核心方法:关键词挖掘与筛选(流量+权重必备)

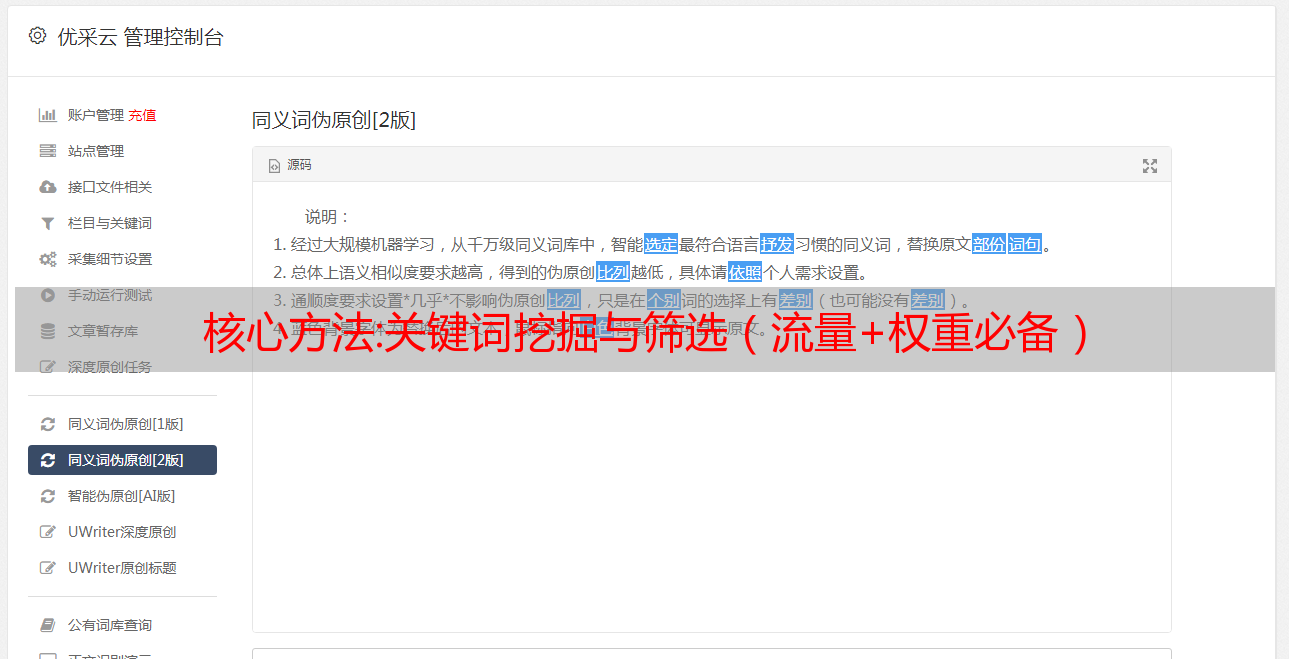

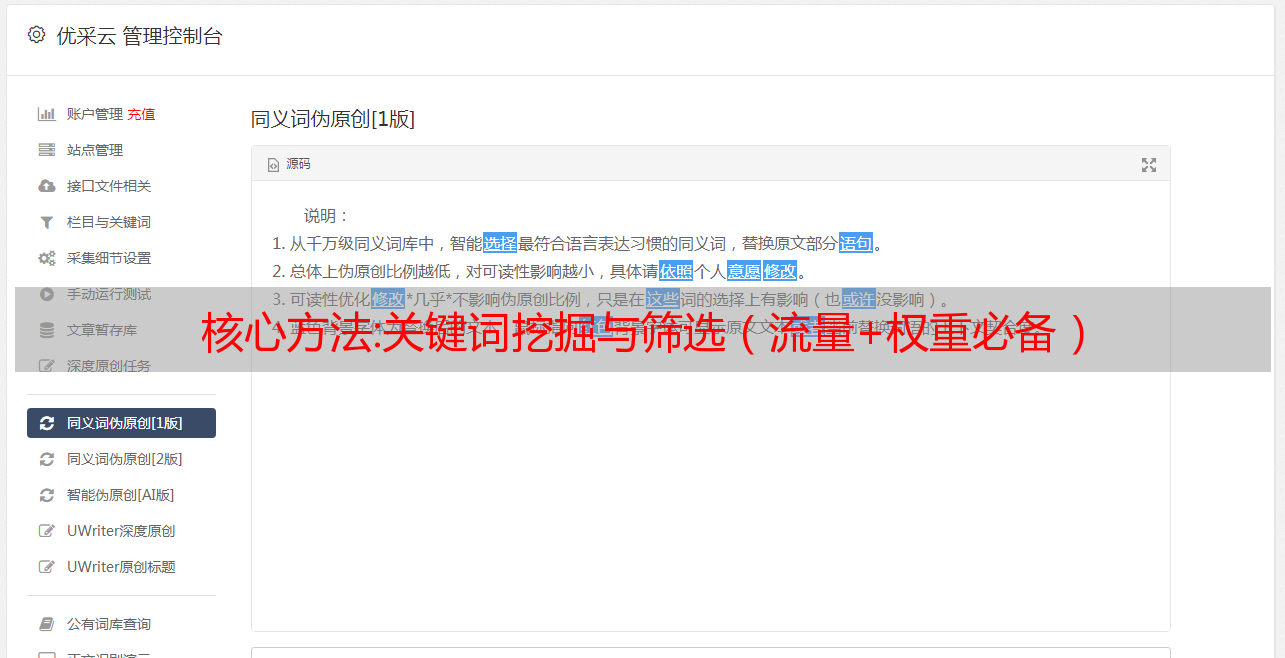

优采云 发布时间: 2022-10-23 02:41核心方法:关键词挖掘与筛选(流量+权重必备)

如果seo达到了一定的水平,你自然会发现seo总是围绕着两个话题

一个是收录的话题,一个是文字的话题

为什么这么说呢,收录可以帮你解决展示点击量,文字帮你解决流量,这也是我们seo的宗旨。

无论你是加重站还是交通站,都必须掌握这套技巧。如果你不掌握它,它肯定是行不通的,你将无法产生流量或加权效果。

如果不是为了面子,不管是自己做项目还是工作中给公司做SEO,本质上SEO最终还是需要流量的,所以我们尽量做到以流量为导向,以权重为辅助。

无论你是加重站还是交通站,都必须掌握这套技巧。如果你不掌握它,它肯定是行不通的,你将无法产生流量或加权效果。

如果不是为了面子,不管是自己做项目还是工作中给公司做SEO,本质上SEO最终还是需要流量的,所以我们尽量做到以流量为导向,以权重为辅助。

首先,无论是权重还是流量,挖矿关键词的步骤都是一样的。唯一不同的是,我已经完成了挖掘关键词和过滤单词的步骤,我将向你解释不同之处。

进行如下

1.词分类

2.按分类进行词挖掘

3.根据挖掘的词过滤

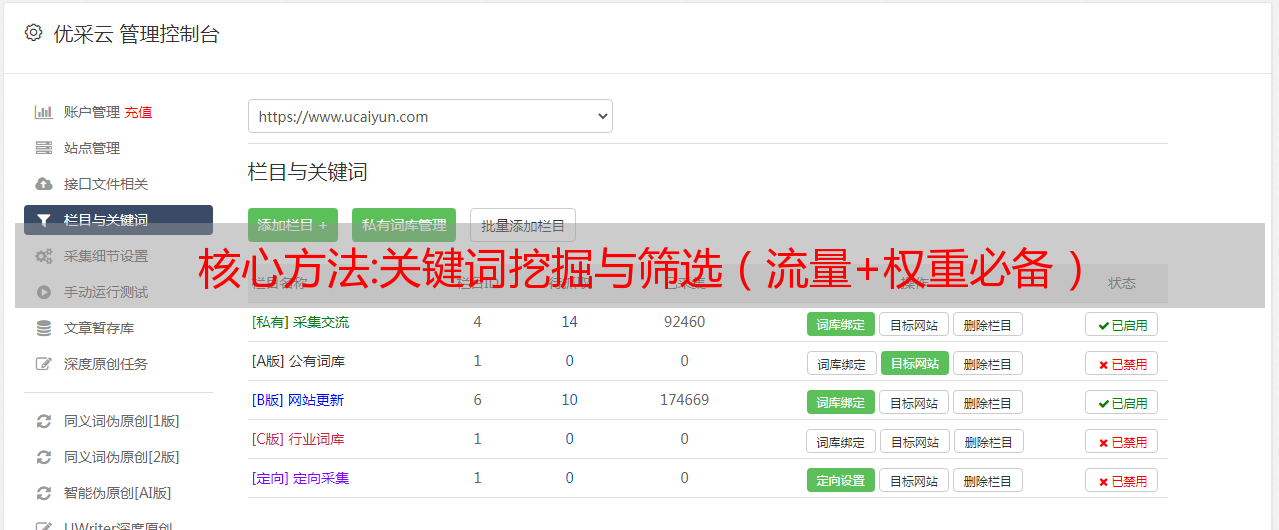

4. 所选词用于精准词内容采集

挖掘工具:5118关键词挖掘工具

我们仍然以空调为例。不管你在哪个行业,这个关键词挖矿方法都可以用,不限于某个行业或者某个关键词

任何一个行业词基本上都会分为几种

1.业务类型词

2.疑问词

3. 地区词

不管是什么行业词,这三类一定要记住,它们是通用的

比如空调

什么是业务类型词?业务类型词一般可以理解为,例如海尔空调格力空调价格等,对应的业务类型词一般是核心词的子类。

而且商务型字下面还会有很多其他的字,比如海尔空调什么型号最新空调价格

所以我们对词进行分类,首先采集我们自己的业务类型词,我们如何采集业务类型词?方法如下

1.开启5118关键词挖矿

2.输入你的核心词来挖掘

你需要自己采集这些单词。如果你做海尔空调,你不需要做任何其他事情。

那么你只需要一个业务类型词,那就是海尔空调。如果你做所有类型的空调,采集所有对应的业务类型词。

第二个是区域词。并非所有行业都有地区性词汇。例如,空调没有,但装饰有。

如北京装饰公司上海装饰公司等。

地域词不需要去5118采集,因为你去百度采集中国城市之后,地域词+商业类型词就够了

比如有室内装修公司和别墅装修公司,区域词的组合就是北京+室内装修公司北京+别墅装修公司。如果中国有300个地级市,你有10个业务类型词,那么总共有3000个区域词。这种方法可以快速帮你整理出地区性的词。

第三个是疑问词

多少,如何,如何,哪个,哪个等是常见的疑问词。

那么如何挖掘疑问词呢?方法也很简单。使用商务类型词+疑问词,比如海尔空调是什么?

全部导出

如果总共有5个疑问词和10个商务类型词,那么就相当于采集了50个商务类型疑问词。如果每个业务问题词有 1000 个相关词,那么总共有 50*1000=50,000 个词。一般疑问词出来了

很多人做SEO,想增加流量,但其实你还没有计算出你的行业词库总量。很难知道您的流量上限在哪里。

这个方法可以帮你整理和统计这些单词

刚才讲的是第一点关于关键词的挖掘

现在,第二点是关键词的筛选。我们整理出来的词不代表所有词都需要用到。这里我就说一下我开始说的重量站和交通站的区别。

权重站要做的是第三方工具的权重计算,比如爱站权重,但是爱站权重记录都是索引词和前五页的排名

因此,如果我们要做一个权重站,选择的词必须以索引词为目的进行优化,而不是必须对所有词进行操作

因为有些词没有索引,所以你排名第一,爱站不会给你权重。这个地方需要区别对待。

如果你纯粹是一个体重站,那么你只需要挖很多索引词。假设你想成为家电行业的称重站。

首先,采集所有家用电器,如空调、冰箱、电视等。

然后去5118导出空调、冰箱、电视的所有词,只保留索引词。

比如冰箱有560个索引词,那么对应导出词包后,只能复制前560个词。

同样,我们假设我们要制作一个具有 1000 个权重的词库(爱站 词库示例)以脱颖而出

然后你可以这样计算。假设你网站发了10页,5页收录,然后收录的10页中的1页记录了词库排名,那么几乎可以知道,如果你发20页,就有将是一个带有词库的页面

相应地,如果要实现爱站1000个词库,则需要20000个索引词到采集对应20000个对应文章才能达到1000个。词库的作用

所以,做一个称重站,必须具备挖词、筛选数据分析统计的能力。这只是一个假设。其实真正优化中的排名也和域名网站本身的多维性有关。

刚才是体重站的筛选方法

同理,流动站的关键词筛选方式依旧以冰箱为例。

点击下方蓝色按钮移动日均搜索量,也可以直接导出冰箱词,用excel排序。

然后提取所有具有搜索量的单词并使用它们。一般来说,这些有搜索量的词是比较好的流量词。

如果某些词的搜索量为0,并不代表没有流量,因为我们在做SEO的时候需要明白一个道理

由于这些词是在5118这样的工具中记录的,所以5118的词也捕获了大量百度的关键词数据。既然这些词被记录下来,就意味着这些词100%被人搜索过,无非就是搜索的次数。

由于我们搜索过,100%的人点击了,所以我们是流量站,一次可以优先搜索所有搜索量大的词。

然后转到 0 搜索量。0 搜索量只是告诉你搜索的人数每周少于 1 次。这并不意味着没有人搜索。可能一个月2个人搜索,这种词竞争不大。

假设用这么小的搜索量做10万字,累积的流量其实很恐怖

所以,千万不能用常规的SEO思维来对待流量站,而是要用流量的思维来对待它。

无论是交通站还是称重站,我们也对文字进行了挖掘和筛选。

然后把这些话放到采集对应的文章准备好

另外,如果前期准备了50000关键词,那么对应的内容一定是50000+,并且要形成*敏*感*词*的关系。

为什么是50000+而不是50000,因为我们要考虑到如果后面自动发帖有些内容有问题文章,恐怕会出错,那么你的50000内容实际上可能不如5.一万

所以我们去采集对应的内容最好是50000以上的内容。

这里有个小tips,前期采集文章一定要把所有的词组织好,不要组织一个batch去采集一个batch的内容

如果我们害怕我们的内容的最后一个 文章 会重复 采集 到一个 网站,这是一个很大的禁忌

所以我们做站群保持字数不变,但是内容不能一样,包括你发的这个文章,如果第一个网站已经发了,第二个网站不要再用了,要到采集其他内容再操作一次,保证内容不重复不冲突

这堂课基本上就是内容了。以后有空的时候,可以根据我这堂课所教的知识点关键词你想做的行业。你可以实际操作它。

核心方法:浅谈Python网络爬虫

(2) 数据解析:了解HTML结构、JSON和XML数据格式、CSS选择器、Xpath路径表达式、正则表达式等,以便从响应中提取出需要的数据;

(3)数据存储:MySQL、SQLite、Redis等数据库方便数据存储;

相关技术

以上就是学习爬虫的基本要求。在实际应用中,还应该考虑如何使用多线程提高效率,如何调度任务,如何应对反爬虫,如何实现分布式爬虫等等。本文内容比较有限,仅供参考。

六个python相关库

在爬虫实现中,除了scrapy框架外,python还有很多相关的库可用。其中,在数据抓取方面,包括:urllib2(urllib3)、requests、mechanize、selenium、splinter;在数据分析方面,包括:lxml、beautifulsoup4、re、pyquery。

对于数据抓取,涉及的过程主要是模拟浏览器向服务器发送构造好的http请求,常见的类型有:get/post。其中,urllib2(urllib3)、requests、mechanize用于获取URL对应的原创响应内容;而selenium和splinter通过加载浏览器驱动获取浏览器渲染后的响应内容,具有更高的模拟度。

具体选择哪个类库要根据实际需要来确定,比如考虑效率、对方的反爬方式等。通常可以通过使用urllib2(urllib3)、requests、mechanize等来解决selenium和splinter . 尽可能,因为后者由于需要加载浏览器而效率低下。

对于数据解析,主要是从响应页面中提取需要的数据。常用方法包括:xpath路径表达式、CSS选择器、正则表达式等。其中,xpath路径表达式和CSS选择器主要用于提取结构化数据,而正则表达式主要用于提取非结构化数据。对应的库有lxml、beautifulsoup4、re、pyquery。

类库

文档

数据抓取

urllib2

要求

机械化

碎片

硒

数据分析

lxml

美丽的汤4

回覆

查询

相关库文档

七、相关介绍

1 数据抓取

(1) urllib2

urllib2是python自带的访问网页和本地文件的库,通常需要和urllib配合使用。因为urllib提供了urlencode方法对发送的数据进行编码,而urllib2没有对应的方法。

下面是对urllib2的简单封装说明,主要将相关特性集中在一个类函数中,避免一些繁琐的配置工作。

urllib2 包说明

(2) 请求和机械化

Requests 是 Python 的第三方库,基于 urllib,但比 urllib 更方便,接口也很简单。其功能包括: 关于http请求:支持自定义请求头、支持代理设置、支持重定向、支持维护会话[request.Session()]、支持超时设置、post数据自动urlencode;关于http响应:直接从响应中获取详细数据,无需手动配置,包括:状态码、自动解码的响应内容、响应头中的各个字段;还有一个内置的 JSON *敏*感*词*。

Mechanize是对urllib2部分功能的替代,可以更好的模拟浏览器行为,在web访问控制方面非常全面。功能包括:支持 cookie 设置、代理设置、重定向设置、轻松填写表单、浏览器历史记录和重新加载、添加引用标头(可选)、自动符合 robots.txt、自动处理 HTTP-EQUIV 和刷新等。

requests 和 mechanize 的简单封装接口与 urllib2 相同,也将相关特性集中在一个类函数中。这里不再赘述,大家可以参考给定的代码。

(3) 碎片和硒

Selenium (python) 和 splinter 可以很好地模拟浏览器行为,并且都通过加载浏览器驱动程序来工作。在采集信息方面,减少了分析网络请求的麻烦。一般只需要知道数据页对应的URL即可。由于加载浏览器,在效率方面相对低效。

默认情况下,Firefox 浏览器是首选。此处列出了 chrome 和 pantomjs(无头浏览器)驱动程序的下载地址,以便于搜索。

Chrome 和 pantomjs 驱动地址:

铬合金 :

pantomjs:

2 数据分析

对于数据解析,可用的库有 lxml、beautifulsoup4、re、pyquery。其中以beautifulsoup4较为常用。除了使用这些库之外,您还可以了解 xpath 路径表达式、CSS 选择器和正则表达式的语法,以方便从网页中提取数据。其中,chrome浏览器自带生成Xpath的功能。

chrome 视图元素的 xpath

如果基于网络分析可以抓取到所需数据对应的页面,那么从页面中提取数据的工作就比较清晰了。具体使用方法请参考文档,这里不再详述。

八反爬虫

1、基本的反爬方式主要是检测请求头中的字段,如:User-Agent、referer等,这种情况下只需要在请求中带上相应的字段即可。构造的http请求的字段最好与浏览器中发送的字段完全相同,但不是必须的。

2、基于用户行为的反爬方式主要是在后台统计访问的IP(或User-Agent),超过一定的设定阈值时进行拦截。针对这种情况,可以使用代理服务器解决,每隔几次请求,切换使用的代理的IP地址(或者使用User-Agent列表解决,每次从列表中随机选择一个) )。这种反爬虫方法可能会无意中伤害用户。

3.如果你要抓取的数据是通过ajax请求获取的,如果通过网络分析可以找到ajax请求,也可以分析出请求需要的具体参数,那么可以直接模拟对应的http请求,你可以从响应对应的数据中得到它。在这种情况下,它与普通请求没有什么不同。

4、基于Java的反爬方式主要是在响应数据页面之前返回一个带有Java代码的页面,用于验证访问者是否有Java执行环境,从而判断是否使用了浏览器。

通常,这段JS代码执行完后,会发送一个带参数key的请求,后台通过判断key的值来判断是响应真实页面还是假冒错误页面。由于key参数是动态生成的,而且每次都不一样,所以很难分析其生成方式,无法构造出对应的http请求。

比如网站就是这样使用的,详见。

第一次访问网站时,响应的JS内容会发送一个带有yundun参数的请求,而且每次的yunund参数都不一样。

动态参数云盾

本次测试时,Java代码执行后,发送的请求不再携带yundun参数,而是动态生成一个cookie,在后续请求中带上cookie,与yundun参数类似。

动态cookies

对于这样的反爬虫方法,爬虫需要能够解析和执行Java。具体方法可以通过使用 selenium 或者 splinter 加载浏览器来实现。