技巧:外链自动批量发布工具到底有没有用

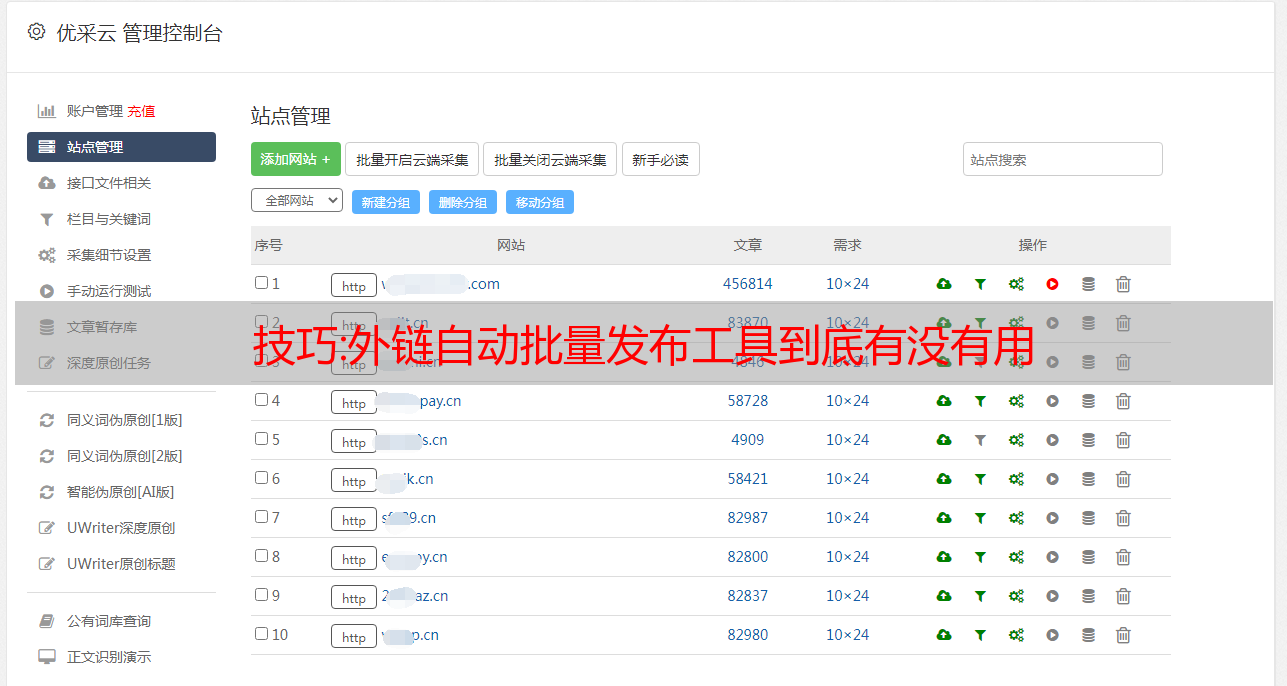

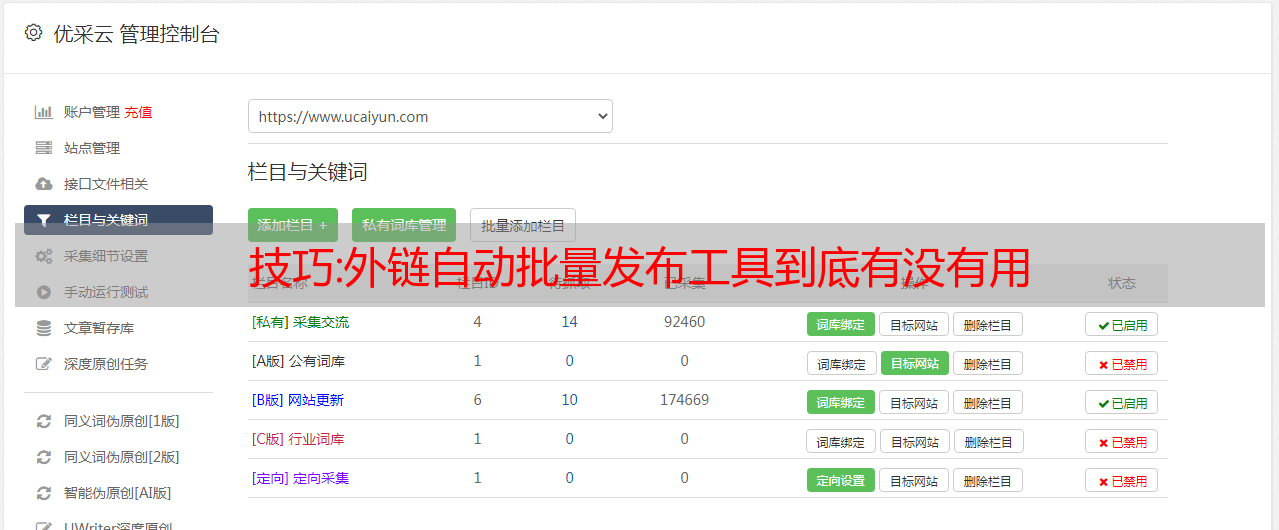

优采云 发布时间: 2022-10-21 20:16技巧:外链自动批量发布工具到底有没有用

外部链接的建设一直是seo的重要任务之一。随着时间的推移,搜索引擎越来越重视网站的内在质量,对外部链接的要求也越来越高。早期,自动外部链接工具非常流行。这个外链工具的原理是模拟各大平台手动查询关键词。当搜索引擎收录 时,就会形成一个外部链接。比如天虹在爱站网上搜索他的网站,搜索结果页的url是一样的。此链接为收录后,将成为我的网站的外部链接。因为这个外链工具聚合了大量的高权重平台,每次使用后,

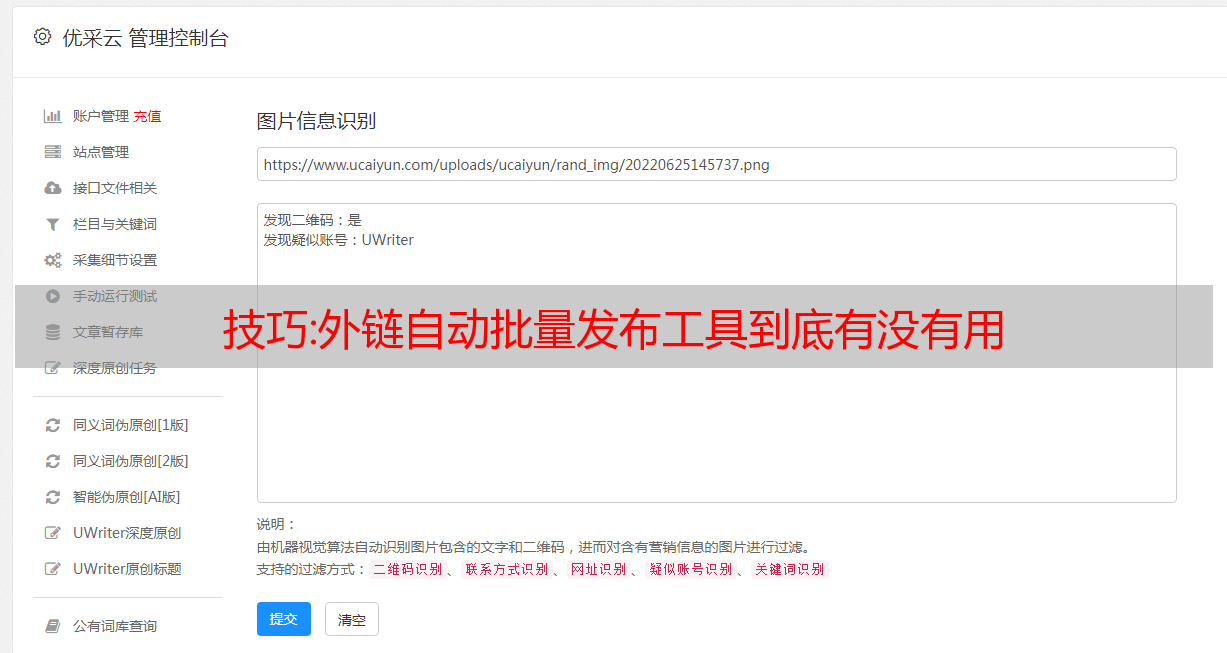

有人质疑这种外链的留存时间,天虹想说,留存时间也长。天鸿此前曾为其客户景尚志使用过该工具,如下图。可以看出这是2018.1.22的收录,现在还保留着。所以说,时间的保存在这里,佛系随缘。不过seo的外链讲的是效果,就是能不能引流、辅助屏风、提升关键词的排名。天虹在这里做个总结。这种外链只是看起来很漂亮,实际上并没有太大的作用。

百度在官方文档中已将此类外链明确归类为垃圾外链。原文如下: 垃圾外链是指对指向网站没有推荐意义的超链接,不是被指向的站点故意制作的。包括但不限于:搜索结果页面发送的链接、站长服务自动生成的链接网站、不良垃圾和作弊网站自动生成的链接采集等。此类外部链接超过98个% 已经被我们识别并在链接计算中自动过滤了,这样一般情况下不会对指向网站的链接产生直接的负面影响。

在这一点上,我们还是应该相信百度。毕竟,百度还是有识别这类搜索结果外链的基础技术。以前可能有一些童鞋们也在纠结这个外链工具每次用了多少次却没有受到惩罚。天虹想说,你用一天就没事,因为百度没有计算这个工具创建的外部链接对网站的影响。否则,要陷害竞争对手网站并不容易,但期望使用这种方法来提升网站排名会令人失望。

教程:用 PyQt5 写一个傻瓜式的一键数据采集软件

数据采集越来越成为互联网从业者的刚需。

从内部报告到外部市场动态,需要采集大大小小的信息和数据。爬虫无疑是最快最高效的常规数据采集的方法。但是,要写爬虫,必须有一定的编程基础,谁能受得了。市面上也有一些自助数据采集工具,如:优采云、优采云等,确实是在降低数据采集和门槛和方便数据采集的操作。但这些工具或多或少还是需要手动定义和选择规则。在State先生的“前爬虫生涯”中,遇到过很多生意人,有一个要求:直接把数据给我。如果答案是否定的,它会说:你给我一个工具,让我点击数据,它就会出来。其实我们可以使用PyQt5对爬虫程序进行封装打包,实现傻瓜式,一键式采集软件。这个特别适合普通商务人士,实时数据性能不高,但需要登录。网站。下面,我们以采集微信公众号后台数据为例,介绍使用PyQt5开发一键傻瓜式数据采集工具。核心采集代码就到这里了,我们只用采集微信公众号后台“整体账号状态”的数据作为演示:这个特别适合普通商务人士,实时数据性能不高,但需要登录。网站。下面,我们以采集微信公众号后台数据为例,介绍使用PyQt5开发一键傻瓜式数据采集工具。核心采集代码就到这里了,我们只用采集微信公众号后台“整体账号状态”的数据作为演示:这个特别适合普通商务人士,实时数据性能不高,但需要登录。网站。下面,我们以采集微信公众号后台数据为例,介绍使用PyQt5开发一键傻瓜式数据采集工具。核心采集代码就到这里了,我们只用采集微信公众号后台“整体账号状态”的数据作为演示:

我们使用 requests 库来处理 HTTP 请求,使用 BeautifulSoup 来解析和提取 HTML 文档的数据。其核心采集代码如下:

<p> def check_status(self):

try:

print("获取到的Cookie:", self.cookie)

print("获取到的Token:",self.token)

# 获取当前登录店铺和用户名

url = 'https://mp.weixin.qq.com/cgi-bin/home?t=home/index&token={token}&lang=zh_CN'.format(token=self.token)

wbdata = requests.get(url, headers=self.header, cookies=self.cookie).text

soup = BeautifulSoup(wbdata,'lxml')

nickname = soup.select_one("a.weui-desktop-account__nickname").get_text()

total_cnt = soup.select("em.weui-desktop-data-overview__desc")[2].get_text()

self.nickname = nickname

except Exception as e:

self.nickname = None

logger.error("获取用户信息出错:{}".format(repr(e)))

return (self.nickname, self.cookie)</p>

搭建图形界面因为微信公众号需要登录才能使用,所以我们使用PyQt5的QtWebEngineWidgets小部件在程序中嵌入浏览器,直接在程序中实现登录操作。

可以看到我们图形程序的主界面分为两个选项卡,通过QTabWidget选项卡部分实现。在第一个选项卡中,我们放置了一个 QtWebEngineWidgets QWebEngineView 小部件,用于显示网页和登录。在第二个选项卡中,我们放置了按钮小部件和文本输入小部件,用于控制数据采集 的进度和结果以及显示数据采集.

采集处理与控制 程序的图形界面构建完成后,我们需要对程序的功能进行处理。这些功能包括: 网页的cookie是我们获取登录状态的关键。在这里,浏览器配置文件是通过 QtWebEngineWidgets 的 QWebEngineProfile 组件实现的。QWebEngineProfile 有一个 cookie 存储,每个请求都会将 cookie 写入 QWebEngineProfile,我们将从这里读取最新的 cookie。数据采集的执行是通过“检查登录状态”按钮进行的,按钮的点击信号绑定了一个槽函数。slot函数调用QThread在子线程中执行数据采集。核心代码。而结果的输出,我们通过文本输出框来实现。

<p> # 在控制台中写入信息

def outputWritten(self, text=None):

cursor = self.label_1.textCursor()

cursor.movePosition(QtGui.QTextCursor.End)

cursor.insertText(text)

self.label_1.setTextCursor(cursor)

self.label_1.ensureCursorVisible()</p>

这样,在按钮的slot函数中,调用outputWritten方法在文本框中输出采集信息。最后的结果最终我们实现的效果是:打开程序,在“登录页面”标签页扫码登录微信公众号后台;然后切换到“操作页面”,点击“检查登录状态”按钮,程序会自动采集数据,最后输出到文本输入框。未登录时的效果:

登录状态下的效果:

按照同样的逻辑,我们可以在采集网页中实现其他数据,比如文章列表数据、观察列表用户数据等,或者其他网站数据。

您希望它以“Python GUI 开发视频教程”的形式呈现吗?点击下方“看”,给它一个去大厅的机会,给我一个鼓励!