干货内容:在线seo外链工具-SEO外链群发工具真的有用吗

优采云 发布时间: 2022-10-20 15:38干货内容:在线seo外链工具-SEO外链群发工具真的有用吗

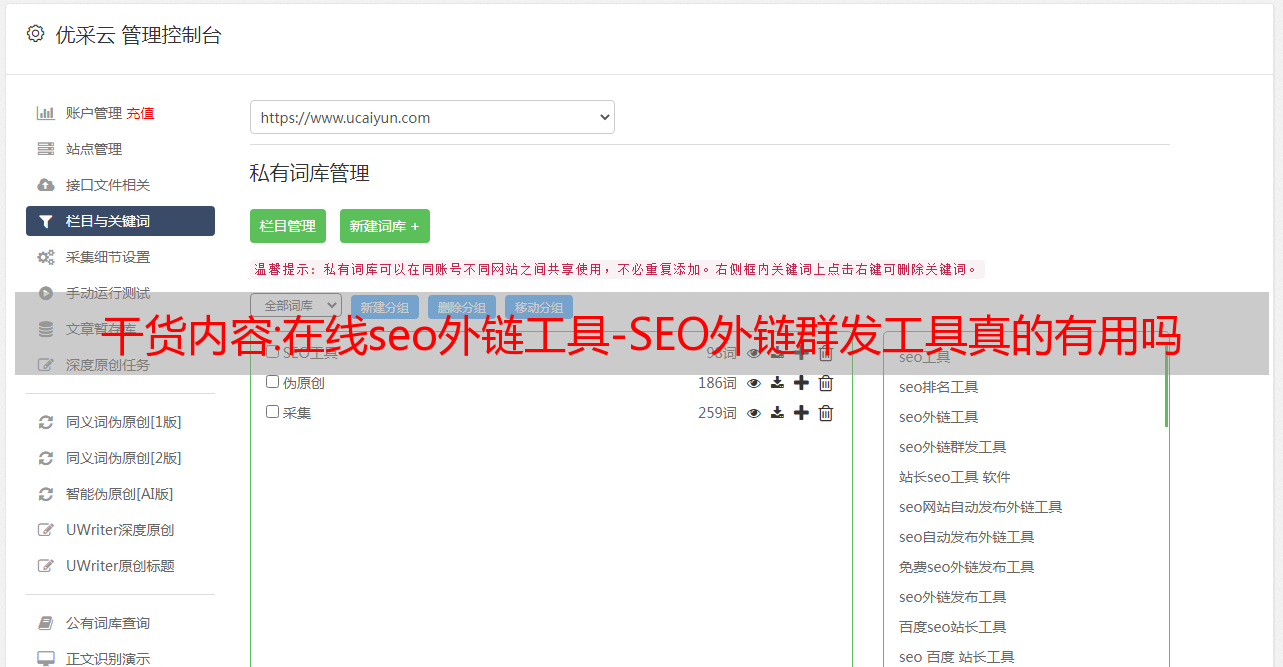

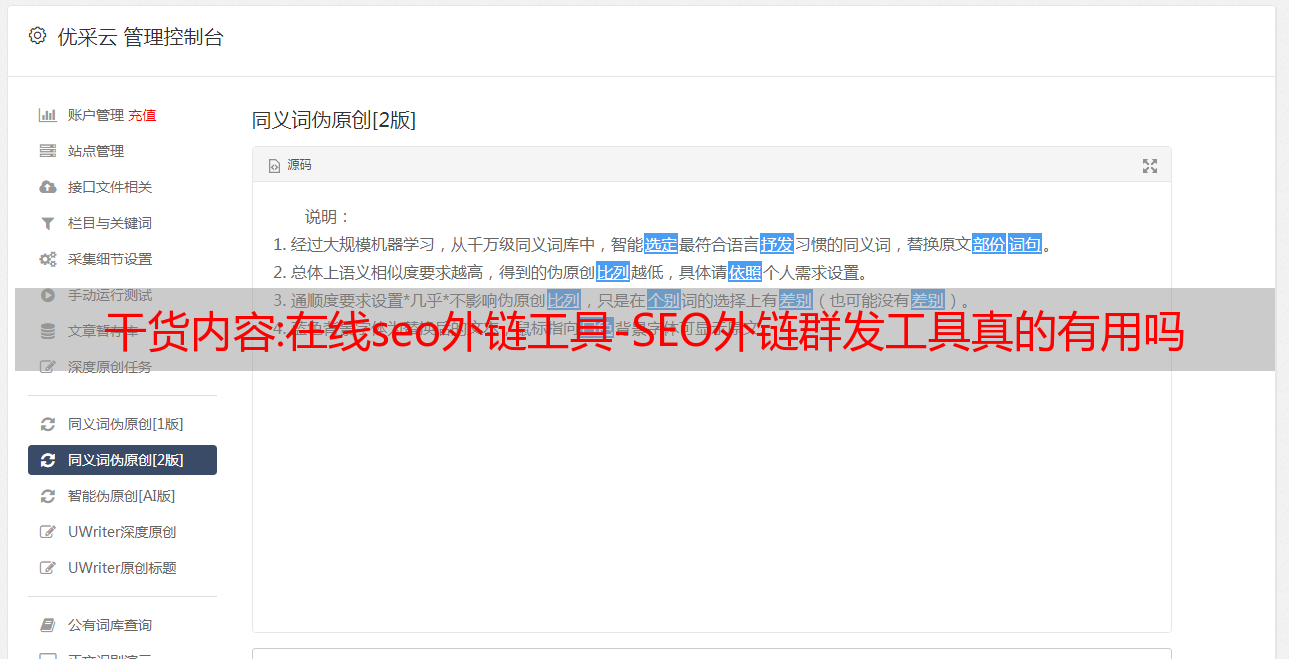

很多朋友在网站seo优化过程中遇到过一些网站优化问题,包括“在线seo外链工具:SEO外链群发工具真的有用吗?”的问题,那就在下面搜索认识一下网络编辑来回答你目前困惑的问题。

搜索引擎优化外链当然有用,外链可以更好的增加百度网站收录。推荐使用skycc推广软件对外部链接进行分组。

明明百度收录有我的文章,文章有官网的外链,但是用站长工具查外链也没什么

的。因为百度后台站长工具中的外链功能过滤网站,

具体:垃圾外链和作弊外链和百度的处理原则,你在发布外链后必须知道这些步骤(判断是否垃圾,作弊,百度处理原则),如果你不属于以上类型的外链地址,他会给你外链,否则不计算外链。所以你在后台找不到链接。

在线seo链接工具:SEO问题,使用海量链接工具有用吗?

好用,但也有风险,如果你站很多,又不想找外链平台为你服务,吃个饭不知道天堂。小七在线外链工具。在线seo链接工具

如果做一个网站,又想靠几年前的连锁运营来排位,估计又要回归神秘了。

辅助效果肯定是有的,答案只是比较少。

以上就是关于文章关于在线seo外链工具和SEO外链群发工具真正有用的内容。如果您有网站优化的意向,可以直接联系我们。很高兴为您服务!

干货教程:python爬虫基础之简易网页搜集器

简单的网络爬虫我们之前学习了一个简单的爬虫,它可以爬取浏览器页面。但其实我们的需求当然不是爬搜狗主页或者B站主页那么简单的,不管多差,我们都希望能爬到具体的有信息的页面。

简单的网络爬虫

之前我们已经学习了如何简单地抓取浏览器页面。但其实我们的需求当然不是爬搜狗主页或者B站主页那么简单的,不管多差,我们都希望能爬到具体的有信息的页面。

不知道学完爬虫后,有没有像我一样尝试爬过一些搜索页面,比如百度。像这样的页面

注意我被红色描边的部分,这是我正在打开的网页。现在我希望爬取这个页面的数据。根据我们之前学习的代码,应该是这样写的:

<p>import requests

if __name__ == "__main__":

# 指定URL

url = "https://www.baidu.com/s?ie=utf-8&f=8&rsv_bp=1&rsv_idx=2&tn=93923645_hao_pg&wd=%E5%A5%A5%E7%89%B9%E6%9B%BC&rsv_spt=1&oq=%25E7%2588%25AC%25E5%258F%2596%25E7%2599%25BE%25E5%25BA%25A6%25E9%25A6%2596%25E9%25A1%25B5&rsv_pq=b233dcfd0002d2d8&rsv_t=ccdbEuqbJfqtjnkFvevj%2BfxQ0Sj2UP88ixXHTNUNsmTa9yWEWTUEgxTta9r%2Fj3mXxDs%2BT1SU&rqlang=cn&rsv_dl=tb&rsv_enter=1&rsv_sug3=8&rsv_sug1=5&rsv_sug7=100&rsv_sug2=0&rsv_btype=t&inputT=1424&rsv_sug4=1424"

# 发送请求

response = requests.get(url)

# 获取数据

page_text = response.text

# 存储

with open("./奥特曼.html", "w", encoding = "utf-8") as fp:

fp.write(page_text)

print("爬取成功!!!")</p>

然而,当我们打开我们保存的文件时,发现结果并不是我们想的那样。

我们发现我们保存的文件是一个空白页,这是为什么呢?

其实把网址改成搜狗可能更直观(不知道为什么我这边的搜狗总是打不开,所以我以百度为例,你可以自己写关于搜狗搜索的代码),同样的代码改成搜狗的网址的结果是这样的

我们发现有一句话“网络中有异常访问”,那么这句话是什么意思呢?

这句话的意思是搜狗或者百度注意到发送请求的是爬虫程序,而不是人为操作。

那么这样做的理由是什么?

简单来说,程序访问和浏览器访问是有区别的。请求的服务器依靠用户代理来确定访问者的身份。如果是浏览器,就会接受请求,否则会被拒绝。这是一种很常见的防爬机制。

我们无能为力吗?

不~ 所谓魔是一尺高,道是一丈高。既然我们要识别user-agent,就让爬虫模拟user-agent。

在python中模拟输入数据或用户代理,我们一般使用字典

就这样写吧:

<p>header = {

"user-agent": "" # user-agent 的值 是一个长字符串

}</p>

那么如何获取 user-agent 的价值呢?

1.打开任意网页,右击,选择“检查”

2.选择“网络”(谷歌浏览器)(如果是中文,选择“网络”)

3.如果发现点击是空白的,像这样,刷新页面

刷新后是这样的:

然后随机选择红笔圈出来的item,我们会看到这样的东西,然后在里面找到“user-agent”,复制它的值。

使用“用户代理”,我们正在重写我们的网页爬取代码,就是这样

<p>import requests

if __name__ == "__main__":

# 指定URL

url = "https://www.baidu.com/s?ie=utf-8&f=8&rsv_bp=1&rsv_idx=2&tn=93923645_hao_pg&wd=%E5%A5%A5%E7%89%B9%E6%9B%BC&rsv_spt=1&oq=%25E7%2588%25AC%25E5%258F%2596%25E7%2599%25BE%25E5%25BA%25A6%25E9%25A6%2596%25E9%25A1%25B5&rsv_pq=b233dcfd0002d2d8&rsv_t=ccdbEuqbJfqtjnkFvevj%2BfxQ0Sj2UP88ixXHTNUNsmTa9yWEWTUEgxTta9r%2Fj3mXxDs%2BT1SU&rqlang=cn&rsv_dl=tb&rsv_enter=1&rsv_sug3=8&rsv_sug1=5&rsv_sug7=100&rsv_sug2=0&rsv_btype=t&inputT=1424&rsv_sug4=1424"

# 模拟 “user-agent”,即 UA伪装

header = {

"user-agent" : "" # 复制的 user-agent 的值

}

# 发送请求

response = requests.get(url, headers = header)

# 获取数据

page_text = response.text

# 存储

with open("./奥特曼(UA伪装).html", "w", encoding = "utf-8") as fp:

fp.write(page_text)

print("爬取成功!!!")</p>

再次运行,然后打开文件

这次成功了,说明我们的爬虫程序完美的欺骗了服务器

至此,这篇关于基于python爬虫的简单网页采集器的文章文章就介绍到这里了。

在下方搜索并添加老师微信