官方数据:大数据采集的方法

优采云 发布时间: 2022-10-20 10:24官方数据:大数据采集的方法

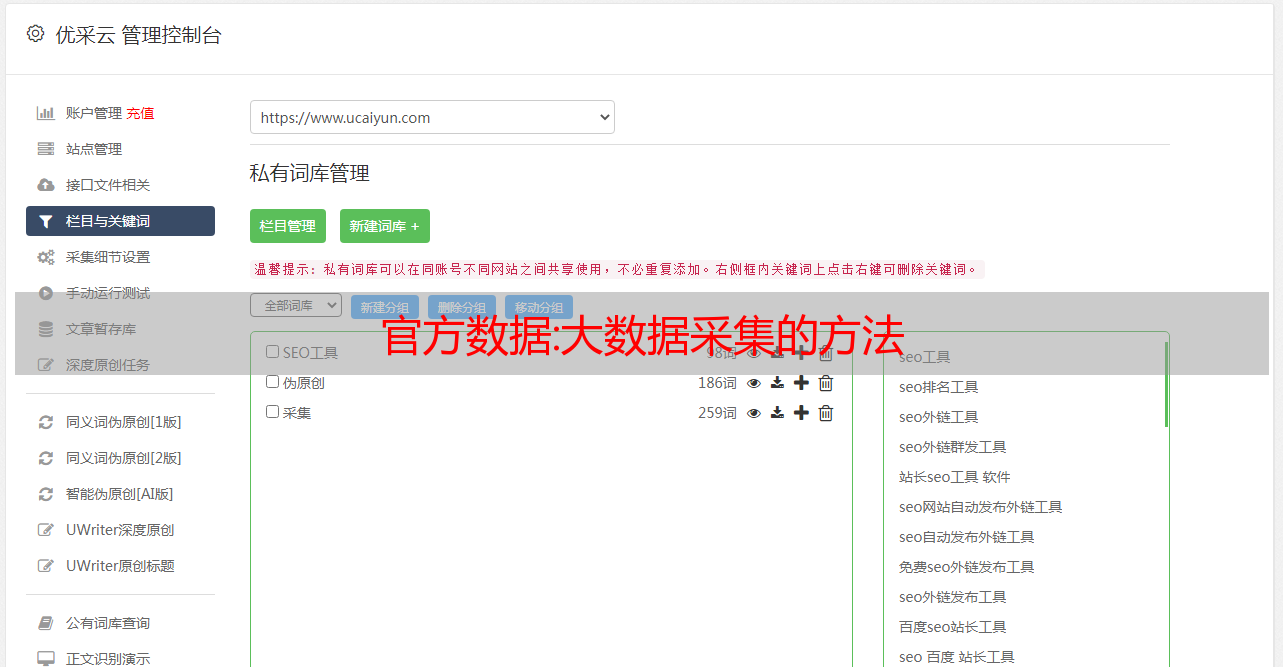

1、离线采集:工具:ETL;

在数据仓库的语境中,ETL基本上是数据采集的代表,包括数据抽取(Extract)、转换(Transform)和加载(Load)。在转换过程中,需要针对特定的交易场景进行数据管理,如非法数据监控过滤、格式转换和数据规范化、数据替换、保证数据完整性等。2、实时采集:

工具:Flume/Kafka;实时采集主要用于考虑流处理的事务场景,例如用于记录数据源性能的各种操作活动,例如用于网络监控的流量管理,用于金融应用的库存核算,以及Web服务器记录用户访问行为。在流处理场景下,数据采集会成为Kafka的客户,就像截取上游数据源源不断的大坝,然后根据事务进行相应的处理(如去重、去噪、中央记账等)场景,然后写入相应的数据存储。

3、网络采集:工具:爬虫、DPI等;

Scribe 是 Facebook 开发的数据(日志)采集系统。也称为网络蜘蛛或网络机器人,它是根据一定的规则自动从万维网上抓取信息的程序或脚本。支持图片、音频、视频等文件或附件的采集。除了网络中收录的内容之外,网络流量的采集还可以使用带宽管理技术(例如 DPI 或 DFI)进行处理。

4、其他数据采集方式 对于*敏*感*词*、财务数据等对企业生产经营数据具有较高保密性要求的数据,可通过与数据技术服务商合作,使用特定系统接口等相关方式进行数据采集。方法。例如,八达云计算的数字化企业BDSaaS在数据采集技术、BI数据分析、数据安全保密等方面都做得很好。

关于大数据采集方法的分类,青腾小编就在这里跟大家分享一下。如果你对大数据工程有浓厚的兴趣,希望这篇文章可以帮助到你。如果想了解更多数据分析师和大数据工程师的技能和资料,可以点击本站其他文章进行学习。

汇总:数据采集与预处理培训课件

国标教材《余计算》配套篇,剖析大数据核心技术和大数据实际应用,主编刘鹏,副主编张艳、张崇生、张志礼—— BIG DATA负责人刘鹏教授,博士 清华大学。现任南京大数据研究院院长、中国信息协会大数据分会副理事长、中国大数据技术非应用联盟副理事长。主持完成科研项目25项,发表论文80余篇,出版专业书籍15部。获部级科技进步二等奖4项,三等奖4项。《宇算》主编 被全国高校广泛使用,被引用次数居中国计算机图书第一。创立了著名的中国宇计算()和中国大数据()网站。带领团队获得2002年PennySort国际计算机排序大赛冠军,两次获得全国高校科技大赛一等奖,三度获得清华大学科技大赛一等奖。曾获“全军十佳学习英才”(排名第一)、南京市“十佳杰出青年”、江苏省中青年科技带头人、清华大学“学术新秀”称号. 第2章数据采集无预处理2.1 2.

这给我们带来了许多挑战。第一个挑战是从大量数据中采集所需的数据。以下是常用的大数据采集工具。of 42 4 2.1.1 概述 2.1 大数据采集架构第二章数据采集无需预处理 Flume Chukwa Scrible Kafka 大数据采集工具 42 5 2.1.2 常用大数据采集*敏*感*词*数据采集最传统的方式是公司自己的生产系统生成的数据。除了上述生产系统中的数据外,公司的信息系统中还充斥着大量的用户行为数据、日志式数据、活动数据、事件信息等,越来越多的企业通过设置保存这些数据登录采集系统,希望通过这些数据获取其商业或社会价值。2. 1 大数据采集架构第2章数据采集无预处理42 6 在Flume中,外部输入称为Source(source),系统输出称为Sink(sink)。Channel(通道)将Source和Sink链接在一起。Apache Chukwa 项目有点类似于 Flume,Chukwa 继承了 Hadoop 的可扩展性和健壮性。还有一个强大的内置工具箱,用于显示系统监控和分析结果。在失联时代,网络爬虫也是很多企业获取数据的一种方式。Nutch 是网络爬虫的宠儿。Nutch 是 Apache 下的一个开源项目。它已经存在了10多年,拥有大量的忠实用户。而系统的输出称为Sink(汇)。Channel(通道)将Source和Sink链接在一起。Apache Chukwa 项目有点类似于 Flume,Chukwa 继承了 Hadoop 的可扩展性和健壮性。还有一个强大的内置工具箱,用于显示系统监控和分析结果。在失联时代,网络爬虫也是很多企业获取数据的一种方式。Nutch 是网络爬虫的宠儿。Nutch 是 Apache 下的一个开源项目。它已经存在了10多年,拥有大量的忠实用户。而系统的输出称为Sink(汇)。Channel(通道)将Source和Sink链接在一起。Apache Chukwa 项目有点类似于 Flume,Chukwa 继承了 Hadoop 的可扩展性和健壮性。还有一个强大的内置工具箱,用于显示系统监控和分析结果。在失联时代,网络爬虫也是很多企业获取数据的一种方式。Nutch 是网络爬虫的宠儿。Nutch 是 Apache 下的一个开源项目。它已经存在了10多年,拥有大量的忠实用户。在失联时代,网络爬虫也是很多企业获取数据的一种方式。Nutch 是网络爬虫的宠儿。Nutch 是 Apache 下的一个开源项目。它已经存在了10多年,拥有大量的忠实用户。在失联时代,网络爬虫也是很多企业获取数据的一种方式。Nutch 是网络爬虫的宠儿。Nutch 是 Apache 下的一个开源项目。它已经存在了10多年,拥有大量的忠实用户。

Flume 架构 2.1 大数据采集架构第 2 章数据采集无预处理 42 7 2.1.3 Apache Kafka 数据采集 Apache Kafka 旨在高效处理大量实时数据,它是快速、可扩展、分布式、分区和可复制的。Kafka 是用 Scala 语言编写的。虽然属于Java阵营,但并不遵循JMS规范。 主题(topic):消息的类别名称。 Producers(消息发布者):可以向Topics发布消息的进程。 Consumers(消息接收者):可以从Topics接收消息的进程。 Broker:组成Kafka集群的单个节点。Kafka集群基本工作流程2.1大数据采集架构第二章数据采集无预处理42 8 1. 主题主题是消息的分类名称(或提要的名称)。Kafka 集群或 Broker 为每个主题维护一个分区日志。每个分区日志都是一个有序的消息序列,消息不断地附加到分区日志中,并且这些消息是不可变的。2、日志区分 一个topic可以有多个partition,这些partition可以作为并行处理单元,让Kafka能够高效处理大量数据。

主题和日志分析 2.1 大数据采集架构第 2 章数据采集无预处理 42 9 3. 生产者 生产者将数据发布到他们选择的主题。生产者可以选择将主题分配到哪个分区。这可以通过使用循环或任何其他语义划分函数来实现。4.消费者Kafka提供了消费者的单一抽象,这个抽象有两种模式的特征消费者群体:排队和发布-订阅。5. Apache Kafka的安装和使用 由于Kafka是在网络上处理请求的,所以需要为其创建一个用户,这样可以方便管理Kafka相关的服务,减少对服务器上其他服务的影响。2.1 大数据采集架构第二章数据采集无预处理 42 10 使用useradd命令创建Kafka用户:$ sudo useradd kafka –m 使用 passwd 命令设置其密码: $ sudo passwd kafaka 接下来,将 kafaka 用户添加到 sudo 管理组,这样 kafaka 用户就有安装 Apache Kafka 依赖库的权限。这里使用adduser命令添加: $ sudo adduser kafka sudo 现在可以使用kafka账号了。

没有预处理 42 13 2.1 大数据 采集架构第 2 章数据采集没有预处理 42 14 2.1 大数据数据采集架构第 2 章数据采集没有预处理 42 15 6 . 使用Java编写Kafka的实例首先编写KafkaProducer.properties文件: zk.connect= localhost:2181 broker.list= localhost:9092 serializer.class= kafka.serializer.StringEncoder request.required.acks = 1 以下代码是用Java编写的Kafka消息发布者:import kafka.javaapi.producer.Producer;导入 kafka.producer.KeyedMessage;导入 kafka.producer.ProducerConfig;public class MyKafkaProducer { private Producer<String, String> producer; 私有最终字符串主题;公共 MyKafkaProducer(String topic) 抛出异常 { InputStream in = Properties.class.getResourceAsStream("KafkaProducer. ms = 1000 上面的参数配置很容易理解。具体细节可以参考Kafka的官方文档。

以下代码是用 Java 编写的 Kafka Comsumer。导入 java.io.InputStream;导入 java.util.HashMap;导入 java.util.List;导入 java.util.Map;导入 java.util.Properties;导入 kafka.consumer.ConsumerConfig;导入 kafka.consumer.ConsumerIterator;导入 kafka.consumer.KafkaStream;导入 kafka.javaapi.consumer.ConsumerConnector;导入 kafka.consumer.Consumer;公共类 MyKafkaConsumer { 私有最终 ConsumerConnector 消费者;私有最终字符串主题;public MyKafkaConsumer(String topic) throws Exception{ InputStream in = Properties. class.getResourceAsStream("KafkaProducer.properties"); 属性 props = new Properties(); 道具.load(in); ConsumerConfig 配置 = 新的 ConsumerConfig(props); 消费者 = Consumer.createJavaConsumerConnector(config); ic = 主题;} public void consumeMessage() { Map<String, String>

数据预处理的常用方法包括数据清洗、数据集成和数据转换。of 42 18 2.2 数据预处理原理第2章数据采集无预处理填充缺失值数据属性分为数值属性和非数值属性进行处理,缺失值数据使用大部分现有数据属性的信息分为数值属性和非数值属性进行处理。通过使用现有数据中的大部分信息来推断缺失值,可能会使用大量相同的属性值,这可能导致挖掘程序得出有偏差甚至错误的结论。数据偏差问题小,但是这种方法非常耗时,不具备实际可操作性。通常,当类标签缺失时,该方法用于填补缺失值。使用均值替换缺失值。忽略元组。手动填写缺失值。使用全局常量来填充缺失值。用属性的均值填充缺失值 用相似样本的属性均值填充缺失值 用42的最可能值填充缺失值 19 2.2.1 数据清洗 2.2 数据预处理原理 章节2 数据采集No preprocessingof 42 20 binning 方法通过检查某个数据周围的数据的值,即“最近邻”来平滑有序数据的值。分箱 01 回归 02 平滑数据可以通过用函数拟合数据来实现。线性回归的目标是找到“最好的” 适合两个属性的线,这样一个属性可以用来预测另一个。Clustering 03 通过聚类可以检测离群值,将相似的值组织成组或簇,离群值是落在簇外的值。

许多数据平滑方法也是涉及离散化的数据缩减方法。噪声是被测量变量的随机误差或方差。给定一个数值属性,如何“平滑”数据并消除噪声?下面给出数据平滑技术的具体内容。2.2 数据预处理原理第2章数据采集没有预处理的42 21 数据清洗可视为一个过程,包括检测偏差和不校正偏差两个步骤: 2 校正偏差 1 检查偏差可以利用已有的知识数据的性质发现要调查的噪声、异常值和异常值。这种知识或“关于数据的数据”称为元数据。也就是说,一旦发现偏差,通常需要定义和应用一系列转换来纠正它们。但是这些工具只支持有限的转换,因此可能经常需要为数据清理过程的这一步编写自定义程序。2.2 数据预处理原理第2章数据采集无预处理(1)模式集成和对象匹配问题(2)冗余问题(3)元组重复(4)数据值冲突检测不要处理有问题的数据挖掘频繁需要数据集来组合来自多个数据存储的数据。数据可能还需要转换为适合挖掘的形式。大多数数据分析任务都涉及数据集成。Question of 42 22 2.2.2 数据集成 2.2 数据预处理原理 第2章数据 采集 无预处理 1. 平滑。去除数据中的噪音 2。聚合。聚合或聚合数据。

3. 数据泛化。使用概念分层,用高级概念替换低级或“原创”数据 4. 规范化。按比例缩放属性数据,使其落入一个小的特定区间 5. 属性结构。42 23 2.2.3 数据转换 数据转换的目的是将数据转换或统一成适合挖掘的形式。数据转换主要涉及以下内容: 第2章数据采集 无预处理 2.1 2.2 数据预处理原理 2.3 数据仓库和ETL工具练习 国家大学标准教材《喻计算》的配套章节,分析核心技术和实践方面大数据应用大数据采集架构 42 24 2. 3 数据仓库和ETL工具第2章数据采集数据仓库中的数据来自多种业务数据源,可能位于不同的硬件平台,使用不同的操作系统,数据模型也有很大不同。如何获取这些海量数据和各类数据,并将其加载到数据仓库中,成为构建数据仓库的关键问题。of 42 25 2.3.1 数据仓库和ETL工具 数据仓库是企业管理和决策中面向主题的、集成的、时变的、非易失性数据的集合。2.3 数据仓库和ETL工具第2章数据采集... 它可能位于不同的硬件平台上,使用不同的操作系统,数据模型也有很大的不同。如何获取这些海量数据和各类数据,并将其加载到数据仓库中,成为构建数据仓库的关键问题。of 42 25 2.3.1 数据仓库和ETL工具 数据仓库是企业管理和决策中面向主题的、集成的、时变的、非易失性数据的集合。2.3 数据仓库和ETL工具第2章数据采集... 它可能位于不同的硬件平台上,使用不同的操作系统,数据模型也有很大的不同。如何获取这些海量数据和各类数据,并将其加载到数据仓库中,成为构建数据仓库的关键问题。of 42 25 2.3.1 数据仓库和ETL工具 数据仓库是企业管理和决策中面向主题的、集成的、时变的、非易失性数据的集合。2.3 数据仓库和ETL工具第2章数据采集... 1 数据仓库和ETL工具 数据仓库是企业管理和决策中面向主题的、集成的、时变的、非易失性数据的集合。2.3 数据仓库和ETL工具第2章数据采集... 1 数据仓库和ETL工具 数据仓库是企业管理和决策中面向主题的、集成的、时变的、非易失性数据的集合。2.3 数据仓库和ETL工具第2章数据采集...