分享文章:网站文章采集与伪原创技巧

优采云 发布时间: 2022-10-20 05:084. 页面信息完整。

有朋友发现,我们在做网站原创文章的时候,坚持每天更新原创 文章,为什么收录这么少,排名也低?为什么其他网站对伪原创文章的排名很高?

其实不管是原创文章还是采集伪原创 文章,为了解决用户的需求,我们写的文章起点,也应该这样,并加以说明,让用户有更好的阅读体验,符合高质量文章的特点,如果排版凌乱,文章内容与文章的标题不匹配,内容对用户没有多大用处, 它不能很好地解决用户的问题,那么即使文章原创很高,搜索引擎也会认为这个文章是垃圾文章,相反,如果我们关注用户的需求和体验,为了解决用户的问题做高质量的伪原创文章,那么搜索引擎就会认为这个文章是一个高质量的文章, 从而加快收录,提高网站排名。

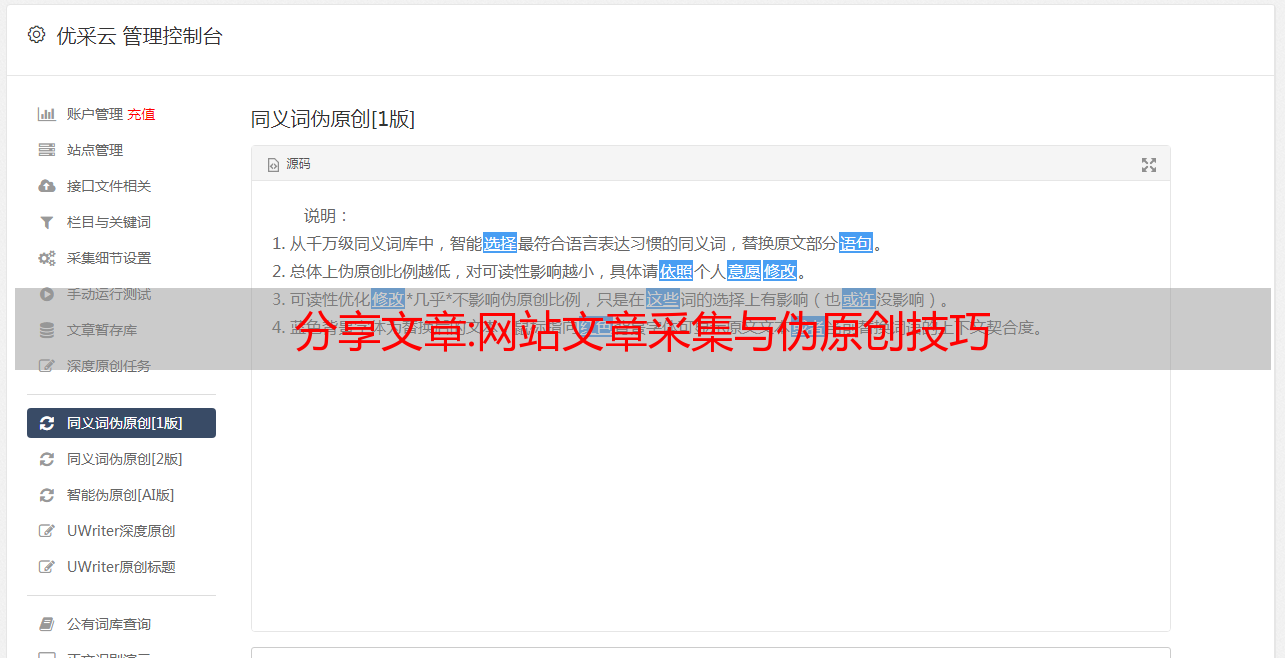

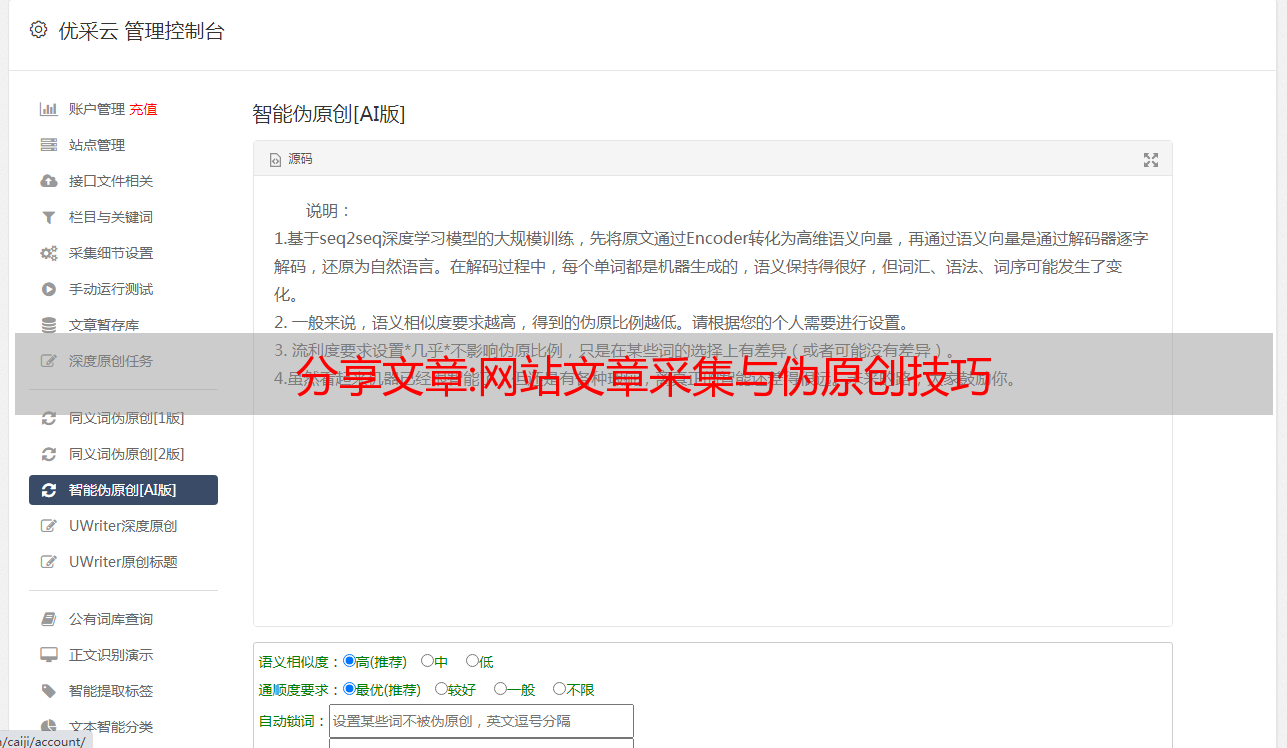

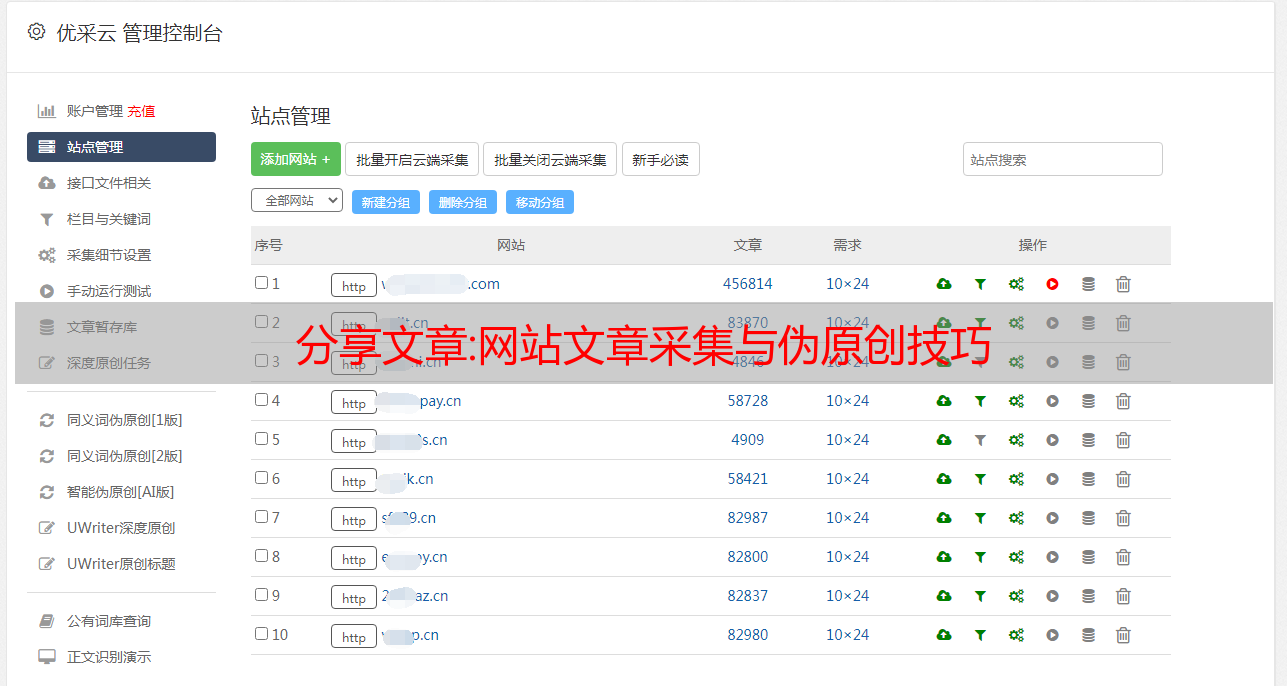

那么,我们如何采集文章制造高质量的伪原创呢?当我们做伪原创文章时,我们可以首先整合相关信息,关于信息采集,我们需要采集和学习更多具有高文章排名的页面,整合这些采集文章中的所有高质量内容,然后用简单的语言用图片和文字来表达它们。当我们再次写伪原创文章时,我们必须有不同的观点,以便使整个文章比原来的文章更全面,改善用户的浏览体验,例如,我们可以修改一些没有意义文章,以及文章中的一些拼写错误,删除原创文章中的一些广告内容,超链接,水印图片,图标等。伪原创的文章不宜与原采集 文章太相似,如果相似度达到80%,那么搜索引擎会认为我们网站文章是抄袭的。不要随意在文章中添加图片,添加的图片最好是对用户有帮助的图片。

分享文章:公众号文章采集器附教程

官方账号文章数据采集和处理无处不在。而且数量很大。我们目前正处于数据爆炸的时代,数据采集和处理随时与我们同在。无论是网站论坛、官方账号文章还是Minments,每天都会产生数以亿计的数据、文章、内容等。

通过数据采集和处理工具,我们可以采集采集所需的官方账号文章数据。本地保存,执行数据分析或二次创建。

数据采集和处理工具操作简单,页面简单方便,我们只需要点击鼠标即可完成采集配置,就可以采集启动目标URL。支持采集资源标签保留(更好的保留格式),原创敏感词过滤(电话号码地址等),原创图像水印删除等。

有时网络抓取是不够的;通常需要更深入地挖掘和分析数据,以揭示数据背后的真正含义并发现有价值的见解。数据和内容的分析利用可以说与我们的工作生活息息相关。

以网站SEO为例,通过数据分析,我们可以计算出网站的每日流量变化和页面的跳出率,并总结出我们网站一些链接的缺点。我们还可以通过数据采集来分析竞争对手关键词排名与我们的差距,以便及时进行调整,做出更好的优化响应。

当然,如果您不喜欢使用工具,我们也可以通过自己输入代码来完成这部分工作:

第一步是通过创建蜘蛛从目标中获取内容:

为了保存数据,以Facebook为例,我们将定义一个收录三个字段的项目:“标题”,“内容”和“星星”:

*敏*感*词*碎屑

类FacebookSentimentItem(scrapy.项目):

标题 = 刮擦。字段()

内容 = 残缺。字段()

星星=刮擦。字段()

我们还创建了一个蜘蛛来填充这些项目。我们给出页面的起始 URL。

*敏*感*词*碎屑

fromFacebook_sentiment.itemsimportFacebookSentimentItem

类目标蜘蛛(刮擦。蜘蛛):

名称=“目标”

start_urls=[域名]。

然后,我们定义一个函数来解析单个内容并保存其数据:

defparse_review(自我,回应):

项目 =脸书感知项()

项目['标题']=响应.xpath('//div[@class=“引用”]/文本())提取物()[0][1:-1]#stripthequotes(第一个和最后一个)

项目 ['content']=response.xpath('//div[@class=“条目”]/p/text()').Extract()[0]

项目['星星']=响应.xpath('//span[@class=“速率rating_srating_s”]/img/@alt“).extract()[0]

返回项

之后,我们定义一个函数来解析内容页面,然后传递页面。我们会注意到,在内容页面上,我们看不到整个内容,这只是一个开始。我们将通过单击指向完整内容的链接并使用parse_review从该页面抓取数据来解决此问题:

defparse_Facebook(自我,响应):

forhrefinresponse.xpath('//div[@class=“quote”]/a/@href'):

url=response.urljoin(href.Extract())

产量。请求,回调=self.parse_review)

next_page=响应.xpath(“//div[@class=”统一分页“]/子:*[2][自身::a]/@href”)

ifnext_page:

url=response.urljoin(next_page[0].Extract())

产量。请求(网址,self.parse_Facebook)

最后,我们定义了主解析函数,它将从主页面开始并解析其所有内容:

解析(自我,响应):

forhrefinresponse.xpath('//div[@class=“listing_title”]/a/@href'):

url=response.urljoin(href.Extract())

产量。请求(网址,回调=self.parse_Facebook)

next_page=响应.xpath(“//div[@class=”unifiedpaginationstandard_pagination“]/子:*[2][自身::a]/@href”)

ifnext_page:

url=response.urljoin(next_page[0].Extract())

产量。请求(网址,自我解析)

因此,询问内容:我们告诉蜘蛛从主页开始,单击指向每条内容的链接,然后抓取数据。在每个页面之后,它将获得下一页,因此它将能够根据需要抓取尽可能多的内容。

可以看出,我们通过代码采集数据不仅复杂,而且需要相对专业的知识。在网站优化方面,我们还是应该坚持最优的解决方案,而数据共享采集和处理到此结束,如果您有不同意见,不妨留言讨论。返回搜狐,查看更多