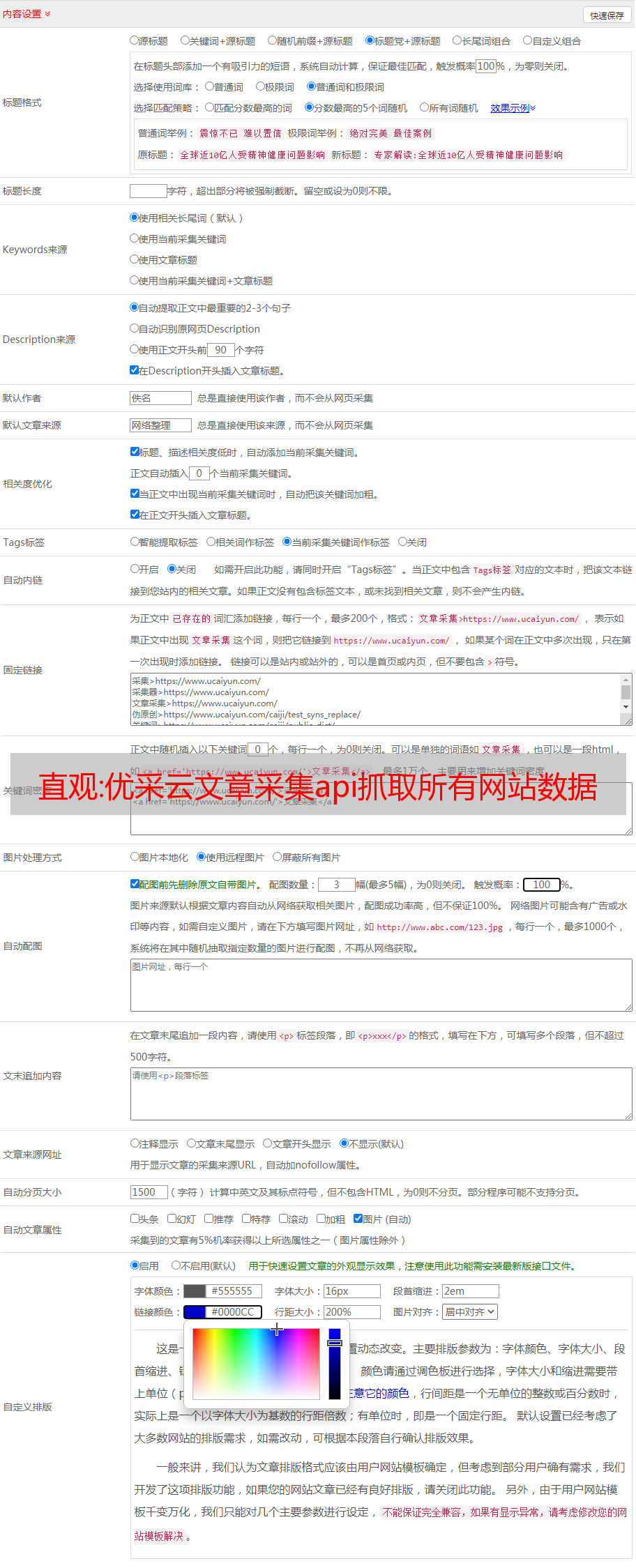

直观:优采云文章采集api抓取所有网站数据的完整过程

优采云 发布时间: 2022-10-18 22:10直观:优采云文章采集api抓取所有网站数据的完整过程

优采云文章采集api是专门定制的采集神器,其采集原理与大家的熟知的百度网盘爬虫、乐讯,以及题主所问互联网一些p2p网站使用spider模式相同,均为:分享抓取来的链接,将网站内的连接聚合,并转换为json字符串形式,再向后端请求抓取数据,而对于后端发送请求过程中,若需要某网站的数据时,则需要对网站进行下载操作,但这种下载功能一直是免费的,也就是说通过私有api,即可免费接入某个或某些网站,但是如果网站服务器返回数据失败,则算是流失了宝贵的用户数据。

所以科学使用api接口,就有可能获取珍贵的网站数据。那么问题来了,对于抓取所有网站的数据到底有多难?那么通过以上分析,接下来我分享下我自己常用的一个抓取github网站(当然没这么多网站,因为会分享很多个网站,基本你能想到的网站,它都有,如,issues.w3ss.io等等)。采集的数据非常有价值,做为我学习的参考、研究的依据,接下来我给大家分享一下我的抓取数据的完整过程。

1.打开github首页,点击进入搜索框。2.在弹出的搜索框中输入命令tomcat,点击搜索。得到以下页面。3.点击tomcat,展开单页内容,鼠标移上去后会有一个刷新按钮。4.鼠标移下来后,我们会发现地址栏中多了一个public,我们需要将这个id分享出去。(可以在windows电脑浏览器中打开该链接,也可以在手机app中打开,打开方式就是点击地址栏右侧的那个图标,然后将要分享的网址复制粘贴,回车即可)5.点击分享出去。

得到以下页面。6.点击列表底部的”share”,将数据分享出去。其中share数据包含:分享的连接点击分享出去后会出现一个完整的列表。在列表里输入需要抓取的网站名,点击”text”,即可开始抓取数据。好了,该数据抓取成功了。但我们要进行分析,看看这个数据是否对我们有价值,或者说该数据中是否存在了什么价值,这是重点,我们该如何用数据做我们分析的抓取策略呢?。