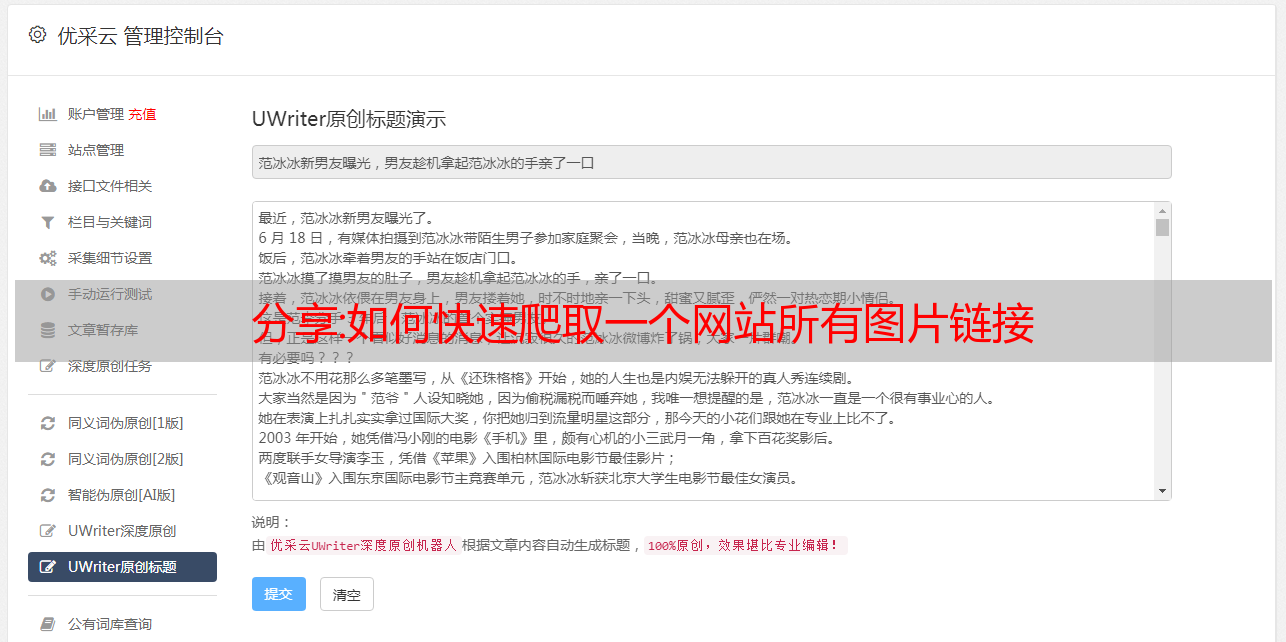

分享:如何快速爬取一个网站所有图片链接

优采云 发布时间: 2022-10-18 10:54分享:如何快速爬取一个网站所有图片链接

网页图片批量下载,我们经常通过网页寻找图片素材,如何批量下载图片,遇到喜欢的图片如何下载原图。今天我们就来说说如何完成网页图片的高质量下载。

使用图片批量下载工具,我们不仅可以单页下载图片,还可以通过三种方式批量下载图片。

1.通过txt导入图片所在链接,批量下载图片,只要链接可以打开就可以下载

2、关键词图片采集,比如我们通过关键词desert进入“desert”,可以在各种自媒体上获取大量相关的文章平台,并通过提取 文章 中的图像获得大量与沙漠相关的材料。

3.指定网页采集,输入我们的网页链接,我们不仅可以下载单个页面的所有图片,还可以批量下载整个网站的所有页面图片,通过设置图片size 我们可以批量过滤低质量的图像。

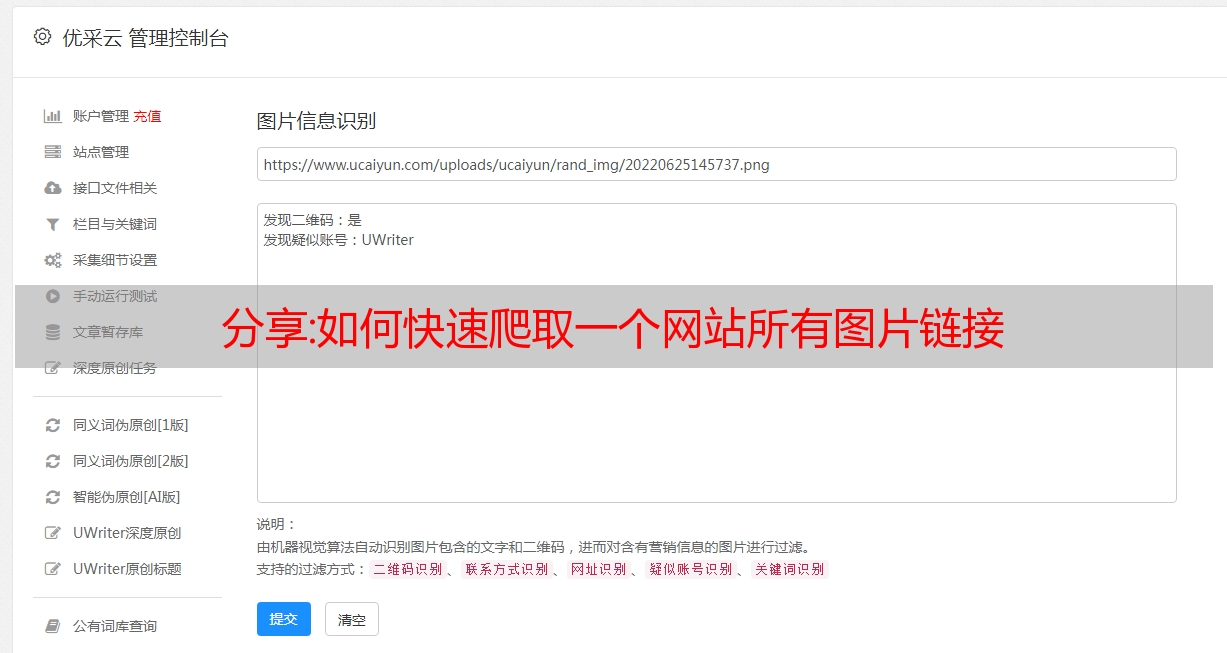

图像优化是指在不牺牲质量的情况下尽可能减小图像文件的大小,从而减少页面加载时间。也称为图像搜索引擎优化。也就是说,当我们告诉搜索引擎这张图片的内容代表什么,和你的文章是否匹配,就可以提高搜索引擎对收录网站的抓取,从而获得排名.

自媒体2

网页图片都以链接的形式存在。对于网站的优化,给我们的图片添加标签和描述可以为爬虫提供相关信息,并且图片alt标签和插入的内容一样,可以大大提高文章的相关性,如何优化我们的 网站 图片:

1. 用 关键词 命名我们的图像

很多用户不注意图片的命名,经常使用乱码作为图片名称。这些都不是SEO的表现,那么如何正确写呢?将我们的 关键词 添加到图片名称中,这样有利于图片优化

自媒体3

2.优化ALT标签

首先我们要知道ALT标签的作用是什么?即当我的图片无法打开时,只会显示alt信息。网页访问者可以通过 ALT 标签来判断图片的内容。将 关键词 添加到 alt 标签是提高 关键词 排名的好方法。

alt标签用html语言编写的方式是这样的:

自媒体4

自媒体5

3.减小图片文件大小

如果可以用 CSS 样式代替,就尽量少用图片,如果可以用列表,就少用缩略图,如果可以用颜色,就少用大图作为背景。这3点非常重要。我们在上传图片的时候,建议每张图片的大小不要超过200K,最好控制在100K以内。

自媒体6

4.选择正确的文件格式

在我们的网站中,一般推荐使用JPG格式。JPG格式的图片比较小,画质相对较好。如果图片是*敏*感*词*形式,可以使用GIF*敏*感*词*格式,保存为JPG图片,不会动。如果图片为透明或半透明格式,建议使用24位PNG格式图片,如logo等,兼容性更好,边缘显示效果更好。

自媒体7

核心方法:如何利用Scrapy爬虫框架抓取网页全部文章信息(上篇)

点击上方“Python爬虫与数据挖掘”关注

回复“书籍”获取Python从入门到进阶共10本电子书

这个

天

鸡

汤

孤寂的邓陷入了沉思,卷起帘子,对着月空叹了口气。

/前言/

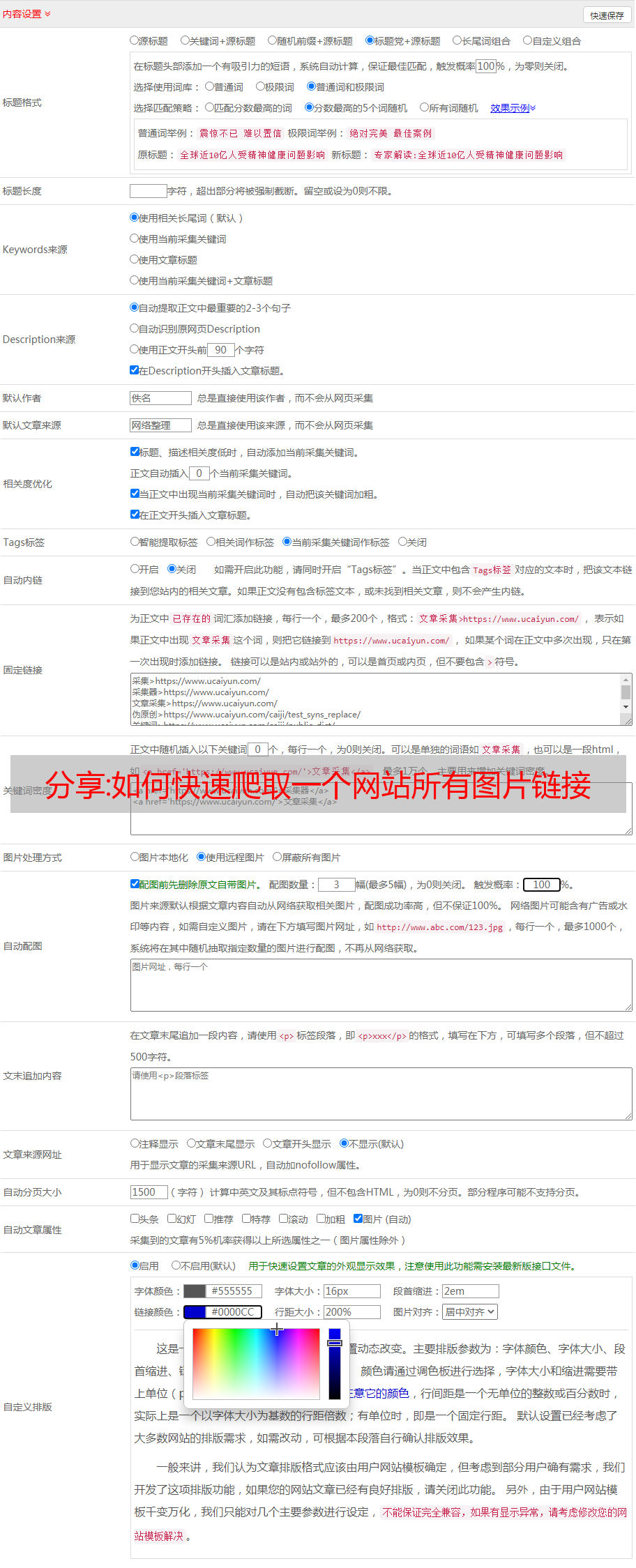

前段时间小编给大家分享了Xpath和CSS选择器的具体用法。有兴趣的朋友可以戳这些文章文章复习,,,,,,,学习如何使用选择器。它可以帮助您更好地利用 Scrapy 爬虫框架。在接下来的几篇文章中,小编会讲解爬虫主文件的具体代码实现过程,最终实现对网页所有内容的爬取。

上一阶段,我们通过Scrapy实现了特定网页的具体信息,但还没有实现对所有页面的顺序提取。首先,我们来看看爬取的思路。大致思路是:当获取到第一页的URL后,再将第二页的URL发送给Scrapy,这样Scrapy就可以自动下载该页的信息,然后传递第二页的URL。URL继续获取第三页的URL。由于每个页面的网页结构是一致的,这样就可以通过反复迭代来实现对整个网页的信息提取。具体实现过程将通过Scrapy框架实现。具体教程如下。

/执行/

1.首先,URL不再是特定文章的URL,而是所有文章列表的URL,如下图,并将链接放在start_urls中,如图在下图中。

2. 接下来我们需要改变 parse() 函数,在这个函数中我们需要实现两件事。

一种是获取一个页面上所有文章的URL并解析,得到每个文章中具体的网页内容,另一种是获取下一个网页的URL并手它交给 Scrapy 进行处理。下载,下载完成后交给parse()函数。

有了前面 Xpath 和 CSS 选择器的基础知识,获取网页链接 URL 就相对简单了。

3.分析网页结构,使用网页交互工具,我们可以快速发现每个网页有20个文章,也就是20个URL,id=中存在文章的列表标签下方的“存档”,然后像剥洋葱一样得到我们想要的URL链接。

4、点击下拉三角形,不难发现文章详情页的链接并没有隐藏很深,如下图圆圈所示。

5.根据标签,我们可以根据图片进行搜索,加上选择器工具,获取URL就像在搜索一样东西。在cmd中输入以下命令进入shell调试窗口,事半功倍。再次声明,这个URL是所有文章的URL,而不是某个文章的URL,否则调试半天也得不到结果。

6、根据第四步的网页结构分析,我们在shell中编写CSS表达式并输出,如下图所示。其中a::attr(href)的用法很巧妙,也是提取标签信息的一个小技巧。建议朋友在提取网页信息的时候可以经常使用,非常方便。

至此,第一页所有文章列表的url都获取到了。解压后的URL,如何交给Scrapy下载?下载完成后,如何调用我们自己定义的分析函数呢?