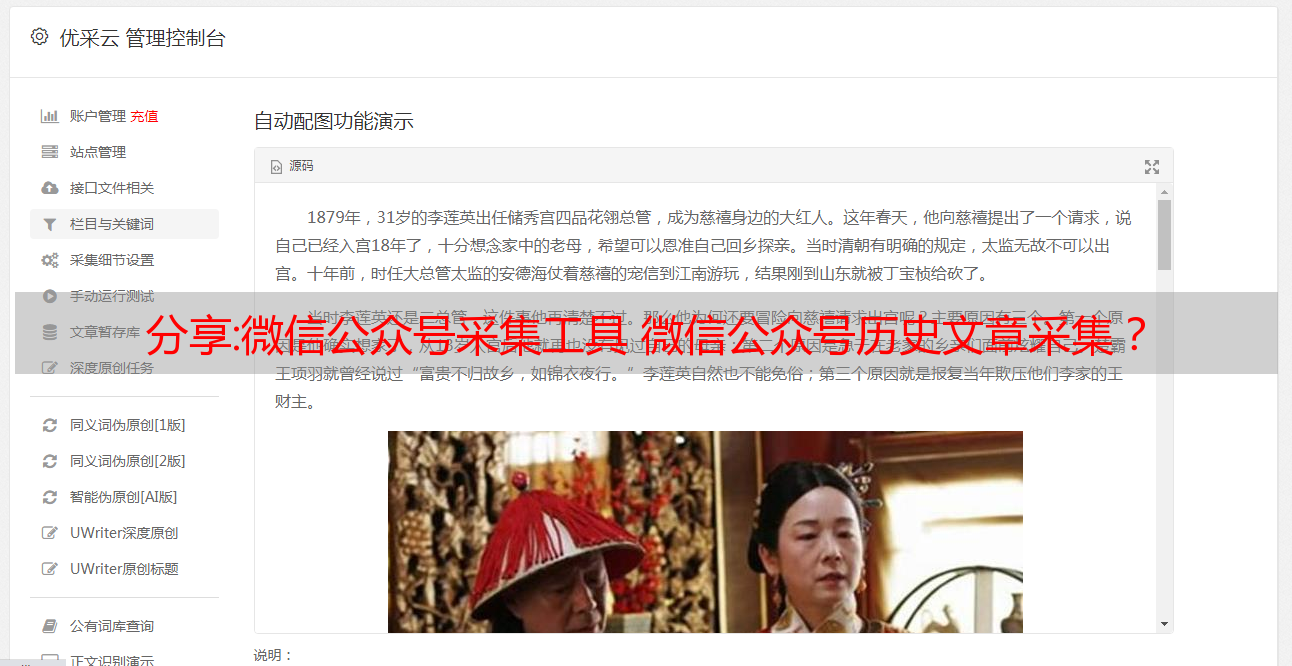

分享:微信公众号采集工具 微信公众号历史文章采集?

优采云 发布时间: 2022-10-17 18:12根据公众号采集,您可以使用博时公众号的功能,不仅可以阅读所有历史数据,还可以阅读最新的阅读数和积分。根据关键字采集,可以使用 文章 采集工具。

微信公众号历史文章采集?

你好。未来公众号的公众号小助手可以采集公众号和所有历史问题。页面模板中总结了该工具的呈现方式,例如使用数据挖掘等专业辅助工具,可以批量导出文章,点击搜索,搜索公众号,点击采集,操作简单)。可以用来爬取公众号索引。除了从微信公众号采集文章,还可以采集标题、文章和原创文章。公众号就是公众号:链接、阅读量、积分、发帖次数等。具体步骤如下:

1.采集需要采集的公共电话号码列表。

2.将这些公众号添加到您的自定义清算索引列表中。

3.clearindex会自动自动采集相关数据,然后注意如果没有相关公众号查询,需要进行入库操作。

哪个微信采集工具可以采集公众号的所有历史文章?

自媒体的新闻编辑是Bothink的趋势,多元化的动态表达,而不是单一的工具。我们的愿景是采集和归档的最佳方式。我们手中的笔,就是记录的意思。我们从不同的角度拍摄我们生活中的每一个视频和照片。所以,在自媒体领域,我们需要符合自己的标准,懂得随时随地捕捉各种素材,用智慧和现实生活中的点点滴滴,呈现出最具感染力的高品质为读者服务,履行媒体人的责任,完成服务大众的复兴使命!公众号采集一两篇文章也不错,自己复制采集也不错。你想批量采集和下载公众号吗?

如果是批量下载,只能用工具下载

前段时间用了一个有批量下载功能的工具文章

百度搜索兔兔数据,希望你能帮到我

1.首先,找到一个你要搜索的公众号。在下方输入公众号。有一些官方账号记录。您可以点击进入。

2.另外,还可以点击右上角的人形图标进入后台

3公众号并进入后台。我们将看到最新的 文章 内容。但这些都不能让我们满意。单击下拉列表以查找所有信息。点击后,我们将进入整个信息界面

4、进入全历史信息界面,面向全。界面会下拉,顶部会出现一个搜索框。

5.这个搜索框可以搜索本文历史文章。点击搜索进入搜索界面

6. 搜索界面,例如输入“HPV”,就会出现这个公众号所有关于HPV文章的界面。

免费获取:python自动获取微信公众号最新文章的实现代码

目录微信公众号获取思路采集示例微信公众号获取思路

获取微信公众号文章常用的方法有搜狐、微信公众号首页和api接口。

听说最近搜狐不太好用,而且之前使用的API接口也经常维护,所以使用微信公众平台进行数据爬取。

首先,登录你的微信公众平台。如果您没有帐户,您可以注册一个。进来后找“图文资料”,就是写公众号的地方

点击后会出现写公众号的界面文章。在界面中,您会找到“超链接”字段,您可以在其中搜索其他公众号。

以“python”为例,输入要检索的公众号名称,从显示的公众号中选择公众号为采集

点击浏览器查看,在网络中找到链接,下图中的链接,右边的Request URL是存储公众号数据的真实链接。表示这是一个 json 网页。

采集实例

与公众号“蟒蛇”>

https://mp.weixin.<a href=https://www.easck.com/tags/QQ/0.shtml target=_blank>QQ</a>.com/cgi-bin/appmsg:微信公众平台的链接

"token": "163455614", #需要定期修改的token

"lang": "zh_CN", #语言

"f": "json",

"ajax": "1", #显示几天的文章

"action": "list_ex"

"begin": "0", #起始页面

"count": "1", #计数

"query": "",

"fakeid": 'MzIwNDA1OTM4NQ==', #公众号唯一编码

"type": "9",

由于我发现fakeid是唯一代表公众号的代码,那么我只需要找到所需公众号的fakeid即可。我随机找了三个公众号进行测试。

fakeid=[ 'MzIwNDA1OTM4NQ==','MzkxNzAwMDkwNQ==','MjM5NzI0NTY3Mg==']

#若增加公众号需要增加fakeid

然后下一步就是请求URL

首先导入需要的库

import time

import requests

from lxml import etree

import pandas as pd

import json

import numpy as np

import datetime

import urllib3

from urllib3.exceptions import InsecureRequestWarning

urllib3.disable_warnings(InsecureRequestWarning)

由于不想重复登录公众号平台,可以使用cookies来避免登录。在请求文章之前,需要先找到网页的cookie和User-Agent。由于微信公众号是定期刷新的,所以这个cookie和上面的token都要定期刷新。代替。

为了避免反扒,最好找个代理ip

headers = {

"Cookie": "appmsglist_action_3567997841=card;wxuin=49763073568536;pgv_pvid=6311844914;ua_id=x6Ri8bc9LeaWnjNNAAAAADI-VXURALRxlSurJyxNNvg=;mm_lang=zh_CN;pac_uid=0_3cf43daf28071;eas_sid=11Q6v5b0x484W9i7W0Z7l7m3I8;rewardsn=;wxtokenkey=777;wwapp.vid=;wwapp.cst=;wwapp.deviceid=;uuid=fd43d0b369e634ab667a99eade075932;rand_info=CAESIHgWwDfp3W4M9F3/TGnzHp4kKkrkMiCEvN/tSNhHtNBm;slave_bizuin=3567997841;data_bizuin=3567997841;bizuin=3567997841;data_ticket=IfMEEajZ8UvywUZ1NiIv9eKZkq0cgeS0oP6tTzEwNSjwK6q+u5vLw0XYeFvLL/JA;slave_sid=aVBzSlpYOGt4eTdmbzFRWDc1OUhzR1A1UkwzdUdBaklDaGh2dWY2MUZKTEw1Um1aalZRUXg5aVBMeEJVNklCcGlVN0s5Z3VEMmRtVENHS1ZxNTBDOWRCR0p2V2FyY2daU0hxT09Remd5YmlhRWExZkMwblpweVc3SndUbnJIQk55MGhUeExJa1NJcWZ0QmJS;slave_user=gh_e0f449d4f2b6;xid=7d5dc56bb7bb526c70cfef3f6bdfa18a",

"User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_0) <a href=https://www.easck.com/tags/Apple/0.shtml target=_blank>Apple</a>WebKit/537.36 (KHTML, like Gecko) <a href=https://www.easck.com/tags/Chrome/0.shtml target=_blank>Chrome</a>/100.0.4896.75 Safari/537.36",

}

proxies = {'http': '112.80.248.73'}

接下来可以爬取页面,获取页面中的文章标题和文章链接,以及文章的时间,分析网页的信息,发现所有的信息网页保存在“app_msg_list”字段中,因此提取该字段中的数据。

代码显示如下:

得到的数据包存放在df中。这里的数据不是微信公众号最新的文章数据,而是微信公众号最近一天发送的文章数据。因此,还需要过滤发布时间。注意这里的时间格式是时间戳,所以需要转换时间数据

转换代码如下:

def time_s(df):

def transfer_time(s): #时间处理

aa = time.ctime(s)

bb = aa.split(' ')

<p>

cc = (bb[-1]+"-"+bb[1]+"-"+bb[-3]).replace('Jan','1').replace('Feb','2').replace('Mar','3'). \

replace('Apr','4').replace('May','5').replace('Jun','6').replace('Jul','7').replace('Aug','8') \

.replace('Sep','9').replace('Oct','10').replace('Nov','11').replace('Dec','12')

dd = datetime.datetime.strptime(cc,'%Y-%m-%d').date()

return dd

ti=[]

hd=[]

for i in range(0,len(df['time'])):

timestap= transfer_time(df['time'][i])

ti.append(timestap)

#print(ti)

d= ti[i] + datetime.timedelta(weeks=0, days=0, hours=0, minutes=0, seconds=0, milliseconds=0, microseconds=0, )

#dc = d.strftime("%Y-%m-%d")

hd.append(d)

df['time']=hd</p>

这样就可以将微信公众号的时间戳数据转换为时间数据,然后根据当天的日期提取数据集中的内容并存储。

dat=df[df['time'] == datetime.date.today() + datetime.timedelta(days= -1)] #自动获取昨天日期,将-1改为-2,则为前天的日期,以此类推

##改自动化

path = 'C:/Users/gpower/Desktop/work/行业信息/' #根据自己电脑位置更改

import re

filename=path+"微信公众号采集" + re.sub(r'[^0-9]','',datetime.datetime.now().strftime("%Y-%m-%d")) + '.csv'

# 对文件进行命名,以“微信公众号采集+当前日期”命名

dat.to_csv(filename,encoding='utf_8_sig')

print("保存成功")

这样就可以下载最新的微信公众号文章采集。如果需要多个微信公众号,可以在fakeid中添加公众号的识别码。

这是文章关于python自动获取微信公众号最新文章的介绍。更多关于python自动获取微信公众号文章的信息,请搜索第一财经站长上一页文章或继续浏览以下相关文章希望大家多多支持第一财经站长站未来!

如有侵权,请发邮件至[emailprotected]