完整的解决方案:wordpress采集插件哪个最好 WordPress建站,该如何选择服务器??

优采云 发布时间: 2022-10-16 02:06完整的解决方案:wordpress采集插件哪个最好 WordPress建站,该如何选择服务器??

搭建WordPress网站时如何选择服务器?服务器,这里知识渊博。免费备案的服务器为知名服务器厂商的服务器,如bricklayer、vultr、linode、digital ocean等,价格低廉,售后服务好,性价比高!备案服务器主要是阿里云、腾讯云等国内服务器厂商。

个人觉得国内服务器的上行带宽太低,让我很不爽。另外,备案很麻烦。

但好处是备案后可以收到国内百度联盟、360联盟、京东联盟、阿里妈妈的广告,服务器钱可以在短时间内赚回来!建议:尽量选择大厂的服务器,网站安全,如果实在不想录,或者实在缺钱,就选择国外的服务器,不然国内的服务器最好选择。一个好的服务区可以让你花更多的时间丰富网站内容,优化改进网站,建立自己的品牌wordpress博客,备份和恢复数据详细教程?第一步:备份数据,在旧空间登录phpMyAdmin进行数据备份,选择日志中的数据,将数据全部导出到本地,另存为。

SQL 然后将其保存为 TXT 文件。第二步:备份wordpress博客根目录下的WP内容文件,通过FTP下载到本地。

第三步:在新空间上传WordPress程序。安装成功后,在新空间输入phpMyAdmin,删除所有数据。

第四步:登录新空间的数据库面板phpMyAdmin,上传原备份。新数据库的 SQL 数据文件。

第五步:将备份的WP内容文件通过FTP上传到wordpress博客的根目录,替换旧的WP内容文件。第六步:分析,把新的空间放到IP上,这样WordPress搬家就完成了。

移动 Wordpress 博客的方法非常简单。只要按照这六个步骤,就可以成功完成一个WP博客的搬家。关于移动Wordpress博客的教程有很多,多尝试就可以成功改变空间。织梦采集下采集的内容可以发表在wordpress上吗?这个好像不行

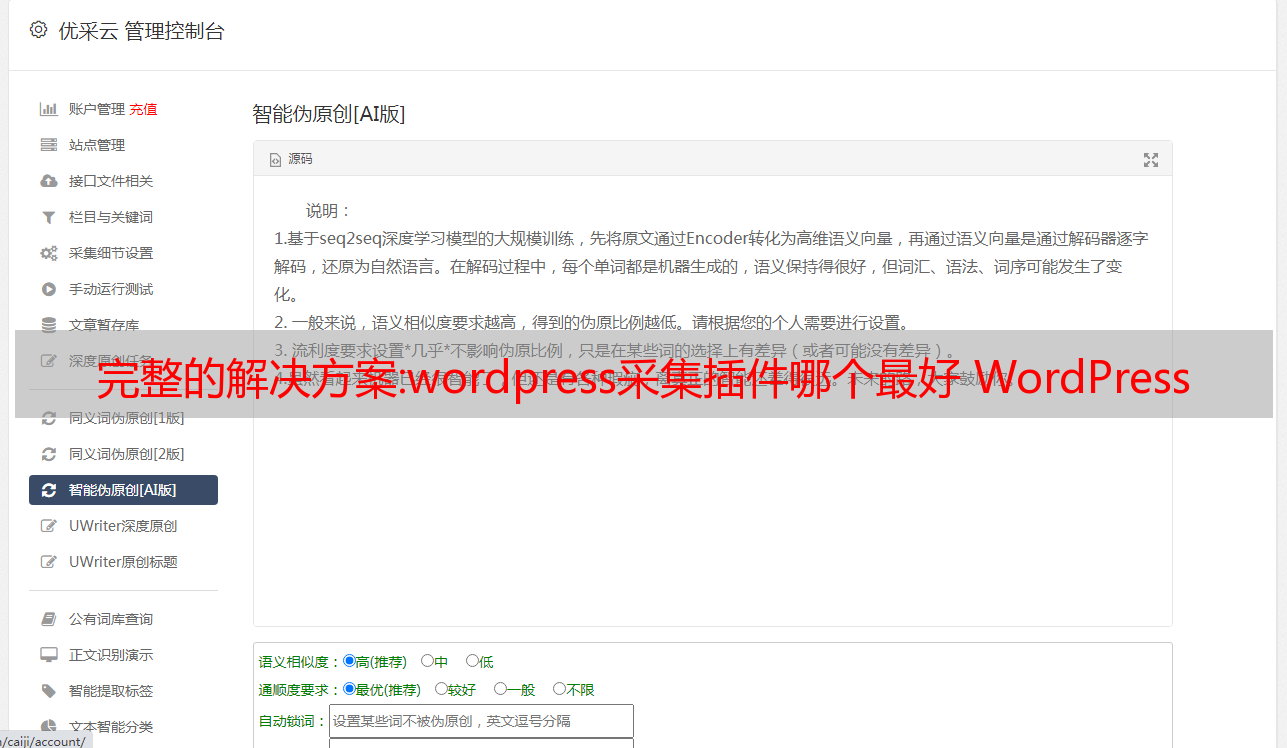

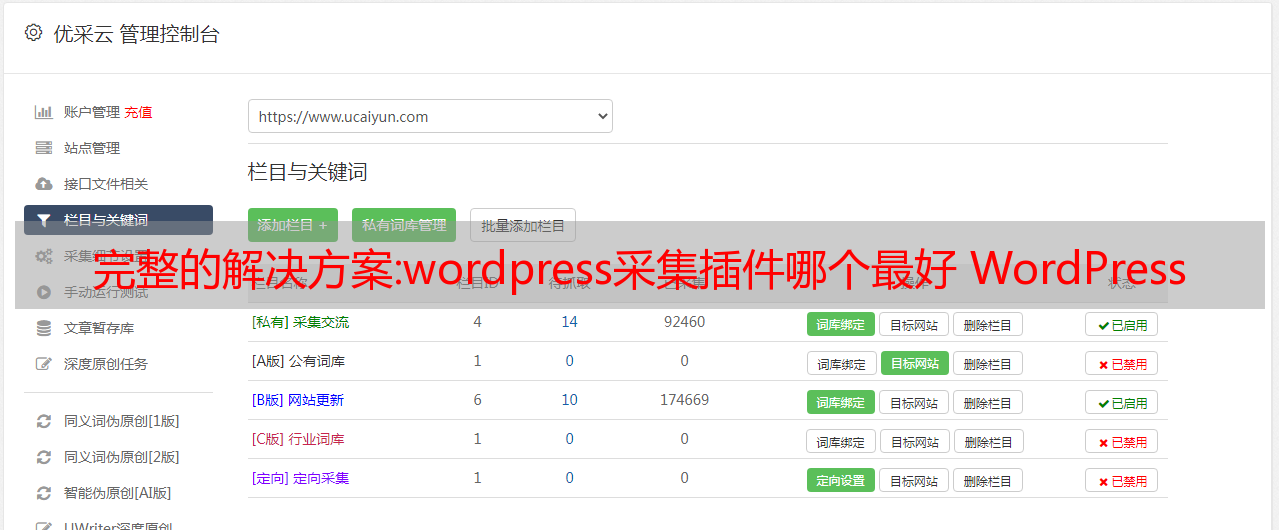

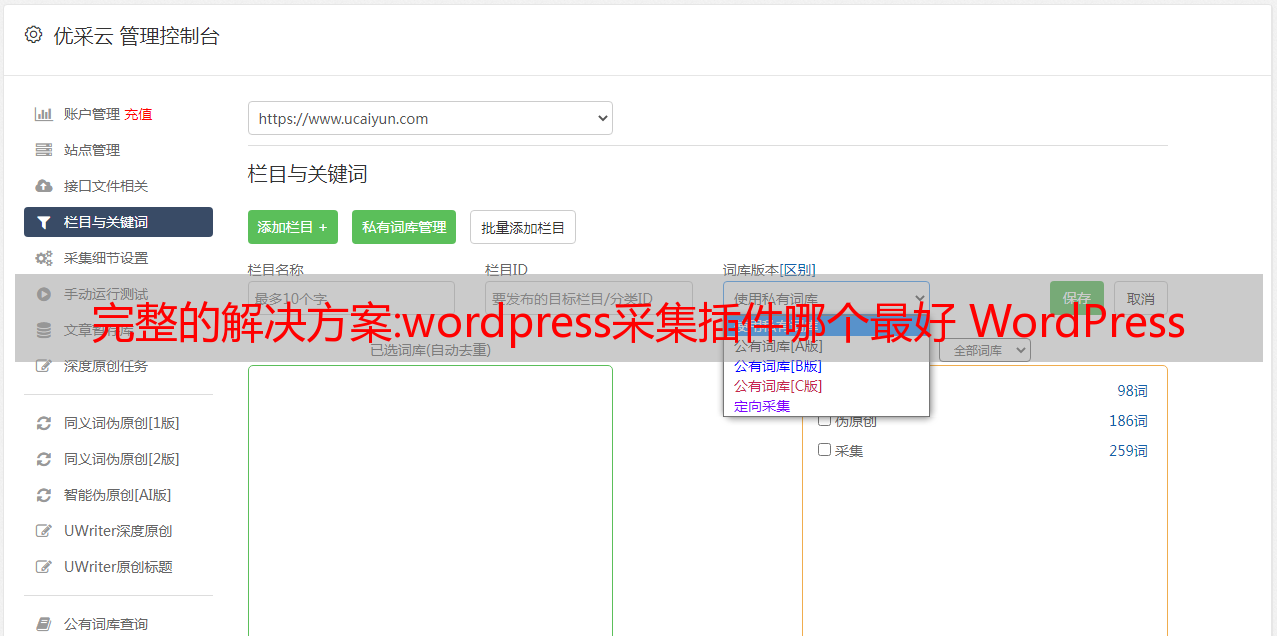

如果你想在 WordPress 上采集数据,你可以使用 WordPress 的采集插件。或者通过 Locomotive Collector 采集并发布到 WordPress网站。

优化的解决方案:性能优越的轻量级日志收集工具,微软、亚马逊都在用!

ELK日志采集系统大家都知道,但是还有一个日志采集系统EFK,想必很多朋友都不知道!这里的F指的是Fluentd,它有类似Logstash的日志采集功能,但是内存占用不到Logstash的十分之一,而且性能优越,非常轻量级。本文将详细介绍Fluentd的使用,主要用于采集SpringBoot应用程序的日志。希望对大家有帮助!

Fluentd 简介

Fluentd 是一个开源的日志采集功能,致力于为用户构建统一的日志采集层,可以与 Elasticsearch 和 Kibana 一起构建 EFK 日志采集系统。什么是统一日志采集层?看看下面的图片就可以看得一清二楚了!

从 Fluentd 官网安装

ELK日志采集系统的搭建在中已经介绍过了,这里不再介绍Elasticsearch和Kibana的安装,而是Docker环境下Fluentd的安装。

docker pull fluent/fluentd:v1.10<br />

<br /> @type forward<br /> @id input1<br /> @label @mainstream<br /> port 24224<br /><br /><br /><br /> @type stdout<br /><br /><br /><br /> <br /> @type file<br /> @id output_docker1<br /> path /fluentd/log/docker.*.log<br /> symlink_path /fluentd/log/docker.log<br /> append true<br /> time_slice_format %Y%m%d<br /> time_slice_wait 1m<br /> time_format %Y%m%dT%H%M%S%z<br /> <br /> <br /> @type file<br /> @id output1<br /> path /fluentd/log/data.*.log<br /> symlink_path /fluentd/log/data.log<br /> append true<br /> time_slice_format %Y%m%d<br /> time_slice_wait 10m<br /> time_format %Y%m%dT%H%M%S%z<br /> <br /><br />

docker run -p 24221:24221 -p 24222:24222 -p 24223:24223 -p 24224:24224 --name efk-fluentd \<br />-v /mydata/fluentd/log:/fluentd/log \<br />-v /mydata/fluentd/fluent.conf:/fluentd/etc/fluent.conf \<br />-d fluent/fluentd:v1.10<br />

chmod 777 /mydata/fluentd/log/<br />

docker exec -it --user root efk-fluentd /bin/sh<br />

fluent-gem install fluent-plugin-elasticsearch<br />

version: '3'<br />services:<br /> elasticsearch:<br /> image: elasticsearch:6.4.0<br /> container_name: efk-elasticsearch<br /> user: root<br /> environment:<br /> - "cluster.name=elasticsearch" #设置集群名称为elasticsearch<br /> - "discovery.type=single-node" #以单一节点模式启动<br /> - "ES_JAVA_OPTS=-Xms512m -Xmx512m" #设置使用jvm内存大小<br /> - TZ=Asia/Shanghai<br /> volumes:<br /> - /mydata/elasticsearch/plugins:/usr/share/elasticsearch/plugins #插件文件挂载<br /> - /mydata/elasticsearch/data:/usr/share/elasticsearch/data #数据文件挂载<br /> ports:<br /> - 9200:9200<br /> - 9300:9300<br /> kibana:<br /> image: kibana:6.4.0<br /> container_name: efk-kibana<br /> links:<br /> - elasticsearch:es #可以用es这个域名访问elasticsearch服务<br /> depends_on:<br /> - elasticsearch #kibana在elasticsearch启动之后再启动<br /> environment:<br /> - "elasticsearch.hosts=http://es:9200" #设置访问elasticsearch的地址<br /> - TZ=Asia/Shanghai<br /> ports:<br /> - 5601:5601<br /> fluentd:<br /> image: fluent/fluentd:v1.10<br /> container_name: efk-fluentd<br /> user: root<br /> environment:<br /> - TZ=Asia/Shanghai<br /> volumes:<br /> - /mydata/fluentd/log:/fluentd/log<br /> - /mydata/fluentd/fluent.conf:/fluentd/etc/fluent.conf<br /> depends_on:<br /> - elasticsearch #kibana在elasticsearch启动之后再启动<br /> links:<br /> - elasticsearch:es #可以用es这个域名访问elasticsearch服务<br /> ports:<br /> - 24221:24221<br /> - 24222:24222<br /> - 24223:24223<br /> - 24224:24224<br />

Fluentd 配置细节

接下来介绍一下如何配置Fluentd的配置文件,先发布完整的配置,然后再详细讲解一些配置点。

完全配置

<br /> @type tcp<br /> @id debug-input<br /> port 24221<br /> tag debug<br /> <br /> @type json<br /> <br /><br /><br /><br /> @type tcp<br /> @id error-input<br /> port 24222<br /> tag error<br /> <br /> @type json<br /> <br /><br /><br /><br /> @type tcp<br /> @id business-input<br /> port 24223<br /> tag business<br /> <br /> @type json<br /> <br /><br /><br /><br /> @type tcp<br /> @id record-input<br /> port 24224<br /> tag record<br /> <br /> @type json<br /> <br /><br /><br /><br /> @type parser<br /> key_name message<br /> reserve_data true<br /> remove_key_name_field true<br /> <br /> @type json<br /> <br /><br /><br /><br /> @type stdout<br /> output_type json<br /><br /><br /><br /> @type elasticsearch<br /> host 192.168.3.101<br /> port 9200<br /> type_name docker<br /> logstash_format true<br /> logstash_prefix docker-${tag}-logs<br /> logstash_dateformat %Y-%m-%d<br /> flush_interval 5s<br /> include_tag_key true<br /><br />

配置点分析

定义日志采集的来源,可以是tcp、udp、tail(文件)、forward(tcp+udp)、http等。

这里我们从tcp请求中采集日志,端口为24221,标签设置为debug。

<br /> @type tcp<br /> @id debug-input<br /> port 24221<br /> tag debug<br /> <br /> @type json<br /> <br /><br />

定义如何解析原创数据并将日志转换为 JSON。

例如,我们可以将调试日志转换为 JSON 并进行如下配置。

<br /> @type tcp<br /> @id debug-input<br /> port 24221<br /> tag debug<br /> <br /> @type json<br /> <br /><br />

可以对采集到的日志进行一系列处理,例如将日志打印到控制台或解析日志。

将所有日志打印到控制台的配置:

<br /> @type stdout<br /><br />

对于tag为记录源的日志,我们将message属性转换为JSON格式。如果未转换,则消息属性将是一个字符串。

<br /> @type parser<br /> key_name message<br /> reserve_data true<br /> remove_key_name_field true<br /> <br /> @type json<br /> <br /><br />

定义采集到的日志最终输出到哪里,可以输出到stdout(console)、file、elasticsearch、mongo等。

这里我们使用elasticsearch来存储日志信息。logstash_format、logstash_prefix、logstash_dateformat主要用于控制日志索引名的生成。目前配置的生成调试日志的索引格式是docker-debug-logs-2020-06-03,flush_interval用来控制日志输出到elasticsearch的时间间隔。

<br /> @type elasticsearch<br /> host 192.168.3.101<br /> port 9200<br /> type_name docker<br /> logstash_format true<br /> logstash_prefix docker-${tag}-logs<br /> logstash_dateformat %Y-%m-%d<br /> flush_interval 5s<br /> include_tag_key true<br /><br />

替换配置文件

替换原来的/mydata/fluentd/fluent.conf配置文件,然后重启服务,我们的Fluentd服务就可以开始采集日志了。

docekr restart efk-fluentd<br />

与 SpringBoot 一起使用

其实Fluentd的日志采集原理和Logstash是一样的。它通过tcp端口采集日志,所以我们只需要将logback配置文件中原来的Logstash日志采集地址端口改为Fluentd的。

<br /><br /> ${LOG_STASH_HOST}:24221<br /><br /><br /><br /><br /> ${LOG_STASH_HOST}:24222<br /><br /><br /><br /><br /> ${LOG_STASH_HOST}:24223<br /><br /><br /><br /><br /> ${LOG_STASH_HOST}:24224<br /><br />

logstash:<br /> host: localhost<br />

在 Kibana 中查看日志

至此,我们的EFK日志采集系统就完成了,只需要在Kibana中使用即可。

Logstash 与 Fluentd

接下来,我们来比较一下这两种日志采集工具的各个方面。

LogstashFluentd 的比较

内存使用情况

开始1G左右

开始约60M

CPU使用率

更高

降低

插件支持

富有的

富有的

一般日志解析

支持grok(基于正则表达式)解析

支持正则表达式解析

特定的日志类型

支持JSON等主流格式

支持JSON等主流格式

数据过滤

支持

支持

数据缓冲区发送

插件支持

插件支持

操作环境

JRuby实现,依赖JVM环境

CRuby,C实现,依赖Ruby环境

线程支持

支持多线程

多线程受 GIL 限制

参考

官方文档:

项目源码地址