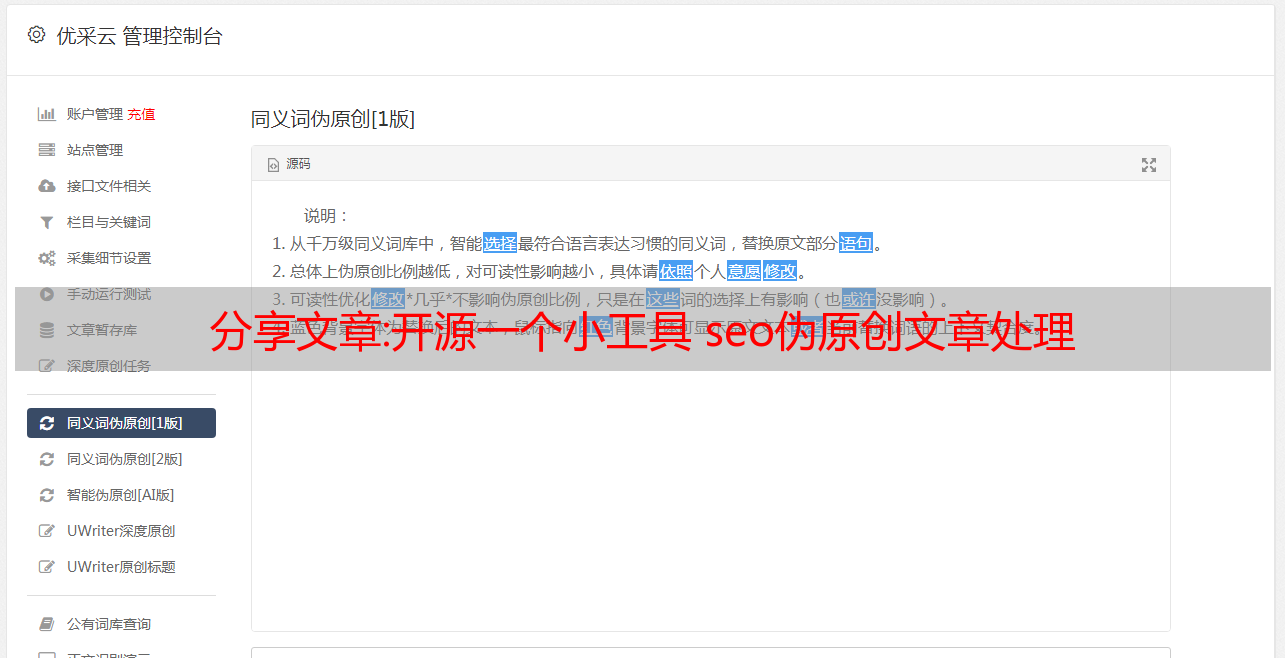

分享文章:开源一个小工具 seo伪原创文章处理

优采云 发布时间: 2022-10-14 11:24分享文章:开源一个小工具 seo伪原创文章处理

网站 SEO文章伪原创在线生成工具网站源代码

经过一周的二次开发,根代码是在线SEO伪原创,源代码没有任何缺陷,没有任何问题,工具类网站。 主要功能介绍 1.支持文章在线伪原创功能 2.支持关键词 Exchange 预览版 3.独立背景 4.支持访客提交交换关键词(后台能够审核用户...

)。

PHP在线SEO文章伪原创同义词交换工具源代码支持在独立背景下提交关键词

PHP在线SEO文章伪原创同义词交换工具源代码支持关键词提交独立后台帐户密码有效演示:1.支持文章在线伪原创功能 2.支持关键字交换预览 3.具有独立背景 4.支持访客提交关键词。支持效果演示。支持关键字交换预览 3.有独立的背景...支持提交访客。支持.提交结果,支持.提交功能..支持.ExcelScope.Supports.Submit.支持者.Portal门户.支持的语音顾问.支持关键字交换预览 3.后台独立.支持用户提交 ..支持者提交关键字演示文稿.可支持性 T

PHP在线搜索引擎优化文章伪原创同义词交换工具源代码

PHP在线SEO文章伪原创同义词交换工具源代码支持关键词提交独立背景 1.支持文章在线伪原创功能 2.支持关键字交换预览 3.拥有独立背景 4.支持访客提交关键词(后台可以查看用户提交的关键词) 5.完全开源,支持二次开发...

网站SEO文章伪原创在线生成网站源代码

经过一周的二次开发,根代码是在线SEO伪原创,源代码没有任何缺陷,没有任何问题,工具类网站。 SEO在线伪原创工具源代码主要功能介绍1,支持文章在线伪原创功能2,支持关键词交流预览3,具有独立背景4,支持客人提交....

行业实践:python爬虫网络安全的_python爬虫实践教学

一、引言

这个文章以前是用来培训新人的,大家都觉得很容易理解,于是我和大家分享,学习了。如果你已经学会了一些python,并且想用它做点什么而没有方向,请尝试完成以下情况。

二、环境准备

安装请求 lxml 美趣汤4

三个库(以下代码在 python3.5 环境中进行了测试)pip 安装请求 lxml 美女汤4

三、抓取工具获取本地公共IP地址的几个小案例

使用百度搜索界面编写网址采集器

自动下载搜狗壁纸

自动填写调查

获取公网代理的IP地址,判断是否可以使用和延时

3.1 获取本地公网IP地址

以在公网查询IP为借口,使用python的请求库自动获取IP地址导入请求。

r = 请求。

r.编码 = r.apparent_encoding #使用requests的字符编码智能分析以避免中文乱码

打印(r.文本)

# 您还可以使用常规匹配的 re 模块提取 IP

导入再

print(re.findall(“\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}”,r.text))

3.2 使用百度搜索界面编写网址采集器

在本例中,我们将请求与美丽汤库结合使用来完成任务。我们希望在程序中设置用户代理标头,以绕过百度搜索引擎的反爬网程序机制(您可以尝试不添加User-Agent标头,看看是否可以获取数据)。注意观察百度搜索结构的URL链接规则,比如第一页的url链接参数pn=0,url链接参数pn=10。等等。在这里,我们使用css选择器路径提取数据。导入请求

从 bs4 导入 美丽汤

# 设置用户代理头,绕过百度搜索引擎的反爬虫机制

标头 = {'用户代理': 'Mozilla/5.0 (X11;Linux x86_64;rv:52.0) 壁虎/20100101火狐/52.0'}

# 注意观察百度搜索结构的URL链接规则,如第一页pn=0,第二页pn=10....等,下面对前10页的结果进行循环搜索

对于范围(0,100,10)中的 i:

bd_search = “:/dede/login.php?&pn=%s” % str(i)

r = 请求(bd_search,标头 = 标头)

汤 = 美丽汤(r.text,“lxml”)

# 以下选择使用 css 选择器路径提取数据

url_list = 汤选(“.t > a”)

对于url_list网址:

real_url = 网址[“href”]

r = 请求(real_url)

打印(网址)

编写完程序后,我们使用关键词inurl:/dede/login .php批量提取织梦cms的背景地址,效果如下:

3.3 自动下载搜狗壁纸

在此示例中,我们将通过爬虫自动下载搜索壁纸,并将程序中存储的图像的路径更改为要存储图像的目录路径。还有一点是我们在程序中使用了json库,因为在观察中,我们发现搜狗壁纸的地址是以json格式存储的,所以我们用json来解析这组数据。导入请求

导入 json

#下载图片

网址 = “”

r = 请求。

data = json.loads(r.text)

对于数据中的 i[“all_items”]:

img_url = i[“pic_url”]

# 以下行中的路径可以更改为要存储图像的目录路径

与打开(“/home/evilk0/Desktop/img/%s” % img_url[-10:]+“.jpg”,“wb”) 作为 f:

r2 = 请求(img_url)

f.写(r2.内容)

打印(“下载完成:”,img_url)。

3.4 自动填充问卷导入请求

导入随机

网址 = “”

数据 = {

“submitdata” : “1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s”

}

标头 = {

“用户代理” : “Mozilla/5.0 (X11;Linux x86_64) 苹果网络工具包/537.36 (KHTML, 像壁虎一样)“,

“饼干”: “.ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41;蜘蛛网=%c2%a7%e7%9b%b4%e8%be%be%c2%a71;UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912;Wjx用户=用户名=&类型=1;上次检查更新日期 = 1;上次检查设计=1;删除Q饼干=1;_cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C68;jac21581199=78751211;CNZZDATA4478442=cnzz_eid%3D878068609-1521456533Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471;Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471“,

}

对于范围中的 i(0,500):

选择 = (

随机林丁(1, 2),

随机林丁(1, 4),

random.randint(1, 3),

随机林丁(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

数据[“提交数据”] = 数据[“提交数据”] % 选择

r = requests.post(网址 = 网址,标头 = 标头,数据 = 数据)

打印(r.文本)

data[“submitdata”] = “1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s”

当我们使用同一IP提交多份问卷时,会触发目标的反爬虫机制,服务器会出现验证码。

我们可以使用 X-转发-For 来伪造我们的 IP,代码修改如下:导入请求

导入随机

网址 = “”

数据 = {

“submitdata” : “1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s”

}

标头 = {

“用户代理” : “Mozilla/5.0 (X11;Linux x86_64) 苹果网络工具包/537.36 (KHTML, 像壁虎一样)“,

“饼干”: “.ASPXANONYMOUS=iBuvxgz20wEkAAAAZGY4MDE1MjctNWU4Ni00MDUwLTgwYjQtMjFhMmZhMDE2MTA3h_bb3gNw4XRPsyh-qPh4XW1mfJ41;蜘蛛网=%c2%a7%e7%9b%b4%e8%be%be%c2%a71;UM_distinctid=1623e28d4df22d-08d0140291e4d5-102c1709-100200-1623e28d4e1141; _umdata=535523100CBE37C329C8A3EEEE289B573446F594297CC3BB3C355F09187F5ADCC492EBB07A9CC65CD43AD3E795C914CD57017EE3799E92F0E2762C963EF0912;Wjx用户=用户名=&类型=1;上次检查更新日期 = 1;上次检查设计=1;删除Q饼干=1;_cnzz_CV4478442=%E7%94%A8%E6%88%B7%E7%89%88%E6%9C%AC%7C%E5%85%8D%E8%B4%B9%E7%89%88%7C68;jac21581199=78751211;CNZZDATA4478442=cnzz_eid%3D878068609-1521456533Hm_lvt_21be24c80829bd7a683b2c536fcf520b=1521461287,1521463471;Hm_lpvt_21be24c80829bd7a683b2c536fcf520b=1521463471“,

“X 转发- For” : “%s”

}

对于范围中的 i(0,500):

选择 = (

随机林丁(1, 2),

随机林丁(1, 4),

random.randint(1, 3),

随机林丁(1, 4),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

random.randint(1, 3),

)

数据[“提交数据”] = 数据[“提交数据”] % 选择

header[“X-转发-For”] = (str(随机 1,255)+“。+(1,255)+“.”)+(1,255)+“.”)+str(随机 1,255)

r = requests.post(网址 = 网址,标头 = 标头,数据 = 数据)

打印(页眉[“X-转发-For”],r.text)

data[“submitdata”] = “1$%s}2$%s}3$%s}4$%s}5$%s}6$%s}7$%s}8$%s}9$%s}10$%s”

标头[“X 转发-For”] = “%s”

渲染:

关于这个文章,因为我之前写过,我就不重复了,我有兴趣直接看:[如何通过Python自动填写问卷]。

3.5 获取公网代理的IP地址,确定是否可以使用以及延迟时间

在此示例中,我们希望对塞浦路斯代理上的代理 IP 进行爬网,并验证这些代理的可行性和延迟时间。(您可以将已爬网的代理 IP 添加到代理链,然后执行通常的渗透任务。在这里,我直接调用 Linux 系统命令 ping -c 1“ + ip.字符串 + ” |awk 'NR==2{print}' -,如果要在 Windows 中运行此程序,则需要在倒数第二行修改 os.popen 中的命令,并将其更改为 Windows 可以执行的命令。从 bs4 导入 美丽汤

导入请求

导入操作系统