分享文章:伪原创文章和原创文章的区别是什么 怎么才能写出优质的伪原创文章

优采云 发布时间: 2022-10-12 08:33分享文章:伪原创文章和原创文章的区别是什么 怎么才能写出优质的伪原创文章

什么是伪原创论文?伪原创组合物和原创组合物有什么区别?我怎样才能写出高质量的伪原创论文?今天我将谈谈伪原创论文写作方法和技巧。

首先,我们必须了解伪原创是什么,知道伪原创的原则,知道使伪原创更好的原则。那么,什么是伪原创?伪原创基于原创,以原创文章为中心,重新排版和编辑以进行二次创作。

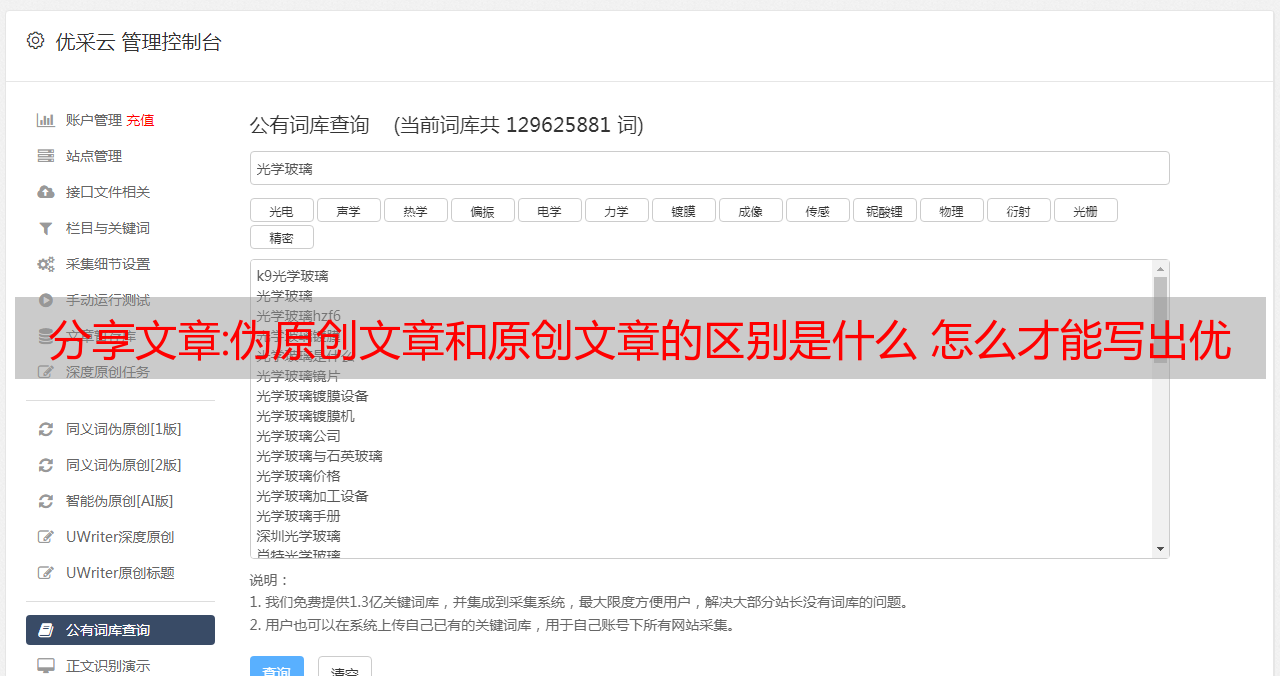

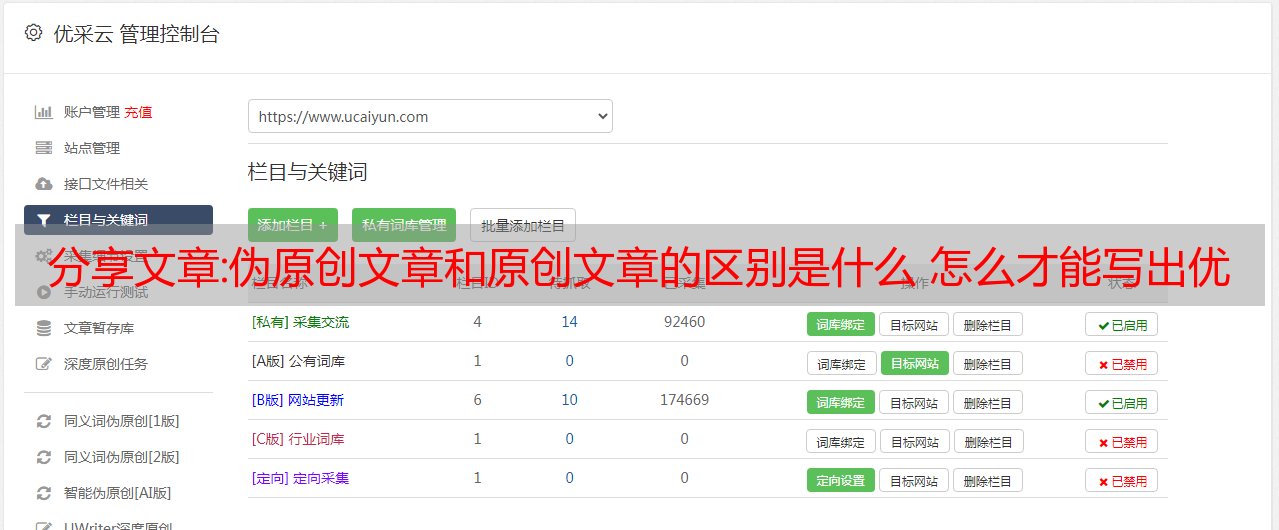

伪原创有两个步骤。第一步是查找资源,第二步是再次编辑资源。资源从何而来?它只不过是同行业中的一网站。我建议你采集同行业的优质网站,观察这些网站每天更新什么,筛选资源,丢弃劣质资源,留下优质资源,然后伪原创优质资源,通过伪原创获得比原来更好的资源。

伪原创?这个问题必须澄清。伪原创不是要区别于原创,而是要进一步提高文章质量,给用户更好的阅读体验。如果只是为了愚弄搜索引擎,那么伪原创就失去了意义,没有质量的伪原创就是垃圾邮件。

伪原创有两个关键点,一个是资源的选择,二是创造二次创作的能力。

个人感悟:一文读懂大数据平台——写给大数据初学者的话

一篇了解大数据平台的文章——写给大数据开发初学者!Hadoop怎么学,Hadoop应该学什么?如何学习?

大数据方向应该学什么技术,学习路线是什么,我觉得大数据很火,就业很好,薪水很高……如果你迷茫,请思考:什么您对计算机/软件感兴趣吗?对操作系统、硬件、网络、服务器感兴趣?对软件开发、编程、编写代码感兴趣?或者您对数据和数字特别感兴趣?

大数据的三个发展方向:

请不要问我哪个更容易,哪个前景更好,哪个更贵。先从大数据的4V特性说起:

1、数据量大:TB->PB

2. 数据类型很多:结构化、非结构化文本、日志、视频、图片、地理位置等;

3、商业价值高:但这个价值需要在海量数据之上通过数据分析和机器学习更快地挖掘出来;

4、处理时效性高:海量数据的处理需求不再局限于离线计算。

如今,为了应对大数据的这些特点,开源的大数据框架越来越多,而且越来越强大。让我们先列出一些常见的:

文件存储:Hadoop HDFS、Tachyon、KFS

离线计算:Hadoop MapReduce、Spark

流式传输、实时计算:Storm、Spark Streaming、S4、Heron

KV、NOSQL 数据库:HBase、Redis、MongoDB

资源管理:YARN、Mesos

日志采集:Flume、Scribe、Logstash、Kibana

消息系统:Kafka、StormMQ、ZeroMQ、RabbitMQ

查询分析:Hive、Impala、Pig、Presto、Phoenix、SparkSQL、Drill、Flink、Kylin、Druid

分布式协调服务:Zookeeper

集群管理和监控:Ambari、Ganglia、Nagios、Cloudera Manager

数据挖掘、机器学习:Mahout、Spark MLLib

数据同步:Sqoop

任务调度:Oozie…

眼花缭乱,有30多种,别说精通了,个个都会用,估计也不多。

第 1 章:了解 Hadoop 1.1 学习百度和谷歌

无论您遇到什么问题,请先尝试搜索并自己解决。谷歌首选,翻不了就用百度。

1.2 参考资料首选官方文档

特别是对于入门来说,官方文档始终是首选文档。我相信大多数这样做的人都是有文化的人,只是凑合着用英语。如果实在受不了,请参考第一步。

1.3 让Hadoop先运行

Hadoop可以说是大数据存储和计算的鼻祖。现在大多数开源大数据框架都依赖于 Hadoop 或者与之很好地兼容。

关于Hadoop,你至少需要弄清楚以下几点:

要自己构建 Hadoop,请使用第一步和第二步使其运行。建议先使用安装包命令行安装,不要使用管理工具安装。

另外:现在使用Hadoop 2.0及以上版本

1.4 尝试使用Hadoop 1.5 你应该了解他们的原理 1.6 自己写一个MapReduce程序

请按照 WordCount 示例,自己编写一个 WordCount 程序(或复制),打包提交给 Hadoop 运行。你不懂Java?Shell,Python都可以,有个东西叫Hadoop Streaming。

如果你仔细完成了以上步骤,恭喜你,你的一只脚已经进来了。

第 2 章:更高效的 WordCount 2.1 学习 SQL

你知道数据库吗?你会写SQL吗?如果没有,请学习一些 SQL。

2.2 SQL的字数

在 1.6 中,您编写(或复制)了多少行代码 WordCount?

给你看我的:SELECT word,COUNT(1) FROM wordcount GROUP BY word;

这就是 SQL 的魅力。编程需要几十行甚至上百行代码,我一句话就可以搞定。在 Hadoop 上使用 SQL 处理和分析数据方便、高效、易用,是一种趋势。无论是离线计算还是实时计算,越来越多的大数据处理框架都在积极提供SQL接口。

2.3 SQL On Hadoop的Hive

什么是蜂巢?官方的解释是:Apache Hive 数据仓库软件便于读取、写入和管理位于分布式存储中的大型数据集,并使用 SQL 语法进行查询。

为什么 Hive 是数据仓库工具,而不是数据库工具?有些朋友可能不知道数据仓库。数据仓库是一个逻辑概念。底层使用数据库。数据仓库中的数据有这两个特点:历史数据最全(海量),比较稳定;所谓相对稳定,就是说数据仓库不同于业务系统数据库,数据经常更新。数据一旦进入数据仓库,很少更新和删除,只会大量查询。Hive 也有这两个特点。因此,Hive 适合作为海量数据的数据仓库工具,而不是数据库工具。

2.4 安装配置Hive

请参考1.1和1.2完成Hive的安装和配置。可以正常进入Hive命令行。

2.5 尝试使用 Hive

请参考1.1和1.2在Hive中创建wordcount表并运行2.2中的SQL语句。

在 Hadoop WEB 界面中找到刚才运行的 SQL 任务。看

SQL查询结果是否与MapReduce 1.4中的结果一致。

2.6 Hive 的工作原理

明明是用SQL写的,为什么我在Hadoop WEB界面看到MapReduce任务?

2.7 学习Hive的基本命令

创建和删除表;

将数据加载到表中;

下载Hive表的数据;

有关 Hive 语法和命令的更多信息,请参阅 1.2。

如果你已经认真、完整地按照第 1 章和第 2 章的步骤进行操作,那么你应该已经具备以下技能和知识点:

Hadoop2.0的特点;MapReduce原理(还是经典话题,10G文件,给定1G内存,如何用Java程序统计出现频率最高的10个单词和出现次数);HDFS读写数据过程;将数据放入 HDFS;从 HDFS 下载数据;自己编写简单的MapReduce程序,如果运行出现问题,知道在哪里查看日志;编写简单的SELECT、WHERE、GROUP BY等SQL语句;Hive SQL 转换成 MapReduce 的一般流程;Hive中常用语句:建表、删除表、加载数据入表、分区、下载表中数据到本地;

通过以上学习,你了解到HDFS是Hadoop提供的分布式存储框架,可以用来存储海量数据,MapReduce是Hadoop提供的分布式计算框架,可以用来统计和分析海量数据HDFS 和 Hive 是 Hadoop 上的 SQL。Hive 提供了一个 SQL 接口。开发者只需要编写简单易用的 SQL 语句。Hive 负责将 SQL 翻译成 MapReduce 并提交操作。

此时,您的“大数据平台”如下所示:

那么问题来了,如何把海量数据拿到HDFS上呢?

如果你仔细完成了以上步骤,那么恭喜你,你的半条腿已经进来了。

第 3 章:将数据从其他地方引入 Hadoop

这里也可以称为data采集,将各个数据源的data采集传输到Hadoop。

3.1 HDFS PUT 命令

你以前应该用过这个。

put命令在实际环境中也比较常用,通常与shell、python等脚本语言配合使用。

推荐熟练度。

3.2 HDFS API

HDFS 提供了用于写入数据的 API。您可以使用自己的编程语言将数据写入 HDFS。put 命令本身也使用 API。

在实际环境中,编写程序并使用API将数据写入HDFS的情况一般比较少见,通常使用其他框架封装的方法。例如:Hive 中的 INSERT 语句、Spark 中的 saveAsTextfile 等。

建议了解原理,写Demo。

3.3 Sqoop

Sqoop 是一个开源框架,主要用于 Hadoop/Hive 与 Oracle/MySQL/SQLServer 等传统关系型数据库之间的数据交换。就像 Hive 将 SQL 翻译成 MapReduce 一样,Sqoop 将你指定的参数翻译成 MapReduce,提交给 Hadoop 运行,完成 Hadoop 与其他数据库之间的数据交换。

自己下载并配置Sqoop(建议先使用Sqoop1,Sqoop2比较复杂)。了解 Sqoop 常用的配置参数和方法。

使用 Sqoop 将数据从 MySQL 同步到 HDFS;

使用 Sqoop 将数据从 MySQL 同步到 Hive 表;

PS:如果后续选择确定使用Sqoop作为数据交换工具,建议精通,否则,理解和使用Demo就足够了。

3.4 水槽

Flume是一个分布式海量日志采集和传输框架,由于“采集和传输框架”,不适合关系型数据库数据采集和传输。Flume 可以实时采集从网络协议、消息系统和文件系统中获取日志,并将它们传输到 HDFS。因此,如果你的业务有来自这些来源的数据并且需要实时采集,那么应该考虑使用 Flume。

下载并配置 Flume。使用 Flume 监控一个不断追加数据的文件,并将数据传输到 HDFS;

PS:Flume的配置和使用比较复杂。如果你没有足够的兴趣和耐心,你可以先跳过 Flume。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第 4 章:从其他地方获取 Hadoop 数据

上一节介绍了如何将数据从数据源 采集 传输到 Hadoop。数据上 Hadoop 后,可以使用 Hive 和 MapReduce 进行分析。那么接下来的问题是,如何将分析结果从 Hadoop 同步到其他系统和应用程序?

其实这里的方法和第三章基本一样。

4.1 HDFS GET 命令

将 HDFS 上的文件获取到本地。需要熟练度。

4.2 HDFS API

与 3.2 相同。

4.3 Sqoop

与 3.3 相同。使用 Sqoop 将 HDFS 上的文件同步到 MySQL;使用 Sqoop 将 Hive 表中的数据同步到 MySQL;

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

如果你已经认真、完整地按照本文第 3 章和第 4 章的步骤进行操作,那么你应该已经具备以下技能和知识点:

知道如何将现有数据采集放到HDFS上,包括离线采集和实时采集;你已经知道 sqoop 是 HDFS 和其他数据源之间的数据交换工具;你已经知道了flume可以作为实时日志采集;

从之前的学习中,你已经掌握了很多大数据平台搭建Hadoop集群的知识和技能,

将数据采集放到Hadoop上,使用Hive和MapReduce对数据进行分析,将分析结果同步到其他数据源。

下一个问题来了,Hive用的越来越多,你会发现很多不爽的地方,尤其是速度慢,

在大多数情况下,即使我的数据量很小,它也必须申请资源并启动 MapReduce 才能执行。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第五章:快点

My SQL 其实大家发现Hive后台使用MapReduce作为执行引擎,确实很慢。

因此,SQL On Hadoop 的框架越来越多。据我所知,最常用的是 SparkSQL、Impala 和 Presto,按受欢迎程度排序。

这三个框架基于半内存或全内存,并提供SQL接口快速查询和分析Hadoop上的数据。三者的比较见1.1。

我们目前正在使用 SparkSQL。至于我们为什么使用 SparkSQL,大概有以下几个原因:

5.1 关于Spark和SparkSQL 5.2 如何部署和运行SparkSQL

PS:Spark不是一门短时间内就能掌握的技术,所以建议在了解Spark之后,可以先从SparkSQL入手,循序渐进。

对于 Spark 和 SparkSQL,请参考

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第6章:一次采集,多次消费(Kafka)

一次采集,多次消费数据。

在实际业务场景中,特别是对于一些监控日志,如果想实时从日志中了解一些指标(关于实时计算,后面章节会介绍),此时从HDFS的分析是太慢了,虽然用了Flume采集,但是Flume不能在HDFS上短时间滚动文件,会导致很多小文件。

为了满足一次性采集和多次消费数据的需求,这里要说的就是Kafka。

6.1 什么是卡夫卡?

卡夫卡的核心概念和名词解释。

6.2 如何部署和使用Kafka

在单机上部署Kafka,并成功运行内置的生产者和消费者示例。使用 Java 程序自己编写和运行生产者和消费者程序。Flume和Kafka的集成,使用Flume监控日志,将日志数据实时发送到Kafka。

关于Kafka,可以参考

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

此时使用Flume采集的数据并没有直接到HDFS,而是先到Kafka。Kafka中的数据可以同时被多个消费者消费,其中之一就是将数据同步到HDFS。

如果你已经认真完整地按照本文第5章和第6章的步骤进行了操作,那么你应该已经具备以下技能和知识点:

为什么 Spark 比 MapReduce 快。使用 SparkSQL 代替 Hive 可以更快地运行 SQL。使用Kafka完成一次数据采集,多次消费。您可以编写自己的程序来完成 Kafka 的生产者和消费者。

从前面的学习中,你已经掌握了大数据平台中数据采集、数据存储计算、数据交换的大部分技能,而这其中的每一步都需要一个任务(程序)来完成,有每个任务之间的某些依赖关系。比如data采集任务成功完成后,数据计算任务才能开始运行。如果任务执行失败,需要向开发运维人员发送告警,并提供完整的日志,方便查错。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第 7 章:不断增长的分析任务

不仅是分析任务,数据采集,数据交换也是一项一项任务。其中一些任务是周期性触发的,而另一些则需要由其他任务触发。当平台中有成百上千个任务需要维护和运行时,仅靠 crontab 是不够的,还需要一个调度监控系统来完成。调度监控系统是整个数据平台的中心系统,类似于AppMaster,负责分配和监控任务。

7.1 Apache Oozie

1. 什么是 Oozie?有哪些功能?

2. Oozie 可以调度哪些类型的任务(程序)?

3、Oozie支持哪些任务触发方式?

4. 安装和配置 Oozie。

7.2 其他开源任务调度系统

阿兹卡班:

轻任务调度程序:

宙斯:

等等……另外,我这边是之前单独开发的任务调度和监控系统。详见《大数据平台任务调度与监控系统》。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第 8 章:我的数据需要实时性

在第 6 章介绍 Kafka 的时候,我提到了一些需要实时指标的业务场景。实时基本上可以分为绝对实时和准实时。绝对实时延迟要求一般以毫秒为单位,准实时延迟要求一般以秒和分钟为单位。. 对于需要绝对实时性的业务场景,Storm用的比较多。对于其他准实时业务场景,可以是 Storm 或者 Spark Streaming。当然,如果可以的话,你也可以自己编写程序来做。

8.1 风暴 什么是风暴?可能的应用场景有哪些?1、Storm的核心组件有哪些,各自的作用是什么?1. Storm的简单安装部署。1.编写自己的Demo程序,使用Storm完成实时数据流计算。

8.2 Spark Streaming 什么是 Spark Streaming,它与 Spark 有什么关系?1、Spark Streaming和Storm的优缺点是什么?1、使用Kafka+Spark Streaming完成实时计算的demo程序。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

至此,您的大数据平台底层架构已经形成,包括数据采集、数据存储与计算(离线与实时)、数据同步、任务调度与监控。然后是时候考虑如何更好地向外界提供数据了。

如果你认真完成了以上的学习和实践,你的“大数据平台”应该是这样的:

第 9 章:我的数据将来自外部

通常提供外部(业务)数据访问,一般包括以下几个方面:

离线:例如每天将前一天的数据提供给指定的数据源(DB、FILE、FTP)等;

离线数据可以通过使用Sqoop、DataX等离线数据交换工具来提供。实时性:比如一个在线的网站推荐系统需要从数据平台实时获取用户的推荐数据,这个要求的延迟非常低(50毫秒以内)。

根据时延要求和实时数据查询要求,可能的解决方案包括:HBase、Redis、MongoDB、ElasticSearch等。 OLAP分析:OLAP不仅要求底层数据模型相对标准化,而且对查询响应的要求也越来越高速度。可能的解决方案包括 Impala、Presto、SparkSQL 和 Kylin。如果你的数据模型比较大,那么 Kylin 是最好的选择。1、即席查询:即席查询的数据比较随机,一般很难建立通用的数据模型。因此,可能的解决方案是:Impala、Presto 和 SparkSQL。

有这么多成熟的框架和解决方案,您需要根据自己的业务需求和数据平台的技术架构来选择合适的。只有一个原则:越简单越稳定越好。

如果你已经很好地掌握了如何向外界(业务)提供数据,那么你的“大数据平台”应该是这样的:

第 10 章:最大的机器学习

对此,我只能简单介绍一下。我很后悔当时没有好好学习数学。

在我们的业务中,机器学习可以解决的问题大致分为三类:

分类问题:包括二分类和多分类,二分类就是解决预测的问题,比如预测一封邮件是否是垃圾邮件;多分类解决文本的分类问题;1、聚类问题:从用户搜索到的关键词,粗略的对用户进行分类。1.推荐问题:根据用户的历史浏览和点击行为做出相关推荐。

大多数行业使用机器学习来解决这些类型的问题。

入门学习路线:

数学基础;机器学习在行动,Python 是最好的;SparkMlLib 提供了一些封装好的算法,以及特征处理和特征选择的方法。

机器学习真的很棒,也是我的学习目标。

然后,您也可以将机器学习部分添加到您的“大数据平台”中。

多分类和二分类解决了预测的问题,就像预测一封邮件是否是垃圾邮件一样;多分类解决文本的分类问题;1.聚类问题:从用户搜索到的关键词,对用户进行粗略的分类。1.推荐问题:根据用户的历史浏览和点击行为做出相关推荐。

大多数行业使用机器学习来解决这些类型的问题。

入门学习路线:

数学基础;机器学习在行动,Python 是最好的;SparkMlLib 提供了一些封装好的算法,以及特征处理和特征选择的方法。

机器学习确实厉害,也是未来学习的目标。

然后,您也可以将机器学习部分添加到您的“大数据平台”中。