过往经验:这样采集搜狗新闻,会改变你的认知

优采云 发布时间: 2022-10-11 23:14过往经验:这样采集搜狗新闻,会改变你的认知

为什么采集搜狗新闻:

基于搜狗强大的搜索能力,搜狗新闻及时抓取互联网上新闻网站的内容,对每条新闻进行计算,向用户推荐最新最热的新闻,让用户在搜狗新闻享受一站式购物。综合信息服务。

搜狗新闻没有人为的编辑和处理,只是根据算法对新闻信息进行整理整理。因此,搜狗新闻在内容上保证新闻的客观性,不推荐带有主观意愿的新闻内容,以确保用户在搜狗新闻上,可以看到最真实、最完整、最丰富的新闻信息。

采集搜狗新闻的质量如何?

搜狗新闻以搜狗搜索引擎为后盾,采用先进的多线程蜘蛛技术。它就像一个搜索范围很广的雷达,同时监控数千家网络媒体的新闻。(包括所有重要新闻网站和区域信息等重要新闻信息源),一旦有新消息发布,第一时间被引擎发现并处理收录,确保新闻信息是迅速提供给网友。该引擎还可以保留近一个月的所有新闻,这保证了信息储备的丰富性。同时,引擎对所有信息的相关性进行排序,使最有可能满足用户需求的查询结果排在第一位,提高了用户的搜索命中率。

采集搜狗新闻的好处:

1、搜狗新闻质量高,经过搜狗搜索引擎过滤后更符合搜索引擎算法

2. 以搜狗搜索引擎为后盾,搜狗新闻信息丰富完整

3.节省大量人工成本

4、信息全面、关联性强、数据量大

5.采集之后可以创建更多文章

采集搜狗新闻难吗?

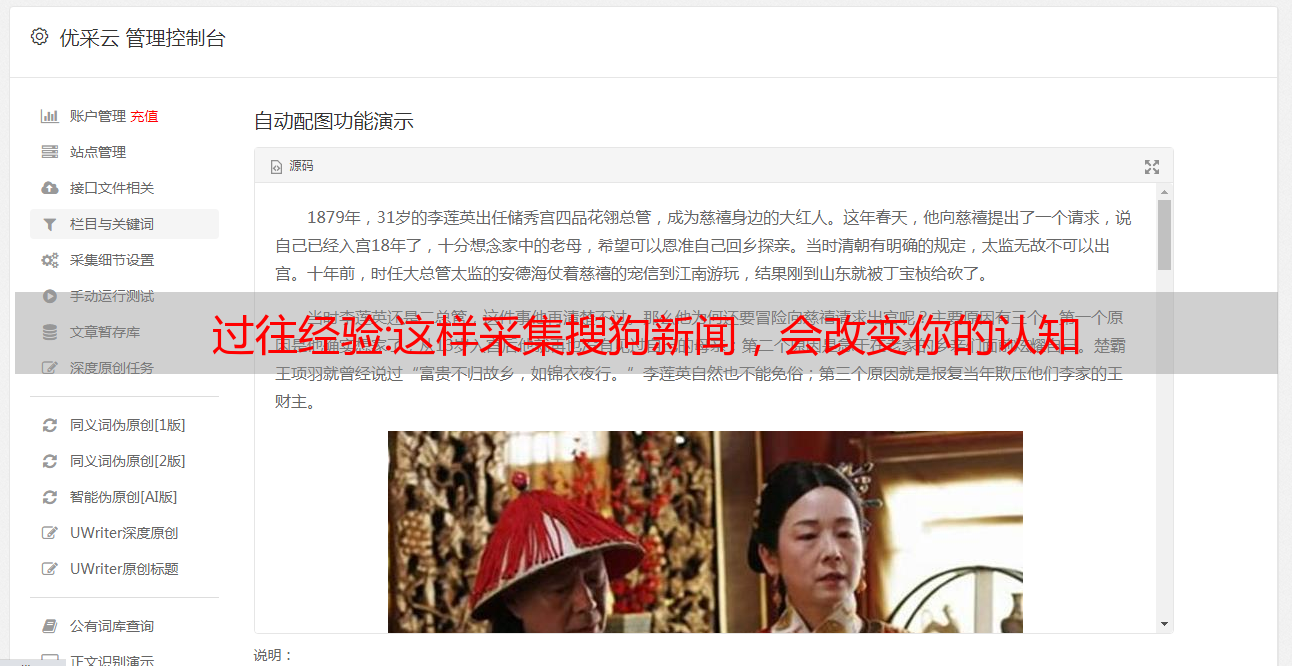

1. 输入 关键词

2.选择搜狗新闻

3. 采集完成

为了使采集的文章优于其他文章,首先要选择好的采集源。排版、错别字等都很好。它节省了我们在排版、布局和纠正错别字上花费的更多时间,从而节省了大量时间。同时,网站的搜索引擎评分自然是很高的,虽然很少有人会注意到这些点,但是效果还是很不错的,大家不妨试试。

事实:你真的了解爬虫吗?看完你会对网络爬虫有更深更全面的认识

前言

爬虫是一项非常有趣的技术。你可以使用爬虫技术来获取一些别人无法获得或需要支付的东西。您还可以自动抓取并保存大量数据,减少手动做一些累人工作的时间和精力。

可以说学编程的人很多,不玩爬虫真的没那么有趣了。无论是业余、私工还是专业爬虫,爬虫的世界确实很精彩。

今天,我将为您谈谈爬行动物。目的是让准备学习爬虫或者刚入门的朋友对爬虫有更深入、更全面的了解。

1.认识爬行动物

1.什么是爬行动物?

一句话介绍大名鼎鼎的爬虫:一个请求网站并提取数据的自动化程序。

我们把它拆开来理解爬虫:

请求网站表示向网站发送请求,比如在百度上搜索关键字“Python”,此时我们的浏览器就会向网站发送请求;

提取数据。数据包括图片、文字、视频等,称为数据。我们发送请求后,网站 会将搜索结果呈现给我们,这实际上是在返回数据。提取;

自动化的程序,也就是我们写的代码,实现了数据的自动提取,比如批量下载和保存返回的图片,而不是一个一个的手动操作。

2.爬行动物的分类

根据使用场景,爬虫可以分为三类:

①万能爬虫类(大而全)

功能强大,采集广泛使用,通常用于搜索引擎,比如百度浏览器就是一个大型爬虫程序。

②专注爬行动物(小而精)

功能比较单一,只抓取特定网站的特定内容。比如去某个网站批量获取一些数据。这也是最常用的爬虫。

③ 增量爬虫(仅采集更新内容)

这实际上是一个专注于爬虫的迭代爬虫。只采集更新数据,不采集老数据,相当于一直存在并在运行,只要有满足更新要求的数据,就会自动爬取新数据。

3.机器人协议

在爬虫中,有一个需要注意的协议叫做Robots,也被称为“网络爬虫排除标准”,它的作用是网站告诉你什么可以爬,什么不能爬。

我在哪里可以看到这个机器人协议?一般情况下,在网站首页网址后添加/robots.txt即可直接查看。例如,百度的机器人协议就在那里。可以看到里面有很多规定不能爬取的URL,比如Disallow:/shifen/ 说明 目前Disallow:/shifen和Disallow:/shifen下的子目录网页都不能爬取。

事实上,这份Robots协议属于君子协议。对于爬虫来说,基本上是口头约定。如果违反,可能要承担法律责任,但是如果不违反,爬虫将无法抓取任何数据,所以通常双方睁一只眼闭一只眼,不要太嚣张.

二、爬虫的基本流程

1.爬虫的4个步骤

爬行动物是如何工作的?爬虫程序大致可以分为四个步骤:

①发起请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应。

②获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可能包括 HTML、Json 字符串和二进制数据(如图片和视频)。

③分析内容

获取的内容可以是HTML,可以用正则表达式和网页解析库来解析。可能是Json,可以直接转换成Json对象解析,也可能是二进制数据,可以保存或者进一步处理。

④保存数据

保存的数据有多种样式,可以保存为文本,保存到数据库,或者保存为特定格式的文件。

基本上这是爬虫必须遵循的四个步骤。

2.请求和响应

请求和响应是爬虫最重要的部分。请求和响应之间的关系是什么?两者的关系如下:

简单理解一下,当我们在电脑的浏览器上搜索东西的时候,比如前面提到的百度搜索“Python”,如果你点击百度,就已经向百度的服务器发送了一个Request,Request里面收录了很多信息,比如身份信息、请求信息等。服务器收到请求后做出判断,然后给我们的电脑返回一个Response,里面也收录了很多信息,比如请求是否成功,比如我们要求的信息。结果(文本、图像、视频等)。

这应该很容易理解吧?接下来,我们来好好看看Request和Response。

3. 理解请求

请求收录什么?它主要包括以下内容:

1.请求方法

请求方式可以理解为你向网站打招呼的方式。如果你想从网站那里得到数据,你必须用正确的方式打招呼,才有可能像你一样关心你如果你想从别人家借东西,你必须在打招呼之前先敲门。如果你直接从窗户爬进去,任何人看到它都会把你踢出去。

主要的请求方式有GET和POST,还有HEAD/PUT/DELETE/OPTIONS等其他方式,其中GET是最常用的请求方式。

2.请求网址

什么是网址?URL的全称是Uniform Resource Locator。例如,一个网页文档、图片、视频等都有一个唯一的URL,可以理解为爬虫中的URL或链接。

3.请求头

什么是请求标头?英文名称Request Headers通常是指请求中收录的头信息,如User-Agent、Host、Cookies等。

这些东西相当于你向网站发送请求时的身份信息。经常需要伪装自己,伪装成普通用户,以防止你的目标网站认出你是爬虫并避开它。一些反采摘问题,成功获取数据。

4.请求正文

官方的说辞就是请求过程中携带的附加数据,比如表单提交时的表单数据。

如何理解?比如去岳父家求婚,总不能空手而归吧?你必须带一些看起来像求婚的东西,你的岳父会把你的女儿许配给你。这是大家共同的礼仪,缺一不可。

你是怎么理解爬行动物的?例如,在某些页面上,您必须先登录,或者您必须告诉我您的要求。比如你在百度网页上搜索“Python”,那么关键词“Python”就是你要携带的请求体。请参阅当涉及到您的请求正文时,百度知道您要做什么。

当然,请求体通常用在 POST 请求方法中。在 GET 请求中,我们通常将其拼接在 URL 中。先了解一下就够了,然后具体爬虫可以加深了解。

5.实用视图请求

说完了Request的理论,我们可以去实践看看Request在哪里,收录什么。

以谷歌浏览器为例,我可以通过输入关键字“Python”来搜索一堆结果。让我们使用网页自带的控制台窗口来分析我们发送的Request请求。

按住F12或者在网页空白处右键选择“Inspect”,然后可以看到控制台中有很多选项。例如,上列中有一个菜单栏。一般来说,我们通常将 Elements 用于初级爬虫。还有Network(网络),其他的东西暂时不可用,等你学习高级爬虫的时候会用到。比如JS逆向工程的时候,可能会用到Application窗口,后面会学习。

Elements 收录了所有请求结果的每一个元素,比如每张图片的源代码,尤其是当你点击左上角的小箭头时,你移动到的每一个地方都会在 Elements 窗口下显示为源代码。

Network是爬虫常用的网络信息,包括我们的Request。让我们来看看。在网络窗口下,选中禁用缓存并单击全部。

刷新网页看看效果,可以看到我们发送了132个Request请求。无需对此感到好奇。虽然我们只向百度发送了一个“Python”请求,但其中有一些是附加在网页上的请求。

虽然里面有很多类型,什么图片格式有png、jpeg等,但是可以滑到最上面,Type(类型)一栏中有一个文档类型,意思是网页文档,点击它,您将获得我们的请求信息。

点击文档进入后,有一个新的菜单栏。在 Headers 列下,我们可以看到 Request URL,也就是我们前面提到的请求 URL。这个 URL 就是我们实际从网页请求的 URL,然后 return 有一个请求方法,可以看出是一个 GET 请求方法。

再往下滑动,也可以看到我们前面提到的Request Headers,信息很多,但是前面我们提到的User-Agent、Host、Cookies都是可用的,这些都是我们给服务端的信息。

虽然Request Headers里面的内容很多,但是我们在写爬虫程序的时候也需要在这方面做伪装工作,但是并不是我们需要写的所有信息,我们可以选择性的写一些重要的信息,比如User-Agent required 、Referer和Host可选,登录时会带上cookie,常用的伪装只有4种。

至于请求体,我暂时不查,因为这里的请求方法是GET请求,而请求体只能在POST请求中查看。

四、理解Response

响应主要包括3条内容,我们来一一看一下。

1.响应状态

我们发送请求后,网站会给我们返回一个Response,里面收录了响应状态码的响应状态,大致可以分为以下几类:

① 200 范围,例如响应状态码 200 表示成功。

②三百范围,如301表示跳跃。

③ 四百范围,如404页面未找到。

④五百范围,如502,网页找不到。

对于爬虫来说,两三百是我们最想看到的响应状态,有可能拿到数据。四五百基本都凉了,拿不到数据。

比如我们刚刚发送了之前的Request请求,在文档文件中,在Headers窗口下的General中,我们可以看到响应状态码是200,说明网页成功响应了我们的请求。

2.响应头

服务器发送给我们的信息中也会有响应头,包括内容类型、内容长度、服务器信息、设置cookies等。

其实响应头对我们来说并没有那么重要,这里我们可以理解。

3.响应体

这一点很重要,除了上面第一点的响应状态,因为它收录了请求资源的内容,比如网页HTML和图片二进制数等。

响应主体在哪里?它也在文档文件的响应列中。可以往下滑看,里面有很多响应数据。这是我们得到的数据。有的可以直接下载,有的需要技术分析。得到。

5、爬虫可以获取哪些数据?

爬虫能得到什么样的数据?基本上可以分为以下几类:

①网页文档,如HTML文档、Json格式文本等。

②得到的图片是二进制文件,可以保存为图片格式。

③视频也是二进制文件,可以保存为视频格式。

④其他,反正其他能看到的东西,理论上爬虫都能拿到,看难度。

6.如何解析数据?

从前面我们可以发送一个请求成功,网页会返回给我们大量的数据,有上千甚至上万个代码,那么如何在这么多代码中找到我们想要的数据呢?常用的方法如下:

①直接加工。当网页返回的数据是一些文本,也就是我们想要的内容时,不需要过滤处理,直接处理即可。

②Json解析。如果网页返回的不是HTML数据而是Json数据,则需要Json解析技术。

③ 正则表达式。如果返回的数据是符合正则表达式的数据,可以用正则表达式解析。

④其他分析方法。常用的有XPath、BeautifulSoup和PyQuery,这些都是爬虫常用的解析库。

7. 如何保存数据?

获取数据后,常用的数据保存方法如下:

①文字。可以直接保存为纯文本、EXCEL、Json、Xml等类型的文本。

②关系数据库。数据可以存储在 MySQL 和 Oracle 等关系型数据库中。

③非关系型数据库。如 MongoDB、Readis 和 Key-Value 存储。

④ 二进制文件。例如,图片、视频、音频等可以直接以特定格式保存。

关于Python技术储备

学好 Python 是赚钱的好方法,不管是工作还是副业,但要学好 Python,还是要有学习计划的。最后,我们将分享一套完整的Python学习资料,以帮助那些想学习Python的朋友!

1. Python全方位学习路线

Python的各个方向都是将Python中常用的技术点进行整理,形成各个领域知识点的汇总。它的用处是你可以根据以上知识点找到对应的学习资源,保证你能学得更全面。

2.学习软件

工人要做好工作,首先要磨利他的工具。学习Python常用的开发软件就到这里,为大家节省不少时间。

三、入门学习视频

当我们看视频学习时,没有手我们就无法移动眼睛和大脑。更科学的学习方式是理解后再使用。这时候动手项目就很合适了。

4. 实际案例

光学理论是无用的。你必须学会跟随,你必须先进行实际练习,然后才能将所学应用于实践。这时候可以借鉴实战案例。

五、面试信息

我们必须学习 Python 才能找到一份高薪工作。以下面试题是来自阿里、腾讯、字节跳动等一线互联网公司的最新面试资料,部分阿里大佬给出了权威答案。看完这套面试材料相信大家都能找到一份满意的工作。

本完整版Python全套学习资料已上传至CSDN。需要的可以微信扫描下方CSDN官方认证二维码免费获取【保证100%免费】