最新版本:SEO 算法解析系列之:搜索引擎对复制网页的算法

优采云 发布时间: 2022-10-10 03:12最新版本:SEO 算法解析系列之:搜索引擎对复制网页的算法

过去推荐

我们谈到了重复内容(即重复页面)对 SEO 的影响以及可以采取的应对措施。现在我们来谈谈搜索引擎如何确定重复页面的基本算法。

下面,我将从SEO的角度简单谈谈搜索引擎是如何决定如何复制网页的。如果想更深入地理解这个基本原理,可以参考《搜索引擎——原理、技术与系统》(李晓明等)和《搜索引擎原理、实践与应用》(陆良、张博文主编) ) 是两本书。

首先,搜索引擎对所有被索引的页面进行清理和重复数据删除。

任何搜索引擎在复制网页操作之前,肯定都会有一个网页净化和内部去重的过程。搜索引擎首先要去除噪音内容,净化网页中的广告、版权信息、常见页眉和页脚部分,然后提取页面的主题和与主题相关的内容进行排名工作。噪声内容不包括在排名权重中。搜索引擎采集的网页集合中相同或极其相似的主题,例如在同一个模板中多次出现的常见代码,作为冗余内容进行剔除。

我们可以这样理解,在最理想的状态下,对于一篇文章原创文章,搜索引擎只将标题和内容计入排名,而排除其他所有内容。

DocView模型是自动分类去重模型,当然不是很准确。可以简单理解一下,DocView模型包括网页标识、网页类型、内容类别、标题、关键词、摘要、文本、相关链接等元素。它提取 DocView 模型的元素并将其应用于自动分类和对网页进行重复数据删除。

通过对以上内容的理解,我们可以大致理解为什么同一个文章放在两个模板完全不同的网站上,搜索引擎仍然可以正确识别出这是重复页面的原因。

其次,搜索引擎判断清洗过的页面的重复内容。

那么搜索引擎究竟是如何判断重复页面的呢?以下内容为北大天网搜索引擎的去重算法,大部分来自《搜索引擎——原理、技术与系统》相关知识的整理,大家可以自行参考相关文档。

现有的方法大致可以分为以下三类:

1.使用内容计算相似度

2.结合内容和链接关系计算相似度

3.结合内容、链接关系和url文本进行相似度计算

大多数现有方法仍然使用文本内容进行相似性识别。其他两种使用链接关系和URL文本的方法都不是很成熟,从效果来看引入其他特征的效果并不明显,所以选择使用内容比较实用。执行类似计算的算法。

搜索引擎对抄袭网页的判断一般是基于这样的思路:为每个网页计算一组信息指纹(信息指纹,英文Fingerprint,就是从网页中的文字信息中提取一定的信息,可以是关键词,词、句子等)或网页中的段落及其权重等,对其进行加密,如MD5加密,形成字符串。信息指纹就像人的指纹,只要内容不同,信息指纹就不同。搜索引擎在抓取检索到的网页时,需要对内容重复的网页进行识别和去重,这需要信息指纹)。如果两个网页有一定数量的相同信息指纹,两个网页的内容被认为是重叠的。很高,这意味着两个页面的内容是重复的。注意,算法提取的信息不是针对整个网页,而是过滤掉网站中的导航栏、logo、版权等常见部分的噪声信息后剩下的文本。

很多搜索引擎对内容复制的判断方法不同,主要有以下两点不同:

1.计算信息指纹的算法;

2.判断信息指纹相似度的参数。

一些算法的介绍:

1. 分割签名算法

该算法将网页按照一定的规则切割成N个片段,对每个片段进行签名,形成每个片段的信息指纹。如果这N个信息指纹中有M个相同(m是系统定义的阈值),则认为两者是重复网页。这个算法对于网页的小规模判断和复制来说是一个不错的算法,但是对于像谷歌这样的海量搜索引擎来说,算法的复杂度是相当高的。

2.基于关键词的复制网页算法

对于像谷歌这样的搜索引擎,在抓取网页的时候,他会记下关键词(中文分词技术)和每个关键词的权重(关键词密度)和Extract meta descrīption or 512每个网页的有效文本字节数。

假设我们同意 Pi 代表第 i 个网页;权重最高的N个关键词网页构成一个集合Ti={t1,t2,...tn},其对应的权重为Wi={w1,w2,。..wi},摘要信息用Des(Pi)表示,前n个关键词s形成的字符串用Con(Ti)表示,对n个关键词排序形成的字符串s用Sort(Ti)表示。

以上信息指纹均采用MD5函数加密。

基于关键词的网页复制算法有以下5种:

1、MD5(Des(Pi))=MD5(Des(Pj)),表示摘要信息完全一样,认为i和j两个网页是重复网页;

2. MD5(Con(Ti))=MD5(Con(Tj)),两个网页的top n关键词和它们的权重顺序相同,认为是重复网页;

3.MD5(Sort(Ti))=MD5(Sort(Tj)),两个网页的前n个关键词相同,权重可以不同,也认为是重复网页页。

4. MD5(Con(Ti))=MD5(Con(Tj))且Wi-Wj的平方和除以Wi和Wj的平方之和小于某个阈值a,则认为两者为重复的网页。

5. MD5(Sort(Ti))=MD5(Sort(Tj)) 如果Wi-Wj的平方和除以Wi和Wj的平方之和小于某个阈值a,则认为两者是重复的网页。

关于第4和第5的阈值a,主要是因为在之前的判断条件下,还是会有很多网页被误伤的。搜索引擎开发根据权重分配比例进行调整,防止误伤。

以上五种算法运行时,算法的效果取决于N,即关键词个数的选择。选择的越多,判断越准确,但计算速度会越慢。因此,必须考虑计算速度和去重精度之间的平衡。根据测试结果,大约 10 个 关键词 是最合适的。

当然,上述算法只是SEO的一个思路,并不是搜索引擎判断和复制网页的所有算法。只要在SEO过程中注意原创和“伪原创”,就不需要太在意这个算法了。

鉴于为新站速成培训提供的一揽子赚钱项目的可持续性,保证注册学员100%赚钱。同时,为了过滤掉一些投机取巧的学生,乐天先生决定清明节后培训费增加4998。到5998,面课价格8998涨到9998。同时,从2022年元旦开始,网课价格涨到6998,面授价格课程将增加到10998人。由于时间有限,为了更好地为学生服务,在线课程只提供一个月。招收4名学生,1月份面授班仅招收2名学生。请知道。

我们的培训独特优势:

1、路很简单,我们会用最简单、最容易接受的方式把复杂的SEO技术和算法传授给学生,让学生最大程度的学习和实践。

2、学习后,可以做体重站、排名站、流量站。结果立竿见影,技术可以毫无保留地共享。

3.培训模式:零基础系统SEO视频教程(建立系统SEO意识)+SEO实战培训视频教程(即学而做)+永久*敏*感*词*实操辅导(解决学员在学习中遇到的问题)随时随地操作SEO的过程所有问题)

4. 工具支持:每一步都需要工具,我们全程解决

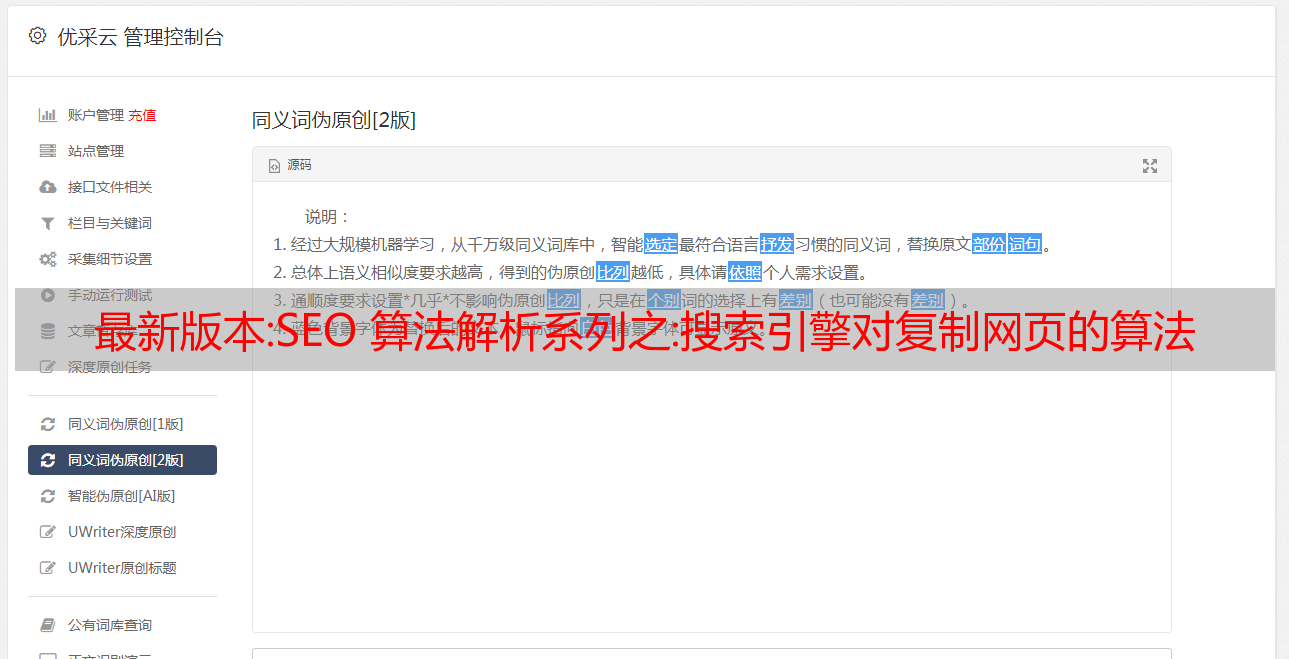

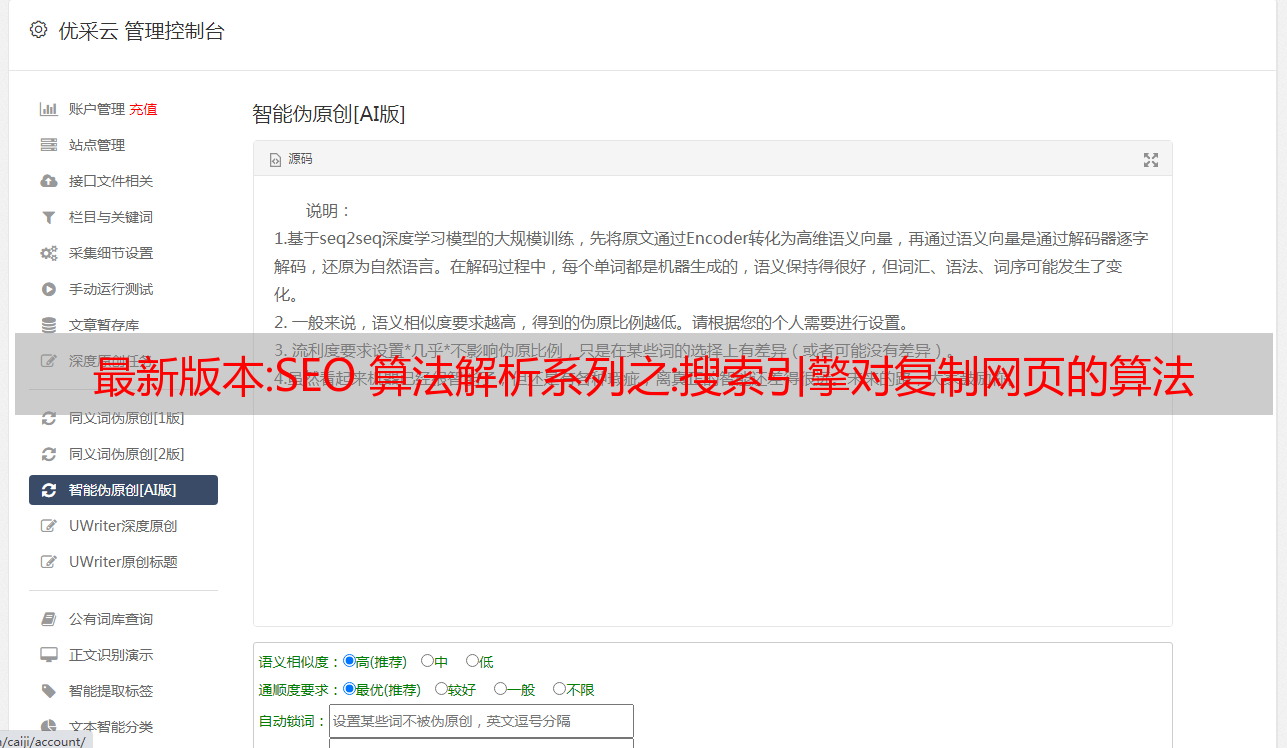

训练包中部分工具截图

报名参加我们的培训是我们的朋友,如果您有问题,我们会尽力解决。

培训大纲和学费:

新站速排培训网课及【零基础包教学包会议班】火热招人!独家灰字快排技术,新搜狗新站第二排技术首页1-7天,新百度K站恢复技术,前十名注册(每月只限前十名学生)免费最新汇总搜索两套pan-directory 站群,橙子SEO工具的免费黄金VIP,双标题自动生成工具,老域名自动扫描软件,前十名注册将获得永久免费导游VIP资格(目前VIP导游是一个-年制),另外赠送各种SEO工具,有选择性障碍,请勿打扰,注册QQ/微信:4652270

最新版本:帝国CMS7.5版采集功能升级,更灵活

论坛有人反映帝国cms的采集功能近十年没有更新,所以团队整理了论坛遇到的很多问题。功能的部分升级,使 采集 更加灵活。

Empirecms7.5版采集功能升级,更灵活:

1. 采集替换字符设置增加了对自定义字段的支持。

2. 采集广告过滤器设置增加了对自定义字段的支持。

3. 采集验证字段内容不为空采集 新增支持自定义字段设置,支持同时验证多个字段。

4. 采集内容分页支持自动识别https地址。

5. 采集新增存储时间间隔设置,可防止远程保存附件时过多的采集被屏蔽。

6、管理采集节点页面和执行采集页面增加“数据更新中心”快捷链接,方便采集刷新生成节点的内容页面储存后一天。

7、单个采集的执行也采用弹窗的方式,方便采集过程中进行其他操作,更加人性化。

8. Empire cms 7.5版本将PHP超时时间与前台和后台分开,方便单独增加后台超时时间,防止PHP在执行过程中超时或采集造成中断.

其他说明:

1.另外一个论坛报道:关于GBK版本的采集其他编码网页,在转码时,有时遇到特殊字符会出现转码不全的问题。因为没有很好的通用转换组件可以成功转码GBK 100%,所以对于经常使用采集转码的用户,建议使用UTF8编码版本的程序,其他编码一般都转成UTF8没有特殊字符。问题是,UTF8毕竟是国际通用编码。