干货教程:采集工具有哪些-免费的采集工具下载_147SEO的博客-程序员宝宝_采集工具

优采云 发布时间: 2022-10-07 23:08干货教程:采集工具有哪些-免费的采集工具下载_147SEO的博客-程序员宝宝_采集工具

采集工具是什么?常用的 采集 工具有哪些?所有的采集工具都可以分为两类:一类是关键词采集,只要输入关键词到采集到你想要的内容,第二类是指定data采集,输入target网站执行data采集。让我与您分享一些免费的 采集 工具。

1号147seo采集工具(免费):为什么是1号147seo采集工具,综合评价后,147SEO采集支持关键词采集 ,支持目标网站采集,操作简单,整个可视化操作不需要写规则,点击需要采集自动化的内容采集。强大的内容处理和信息分类+自动发布到网站深受广大新老玩家的喜爱。

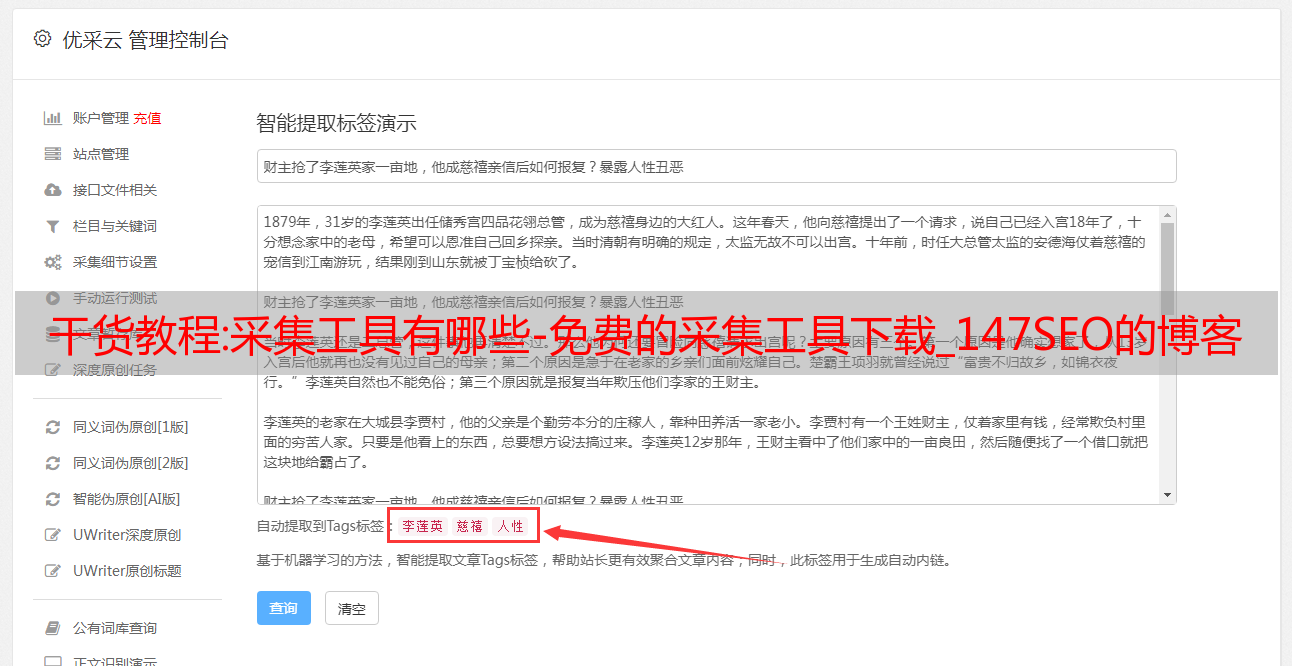

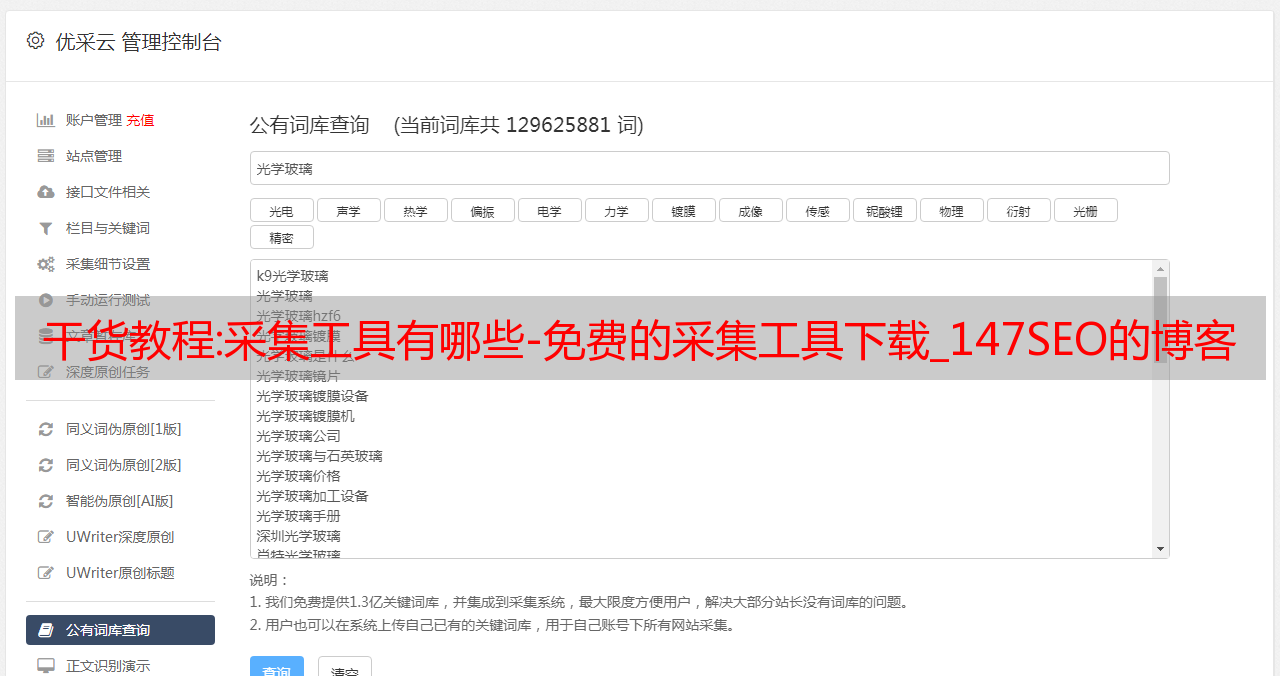

第二名优采云采集器(收费):优采云采集器作为老手采集器拥有一批忠实的老用户,需要一定的编程能力才能为了更好地使用优采云采集器,优采云采集器主要依靠规则来采集。用户需自行填写规则,需要制作发布功能(需要有编程能力)或找官方人员进行收费定制。

第三名:Universal 优采云采集器(收费):Universal 优采云采集器是一个单独的采集工具,不发布模块,只支持采集。

接下来,我将与您分享一些SEO知识。SEO 是关于提高您在搜索引擎中的 网站 排名。因此,SEO方法是通过研究分析搜索引擎的排名规则得到的,那么如何从搜索引擎中寻找SEO方法呢?

控制百度域名的命令,很多人误以为这个命令是查询自己要找的域名的外部链接。事实上,这是错误的。有两个主要问题:

1、有些不是所有的URL都只收录域名;采集工具是什么?2、找不到不收录URL描述的文字链接;

所以这个命令只能找到一部分外链,但是百度没有提供更好的外链查询工具。只讲了以后站长工具的改进,但是没办法,只能即兴使用,所以很多人发外链的分时链接是基于域名的。采集 的工具是什么?那么我们可以用域名语法进行查询,我们如何使用这种语法呢?一个很好的用处是查询其他网站s,看看哪些网站s可以发送外部链接,如果网站s会百度收录他们发送外部链接。SEO最头疼的是知道如何发送外部链接,但我不知道将它们发送到哪里。如果您控制此语法,您可以找到发送链接的中心。采集 有哪些工具?但是,并不是所有的中心都可以发外链,所有的中心都可以轻松发外链。比如有些论坛需要达到一定的点才签约;在某些平台上,您编写 文章 必须达到一定的质量才能获得批准。

3.百度收录查询,上面两条指令是查询所有收录和域名的外链。如果要查询指定时间,采集的工具有哪些?比如要查询昨天发帖的外部链接收录,昨天的文章可以是收录,需要用百度收录查询说明,选择最近的一天或一周,这将停止分析。

网站如何更新内容留住用户?在当今竞争激烈的互联网环境中,采集 工具有哪些?网站关于网站SEO 的内容非常重要。虽然流量是提升网站流失率的先决条件,但如果网站没有好的内容、优质的产品和良好的在线用户体验,很容易流失流量。因此,我们必须做好用户关怀内容,才能留住用户。详细的,我将讨论以下内容。

1. 应用即时内容

什么是即时内容?所谓即时内容,是指最近发生的社交事件。采集工具是什么?面对如此特殊的定义,SEO站长在编写相应内容时必须把握两点,一是及时,二是高效。

实时的内容在短时间内反映了事物,所以为了达到预期的效果,必须在内容分发上付出更多的努力。采集工具是什么?了解同一热点问题的第一次报告和第二次报告的区别。即时内容的时间,无论是排名效果还是流量,都远远大于转载或类似文章的时间。

2. 申请处理方案增加网站的价值

大纲内容是具有一定逻辑和营销技巧的内容。它的配方是个性化的,采集有哪些工具?不同的网站 有不同的风格。在制定大纲内容时,需要涉及受众定制、企业文化趋势、价值确立、营销理念和预期效果等要素。

虽然这方面的内容难以控制和编写,但对市场和用户具有明显的引导作用。用户可以从中汲取经验,丰富自己,提升自身在行业内的综合竞争力。

3、应用客户真实案例展现实力

站长都知道,在网站上填内容的目的是为了让用户更好的了解我们。采集 的工具是什么?相信我们的实力。但是,一些公司的SEO站长也想问问自己,仅仅几篇文章,用户会对公司有信心吗?当然不是。因此,我们需要使用一些真实的客户案例来处理这些问题。网站要想留住用户,就必须用真实的客户案例来吸引用户的访问。既然真实的客户案例是适用且可操作的,那么 采集 可以使用哪些工具?因为来自实战,代表了企业的实力,是真正的成功案例分享,能让用户信任企业。

干货教程:浩华|君无嘻言—种草高效工具 节省网页数据采集时间

图/文:淄博市规划总监尹龙

作为房地产行业规划师,我们将大部分时间和精力都花在了操盘手的规划和执行上,经常在Word、Excel和PPT之间来回穿梭。而有时在面对提案和关键节点规划时,我们需要更详细的区域市场数据,而网页上的土地信息是必不可少的部分。如果不做好月度数据积累,或者面对陌生的城市环境,很难在短时间内整理出这些陌生的数据。我一直在纠结要不要给你一个“草”的数据采集工具。第一,我们很少有机会使用这些工具(但紧急使用确实很香);无法回答具体问题。

不过,在房地产提高“人的效率”的环境下,希望大家多掌握一款软件来使用,提高工作效率,这不是一件坏事。所以,趁着《君无兮言》的机会,为大家“种草”优采云采集器软件。

1

明确的工作目标

采集(汇总)某城市的市场数据,比如我们经常需要的当地“某阶段土地供应及交易数据”,住宅在线签名数据等(值得注意的是,在线每个城市的签名数据网站差别很大,有些网站用软件很难实现采集) 案例如图,如果我们需要2小时排序拿出这个城市的土地供应交易明细,简单的打开每个地块复制粘贴是不现实的,需要数据采集工具来提高效率。

2

学习阅读网址

我们来到了案例城市的土地拍卖页面,这是一个城市级区域土地交易的详细记录。发现在这个网页环境下,点击下一页和任意翻页,网页地址不变,所以我们可以在采集器中输入这个URL来执行所有数据(或部分数据,比如仅作为 采集2021)。但是目前这个界面中的文字并不是我们想要的,我们需要的是里面每个情节的具体细节。但是我们也发现,每一个地块打开后,它的网址都不一样。

由此,我们可以分析采集工作流程:

采集市级网页下的文字内容(结果公示地块标题+时间)及各地块地址链接(深度采集)

复制所有详细包裹的地址链接,启动采集包裹详情,最后导出Excel文件

3

具体采集工作操作方法

首先:从官网下载“优采云采集器”。一个手机账号可以免费做100个采集任务。(足够的)

第二:打开软件后会有2种模式:流程图模式和智能模式。流程图模式是基于人工分工和每一步的操作(操作比较复杂,这里就不具体推荐了),而我们通常使用智能模式,使用这个模式我们来详细说明一下实战案例(单击智能模式启动采集)。

第三:首先,输入网址有3种方式,手动输入(复制粘贴)不能超过200行;文件导入(使用txt文本文件格式)我们一般采集单个或多个网页一般使用前者,批量生成很多深度链接(地块详情页地址)一般使用后者,而批量生成是指有一定规律性参数变化的网址(如翻页参数的序号变化)。因此,我们先复制粘贴需要采集的城市级交易地块的网站地址,点击立即创建。

第四:点击后可以看到采集器已经开始自动识别首页和采集(绿色部分)的信息并在下方生成表格预览,字段2(情节标题)也给我们做了对应的深度链接采集(也就是每个剧情的详情页地址采集在这里)

第五:专注翻页:翻页是指在采集的过程中,程序要自动模拟手动翻页。如果翻页按钮无法识别,我们的后续采集工作将重复进行。在某个页面或之前的某些页面上来回重复 采集 会导致数据结果无限重复。

首先,我们需要知道为什么会发生这种情况。少数情况下,如果网页按钮(下一页)的XPath无法识别,会出现“自动识别分页失败”;有时即使被识别,10页后的“下一页”也会出现。“页面”位置又变了,也会出现采集进程翻页错误。下图是第11页“下一页”按钮的偏差:

解决翻页解决方案(如果您使用的网页可以自动识别翻页,请忽略以下):

[1]点击分页按钮:手动点击分页(下一页)按钮,但如果“下一页”按钮没有放错位置,通常可以工作[2]编辑分页XPath

由于这里涉及到编程知识,我的地产编辑严重超纲了……还好在编程老师的帮助下,给出了一套案例图。我通过多个网站做了一个正则仿,大家可以试试看一下(至于工作原理,不用研究,看步骤即可):

[2-1] 回到浏览器网页界面,将鼠标放在“下一页”,右击查看元素,会看到如下图:

[2-2] 我们只需要复制""双引号内的蓝色部分,然后回到采集软件中的"Edit Paging XPath"输入//*/a[img[@ src="复制"]的蓝色部分] 例如上面的情况,需要输入 //*/a[img[@src="/TPFront/images/page/nextn.gif"]] 以上是翻页失败的处理方法。

第六:设置采集的范围:如果我们只想采集某个阶段的土地信息,可以点击采集范围进行设置。在弹出的对话框中,单击新建条件,然后单击新建组。

在本例中,“字段 3”是绘图的时间,因此我们将字段 3 中的条件设置为“收录”值。如果出现2020,点击OK(表示采集会在值达到2020时停止任务)。当然,我们可以从 Set start page and end conditions to 采集data for a specific year开始。

第七:点击开始采集——任务完成后点击导出数据。

第八:以上,我们已经完成了第一轮采集,目的是获取每个剧情详情页的URL;接下来,我们将Excel中的网站复制到一个新的文本文件(.txt)然后新建一个任务并导入网站文件,点击采集即可(因为详情页不需要转)

第九:导出Excel结果文件并稍作修改。建议大家下载“方格”办公版Excel插件,免费级别超级好用。

例如批量删除地块交易时间的“**小时**分钟”只保留年/月/日(批量删除后5个字符);分批提取最大容积率。对于最大容积率,我们可以通过公式计算出规划建筑面积、楼面价格等。

下图是导出的直接结果:

下图是修改调整后的效果:

总结

以上是与大家分享的房地产数据相关的网页数据爬取。每个城市的土地信息网都有新旧网站。建议你选择老版本的网站土地汇总页面作为目标(比较容易识别);同时,各个城市商品房上线签到的数据页面差异很大,需要看采集器能不能识别。不建议您花太多时间研究爬虫程序,我们只需要使用采集软件来节省数据聚合时间。

⋅///⋅

【过去推荐】

点击图片查看

——

本文章为浩华专业原创,未经许可严禁转载、盗用或用于商业目的