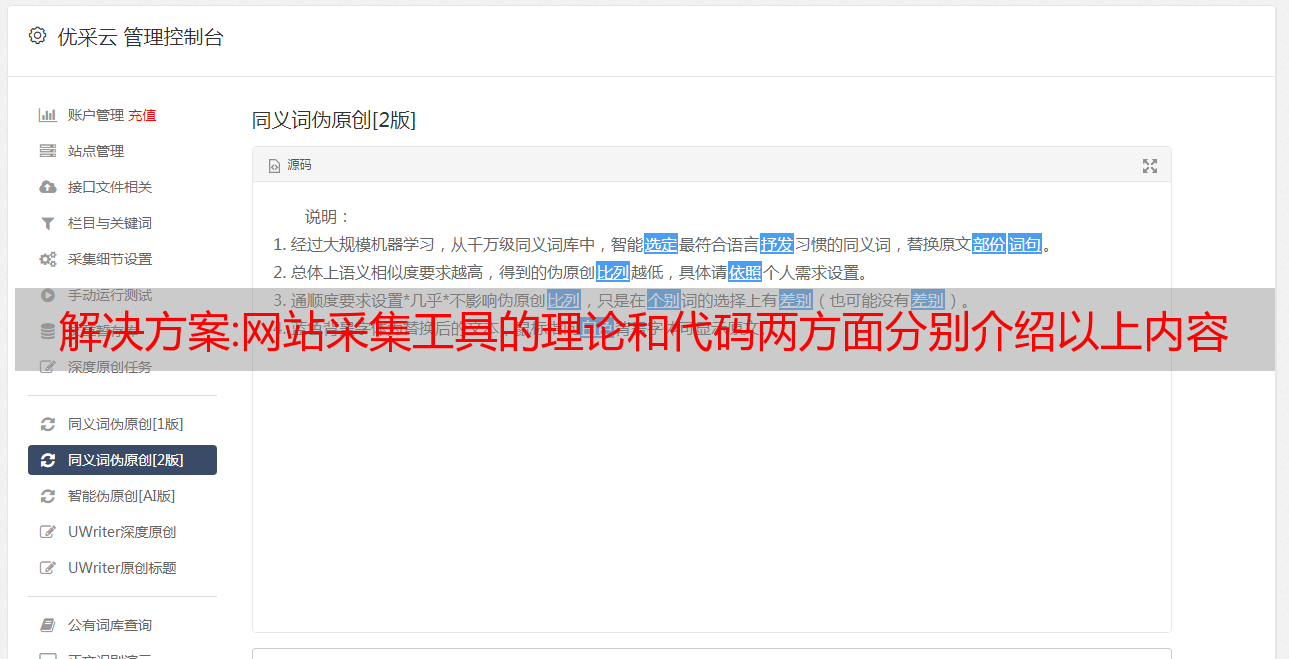

解决方案:网站采集工具的理论和代码两方面分别介绍以上内容

优采云 发布时间: 2022-10-07 02:06解决方案:网站采集工具的理论和代码两方面分别介绍以上内容

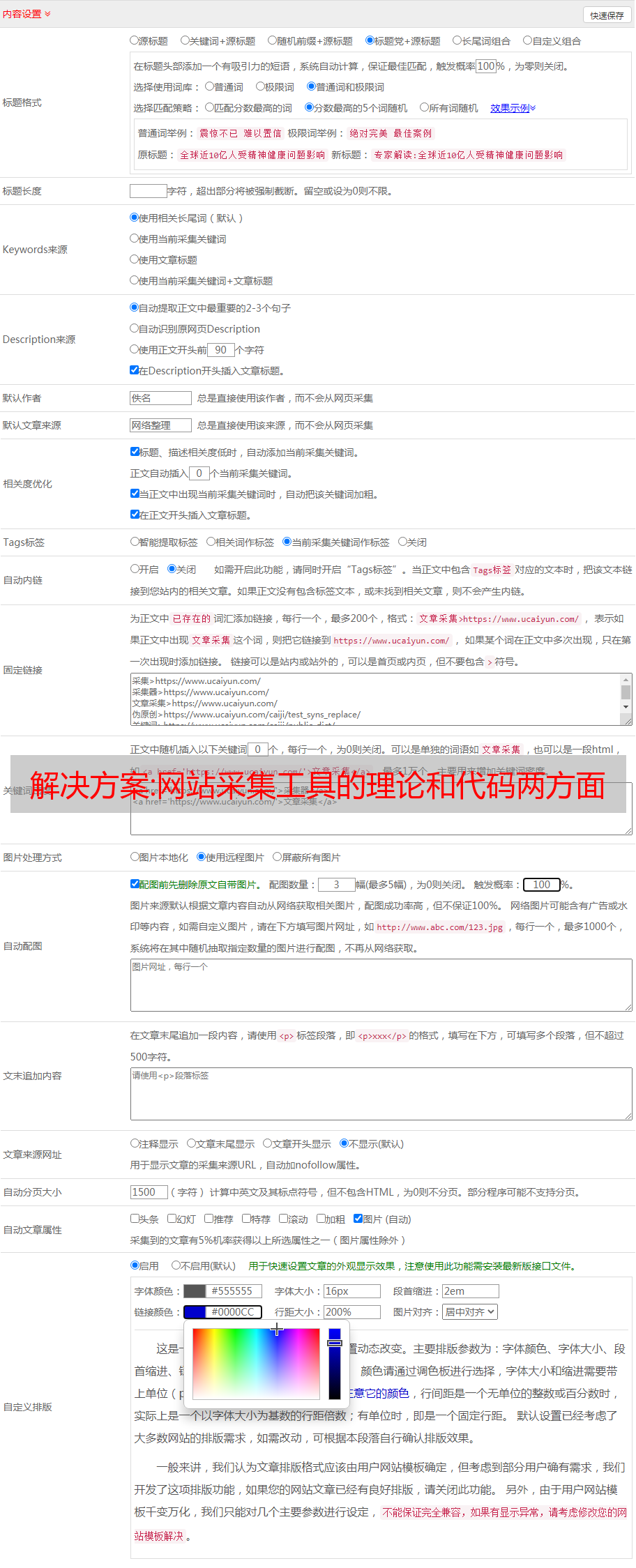

网站采集工具是保证网站抓取质量的利器,它有效避免正常的网站抓取变相形成大批量重复网站等问题。通过本文的学习,你将熟练掌握什么是爬虫、传统爬虫、模拟爬虫、useragent代理、代理池。在这之前需要明确是否只需要使用http网站的爬虫,并且网站抓取的需求如何,爬虫是否可以自动处理静态网站。本文将从理论和代码两方面分别介绍以上内容。

一、理论文章主要介绍一下什么是httpheader和爬虫收集技术问题。1.1为什么要使用httpheader首先我们来看一下http协议,http协议是一种建立在tcp协议基础上的应用层规范,连接建立时客户端和服务器端分别发送报文connection头部部分、数据头部分和主体部分(可以是post请求发送的文件名等敏感内容),服务器将客户端的报文以数据报的形式以指定的格式返回给客户端。

1.2网站抓取的http响应首先我们来看一下网站抓取的http响应1.3模拟爬虫文章主要介绍了为什么要使用模拟爬虫自动处理静态网站、不能自动处理静态网站、html解析步骤、html文档构建的一些方法。二、代码分析2.1网站抓取模拟的代码我们通过爬虫的python代码实现网站抓取功能,有时候需要获取一个web开发引擎(如javaweb)的代码,模拟抓取的代码如下。

如上图所示,爬虫在抓取时不会把所有网站的页面全部抓取下来,而是处理掉其中那些可以拿到访问的网站,并且把需要抓取的静态网站抓取下来。为什么需要通过python代码实现呢?笔者通过这样分析认为:原因在于第一,通过python爬虫或python处理静态内容将花费较多的时间和精力;第二,python爬虫有很多集中在于python脚本,这些脚本是通过调用浏览器访问或django官方的web框架实现的,普通用户的浏览器并不支持浏览python这么多的接口。

1.3.1获取静态内容网站对于静态内容的抓取,用到两个非常常用的url:/和/api。其中/api是javapython等第三方语言开发的爬虫服务,它们收集前端渲染数据包,并发送给request,request会接收到网页返回的html源码,解析后返回给/url,之后我们在模拟爬虫内部也通过selenium抓取相同的数据。

通过上述原理可以解决这个问题。1.3.2解析静态内容网站静态内容并不一定需要获取请求头部分,因为request里面也会带请求头部,所以我们可以直接把返回的html源码拿来解析,这样我们就不需要为这些请求头设置dataheader,所以可以直接对/api来进行解析。1.3.3获取请求头部分通过本文代码能模拟成功,那就能说明web框架对于浏览器登录成功。