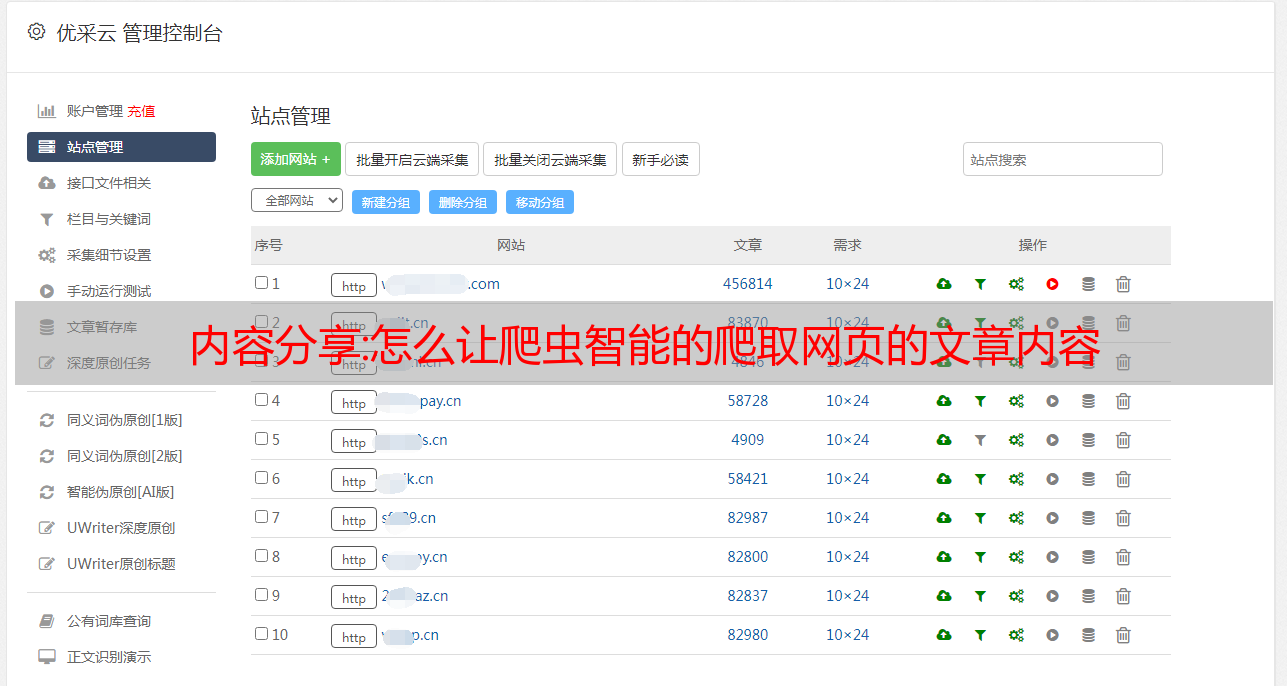

内容分享:怎么让爬虫智能的爬取网页的文章内容

优采云 发布时间: 2022-10-05 18:08内容分享:怎么让爬虫智能的爬取网页的文章内容

第一个问题和

重复现有问题:如何识别和提取网页的正文?

第二个问题我写了一个简单的单词算法,将经常出现的单词作为关键字。即使是非常简单的算法也适用于大多数网页。

但是算法这个词有很多现成的,你可以搜索;

关键词提取有很多现成的,你可以搜索...

第二个问题似乎也重复了现有的问题。

我之前用PHP写了一个采集插件。这称为网页正文提取。

算法大致如下:

1. 将网页分解为多个 DOM 块。

2. 分解 dom 块。你必须使用一定的标准来丢弃和排除。例如,一些dom快速里面,很多链接这个一般都是一个列表。可以丢弃。还要计算文本密度(文本/html)的比率。例如,标签的百分比,例如 (跨度、p、a、字体)。等等,经过多个过滤器后,最终会剩下几个dom块。然后根据某些规则过滤掉它。准确率会更高。

最重要的值也可以作为参考,我在一篇论文中看到,用一段句号来判断。

如果一大段文字中有很多句点,那么这个dom很可能是快速的内容。

我之前写过一个Java版的爬虫(Gworm),提出有点笨拙,如果你给你一个URL,智能提取页面的文章部分还是很困难的(不是没有方法,要用统计概率的方法,不可能100%正确)。所以我之前的解决方案是用css选择器来提取内容,而不是手写正则表达式,一个网站css样式名称一般都很稳定,这样一文章的所有网站只需要一个提取规则,而你的第二个问题,拿到文章标签,使用css选择器也可以轻松解决。在主题之间使用python爬行,我不知道python中的哪个库可以提供DOM上的css选择功能,但我相信一定有,对应于我使用Java版本的css选择器是Jsoup。

更新:只需谷歌“蟒蛇css选择器”一堆结果。看看这个文章。

蟒蛇里有蟒蛇

有*敏*感*词*比索

两者都非常方便使用jquery语法进行处理

Python中有一个抓取的框架,这很棒,还有一个crawnhub云平台,可以节省您的大量工作;

至于抓取标签,分类和聚类算法中涉及许多选项

如果数据量不大,请使用可读性的API来节省麻烦。

建议不要使用王冠词来做html解析,了解lxml,然后在

开发chrome浏览器,这种模式可以直接在lxml中复制对应于DOM节点的xpath,节省很多东西,并且lxml解析html,利用xml的性能

PHP 职业介绍 在线直播 课程:立即学习

全直播+实践讲座+学习+实践+辅导

超值资料:织梦自动添加关键词链接

织梦目前很受欢迎cms。今天分享一个自动添加织梦关键词链接的方法。此方法可用于将内部链接添加到您的 网站。合理的内链可以让你的网站更容易被蜘蛛抓取信息,更合理的分配权重,获得更好的客户体验。下面说一下具体方法:首先,进入内容管理系统的后台管理中心。1.后台>系统>系统基本参数>核心设置>关键字替换(是/否),这里选择“是”。2.后台>系统>系统基本参数>其他选项>文档内容相同关键词替换次数(0表示全部替换):1(如果相同关键词

沁园春