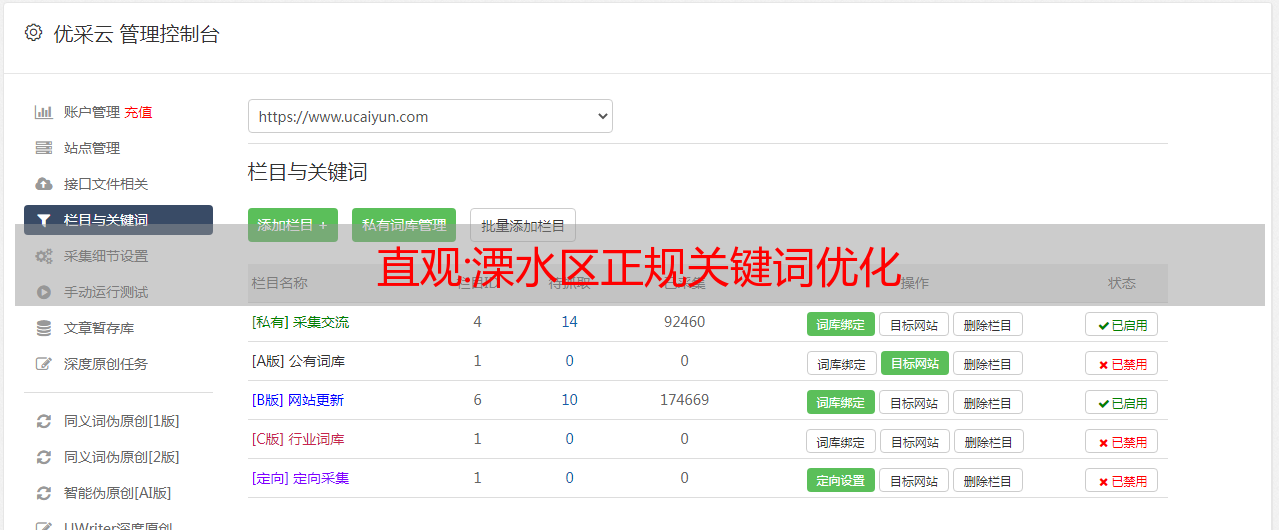

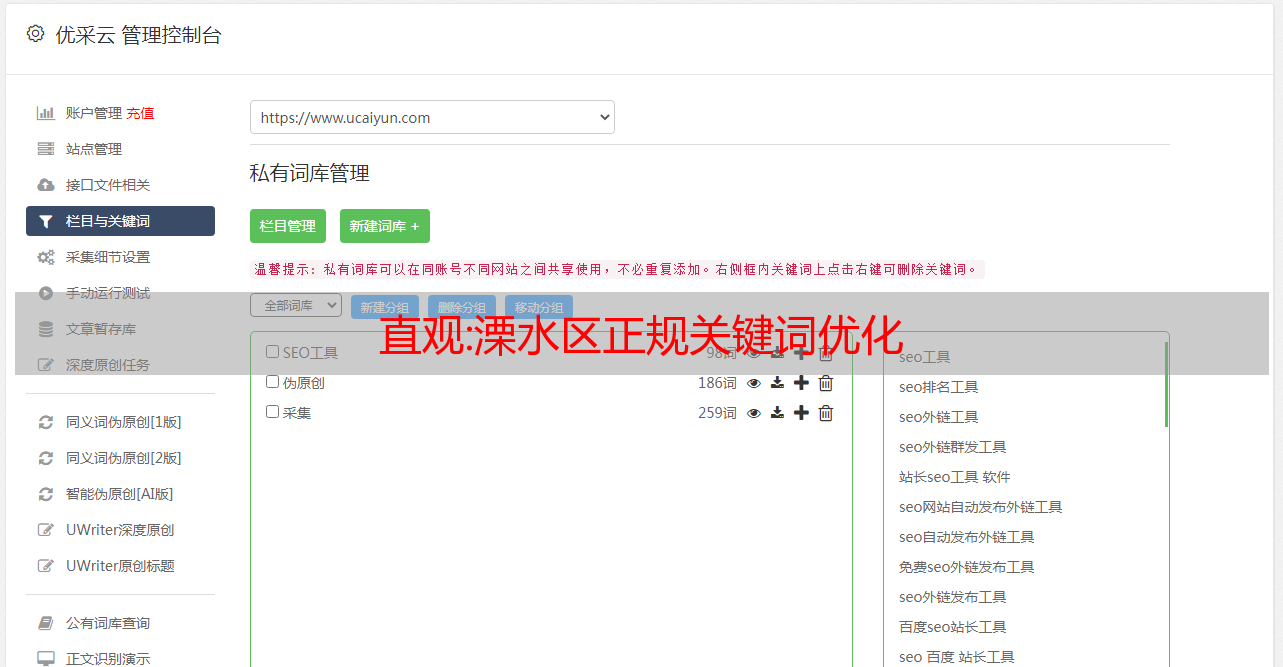

直观:溧水区正规关键词优化

优采云 发布时间: 2022-10-04 02:07直观:溧水区正规关键词优化

丽水区官方对关键词进行了优化,我们知道在搜索引擎中检索信息是通过输入关键词来实现的。因此,顾名思义,关键词 非常关键。它是整个网站登录过程中最基本也是最重要的一步,也是我们网页优化的基础,其重要性怎么强调都不为过。然而,关键词 的确定并不是一件容易的事。为了优化关键词,必须考虑许多因素。比如关键词必须和你的网站的内容有关,以及如何组合和排列单词。,是否符合搜索工具的要求,尽量避免使用流行的关键词等。所以选择正确的 关键词 需要做很多工作。

南京合福信息科技*敏*感*词*专注人工智能技术4年。T云技术是通过互联网云计算、高权重媒体资源网、高权重新闻网驱动百度、手机百度、360、搜狗等搜索引擎变现的技术。该技术可以在3-7天内在搜索结果首页实现数十万的关键词排名。在以电脑为终端的互联网和以手机为终端的移动互联网中,企业产品的推广相结合,实现更全面的网络宣传推广。和服**团队成员在人工智能技术研发、产品实施、业务推广、市场运营、企业管理等领域。公司拥有近100人的团队,主要来自香港科技大学、南洋理工大学、伦敦帝国理工学院、浙江大学、同济大学、中国人民大学等院校。

随着互联网时代的飞速发展,在线娱乐已经成为大多数人的爱好。据调查,截至2016年,中国网民规模已超过6.88亿,超过一半的中国人在使用互联网。所以互联网上有巨大的商机。如果你是一个想在互联网上发展的商人,那么你可以成为你自己的网站。别人在找你的产品的时候,输入相关的关键词就可以快速找到,也就是用户输入单词或者句子来搜索内容,搜索引擎根据内容显示搜索结果. 用户输入的内容是“关键词”。

丽水区官方关键词优化,关键词布局应该在**前面。当我们写 文章 时,我们需要同时添加 关键词 和 文章 内部链接。我认为通常通过在 文章 的第一段添加 关键词 来进行优化是非常有益的。蜘蛛搜索引擎在抓取网页的时候,会给每个文本一个比较大的权重,所以如果要优化关键词,在文章的第一段加上关键词。寻找关键词一般**scarce比较好。我们写的文章关键词都是客户直接提供的,但是关键词应该尽量稀缺,如果关键词很常见,竞争力就很高的。而且页面布局中的关键词比较少,

在采集所需的关键字之前,了解普通人如何使用它们很重要。人们在搜索时一般不会使用单个单词,而是使用短语或短语。这对网站的优化起到了更重要的作用。无论是直接从标题中提取的名词,还是从副标题、正文或摘要中提取的部分词汇,要恰当,必须标注单个概念,避免复合概念。因此,当我们选择关键词时,我们必须定义选择的单词或短语。搜索行业大佬关键词,搜索结果前5页网站基本可以说明行业概况,搜索行业大佬关键词,点击更多相关搜索在搜索结果第一页的底部。获取行业 关键词

丽水区正规关键词优化,常用线上推广:推广方式有整体推广、百度推广(CPC、CPS、CPV、CPA)等。**网站推广有论坛、SNS、交流链接、B2B平台搭建、博客和微博、微信等新媒体渠道;狭义的网络推广的载体是互联网,没有网络的推广不是网络推广;可以分为两种:提升自己的用户体验,利用互联网平台工具进行口碑推广。狭义的网络推广是指以互联网为基础,通过多种方式进行的宣传推广活动,以达到提高品牌知名度的效果。和传统广告一样,网络推广的目的是增加自身曝光度,维护品牌;从广义上讲,网络推广也可以理解为网络营销。

直观:【Python】实时采集疫情数据,打造可视化地图,防疫从你我做起

文章目录

一、写在前面

兄弟们,最近有各种流行病。平时下班后,大家要尽量避免去人多的地方,出门记得戴口罩。

所以如果你不出去,在家无事可做,你就只能学习更多新的东西。今天,我们就爬取国内的疫情数据,看看全国的疫情情况。最后,让我们将数据可视化并制作可视化地图。

二、准备工作2.1、开发环境

如果您无法安装软件、模块或其他基本问题,请参阅此处:Python Beginner 采集

文末还附上视频教程,文章看不懂,可以看视频。

2.2、知识点爬虫基本流程jsonrequests爬虫发送网络请求pandas表处理/保存数据pyecharts可视化三、爬虫部分3.1、爬虫流程明确要求

我们要刮什么?

分析数据从何而来#/

使用开发者工具进行抓包(packet)分析代码流

①。发送访问请求网站

②.获取数据

③。解析数据

xpath css re json bs4(已过时)

python语言中的json字典类型数据{key 1: value 1, key 2: value 2, key 3: value 3}

④.保存数据3.2、数据采集

导入模块

import time # 时间模块

import json # json包

import requests # 网络请求库 第三方 pip

import pandas as pd # 数据处理 第三库 pip

目标网址

url = 'https://view.inews.qq.com/g2/getOnsInfo?name=disease_h5&_=%d'%int(time.time()*1000)

模拟浏览器发送请求并得到响应

html = requests.get(url)

解析网页,提取数据

# json类型转换

data = json.loads(html.json()['data'])

china_data = data['areaTree'][0]['children']

data_set = []

for i in china_data:

data_dict = {}

# 地区名称

<p>

data_dict['province'] = i['name']

# 疫情数据

# 新增确诊

data_dict['nowConfirm'] = i['total']['nowConfirm']

data_dict['confirm'] = i['total']['confirm']

data_dict['dead'] = i['total']['dead']

data_dict['heal'] = i['total']['heal']

data_dict['deadRate'] = i['total']['deadRate']

data_dict['healRate'] = i['total']['healRate']

data_set.append(data_dict)

</p>

df = pd.DataFrame(data_set)

df

保存数据

df.to_csv(r'data.csv')

四、数据可视化部分

from pyecharts import options as opts

from pyecharts.charts import Bar,Line,Pie,Map,Grid

df2 = df.sort_values(by=['nowConfirm'],ascending=False)[:9]

df2

[list(i) for i in zip(df2['province'].values.tolist(),df2['nowConfirm'].values.tolist())]

pie = (

Pie()

.add(

"",

[list(i) for i in zip(df2['province'].values.tolist(),df2['nowConfirm'].values.tolist())],

radius = ["10%","30%"]

)

.set_global_opts(

legend_opts=opts.LegendOpts(orient="vertical", pos_top="70%", pos_left="70%"),

)

.set_series_opts(label_opts=opts.LabelOpts(formatter="{b}: {c}"))

)

pie.render_notebook()

死亡率和治愈率

line = (

<p>

Line()

.add_xaxis(list(df['province'].values))

.add_yaxis("治愈率", df['healRate'].values.tolist())

.add_yaxis("死亡率", df['deadRate'].values.tolist())

.set_global_opts(

title_opts=opts.TitleOpts(title="死亡率与治愈率"),

)

)

line.render_notebook()

</p>

各国确诊病例和死亡人数

bar = (

Bar()

.add_xaxis(list(df['province'].values)[:6])

.add_yaxis("死亡", df['dead'].values.tolist()[:6])

.add_yaxis("治愈", df['heal'].values.tolist()[:6])

.set_global_opts(

title_opts=opts.TitleOpts(title="各地区确诊人数与死亡人数情况"),

datazoom_opts=[opts.DataZoomOpts()],

)

)

bar.render_notebook()

确诊病例数

china_map = (

Map()

.add("现有确诊", [list(i) for i in zip(df['province'].values.tolist(),df['nowConfirm'].values.tolist())], "china")

.set_global_opts(

title_opts=opts.TitleOpts(title="各地区确诊人数"),

visualmap_opts=opts.VisualMapOpts(max_=200, is_piecewise=True),

)

)

china_map.render('a.html')

五、视频教程

怕是零基础就不行了,所以也有这个相关的视频教程,大家可以自己看。

【Python爬虫+数据分析】实时采集最新疫情数据,绘制可视化地图分析!

六、写在最后

兄弟,如果觉得对你有帮助,别忘了给你的脸点个赞,评论,采集,转发四连哦~