汇总:阿里巴巴买家采集,能采集到哪些数据

优采云 发布时间: 2022-10-03 23:06汇总:阿里巴巴买家采集,能采集到哪些数据

阿里巴巴买家采集,采集能得到什么数据

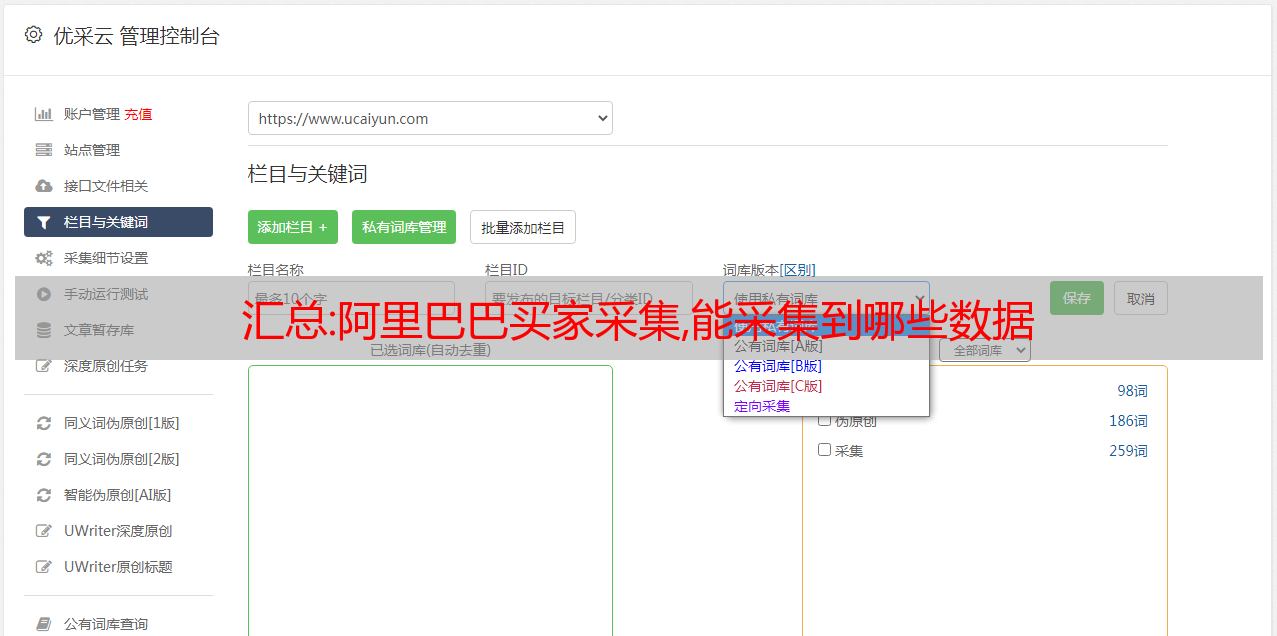

阿里巴巴的数据很多,主要是卖家、买家、产品信息、产品评论。这些网页数据都是可用的采集。具体到可以为采集的字段,包括但不限于:

1.采集卖家店铺名称、店铺类型、宝贝数量、宝贝销量、宝贝评价、省份、城市等。

2.采集买家ID、购买信息、评价内容、消费偏好等。

3、输入关键词,选择要搜索的省、市、店铺等级,然后配置规则采集。

4.您可以选择不同的字段和不同的格式来导出所需的数据。

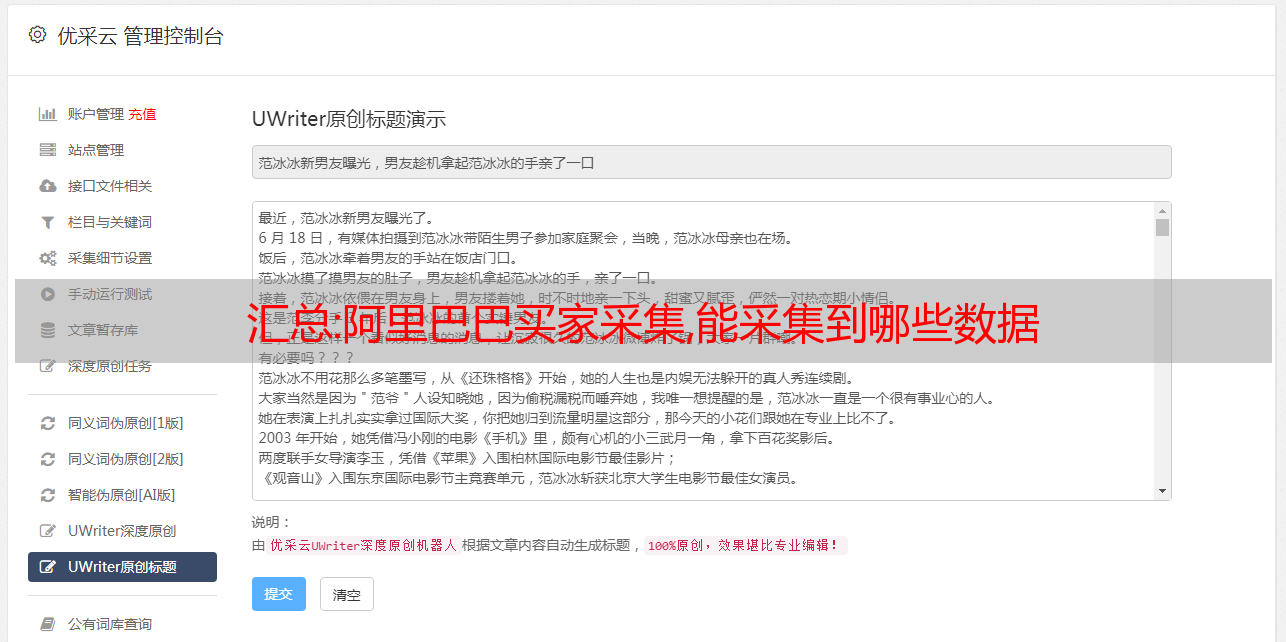

以下是使用优采云、采集1688 条在线评论的完整示例,对商店中的所有产品进行评论。通过产品评估

ID、购买信息、评价内容、消费偏好等数据。

采集,我们可以采集给买家

采集网站:

第 1 步:创建一个 采集 任务

1)进入主界面,选择“自定义模式”

阿里巴巴买家采集,采集可以得到什么数据 图1

2) 将你想要采集的URL复制粘贴到网站的输入框,点击“保存URL”

阿里巴巴买家采集,可以得到什么数据采集 图2

第 2 步:创建翻页循环

1) 在页面右上角,打开“流程”,显示“流程设计器”和“自定义当前操作”两个部分。将页面下拉至最下方,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”,创建翻页循环

阿里巴巴买家采集,采集可以得到什么数据 图3

第 3 步:创建列表循环

1) 移动鼠标,选择页面上的第一个产品链接,然后选择第二个、第三个和第四个产品链接。选中后,系统会自动识别页面中其他类似的链接。在右侧的动作提示框中,选择“循环遍历每个元素”,创建一个列表循环

阿里巴巴买家采集,采集可以得到什么数据 图4

第四步:提取产品信息

1)创建列表循环后,系统会自动点击第一个产品链接进入产品详情页面。点击所需的字段信息,在右侧的操作提示框中,选择“采集该元素的文本”

阿里巴巴买家采集,采集可以得到什么数据 图5

2) 继续点击要为采集的字段,选择“采集该元素的文本”。采集 的字段会自动添加到上面的数据编辑框中。选择对应的字段,可以自定义字段的命名

阿里巴巴买家采集,可以得到什么数据采集 图6

3) 下拉页面点击“评估”按钮,在操作提示框中选择“点击此链接”

阿里巴巴买家采集,采集可以得到什么数据 图7

由于这个网页涉及到 Ajax 技术,我们需要设置一些高级选项。选择“点击元素”这一步,打开“高级选项”,勾选“Ajax加载数据”,时间设置为“2秒”

阿里巴巴买家采集,采集可以得到什么数据 图8

注意:AJAX 是一种延迟加载和异步更新的脚本技术。通过在后台与服务器交换少量数据,可以在不重新加载整个网页的情况下更新网页的某一部分。

性能特点: a.当点击网页上的某个选项时,网站的大部分URL不会改变;湾。网页没有完全加载,而只是部分加载了数据,这些数据会发生变化。

验证方法:点击操作后,在浏览器中,URL输入栏不会出现在加载状态或圆圈状态。

第 5 步:提取产品评论

1)点击“Review”按钮后,产品评价会出现在页面上。向下滚动页面,找到并点击“下一页”按钮,选择“循环点击下一页”创建翻页循环

阿里巴巴买家采集,采集可以得到什么数据 图9

由于本网页涉及Ajax技术,我们选择“点击翻页”步骤,打开“高级选项”,勾选“Ajax加载数据”,时间设置为“2秒”

阿里巴巴买家采集,哪些数据可以采集 到图10 2) 选择页面第一个评价块,选择“选择子元素”

阿里巴巴买家采集,可以得到什么数据采集 图11

3) 系统会自动识别页面上的其他类似元素。在操作提示框中,选择“全选”创建列表循环

阿里巴巴买家采集,可以得到什么数据采集 图12

4)我们可以看到页面上产品评价区块中的所有元素都被选中并变为绿色。在右侧的操作提示框中,会出现一个字段预览表,将鼠标移动到表头,点击垃圾桶图标,可以删除不需要的字段。字段选择完成后,选择“采集以下数据”

阿里巴巴买家采集,哪些数据可以采集到图13 5)字段选择完成后,选择对应的字段,可以自定义字段名

阿里巴巴买家采集,采集可以得到什么数据 图14 第五步:调整流程图结构

回顾采集的流程,操作思路是:打开要待的网页采集>建立产品链接的翻页循环>建立产品链接的循环列表>点击产品链接进入产品详情页面> 建立产品评价页面翻页周期> 创建产品评论列表> 提取评论。

现有的流程图不遵循这个逻辑,我们需要手动调整流程图结构

1)选择整个“循环”步骤(产品链接的循环列表)并将其拖动到第一个“循环”步骤和第二个“循环”步骤之间

阿里巴巴买家采集,可以得到什么数据采集 图15

拖动完成后,位置如图

阿里巴巴买家采集,可以得到什么数据采集 图16

2)选择整个“循环页面”步骤(产品评论的循环页面)并将其拖到整个“循环”(产品链接的循环列表)步骤中

阿里巴巴买家采集,可以得到什么数据采集 图17

拖动完成后,位置如图

阿里巴巴买家采集,可以得到什么数据采集 图18

第 6 步:修改 Xpath

点击左上角的“保存并启动”,选择“启动本地采集”。采集过程中,我们发现采集的数据有很多重复。

1)选择整个“循环页面”步骤,打开“高级选项”,将单元素列表中的这个Xpath://A[text()='Next Page']复制粘贴到火狐浏览器对应的位置

阿里巴巴买家采集,采集可以得到什么数据 图19

Xpath:它是一种路径查询语言。简单地说,它使用路径表达式来查找我们需要的数据位置。Xpath 用于在 XML 中沿路径查找数据,但是 优采云采集器 有一套针对 HTML 的 Xpath 引擎,因此可以使用 XPATH 准确查找和定位网页中的数据。

2)在火狐浏览器中,我们发现当要为采集的评论已经翻到最后一页(第11页)时,使用这个Xpath://A[text()='Next page'],仍然可以找到“下一页”按钮,也就是可以一直点击这个按钮到采集,循环无法结束

阿里巴巴买家采集,哪些数据可以采集得到图20

3)返回优采云采集器,选择“自定义”

阿里巴巴买家采集,可以得到什么数据采集 图21

检查“//A[@class='next']”

详细数据:python爬虫采集企查查数据

七叉叉,一个查询企业信息的网站,这个网站也是网络爬虫选择采集的对象,这个网站反爬能力不是很强,没有一定的爬取技术,是无法采集成功的。

网络爬虫可以从企业查询采集企业信息。如果要查看完整的企业信息,需要登录后点击详情查看信息,但是只能看到部分信息,但是登录的时候会出现一个验证码,如果是爬虫行为,很容易识别。这时候就需要使用爬虫代理IP来解决问题了。登录后获取企业信息的页面源代码,解析采集的数据,获取企业名称和数据码,做好验证码处理,避免爬虫行为被限制。大部分网站都限制了IP访问量。对于爬虫频繁访问,导致被网站限制,我们也可以通过使用爬虫代理来解决这个问题。然后将采集的数据信息保存到一个文件中。

总之采集七叉叉的步骤很简单:

1、使用爬虫代理

2、采集企业信息页面

3、分析采集的数据

4、存储采集的数据信息

以下是采集Qichacha的代码,仅供参考:

#! -*- encoding:utf-8 -*-

import requests

import random

import requests.adapters

# 要访问的目标页面

targetUrlList = [

"https://httpbin.org/ip",

"https://httpbin.org/headers",

<p>

"https://httpbin.org/user-agent",

]

# 代理服务器(产品官网 www.16yun.cn)

proxyHost = "t.16yun.cn"

proxyPort = "31111"

# 代理隧道验证信息

proxyUser = "username"

proxyPass = "password"

proxyMeta = "http://%(user)s:%(pass)s@%(host)s:%(port)s" % {

"host": proxyHost,

"port": proxyPort,

"user": proxyUser,

"pass": proxyPass,

}

# 设置 http和https访问都是用HTTP代理

proxies = {

"http": proxyMeta,

"https": proxyMeta,

}

# 访问三次网站,使用相同的Session(keep-alive),均能够保持相同的外网IP

s = requests.session()

# 设置cookie

cookie_dict = {"JSESSION":"123456789"}

cookies = requests.utils.cookiejar_from_dict(cookie_dict, cookiejar=None, overwrite=True)

s.cookies = cookies

for i in range(3):

for url in targetUrlList:

r = s.get(url, proxies=proxies)

print r.text</p>