总结:文章自动采集和发布分析(一):爬虫的常用代码

优采云 发布时间: 2022-10-02 07:24总结:文章自动采集和发布分析(一):爬虫的常用代码

文章自动采集和发布分析今天公众号想要讲一下,爬虫这个主题其实还是有人觉得很笼统的,很难去说的很明白。后来写了两篇文章,写的都是比较深入一点,作为后续数据分析的基础知识。算是扫盲,比如有人说lookup函数,各种循环操作,逐层嵌套数组都不够好,需要更多算法。其实即使要数学的,也是算法数学基础,计算机本科就学的。

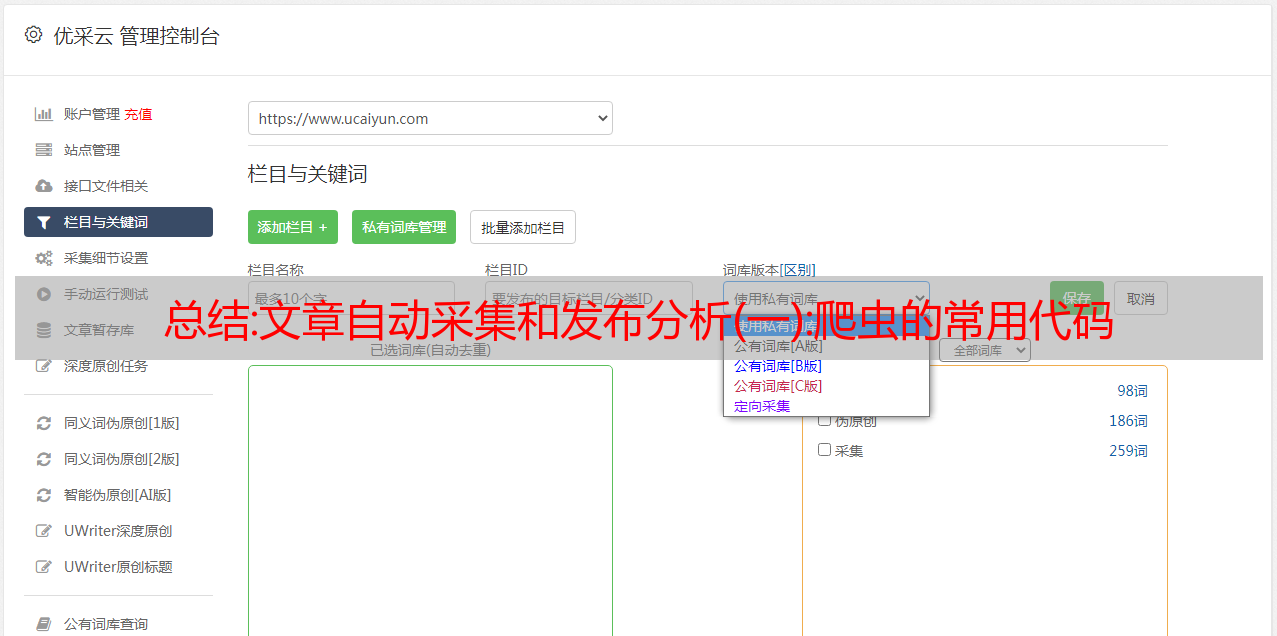

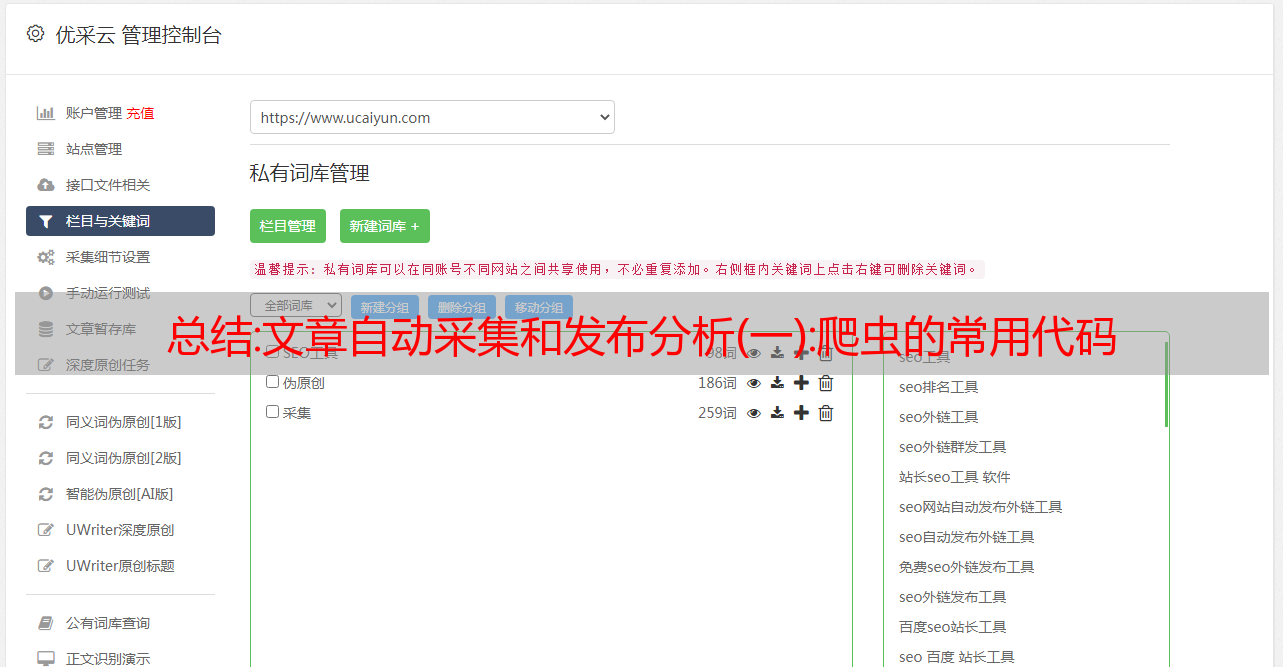

不用我赘述。这篇算是进一步解释,如何通过借助代码实现,自动的获取公众号所有文章的内容,甚至是实现一个批量发布公众号文章的功能。首先我简单介绍一下爬虫的常用的代码实现方式。最常见的,大家都是使用python3的库库。这里列举了3个常用的获取数据的代码,有基于人工智能的算法库,有基于爬虫,还有就是直接使用爬虫库,不过都是针对python语言本身。

想要这些爬虫库,就要各种python的数据库文件了。我们直接来看下面三种实现方式的python代码。importrequestsurl=""headers={"user-agent":"mozilla/5.0(windowsnt6.1;win64;x6。

4)applewebkit/537.36(khtml,likegecko)chrome/78.0.3366.106safari/537.36"}#frombs4importbeautifulsoupbeautifulsoup=beautifulsoup(url,headers=headers)#获取高清图片picture=beautifulsoup(url,headers=headers)#获取文章源代码foriinrange(hs):text=requests.get(i)text=text.encode("utf-8").encode("utf-8")data=text.encode("utf-8").encode("utf-8")result=requests.get(text,headers=headers)#下载文章下面我们来实现上面的爬虫,通过selenium库进行爬取。

fromseleniumimportwebdriverfrombs4importbeautifulsoupurl=""headers={"user-agent":"mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537.36(khtml,likegecko)chrome/78.0.3366.106safari/537.36"}#首先要解决的问题是,我们要清楚我们爬取网页的目的,

5)):headers={"user-agent":"mozilla/5.0(windowsnt6.1;win64;x6

4)applewebkit/537。36(khtml,likegecko)chrome/78。3366。106safari/537。36"}html=beautifulsoup(url,headers=headers)url=url+page_numprint(url)urls=[]forurlinurls。