干货教程:网站文章自动采集自动登录(库、pyquery库)

优采云 发布时间: 2022-09-28 14:13干货教程:网站文章自动采集自动登录(库、pyquery库)

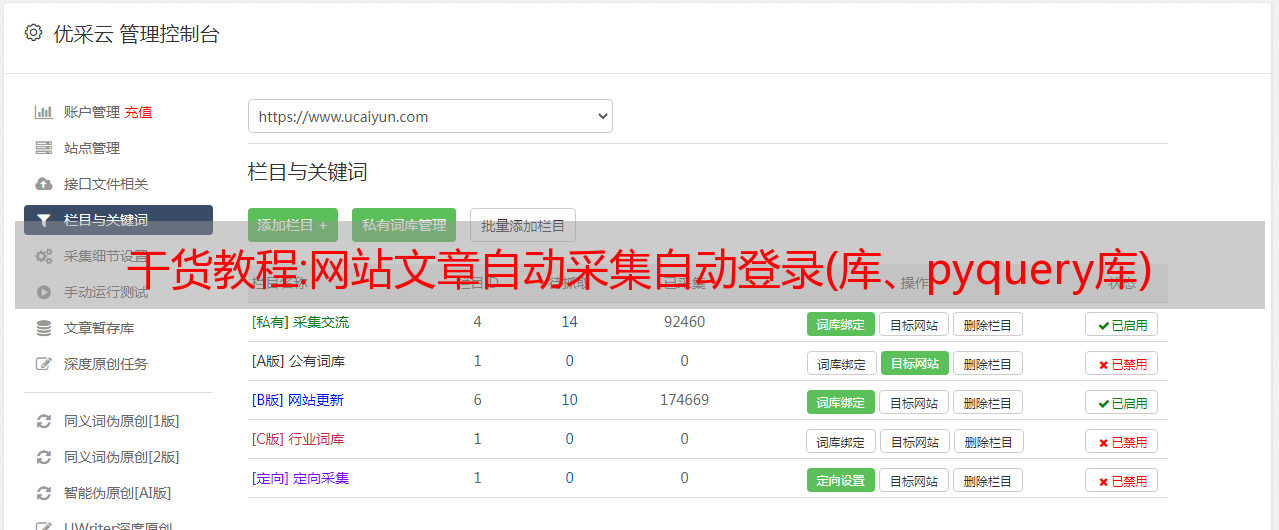

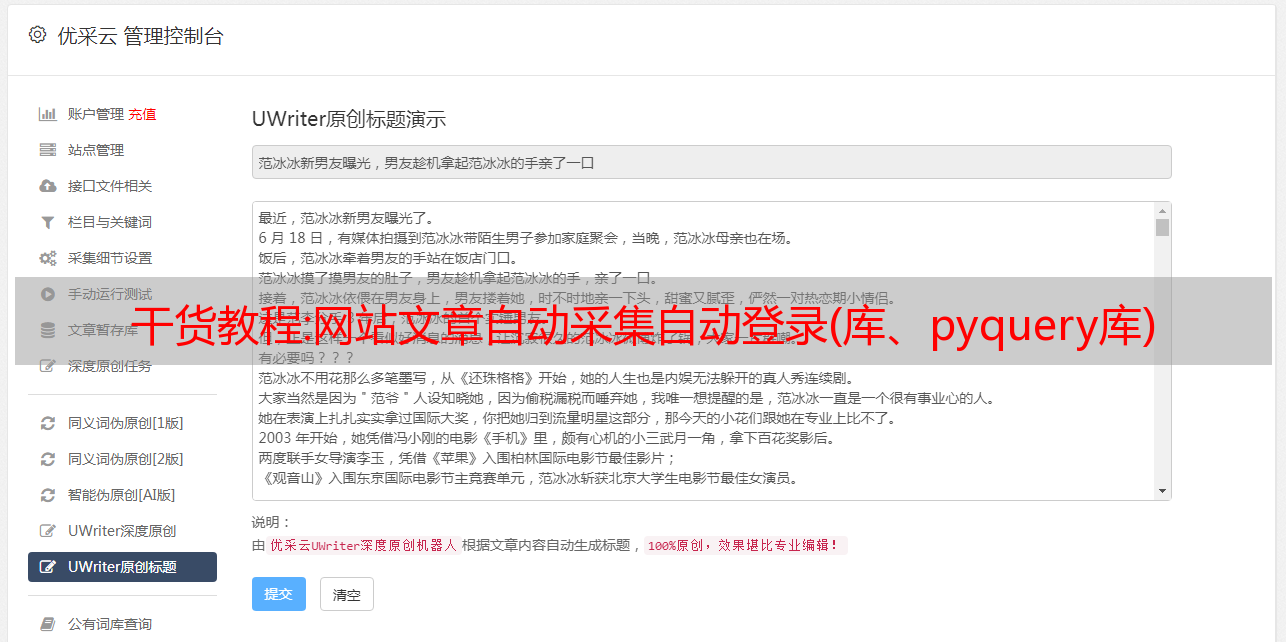

网站文章自动采集自动登录前言采用ai+机器学习去爬取站内其他的网站文章是我想做的,主要是方便我在地铁上碎片时间就能获取这些网站的资源文章,用的是爬虫+深度学习的方法。爬虫spider,机器学习ml,google开源项目代码,所以在采用自动登录的方法时,首先采用的是pythonopencv库做到文章自动登录,解决方案就是使用googlecookie,从首页获取点击链接以及具体的文章id。

获取文章登录密码源码地址,方便大家复制。下面介绍配置以及采用的ai爬虫。urllib库、pyquery库、opencv库爬虫基本使用网站首页获取文章链接及文章id(可以使用地址栏搜索):defgethtml(url):returnurllib.request.urlopen(url).read()#获取文章链接和文章idurllib.request.urlretrieve(url,content)#从文章头部获取具体文章链接、文章id,存入数据库returndefgetheader(self):urllib.request.urlopen(url).read()#获取具体文章链接及文章idurllib.request.urlretrieve(url,string)#从文章头部获取具体文章链接urllib.request.urlopen(url).read()#获取文章内容#文章介绍、作者、标题、cookie等returnurllib.request.urlopen(url).read()#文章标题urllib.request.urlopen(url).read()#文章作者、标题、收藏量urllib.request.urlopen(url).read()#文章收藏量、评论量urllib.request.urlopen(url).read()#文章首页文章链接urllib.request.urlopen(url).read()#ajax生成请求url,返回int值urllib.request.urlopen(url).read()#ajax生成请求url,返回xml值urllib.request.urlopen(url).read()#获取请求头,包括getheader方法列表urllib.request.urlopen("/").read()#获取请求方法,包括get方法init方法urllib.request.urlopen("//").read()#获取请求内容,包括内容列表defdescribe(pageid):xml=xmlreader(pageid)xml.describe(pageid,'size',string,xmlformat)returnxml.describe()defdescribeheader(self):xml=xmlreader(self)xml.describeheader('/','xxx','cssouthmd/lcjzcj/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%/%。