教程:新网站快速被百度收录的5个seo方法技巧

优采云 发布时间: 2022-09-26 10:16教程:新网站快速被百度收录的5个seo方法技巧

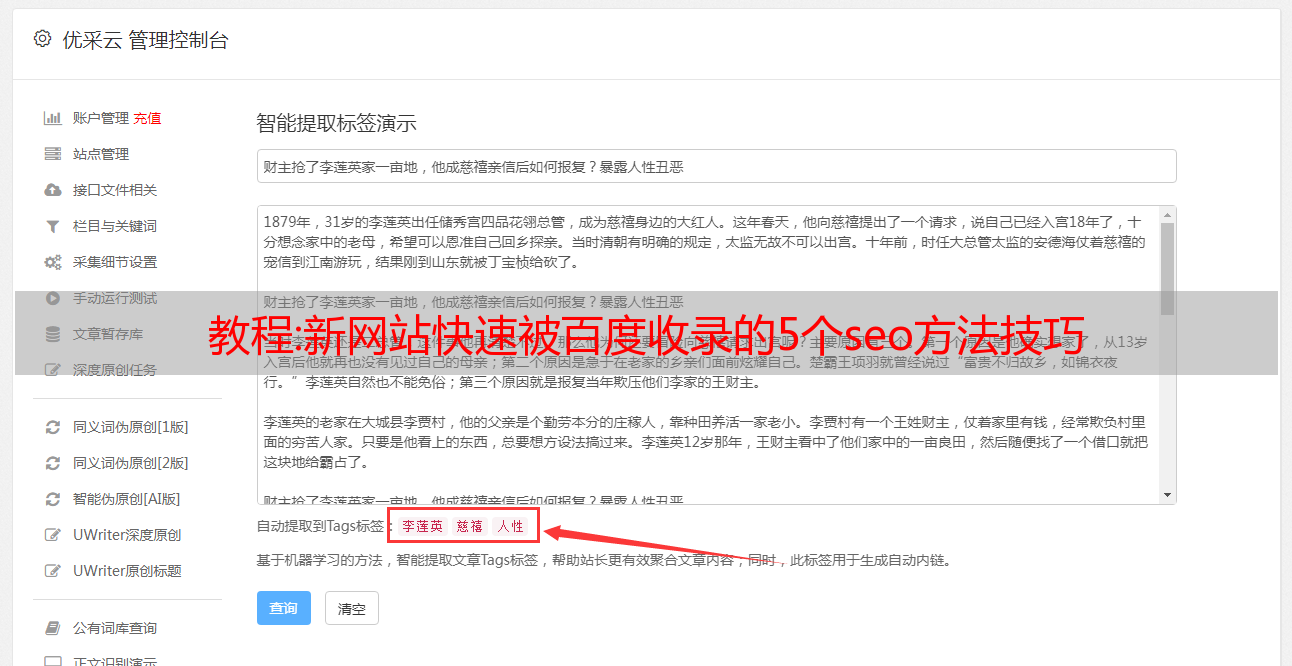

随着近年来百度的不断调整,很多站长发现新的网站收录的速度越来越慢,需要耗费的精力越来越多,而且某些SEO方法需要掌握技巧百度收录可以快速掌握。今天seo知识网给大家分享5个seo方法和技巧,让新网站快速上百度收录,希望对大家有所帮助。

1、百度站长平台提交链接

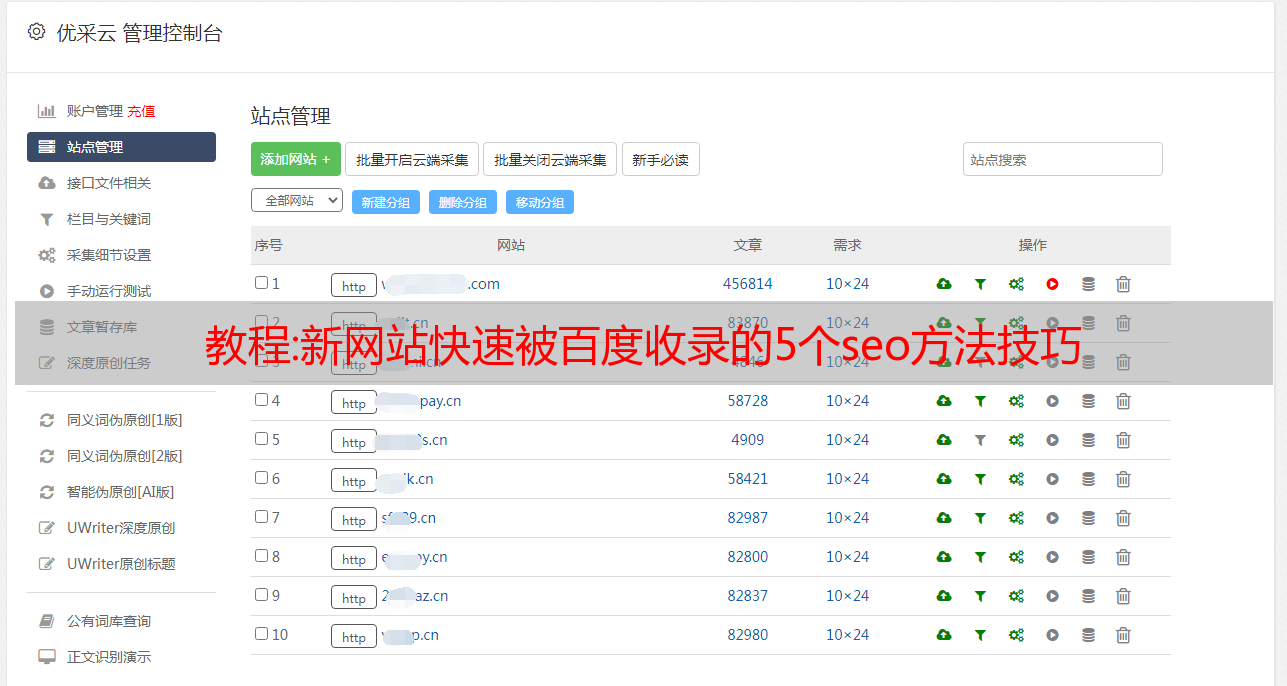

新建网站,基础优化后,每天在百度站长平台提交网站链接,提醒百度抓取网站,完善网站 收录速度。

2、自动推送

做好网站链接的自动推送功能。每天更新后会自动提交到百度站长平台,省时省力,提高网站收录的速度。

3、推送

在网站中设置推送功能,推荐给好友,让多个好友不定时访问网站。 网站的曝光度越高,越容易被搜索引擎蜘蛛抓取。

4、老网站拿去

如果有旧的网站,可以使用旧的网站的友情链接添加新的网站链接,带动新的收录速度车站。

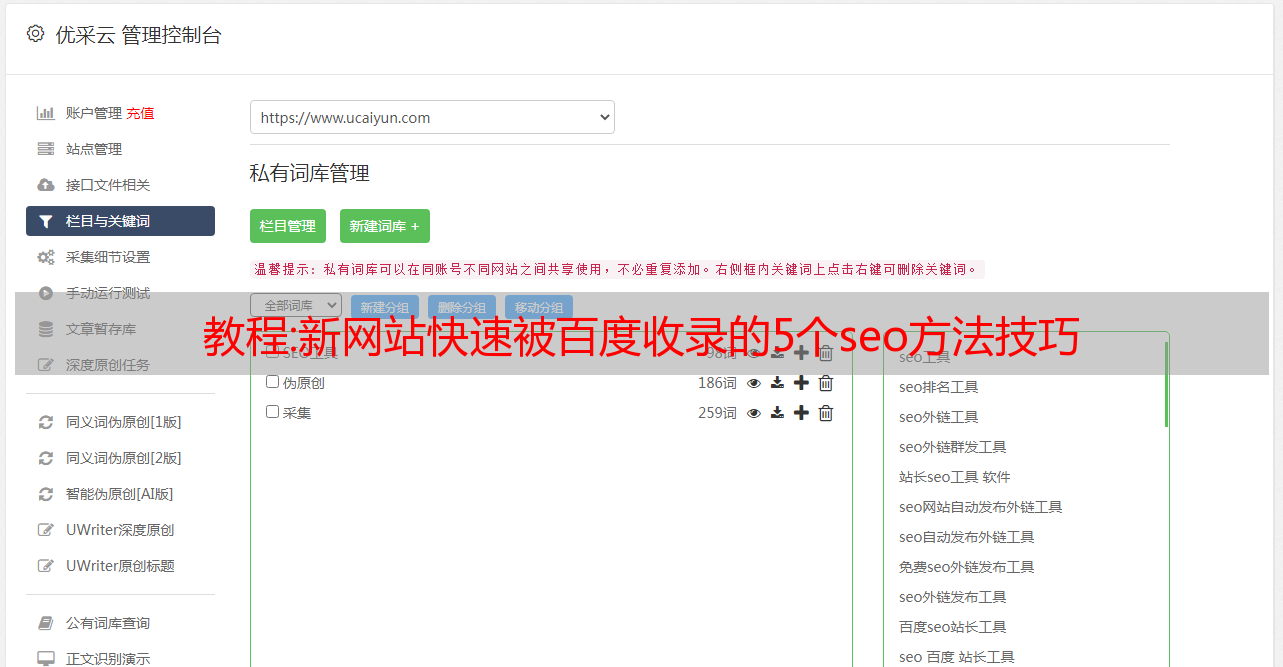

5、外部链接

投稿到优质平台,加外链,但是这些平台大多要求比较高,外链文章广告不要太硬,软文比较适合外链链接。

以上就是【新的网站五种快速百度的SEO方法和技巧收录】的介绍,希望对大家有所帮助。如果还想进一步了解seo优化,可以关注和采集我们的seo知识网,会不定期更新网站建设、seo优化、网站优化方案、seo工具、seo外包、网络推广等方面的知识,供大家参考和理解。

期待你

教程:“黑客”扩展学习“网络爬虫技术详解篇”

前几天写的关于“大数据”的文章得到了很多朋友的认可。 “大数据”这几年很火,朋友们都知道“大数据”的“数据”从何而来?

我们可以简单列举一下:

1.企业产生的用户数据

以BAT等公司为例,拥有庞大的用户群,用户的任何行为都会成为其数据源的一部分

2.数据平台购买数据

例如来自国家数据中心数据市场等

3.政府机构公共数据

例如统计局、银行的公开数据等

4.数据管理公司

比如艾瑞等

5.爬虫获取网络数据

通过网络爬虫技术抓取网络数据以供使用。

其实对于想要获取“大数据或海量数据”的中小型企业或个人来说,最划算的方法就是使用“网络爬虫技术”来获取有效数据,所以近年来,“网络爬虫技术”也很流行!

今天给大家讲解一下《网络爬虫技术原理与实现》!

一、什么是网络爬虫?

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是一种程序或脚本,它根据一定的条件自动从万维网上爬取信息规则。简单来说,就是一个请求网站并提取数据的自动化程序。

最著名的网络爬虫应用是谷歌和百度的网络爬虫。

两大搜索引擎每天都会抓取互联网的数据,然后做数据分析处理,最后通过搜索展示给我们。可以说,网络爬虫是搜索引擎的基础!

二、网络爬虫的工作流程和原理

网络爬虫是搜索引擎爬取系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地,形成网络内容的镜像备份。

(一),网络爬虫的基本结构和工作流程

一般网络爬虫的框架如图:

网络爬虫的基本工作流程如下:

1.首先选择精心挑选的*敏*感*词* URL 的子集;

2.将这些网址放入待抓取的网址队列中;

3. 从待爬取的url队列中取出待爬取的url,解析dns,得到主机的ip,下载url对应的网页,存入下载的网页中图书馆。此外,将这些 URL 放入 Crawl URL 队列。

4.分析已经爬取的URL队列中的URL,分析其中的其他URL,将这些URL放入待爬取的URL队列中,从而进入下一个循环。

(二)、从爬虫的角度划分互联网

相应地,互联网上的所有页面可以分为五个部分:

1.下载了未过期的页面

2.已下载和过期的网页:抓取的网页实际上是互联网内容的镜像和备份。互联网是动态的,互联网上的一些内容发生了变化。目前,这部分抓取的页面已经过时了。

3.待下载网页:URL队列中待抓取的页面

4.知道网页:还没有被爬取,也不在待爬取的url队列中,而是通过分析已经爬取的页面或者对应的页面得到的url可以考虑要爬取的URL。是一个已知的网页。

5.还有一些网页是爬虫无法直接爬取下载的。称为不可知网页。

(三),抓取策略

在爬虫系统中,待爬取的URL队列是一个非常重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。下面重点介绍几种常见的爬取策略:

1.深度优先遍历策略

深度优先遍历策略是指网络爬虫会从起始页开始,逐个跟踪每个链接,处理完该行后移动到下一个起始页,继续跟踪该链接。我们以下图为例:

遍历的路径:A-F-G E-H-I B C D

2.广度优先遍历策略

广度优先遍历策略的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。或者以上图为例:

遍历路径:A-B-C-D-E-F G H I

3.反向链接计数策略

反向链接数是指其他网页指向的网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统都会使用这个指标来评估网页的重要性,从而决定爬取不同网页的顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

4.部分PageRank策略

Partial PageRank算法借鉴了PageRank算法的思想:对于下载的网页,连同待爬取的URL队列中的URL,形成一组网页,每个网页的PageRank值页计算。经过计算,待爬取的 URL 将是 队列中的 URL 按照 PageRank 值的大小排序,然后按照这个顺序爬取页面。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值:把这个网页的所有传入链接传入的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排序。这是一个例子:

5.OPIC 政策政策

算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始*敏*感*词*。当某个页面P被下载时,P的*敏*感*词*分配给从P分析的所有链接,P的*敏*感*词*被清空。将要爬取的URL队列中的所有页面按照*敏*感*词*数量进行排序。

6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站分类。 网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

(四),更新政策

互联网实时变化并且非常动态。网页更新策略主要决定何时更新之前已经下载的页面。常见的更新策略有以下三种:

1.历史参考政策

顾名思义,根据页面过去的历史更新数据预测未来页面何时会发生变化。通常,预测是通过泊松过程建模来进行的。

2.用户体验策略虽然搜索引擎可以针对某个查询条件返回大量结果,但用户往往只关注结果的前几页。因此,爬虫系统可以优先更新那些实际在查询结果前几页的页面,然后再更新后面的那些页面。这个更新策略也需要用到历史信息。 UX 策略保留网页的多个历史版本,并根据每个过去内容更改对搜索质量的影响得出一个平均值,并以此值作为决定何时重新抓取的基础。 3.聚类抽样策略

上面提到的两种更新策略都有一个前提:需要网页上的历史信息。这种方式存在两个问题:第一,如果系统为每个系统保存多个版本的历史信息,无疑会增加很多系统负担;其次,如果新网页完全没有历史信息,就无法确定更新策略。

该策略考虑到网页有很多属性,属性相似的网页可以认为有相似的更新频率。计算某一类别网页的更新频率,只需对该类别的网页进行采样,并将其更新周期作为整个类别的更新周期。基本思路如图:

(五),分布式爬虫系统结构一般来说,爬虫系统需要面对整个互联网上亿万网页,单个爬虫程序不可能完成这样的任务。往往是多个爬虫程序需要一起处理,一般来说,爬虫系统往往是分布式的三层结构,如图:

底层是分布在不同地理位置的数据中心。每个数据中心有多个爬虫服务器,每个爬虫服务器可能部署多套爬虫程序。这样就构成了一个基本的分布式爬虫系统。

有几种方法可以在数据中心中使用不同的服务器:

1.主从

主从型基本结构如图:

对于主从类型,有一个专门的Master服务器来维护一个待爬取的URL队列,负责每次将URL分发给不同的Slave服务器,而Slave服务器负责实际的网页下载作品。 Master服务器除了维护要爬取的URL队列和分发URL外,还负责调解每个Slave服务器的负载。为了避免一些从服务器过于空闲或过度工作。

在这种模式下,Master往往是系统的瓶颈。

2.点对点

对等方程的基本结构如图:

在这种模式下,所有爬虫服务器之间的分工没有区别。每个爬取服务器可以从待爬取的URL队列中获取URL,然后计算该URL主域名的哈希值H,进而计算H mod m(其中m为服务器数量,上图为例如,m 对于3),计算出来的数字就是处理 URL 的主机号。

例子:假设对于URL,计算器hash值H=8,m=3,那么H mod m=2,那么2号服务器会获取链接。假设此时服务器 0 获取了 URL,它会将 URL 传递给服务器 2,服务器 2 会去获取它。

这种模式有一个问题,当一个服务器死掉或添加一个新服务器时,所有 URL 的哈希余数的结果都会改变。也就是说,这种方法不能很好地扩展。针对这种情况,提出了另一种改进方案。这种改进的方案是一致的哈希来确定服务器划分。

基本结构如图:

一致哈希对 URL 的主域名进行哈希处理,并将其映射到 0-232 范围内的数字。这个范围平均分配到m台服务器上,根据主URL域名的hash运算值的范围来决定要爬到哪台服务器上。

如果某台服务器出现问题,本应负责这台服务器的网页会被下一个服务器顺时针爬取。在这种情况下,即使一台服务器出现问题,也不会影响其他工作。

三、常见网络爬虫的种类

1.通用网络爬虫

爬取目标资源遍及整个互联网,爬取目标数据庞大。对爬取性能的要求非常高。应用于大型搜索引擎,具有很高的应用价值。

一般网络爬虫的基本组成:初始URL采集、URL队列、页面爬取模块、页面分析模块、页面数据库、链接过滤模块等

一般网络爬虫的爬取策略:主要有深度优先爬取策略和广度优先爬取策略。

2.专注爬虫

在主题相关页面上定位抓取目标

主要用于特定信息的爬取,主要为特定人群提供服务

关注网络爬虫的基本组成:初始URL、URL队列、页面爬取模块、页面分析模块、页面数据库、连接过滤模块、内容评估模块、链接评估模块等。

关注网络爬虫的爬取策略:

1)基于内容评价的爬取策略

2)基于链接评估的爬取策略

3)基于强化学习的爬取策略

4)基于上下文图的爬取策略

3.增量网络爬虫

增量更新是指在更新过程中只更新变化的地方,不变的地方不更新。只抓取内容发生变化的网页或新生成的网页,可以在一定程度上保证抓取。获取的页面,尽可能新

4.深度网络爬虫

地表网页:无需提交表单,使用静态链接即可到达的静态网页

深层网页:隐藏在表单后面,不能通过静态链接直接获取。是提交某个关键词后才能获取的网页。

深网爬虫最重要的部分是表单填写部分

深网爬虫的基本组成:URL列表、LVS列表(LVS是指标签/值集合,也就是填写表单的数据源)爬取控制器、解析器、LVS控制器、表单分析器、表单处理器、响应分析器等

深网爬虫表单填写有两种:

基于领域知识的表单填写(构建关键词的表单填写库,需要时根据语义分析选择对应的关键词填写)

基于网页结构分析的表单填写(一般只在字段有限时使用,此方法会分析网页结构并自动填写表单)

四、教你实现一个简单的网络爬虫

(一),爬虫进程

在构建程序之前,我们首先需要了解爬虫的具体流程。

一个简单的爬虫程序,流程如下:

如果用文字来表达,那就是:

1、从任务库中选择*敏*感*词*URL(可以是MySQL等关系型数据库);

2、在程序中初始化一个URL队列,并将*敏*感*词*URL加入队列中;

3、如果URL队列不为空,则将队列头部的URL出队;如果 URL 队列为空,则退出程序;

4、程序根据出队的URL反映对应的解析类,新建线程开始解析任务;

5、程序会下载该URL指向的网页,并判断该页面是详情页还是列表页(如博客中的博客详情和博文列表)。库,如果是列表页面,则提取页面链接并添加到URL队列中;

6、解析任务完成后,重复步骤3。

(二), 程序结构

我们已经知道爬虫的具体流程。现在,我们需要一个合理的程序结构来实现它。

首先介绍一下简单爬虫程序的主要结构:

然后,了解一下程序中的工具类和实体类。

最后,根据类的功能,我们把它放在上面流程图的对应位置。具体*敏*感*词*如下:

现在,我们已经完成了实际流程到程序逻辑的转换。接下来,我们将通过源码的介绍深入了解程序的细节。

(三),任务调度,初始化队列

在简单的爬虫程序中,任务调度和队列初始化都是在SpiderApplication类中完成的。

(四),插件工厂

在URL循环调度中,有一句话需要我们注意:

AbstractPlugin 插件 = PluginFactory.getInstance().getPlugin(task);

其中AbstractPlugin是继承Thread的抽象插件类。

这句话的意思是插件工厂,根据url,反射性地实例化继承AbstractPlugin的指定插件。

插件工厂也可以理解为解析类工厂。

在这个程序中,插件工厂的实现主要取决于三个方面:

1.插件

打包插件;

导入 java.lang.annotation.*;

/**

* 插件说明

*

* @作者熊猫

* @日期 2017/12/01

*/

@Target({ElementType.TYPE})

@Retention(RetentionPolicy.RUNTIME)

@记录

公共@interface插件{

字符串值() 默认"";

}

Plugin其实是一个注解接口,在Plugin的支持下,我们可以实现程序通过注解@Plugin来识别插件类。这就像在 SpringMVC 中,我们通过 @[emailprotected] 等来识别每个 bean。

2.XmuPlugin

@Plugin(value = "")

公共类 XmuPlugin 扩展 AbstractPlugin {

}

XmuPlugin是众多插件(解析类)中的一种,作用由注解@Plugin标记,其具体身份(即url对应哪个)由注解中的值标记。

3.插件工厂

封装工厂;

导入实体.任务;

导入 org.slf4j.Logger;

导入 org.slf4j.LoggerFactory;

导入插件.AbstractPlugin;

导入插件.插件;

导入 util.CommonUtil;

导入 java.io.File;

导入 java.lang.annotation.Annotation;

导入 java.lang.reflect.Constructor;

导入 java.util.ArrayList;

导入 java.util.HashMap;

导入 java.util.List;

导入 java.util.Map;

/**

* 插件工厂

*

* @作者熊猫

* @日期 2017/12/01

*/

公共类 PluginFactory {

private static final Logger logger = LoggerFactory.getLogger(PluginFactory.class);

private static final PluginFactory factory = new PluginFactory();

私有列表> classList = new ArrayList>();

私有地图插件Mapping = new HashMap();

私有 PluginFactory() {

scanPackage("插件");

if (classList.size() > 0) {

initPluginMapping();

}

}

公共静态 PluginFactory getInstance() {

返厂;

}

/**

* 扫描包、子包

*

* @param 包名

*/

private void scanPackage(String packageName) {

试试{

字符串路径 = getSrcPath() + File.separator + changePackageNameToPath(packageName);

文件目录 = 新文件(路径);

文件[] 文件 = dir.listFiles();

如果(文件 == null){

logger.warn("包名不存在!");

返回;

}

for(文件文件:文件){

if (file.isDirectory()) {

scanPackage(packageName +"."+ file.getName());

} 否则 {

Class clazz = Class.forName(packageName +"."+ file.getName().split("\.")[0]);

classList.add(clazz);

}

}

} 捕捉(异常 e){

logger.error("扫描包发生异常:", e);

}

}

/**

* 获取根路径

*

* @return

*/

私有字符串 getSrcPath() {

return System.getProperty("user.dir") +

文件.separator +"src"+

File.separator +"main"+

File.separator + "java";

}

/**

* 将包名转换为路径格式

*

* @param 包名

* @return

*/

私有字符串 changePackageNameToPath(String packageName) {

return packageName.replaceAll("\.", File.separator);

}

/**

* 初始化插件容器

*/

private void initPluginMapping() {

for (Class clazz : classList) {

注解注解 = clazz.getAnnotation(Plugin.class);

如果(注释!= null){

pluginMapping.put(((Plugin)注解).value(), clazz.getName());

}

}

}

/**

* 通过反射实例化插件对象

* @param 任务

* @return

*/

public AbstractPlugin getPlugin(Task task) {

if (task == null || task.getUrl() == null) {

logger.warn("非法任务!");

返回空值;

}

if (pluginMapping.size() == 0) {

logger.warn("当前包中没有插件!");

返回空值;

}

对象对象 = null;

String pluginName = CommonUtil.getHost(task.getUrl());

String pluginClass = pluginMapping.get(pluginName);

if (pluginClass == null) {

logger.warn("没有名为"+ pluginName +""的插件);

返回空值;

}

试试{

("找到解析插件:"+pluginClass);

Class clazz = Class.forName(pluginClass);

构造函数构造函数 = clazz.getConstructor(Task.class);

object = constructor.newInstance(task);

} 捕捉(异常 e){

logger.error("反射异常:", e);

}

返回(AbstractPlugin)对象;

}

}

PluginFactory 有两个主要功能:

扫描插件包下有@Plugin注解的插件类;

根据url反射指定插件类。

(五),解析插件

正如我们上面提到的,解析插件其实就是解析每个网站对应的类。

因为在实际爬虫的解析中,总会有很多解析任务是相似甚至相同的,比如链接提取。因此,在解析插件中,我们首先要实现一个父接口来提供这些公共方法。

在这个程序中,插件的父接口就是上面提到的AbstractPlugin类:

打包插件;

导入实体.任务;

导入过滤器.AndFilter;

导入过滤器.FileExtensionFilter;

导入过滤器.LinkExtractor;

导入过滤器.LinkFilter;

导入 mons.lang3.StringUtils;

导入 org.slf4j.Logger;

导入 org.slf4j.LoggerFactory;

导入服务.DownloadService;

导入 util.CommonUtil;

导入 java.util.ArrayList;

导入 java.util.List;

/**

* 插件抽象类

*

* @作者熊猫

* @日期 2017/12/01

*/

公共抽象类 AbstractPlugin 扩展线程 {

private static final Logger logger = LoggerFactory.getLogger(AbstractPlugin.class);

受保护的Task任务;

受保护的 DownloadService downloadService = new DownloadService();

私有列表 urlList = new ArrayList();

public AbstractPlugin(Task task) {

this.task = 任务;

}

@Override

公共无效运行(){

("{} 开始运行...", task.getUrl());

String body = downloadService.getResponseBody(task);

if (StringUtils.isNotEmpty(body)) {

if (isDetailPage(task.getUrl())) {

("开始解析详情页...");

解析内容(正文);

} 否则 {

("开始解析列表页面...");

提取页面链接(正文);

}

}

}

public void extractPageLinks(String body) {

LinkFilter hostFilter = new LinkFilter() {

String urlHost = CommonUtil.getUrlPrefix(task.getUrl());

公共布尔接受(字符串链接){

return link.contains(urlHost);

}

};

String[] fileExtensions = (".xls,.xml,.txt,.pdf,.jpg,.mp3,.mp4,.doc,.mpg,.mpeg,.jpeg,.gif,.png,. js,.zip,"+

".rar,.exe,.swf,.rm,.ra,.asf,.css,.bmp,.pdf,.z,.gz,.tar,.cpio,.class").split( ",");

LinkFilter fileExtensionFilter = new FileExtensionFilter(fileExtensions);

AndFilter filter = new AndFilter(new LinkFilter[]{hostFilter, fileExtensionFilter});

urlList = LinkExtractor.extractLinks(task.getUrl(), body, filter);

}

公共列表 getUrlList() {

返回网址列表;

}

public abstract void parseContent(String body);

public abstract boolean isDetailPage(String url);

}

父接口定义了两条规则:

解析规则,即何时解析文本,何时提取列表链接;

提取链接规则,即过滤掉不需要的链接。

但是我们注意到,用于解析网站 body 内容的父接口中的parseContent(String body) 是一个抽象方法。这正是实际的插件类应该做的。这里我们以XmuPlugin为例:

打包插件;

导入实体.任务;

导入 org.jsoup.nodes.Document;

导入 org.jsoup.nodes.Element;

导入 org.jsoup.select.Elements;

导入 org.slf4j.Logger;

导入 org.slf4j.LoggerFactory;

导入 util.CommonUtil;

导入 util.FileUtils;

导入 java.text.SimpleDateFormat;

导入 java.util.Date;

/**

* xmu 插件

*

* @作者熊猫

* @日期 2017/12/01

*/

@Plugin(value = "")

公共类 XmuPlugin 扩展 AbstractPlugin {

private static final Logger logger = LoggerFactory.getLogger(XmuPlugin.class);

public XmuPlugin(Task task) {

超级(任务);

}

@Override

public void parseContent(String body) {

文档 doc = CommonUtil.getDocument(body);

试试{

字符串标题 = doc.select("p.h1").first().text();

String publishTimeStr = doc.select("p.right-content").first().text();

publishTimeStr = CommonUtil.match(publishTimeStr,"(\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d {2})")[1];

日期publishTime = new SimpleDateFormat("yyyy-MM-dd HH:mm:ss").parse(publishTimeStr);

字符串内容="";

元素元素 = doc.select("p.MsoNormal");

for(元素元素:元素){

内容+="\n"+ element.text();

}

("title:"+title);

("发布时间:"+ 发布时间);

("内容:"+内容);

FileUtils.writeFile(title +".txt", content);

} 捕捉(异常 e){

logger.error("解析内容异常:"+ task.getUrl(), e);

}

}

@Override

public boolean isDetailPage(String url) {

return CommonUtil.isMatch(url,"&a=show&catid=\d+&id=\d+");

}

}

在 XmuPlugin 中,我们做了两件事:

定义详情页的具体规则;

解析出具体的文本内容。

(六), 采集示例

至此,我们已经成功完成了Java简单爬虫程序,我们来看看实际的采集情况。

五、分享几个有用的网络爬虫工具和教程

很多看过文章的人会说写文章太深奥了,需要编程实现数据爬取。有没有简单的方法或工具来实现这一点?解决之后再给大家分享几个好用的网络爬虫工具,使用起来非常简单,也能达到相应的效果。

1、 优采云云爬虫

官网:

简介:优采云Cloud是一个大数据应用开发平台,为开发者提供一整套数据采集、数据分析和机器学习开发工具,为企业提供专业的数据采集、数据实时监控和数据分析服务。

优点:功能强大,涉及云爬虫、API、机器学习、数据清洗、数据销售、数据定制和私有化部署等;

纯云端操作,跨系统操作无压力,隐私保护,用户IP可隐藏。

提供云爬虫市场,零基础用户可直接调用已开发的爬虫,开发者基于官方云开发环境开发上传自己的爬虫程序;

领先的反爬技术,如直接获取代理IP、登录验证码自动识别等,全程自动化,无需人工参与;

丰富的发布界面,采集结果以丰富的表格形式展示;

缺点:它的优点在一定程度上也是它的缺点,因为它是一个面向开发者的爬虫开发系统,提供了丰富的开发功能,网站看起来很技术很专业,虽然官方也提供了现成的- 制作云爬虫市场等爬虫产品,并开放给广大爬虫开发者,让爬虫市场的内容更加丰富,但是对于技术基础为零的用户来说,理解起来并不是那么容易,所以有一定的使用门槛。

是否免费:免费用户没有采集功能和出口限制,也不需要积分。

有开发能力的用户可以自行开发爬虫,实现免费效果。没有开发能力的用户需要从爬虫市场搜索免费的爬虫。

2、 优采云采集器

官网:

简介:优采云采集器是一个可视化采集器,内置采集模板,支持各种网页数据采集。

优点:支持自定义模式,可视化采集操作,使用方便;

支持简单采集模式,提供官方采集模板,支持云端采集操作;

支持代理IP切换、验证码服务等防阻塞措施;

支持多种数据格式导出。

缺点:使用功能门槛高,很*敏*感*词*限制在本地采集,云端采集收费较高;

采集速度慢,很多操作要卡住。 The cloud 采集says 10 times the speed, but it is not obvious;

Only the Windows version is supported, other operating systems are not supported.

Whether it is free: It claims to be free, but actually exporting data requires points. You can earn points by doing tasks, but under normal circumstances, you basically need to buy points.

3、 优采云采集器

官网:

Introduction: 优采云采集器 is a new generation of web page采集 software developed by the former Google search technical team based on artificial intelligence technology. The software is powerful and extremely simple to operate.

Advantages: Supports the smart 采集 mode, you can intelligently identify 采集 objects by entering the URL, no need to configure 采集 rules, and the operation is very simple;

Support flowchart mode, visualize the operation process, and can generate various complex 采集rules through simple operations;

Support anti-shielding measures, such as proxy IP switching;

Support multiple data formats for export;

Support timing采集and automatic publishing, rich publishing interface;

Windows, Mac and Linux versions are supported.

Disadvantages: The software has not been launched for a long time, and some functions are still being improved. Cloud 采集functions

are not currently supported.

Free or not: completely free, 采集data and manual export of 采集results without any limitations, no credits required

4、 Use "优采云采集器" to crawl data instances

Use 优采云采集Waterfall网站pictures (with Baidu pictures采集

for example) method.

采集网站:

%E5%A4%8F%E7%9B%AE%E5%8F%8B%E4%BA%BA%E5%B8%90

Step 1: Create 采集Tasks

1)Enter the main interface and select the custom mode

2)Copy and paste the URL of the above URL into the 网站input box and click "Save URL"

3)The system automatically opens the web page. We found that Baidu Image Network is a waterfall web page. After each pull-down load, new data will appear. When there are enough pictures, it can be pulled down and loaded countless times. Therefore, this page involves AJAX technology, and it is necessary to set an AJAX timeout to ensure that data 采集 is not missed.

Select the "Open Web Page" step, open the "Advanced Options", check the "Scroll down when the page is loaded", set the number of scrolls to "5 times" (set according to your own needs), and the time to "2 seconds", The scroll method is "scroll down one screen"; finally click "OK"

Note: In the example 网站, there is no page turning button, the number of scrolling and the scrolling method will affect the number of data 采集, which can be set as needed

Step 2: 采集Image URL

1)Select the first picture on the page, and the system will automatically identify similar pictures. In the action prompt box, select "Select All"

2)Select "采集The following picture address"

Step 3: Modify Xpath

1)Select the Cycle step to open Advanced Options. It can be seen that 优采云The system automatically adopts the "unfixed element list" loop, and the Xpath is: //DIV[@id='imgid']/DIV[1]/UL[1]/LI

2)This Xpath://DIV[@id='imgid']/DIV[1]/UL[1]/LI is copied to Firefox for observation - only for positioning 22 pictures to the web page

3)We need an Xpath that locates all the required images in the web page. Observe the source code of the webpage and modify the Xpath to: //DIV[@id='imgid']/DIV/UL[1]/LI, all the required pictures in the webpage are located

4)Copy and paste the modified Xpath://DIV[@id='imgid']/DIV/UL[1]/LI to the corresponding location in 优采云, click when finished "OK"

5)Click "Save", then click "Start采集", here select "Start Local采集"

第 4 步:数据采集和导出

1)采集After completion, a prompt will pop up, select export data

2)Select the appropriate export method and export the 采集good data

Step 5: Batch convert image URLs to images

After the above operation, we have obtained the URL of the image to be 采集.接下来,再通过优采云专用的图片批量下载工具,将采集到的图片URL中的图片,下载并保存到本地电脑中。

图片批量下载工具:

1)下载优采云图片批量下载工具,双击文件中的MyDownloader.app.exe文件,打开软件

2)打开File菜单,选择从EXCEL导入(目前只支持EXCEL格式文件)

3)进行相关设置,设置完成后,点击OK即可导入文件

选择EXCEL文件:导入你需要下载图片地址的EXCEL文件

EXCEL表名:对应数据表的名称

文件URL列名:表内对应URL的列名称

保存文件夹名:EXCEL中需要单独一个列,列出图片想要保存到文件夹的路径,可以设置不同图片存放至不同文件夹

如果要把文件保存到文件夹,则路径需要以"\"结尾,例如:"D:\同步\",如果要下载后按照指定的文件名保存,则需要收录具体的文件名,例如"D:\同步

.jpg"如果下载的文件路径和文件名完全一样,则原先存在的文件会被删除