干货教程:黑帽seo教程,如何从零开始学习黑帽SEO?

优采云 发布时间: 2022-09-26 03:07干货教程:黑帽seo教程,如何从零开始学习黑帽SEO?

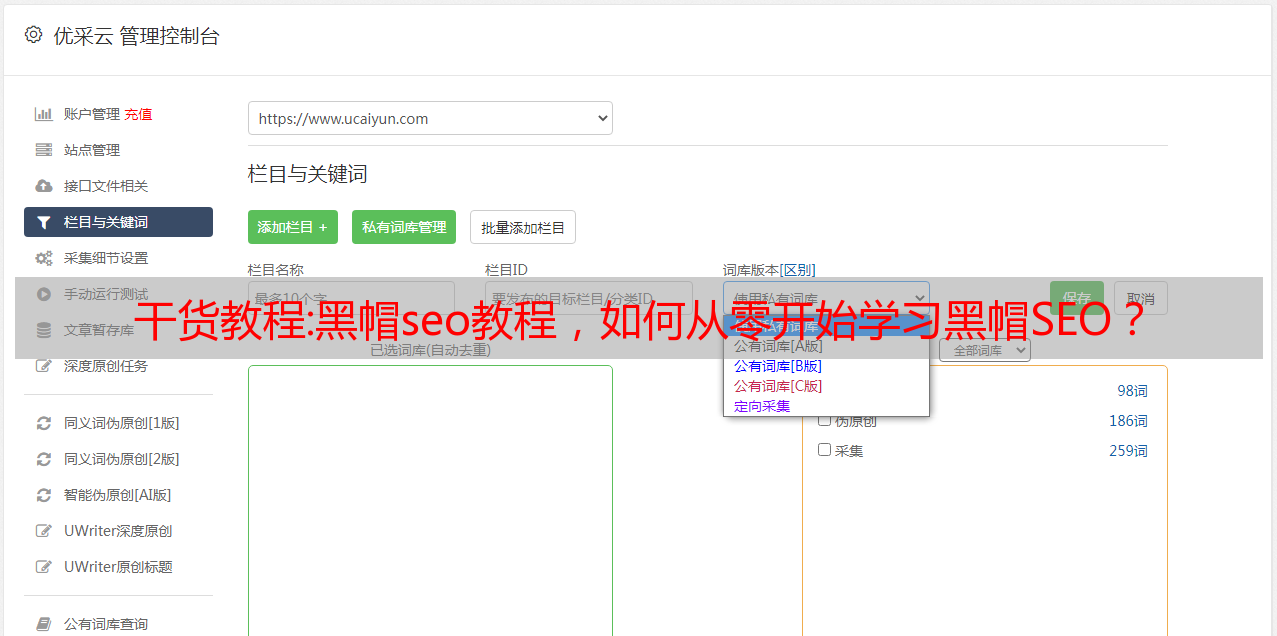

1.文章内容采集

说到内容采集相信大家都太熟悉了。基本上,所有 SEOers 都有“采集”一些内容。 采集 内容可以与 cms 程序一起使用。或者是软件的采集 功能,充斥着大量低质量的网站 内容和垃圾邮件。当然,采集网络里有很多重复的内容,我想最终的结果应该让所有SEO人都清楚。

“黑帽SEO”如何从零开始学习黑帽SEO? “第三部分”

网络文章内容采集

1、采集器

部分采集器具有内容采集和数据导入功能,可以将你采集的任意网页数据发布到远程服务器。业界对采集的内容嗤之以鼻,虽然大部分站长反对通过采集更新网站内容,但还是有不少站长通过各种手段更新内容采集一直都是。

利用采集程序抓取别人的网站内容,放到自己的网站上,这是一种很不公平的获取内容的方式,因为这种方式方便性有成为许多网站更新的手段和渠道,这可以被视为行业内不公平竞争的一种方式。

“黑帽SEO”如何从零开始学习黑帽SEO? “第三部分”

另外,采集内容质量控制的难度也是抵制采集的另一个重要原因。现在很多站长使用程序来处理采集内容,而现有的技术对文章中不利于网站开发的内容,比如坏屏句子等无法安全过滤。即使你从权威的网站上传采集内容,其他网站内容也未必适合你的网站内容更新,网站本身的开发有差异。现在搜索引擎的人性化水平逐渐提高,作弊的手段很容易对搜索引擎不友好。发展后果是完全值得的。无论如何,采集的内容不能让网站长期存活,也不适合网站的长期运营,所以灯塔seo不推荐大家用这个方法。

“黑帽SEO”如何从零开始学习黑帽SEO? “第三部分”

2、伪原创工具

所谓伪原创就是对文章的一篇文章进行再处理,让搜索引擎认为是原创文章的一篇文章,从而增加权重网站 的。随着seo的发展,出现了“伪原创”这个产品,被很多SEOer迷住了,不能自拔。运营站群的站长还是很多的,网站从几百到上千不等。 网站的阵容如果用原创更新*敏*感*词*是个无底洞,而采集是最简洁方便的方法。

“黑帽SEO”如何从零开始学习黑帽SEO? “第三部分”

可能有人会问:“采集的目的是什么?”很简单,当然就是获取大量的内容信息,然后自己集成一个高质量的伪原创。这种方法比在那里思考要好一百万倍。当然,坚持原创是好的,但是由于种种原因,不要随意填写垃圾内容。

我们知道搜索引擎喜欢原创*敏*感*词*内容,它会认为它对于重复内容没有收录价值。如果网站上的大量内容被转载,搜索引擎会觉得整个网站价值不大,从而降低网站的权重。 网站排名自然不会很高。因为伪原创工具是机械的、死板的,这些工具无非是替换词,比如同义词,甚至是反义词,与原意完全相反,没有观点或错误观点,对网站长远发展无害。

“黑帽SEO”如何从零开始学习黑帽SEO? “第三部分”

同时,这些伪原创工具还具有打乱文章的段落和句型的“能力”,使得文章看起来与序言不一致,使听起来有点刺耳。这样的 文章 胡说八道,仅适用于搜索引擎。 网站 的最终目的是向用户展示。 网站的大量文章看不懂,句子没意思。如果你看到别人的网站是这样的,也一定要马上点击屏幕右上角的红叉。今年,搜索引擎对内容的重视程度有目共睹,所以 Lighthouse SEO 建议大家不要使用这种方式。

2.买卖链接

网站的外部优质单向链接推荐功能灯塔seo不用多说,做seo的都知道。这也是人们一直在寻找各种平台发布外部链接的原因之一。主页上一个好的单向链接比那些平台上的链接要好得多。很多人通过链接交易平台买卖链接,也就是pr高的外部链接或者友情链接。这种作弊方式现在也很流行。

好的,文章的这个内容营销圈就分享到这里。对线上推广创业感兴趣的可以加微信:Dao8484 备注:营销圈引流学习,我拉你进直播课程学习群,每周135晚,有实用干货推广引流免费分享技术课程!

看过这篇文章的人还看过以下内容:黑帽SEO学习,如何从零开始学习黑帽SEO?黑帽seo教程,黑帽seo优化详解?黑帽seo方法有哪些,常见的黑帽seo技巧揭晓-?重庆seo论坛,常见的黑帽seo技巧揭晓? seo黑帽优化怎么做,SEO优化中黑帽seo优化的4种方法?

教程:图解Word2vec,读这一篇就够了

此时我们已经生成了数据集中的第一个样本,将用于我们后续的语言模型训练。

接下来,我们将窗口滑动到下一个位置并生成第二个样本:

此时也生成了第二个样本。

不久之后我们就会拥有一个更大的数据集,我们可以在其中看到出现在不同单词组之后的单词:

在实际应用中,模型通常在我们滑动窗口时进行训练。但我认为将生成数据集和训练模型分成两个阶段会更清晰易懂。除了使用神经网络建模外,一种称为 N-gams 的技术通常用于模型训练。

如果您想了解实际产品中从使用 N-gams 模型到神经模型的转变,请查看 Swiftkey(我最喜欢的 Android 输入法)在 2015 年发表的一篇关于他们的自然语言模型及其与之前的比较的博文N-游戏模型。我喜欢这个示例,因为它向您展示了如何在营销宣传中解释嵌入的算法属性。

注意两端

根据前面的信息填空:

在空白前面,我提供的背景是五个字(如果事先提到“巴士”),我相信大多数人都会将巴士放在空白处。但如果我再给你一条信息——比如空格后面的一个词,答案会改变吗?

填空的内容完全变了。在这一点上,“红色”这个词最有可能适合这个位置。从这个例子中,我们可以了解到单词前后的单词带有信息值。事实证明,我们需要考虑两个方向的单词(目标单词左侧的单词和右侧的单词)。那么我们如何调整训练方式来满足这个要求,继续往下看。

Skipgram 模型

我们不仅要考虑目标词的前两个词,还要考虑后面的两个词。

如果我们这样做,我们实际构建和训练的模型将如下所示:

上述架构称为连续词袋 (CBOW),在 word2vec 上的一篇论文中进行了描述。

还有另一种架构,它不根据上下文(前后的词)猜测目标词,而是猜测当前词前后可能出现的词。我们假设训练数据时滑动窗口如下图所示:

绿色方框中的词是输入词,粉色方框是可能的输出结果

这里粉色框的颜色深度不同,因为滑动窗口为训练集生成了4个独立样本:

这种方法称为 Skipgram 架构。我们可以如下图显示滑动窗口的内容。

这为数据集提供了 4 个样本:

然后我们将滑动窗口移动到下一个位置:

这样我们生成接下来的 4 个样本:

移动几组位置后,我们得到一批样本:

重温训练过程

现在我们已经从现有文本中获得了 Skipgram 模型的训练数据集,让我们看看如何使用它来训练预测相邻单词的自然语言模型。

从数据集中的第一个样本开始。我们将这些特征输入到一个未经训练的模型中,并让它预测一个可能的相邻单词。

模型执行三个步骤并输入一个预测向量(对应于词汇表中每个单词的概率)。因为模型没有经过训练,所以这个阶段的预测肯定是错误的。不过没关系,我们知道应该猜哪个词——那个词是我的训练集数据中的输出标签:

目标词的概率为1,其他所有词的概率为0,所以values的向量就是“目标向量”。

模型有多少偏差?两个向量相减得到偏置向量:

现在这个误差向量可以用来更新模型,所以在下一轮预测中,如果我们使用not作为输入,我们更有可能得到thou作为输出。

这实际上是训练的第一步。然后我们继续对数据集中的下一个样本做同样的事情,直到我们遍历了所有样本。这是一个时代。我们再做几个 epoch 来获得一个经过训练的模型,我们可以从中提取嵌入矩阵用于其他应用程序。

以上确实帮助我们理解了整个过程,但它仍然不是 word2vec 真正训练的方式。我们错过了一些关键的想法。

负采样

回想一下这个神经语言模型用来计算其预测的三个步骤:

从计算的角度来看,第三步非常昂贵 - 尤其是当我们需要对数据集中的每个训练示例都执行此操作时(很容易多达数千万次)。我们需要找到一些方法来提高性能。

一种方法是将目标分为两个步骤:

1.生成高质量的词嵌入(不用担心下一个词的预测)。

2.使用这些高质量的嵌入来训练语言模型(用于下一个词的预测)。

在本文中,我们将专注于第 1 步(因为这个 文章 专注于嵌入)。为了使用高性能模型生成高质量的嵌入,我们可以改变预测相邻单词的任务:

将其切换到一个模型,该模型接受输入和输出单词,并输出一个分数,表明它们是否是邻居(0 表示“不是邻居”,1 表示“邻居”)。

这种简单的转换将我们需要的模型从神经网络更改为逻辑回归模型 - 因此计算更简单、更快。

这个切换需要我们切换数据集的结构——标签值现在是一个值为 0 或 1 的新列。它们都将为 1,因为我们添加的所有单词都是邻居。

计算速度快得惊人 - 在几分钟内处理数百万个示例。但我们仍然需要解决一个漏洞。如果所有示例都是邻居(目标:1),我们的“天才模型”可能会被训练为始终返回 1 - 100% 的准确率,但它什么也没学到,只会产生垃圾嵌入结果。

为了解决这个问题,我们需要在数据集中引入负样本——非邻居词的样本。我们的模型需要为这些样本返回 0。模型必须应对这一挑战,并且仍然必须保持高速。

对于我们数据集中的每个样本,我们都会添加负样本。它们具有相同的输入词,标签为 0。

但是我们要填写什么作为输出词呢?我们从词汇表中随机抽取单词

这个想法的灵感来自噪声对比度估计。我们将实际信号(相邻词的正例)与噪声(随机选择的非相邻词)进行比较。这导致计算和统计效率的巨大权衡。

噪声对比度估计

基于负采样的 Skipgram (SGNS)

我们现在介绍了word2vec中的两个(一对)核心思想:负采样和skipgram。

Word2vec 训练过程

现在我们了解了 skipgram 和负采样的两个中心思想,我们可以继续深入了解实际的 word2vec 训练过程。

在训练过程开始之前,我们会对用于训练模型的文本进行预处理。在这一步中,我们确定字典的大小(我们称之为 vocab_size,比如 10,000) 以及其中收录哪些单词。

在训练阶段开始时,我们创建了两个矩阵——嵌入矩阵和上下文矩阵。这两个矩阵将每个单词嵌入到我们的词汇表中(因此 vocab_size 是它们的维度之一 一)。第二个维度是我们希望每个嵌入的长度(embedding_size - 300 是一个常见值),但我们也看到了前面 50 个的例子)。

在训练过程开始时,我们用随机值初始化这些矩阵。然后我们开始训练过程。在每个训练步骤中,我们采用相邻示例及其相关的非相邻示例。让我们看看我们的第一组:

现在我们有四个词:输入词 not 和输出/上下文词:thou(实际相邻词)、aaron 和 taco(反例)。我们继续查找它们的嵌入——对于输入词,我们查看嵌入矩阵。对于上下文词,我们查看上下文矩阵(即使两个矩阵都将每个词嵌入到我们的词汇表中)。

然后我们计算输入嵌入与每个上下文嵌入的点积。在每种情况下,结果都是一个数字,表示输入和上下文嵌入的相似性。

现在我们需要一种方法将这些分数转换成看起来像概率的东西——我们需要它们都是正数并且介于 0 和 1 之间。逻辑函数转换 sigmoid 适合这种事情。

现在我们可以将 sigmoid 运算的输出视为这些示例的模型输出。可以看到,在 sigmoid 操作之前和之后,taco 得分最高,而 aaron 得分最低。

既然未经训练的模型已经做出了预测,而且我们确实有真实的目标标签要比较,那么让我们计算模型预测中的误差。为此,我们只需从目标标签中减去 sigmoid 分数。

错误 = 目标 - sigmoid_scores

这是“机器学习”的“学习”部分。我们现在可以使用这个错误分数来调整 not、thou、aaron 和 taco 的嵌入,以便下次我们进行这个计算时,结果会更接近目标分数。

训练步骤到此结束。我们为这一步中使用的单词(不是,thou,aaron 和 taco)获得了更好的嵌入。我们现在进入下一步(下一个相邻样本及其相关的非相邻样本)并再次执行相同的过程。

随着我们多次循环遍历整个数据集,嵌入会不断改进。然后我们可以停止训练过程,丢弃 Context 矩阵,并使用 Embeddings 矩阵作为下一个任务的训练嵌入。

窗口大小和负样本数

word2vec 训练过程中的两个关键超参数是窗口大小和负样本数。

不同的任务适合不同的窗口大小。一种启发式方法是,使用较小的窗口大小 (2-15) 会导致嵌入使得两个嵌入之间的高相似度得分表明单词是可互换的(请注意,如果我们只查看靠近的单词)接近,反义词通常是可互换的 - 例如,好的和坏的经常出现在相似的上下文中)。使用更大的窗口大小(15-50,甚至更大)将获得相似性更能指示词相关性的嵌入。在实践中,您通常需要引导嵌入过程,帮助读者获得类似的“语言感”。Gensim 默认的窗口大小为 5(其中包括输入除了输入词本身之外的词前后两个词)。

负样本的数量是训练过程中的另一个因素。原创论文认为 5-20 个负样本是一个理想的数字。它还指出,当您有足够大的数据集时,2-5 似乎就足够了。 Gensim 默认为 5 个负样本。

送 10 本书 |免费送货 |你还在等什么