技巧:小蜜蜂助手文章采集工具使用方法,实时访问的话

优采云 发布时间: 2022-09-26 03:05技巧:小蜜蜂助手文章采集工具使用方法,实时访问的话

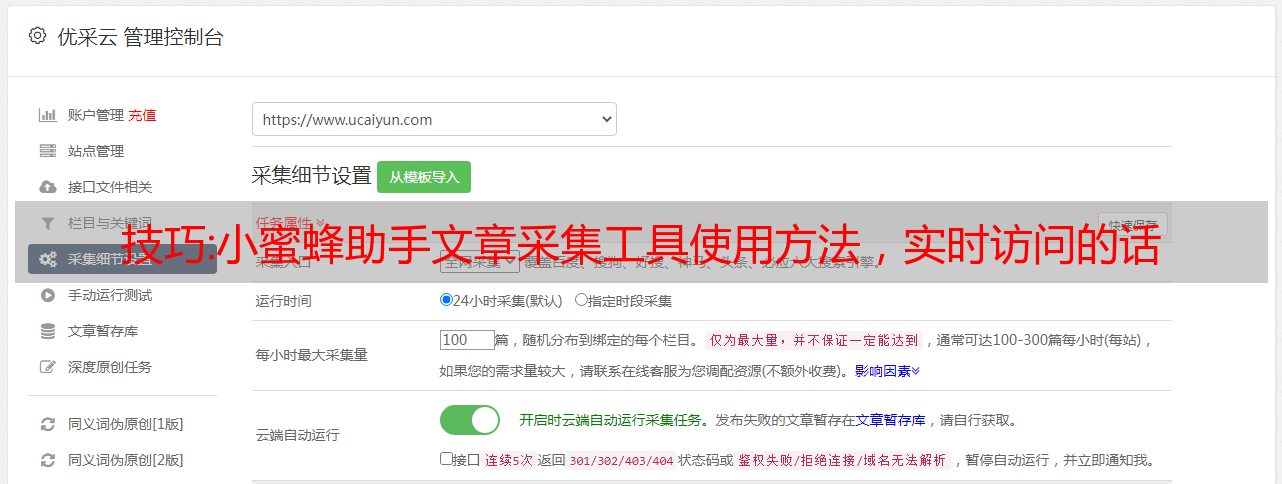

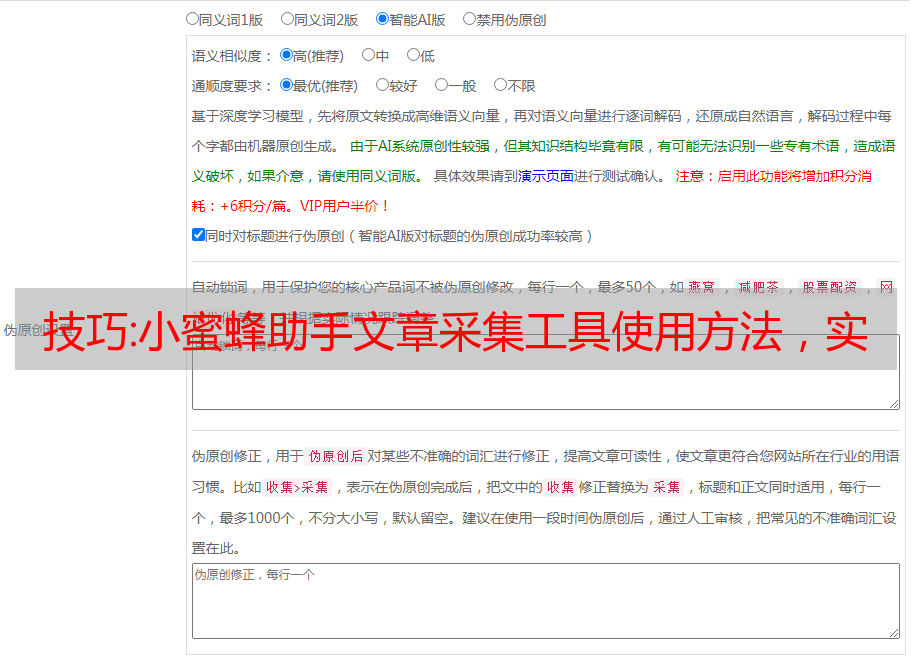

文章采集文章采集功能,由小蜜蜂的文章采集功能实现。包括提取和复制链接,以及内容存储到文本文件等操作。作者:小蜜蜂助手链接:小蜜蜂助手/小蜜蜂文章采集工具使用方法复制别人的链接到小蜜蜂助手文章采集框后,可以自己对链接进行修改,从而实现功能的调整。文章内容输入一篇文章,并选择输入文章中需要使用的关键词,保存到文本文件,从而实现采集。内容存储如果使用的是链接工具:也可以选择存储到本地文件。

我在开始学习爬虫的时候,最头疼的是获取网页爬虫的网站本身的各种各样的规则,弄得人脑瓜子直发晕。大神中的大神这种问题肯定有解决办法啦,不过这个大神我暂时没遇到过,但是这几天也总算找到了可以用的方法,分享给大家哈。先安利一下淘宝,实时访问的话。首先淘宝采集需要用淘宝助理来做淘宝的日志抓取的工具。先打开淘宝的首页,这个时候就会跳出一个菜单,然后就是现在标题所写的接口,在这里一抓一大把,这个时候就可以得出淘宝分页的url了。

主要需要的是淘宝关键词。随后在淘宝进行搜索,将搜索后的内容全部存储,然后再搜索其他词汇的时候就可以直接返回最新的内容,这时候就可以抓取很多看到的关键词的内容了。如果你只需要关键词的内容的话,那么这个时候我想你就已经把淘宝商品按照标题分类排好顺序了。再有一个用方法是淘宝首页有个按标题排序的系统,可以了解一下。

像我这种喜欢将看到的关键词自己编辑成词汇,然后再进行淘宝的分页筛选。这个用的是google的js代码获取,js代码可以自己做一个字典对象,这样就可以拿到每个关键词下自己编辑的词汇。另外对于这些包含关键词的个性化词汇还可以进行微调。对关键词编辑完之后就可以坐等搜索返回的内容了。刚才也说到,本身有淘宝自己的搜索接口,直接在浏览器搜索你所需要的内容就行。

要是要用js的话,那就用js。最后说一下爬虫的方式,主要涉及到基础的网页爬虫和搜索,在此不详细叙述,总之一切都需要基础js代码和部分js算法。话说这个图挺好的啊。