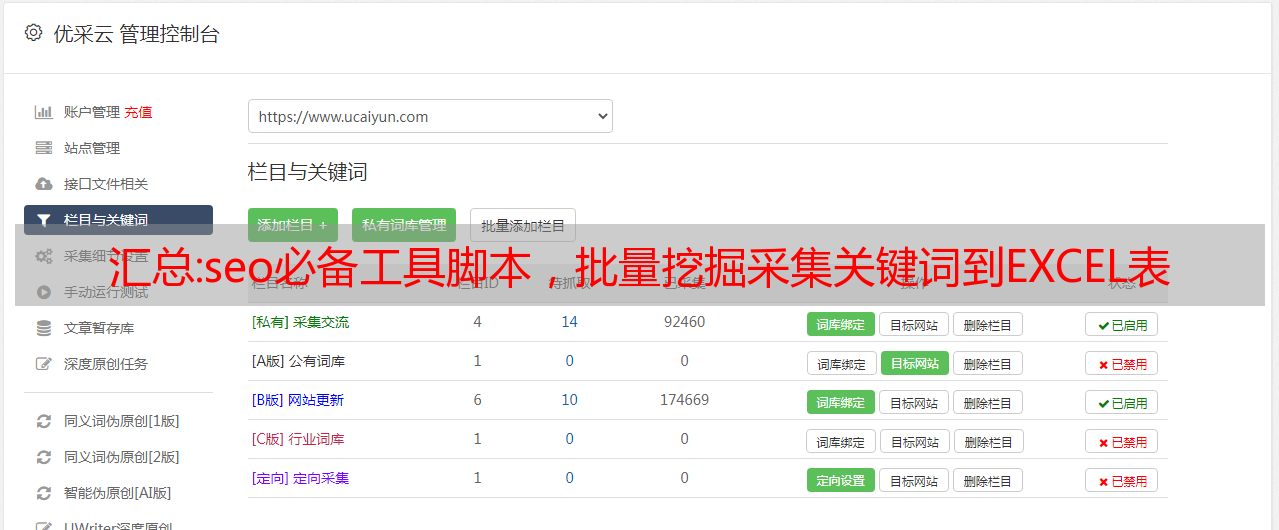

汇总:seo必备工具脚本,批量挖掘采集关键词到EXCEL表

优采云 发布时间: 2022-09-25 22:13下午,我收到朋友的反馈说它失败了。为什么经常失败?因为现在是支付的时代,你做的每件事都需要充值,否则什么都得不到,而且有限制,所以如果你需要,选择支付。花了点时间把文章里的代码改成A站的api,感觉一劳永逸,这个帖子就不再更新了。

下午收到朋友反馈说无效。花了几分钟来修复它。代码于 2020 年 12 月 1 日更新。最新下载地址在文末:

想知道为什么我会收到朋友的反馈吗?点击进入本帖:

我还记得这次疫情期间我是在*敏*感*词*节登记的。期间也学习了很多大佬分享的教程和源码,收获颇丰。

昨天逛论坛的时候,不是发现了一个用python写的seo关键词采集挖矿脚本(原帖:%3D1%26filter%3Dtypeid%26typeid%3D29&page=1),因为我自己做了一个小网站,虽然平时不太关注seo,但是我还是很喜欢这种可以解放双手的工具,所以复制下来试了一下,还有发现代码报错了,于是开始看帖子的评论,发现很多人都报了和我一样的错误,比如下面这个,像我这样的新手,求救。

xyj_2020-07-10_15-50-41.png(27.1 KB,下载:4)

下载附件

2020-7-10 15:54 上传

几年前我自学了一段时间python,加上我有一点编程语言基础,加上我擅长用百度搜索,终于努力修好了这个脚本,至少我可以正在运行,现在分享给大家,回馈论坛,帮助你我。先粘贴代码。不要嘲笑老板

[Python]纯文本查看复制代码

#爱站网长尾关键词挖掘

#2021-5-11更新

# -*- coding=utf-8 -*-

import requests

import xlwt

import json

#secrect_Id 登录爱站后获取

secrect_Id ='805422c95131161b845661eb7afe14c5'

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.93 Safari/537.36',

'Accept':'text/html,application/xhtml+xml,application/xml;q=0.9,image/avif,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9',

"Connection": "keep-alive",

"Accept-Encoding": "gzip, deflate, br",

"Accept-Language": "zh-CN,zh;q=0.9"

}

#获取关键词数据

def get_keyword_datas(keyword):

<p>

data={

'word': keyword,

}

url = "https://apistore.aizhan.com/word/related/{0}".format(secrect_Id)

print(url)

html=requests.post(url,data=data,headers=headers).text

res = json.loads(html)

# print(res)

data_list = []

if res['code'] == 200000:

if res['data']['count'] > 0 :

print('已采集到{0}关键词,正在保存中...'.format(res['data']['count']))

for value in res['data']['list']:

item = []

for k,v in value.items():

item.append(v)

data_list.append(item)

elif res['code'] == 100003:

print("接口维护")

elif res['code'] == 200002:

print("非法关键词")

elif res['code'] == 100005:

print("余额不足,请充值")

else:

print("系统错误")

return data_list

#保存关键词数据为excel格式

def bcsj(keyword,data):

workbook = xlwt.Workbook(encoding='utf-8')

booksheet = workbook.add_sheet('Sheet 1', cell_overwrite_ok=True)

title = [['长尾关键词', '全网指数', 'pc指数', '移动指数']]

title.extend(data)

#print(title)

for i, row in enumerate(title):

for j, col in enumerate(row):

booksheet.write(i, j, col)

workbook.save(f'{keyword}.xls')

print(f"保存数据为 {keyword}.xls 成功!")

if __name__ == '__main__':

keyword = input('请输入关键词>>')

print('正在采集长尾关键词数据,请稍后...')

datas_list=get_keyword_datas(keyword)

if datas_list:

print('========================采集结束========================\n')

bcsj(keyword, datas_list)

else:

print('采集失败\n')</p>

附上采集部分流程图:

运行过程.png (44.82 KB,下载次数:1)

下载附件

2020-7-10 16:12 上传

部分结果:

xyj_2020-07-10_15-57-07.png(74.68 KB,下载:2)

下载附件

2020-7-10 16:12 上传

我的 exe 文件是用 pyinstaller 打包的。打包的体积有点大,有需要的可以下载。

2021 年 5 月 11 日更新下载:

如果你觉得它有用,你能给我一个免费的评价来鼓励我吗?谢谢!

技术文章:网站自媒体文章怎么批量Word、Excel格式免费导出

如何将网站和自媒体上的文章以Word和Excel格式批量导出,不管是今日头条还是微信公众号,很多有趣的文章,如果这些文章可以批量导出,不仅可以让我们获得大量的素材,还可以对数据进行分析,方便我们的工作和生活。

对于海量的文章数据,单纯的复制粘贴效率会很低,手动操作难免出错。借助SEO采集工具,我们不仅可以采集网站相关内容、微信头条等,自媒体文章也可以实时更新时间通过增量采集行业相关信息,也可以Excel、word、txt、HTML等格式导出到本地。

1.及时性

各行各业每天都会产生大量的文章数据。以网站的构造为例,如果网站优化得更好,我们可以使用网站自媒体文章采集大量的素材实现网站内容的高质量更新。不管是哪个行业,时效性也很重要。信息网站可以增量更新采集守住相关行业的第一手资源,实现网站的快速更新。

2. 内容价值

新旧内容具有同等价值。创作新作品并将新主题融入我们的 SEO 活动将吸引新的观众。虽然新内容至关重要,尤其是在当前趋势和时尚下,但生成永恒的内容同样重要。为了使我们的内容每年都能继续取得成功,无论过去了多少时间,它都必须具有相关性。例如,如果您的内容是关于化妆的,您应该在 文章/resources 上找到应用它的最佳方式。像这样的内容将继续并每年为我们的 网站 和其他平台带来新用户。为了让我们的观众保持参与,发布与我们的利基相关的新内容也很重要。在这种情况下,发布一个关于最佳新化妆产品的 文章 是个好主意。

3. 内容长度

对更丰富、更有趣、更有用的内容的需求逐年增加。用户期望丰富的内容能够让他们在相当长的一段时间内保持沉默。虽然冗长的内容很受欢迎,但作为数字营销人员,我们需要在短内容和长内容之间找到平衡。对于视频,观众更喜欢 10-30 分钟的内容。在 抖音 上,用户更喜欢较短的视频(通常不到一分钟),因为他们在一段时间内互动的内容大量涌入。根据我们使用的内容类型和形式,所需的内容长度会有所不同。

4.用户体验

在线用户讨厌使用糟糕的编程网站。用户体验可以成就或破坏我们的声誉。页面速度慢、滞后、布局混乱、客户服务差以及其他问题让观众感到沮丧。有时,由于用户的互联网连接、临时系统故障和*敏*感*词*。我们可以通过多种方式提供优质的用户体验,以便在线个人能够很好地接收我们的内容。我们可以做的第一件事是确保我们的 网站 是安全的。黑客和其他在线威胁可能会使我们的订阅者、客户和客户信息(以及我们自己的)面临风险。过去,安全漏洞使客户不愿使用某些 网站。如果客户可以看到我们的 网站 是安全的,他们将来会更有信心与之互动。除了安全的网站,我们还可以通过更新的编程、人工智能辅助和定期的网站维护来改善用户体验。

2022 年的主要 SEO 趋势是良好的用户体验、高价值的内容和整体所需的内容长度。不断创造优质内容,为用户提供持续的服务,是我们用户留存的重要一环。无论是优化还是其他行业,还是有很多共同点的。