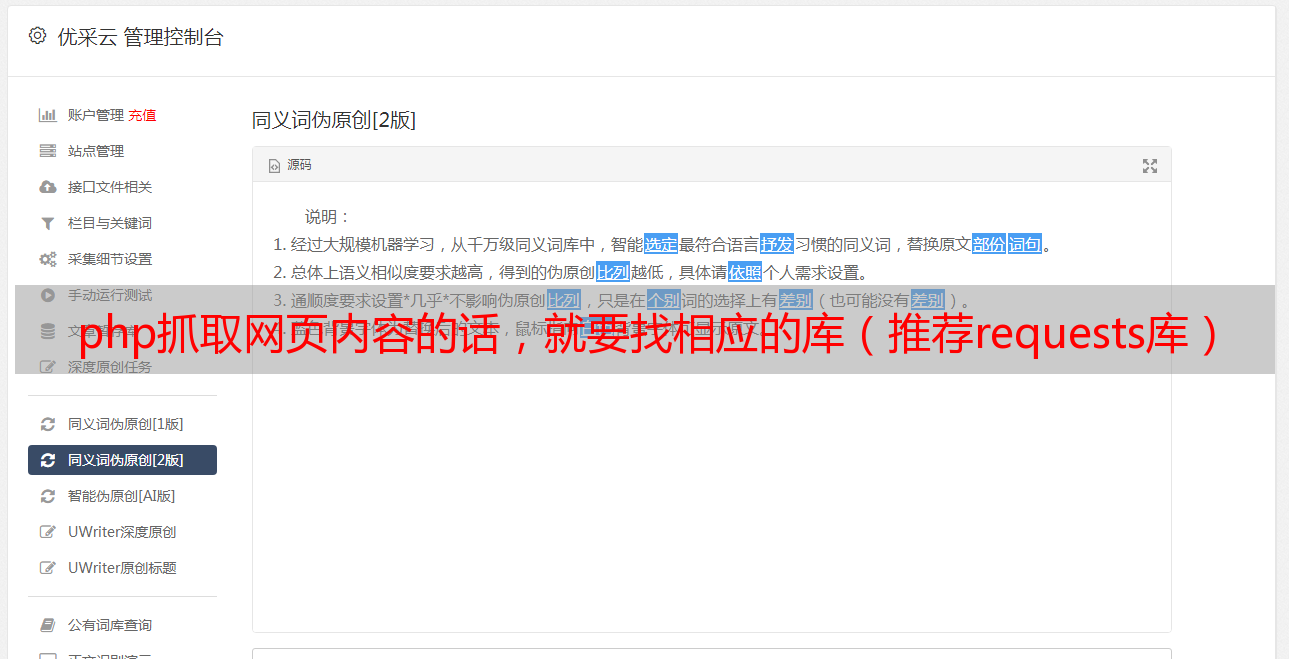

php抓取网页内容的话,就要找相应的库(推荐requests库)

优采云 发布时间: 2022-09-16 13:00php抓取网页内容的话,就要找相应的库(推荐requests库)

php抓取网页内容的话,就要找相应的库(推荐requests库)。

1、正则爬虫可以用python正则表达式,可以用requests库实现网络爬虫。

2、爬虫框架可以用scrapy实现爬虫。

3、表单爬虫可以用mongocode和requests库实现。

可以抓到,然后把抓到的内容导出给服务器用html实现,由于你没有设置预览方式所以只能看然后打包可以放到一个js文件里面去,

第一次回答问题。我在做网络爬虫的过程中一直有个困惑,为什么即使是我们自己写的爬虫,一开始也没有抓到数据,但是这些数据可以被我们自己轻易下载、读取到?或者说能有一部分数据我们只能获取到一些公开的数据?更甚至如果我们只想获取某个网站的某个页面,我们可以简单的判断一下该页面的抓取难度,比如php的websocket协议,里面允许请求https加密的html,这样我们就可以不去抓取该页面所有的数据。

既然有一些数据我们获取不到,而这些数据又是网站的一部分,那我们要实现这个网站的爬虫需要做些什么?难道要保证自己写的爬虫每次都能成功一样吗?好像也不对。除了要获取某个网站的全部内容,我想其他网站的内容我们也不一定要爬到。比如看论坛的文章,我们看到的只是博客园的部分内容,而其他的我们根本就不想看到。对于php的话,首先我看到的php原生是没有websocket服务的。

对于很多网站来说我觉得有websocket服务比不用好。php不能开发客户端和服务端,但是服务端肯定是可以的。用浏览器实现应该是不靠谱的,对于xml格式的就更不可能了。后来想到了flask,又想到了基于requests和pyquery的库。这里从抓取和debug的角度,介绍下一个爬虫中常用的库pcrequests吧。

怎么抓取呢?很多技术博客有介绍爬虫,但是大家都基于pcrequests开发爬虫,因为pcrequests的api比其他python库好用一些。而我们从抓取原理出发,就是必须知道自己要爬哪个页面,然后去flask里面把它的html注入到自己的爬虫程序,以及数据准备的话,肯定是debug的麻烦的多。这样说来我们实现debug爬虫的原理就一定要一个flask的库。

我知道会有人觉得flask的api难用,但是我觉得这是很多人面对一个不熟悉的框架所做的。接下来只是一些个人经验,可能有不足的地方,但是希望能给迷茫中的你一些帮助。原理讲清楚之后你就能明白我的意思,从一个简单的例子可以看出我想说的,在这个系列文章里,我只是知道flask是一个http服务器,flask里面的一些基本功能包括:可以对自己保存的cookies进行操作,对flask里保存的dom信息进行操作,对。