文章一键采集工具,支持几百个网站的抓取和采集

优采云 发布时间: 2022-09-15 14:00文章一键采集工具,支持几百个网站的抓取和采集

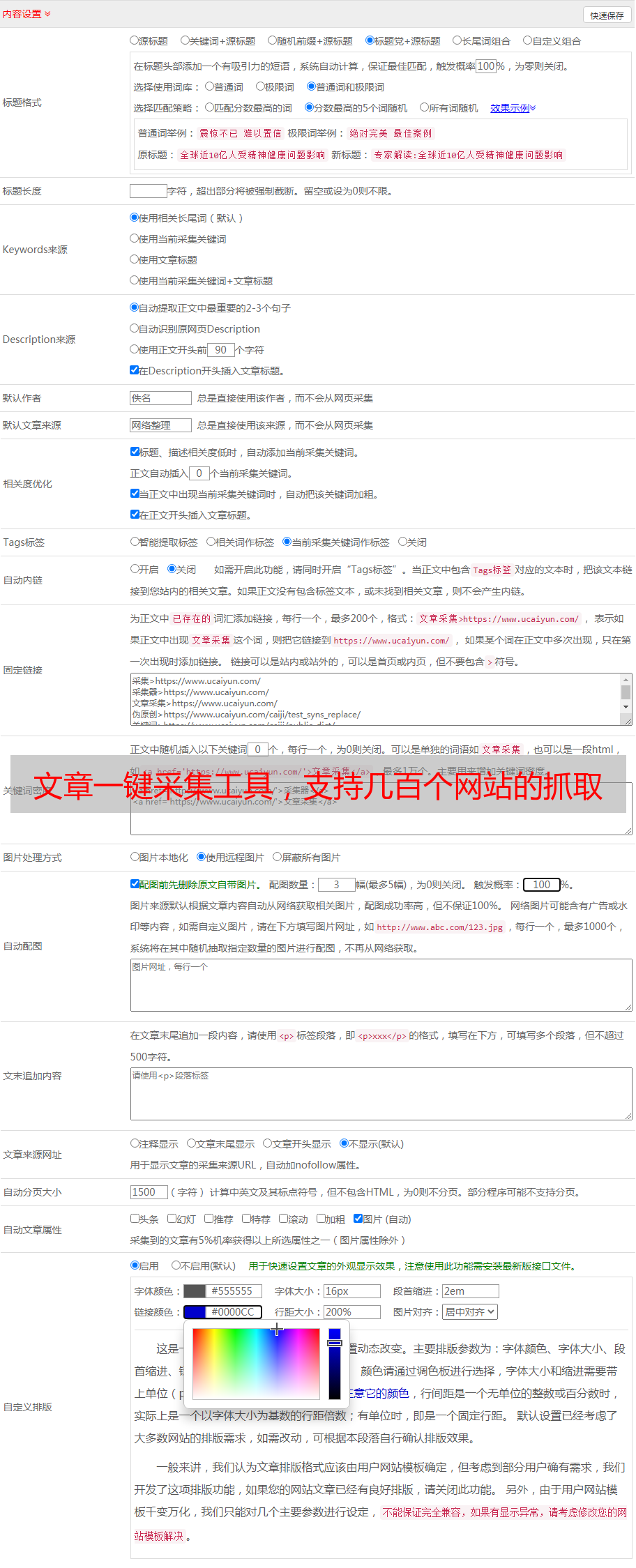

文章一键采集工具,支持几百个网站的抓取和采集,支持详细代码提供,满足大家不同的采集需求。什么是采集网站可以自定义给网站打上标签。比如我要爬500个网站,那我就可以给这500个网站打上500个不同的标签,比如程序员,程序员爱上爬虫,程序员工资又涨了,程序员发出去的薪水好多,程序员转行真好然后我就可以根据这500个标签来抓取。

每个标签后面都会有提供的代码一键采集工具首页这里是500个不同标签的代码自定义配置网址使用一键采集工具:打开一键采集工具左上角有编辑框,在编辑框内输入我们要抓取的网站地址(包括网址和网站id)。点击保存按钮(点击保存后,右边保存按钮前会有提示,点击应用保存网站)在页面右侧有保存网站列表。一次可采集500个。

它能准确的抓取我们想要抓取的网站。后边会有详细地代码提供,你可以对你自己的网站做一个小改动,采集下一批网站。最后我们可以把我们抓取到的网站保存在我们的网盘里,或者可以到公众号cyp3456上面获取更多免费的文章。这是我们免费获取网站的链接。转载请注明出处。

广告么?假如是会员的话,不知道能不能帮到你。

至少来说可以按照自己想抓的文章类型做一个词或者关键词的分类标签,然后就可以一键分析出相应类型的文章及网站,当然这其中有个主要编辑工具,这个需要自己有目标网站的具体类型标签或者自己写一些爬虫程序去匹配,如果资金充足可以考虑使用google提供的爬虫程序(收费),能抓到很多站点,但是自己写程序成本很高,另外大部分用户都是按照日期来维护自己的爬虫程序,很不方便,有些站点的关键词都几年不变,会造成负担,如果我们想一键抓取某个站点的很多文章,同时没有采集频率限制的话,其实可以用万爬,这个的主要是公司有个seo服务,价格是免费的,而且我也有接触过,自己的话平时对于搜索引擎爬虫比较熟悉,同时对这个和大数据存储还是比较看好,可以给出一些建议。