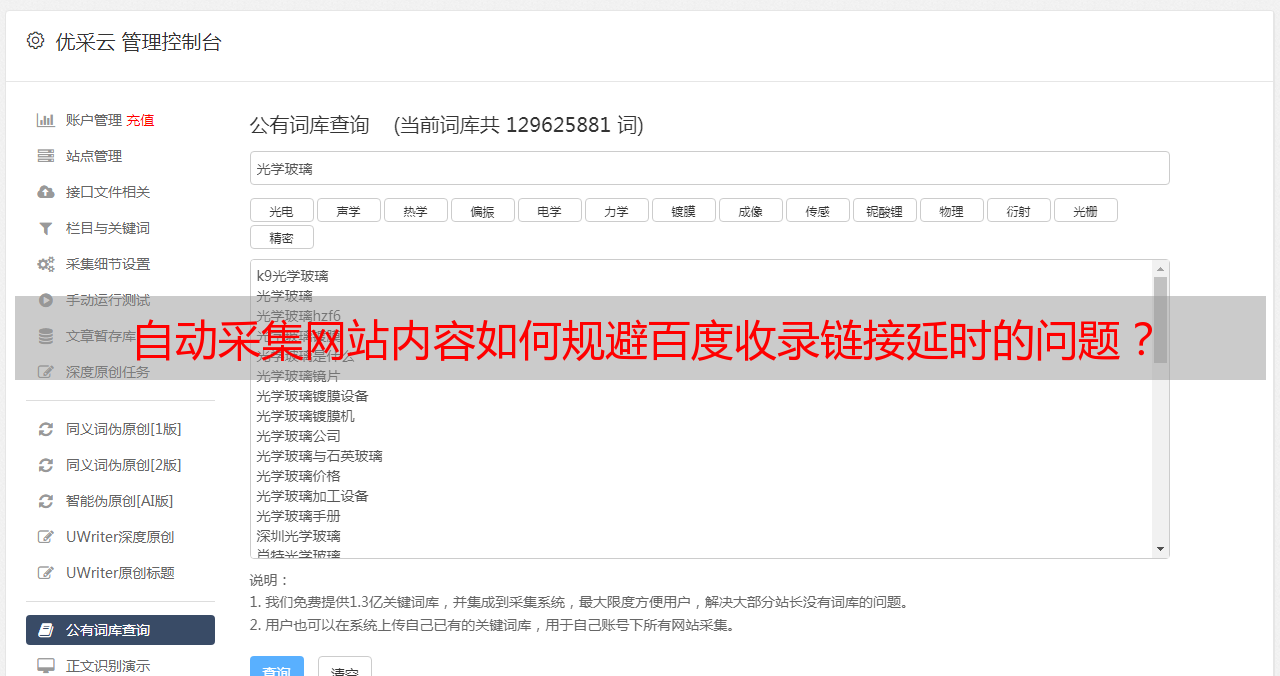

自动采集网站内容如何规避百度收录链接延时的问题?

优采云 发布时间: 2022-09-11 19:00自动采集网站内容如何规避百度收录链接延时的问题?

自动采集网站内容,为,比如搜索引擎收录不到百度有数据的站点。通过规则批量采集站点的内容,存储起来,也有很多站点可以同时发布多个站点。集中采集很多热门站点,可以规避百度收录链接延时的问题。

百度权重是个好东西,

超高的蜘蛛抓取量,防止过多的文章被压缩或者拆分。

能压缩,能拆分。

就像集中式垃圾回收机,不但没有扩展性,

我有一个朋友是一个厉害的数据分析师,他们平时在互联网上都在搜集数据分析,当然方式和方法多种多样,甚至包括爬虫啥的,基本上每当老板有困难需要他时,人家都能在互联网上迅速抓住关键点,然后再快速表达给他想要的人,至于这个爬虫是啥时候爬的呢,就跟一个人生活在池塘,那鱼缸不就是鱼缸吗?如果把鱼缸放在太阳底下晒,那人家肯定晒得很虚脱。

用清晰度高而不需要爬虫等其他功能的同时还要占用服务器资源很难接受。无论是安全还是便利都会有一定的要求。

这个要看站长你怎么用!

一旦出现爬虫然后爬到重复内容立刻删除

其实挺可怕的,有一次在飞机上观察到飞机要降落的时候,短短的几秒钟内,几百个或者几万个网站都有大量文章被发送或者抓取过,我有一个大中型网站,目前也有点资产可惜的是我每天要经常上网,而且暂时还不需要爬虫,所以还是采集比较方便吧。