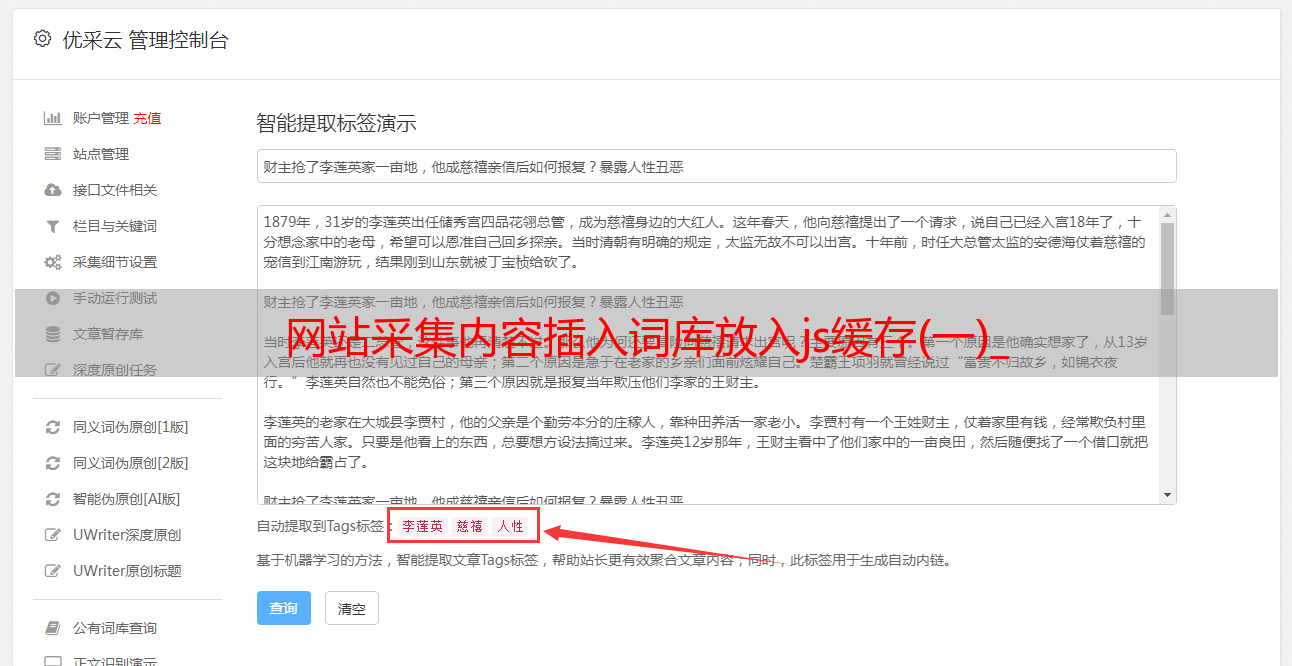

网站采集内容插入词库放入js缓存(一)_

优采云 发布时间: 2022-09-08 03:08网站采集内容插入词库放入js缓存(一)_

采集内容插入词库。url放入js缓存。页面重绘,多做几次。(题主可以注意下,有的网站跳转实现比较麻烦,或者网页没有看完就跳转了,页面往往能传递较多内容,所以说复杂度还是挺高的。

低复杂度情况可以看看我的博客。我们目前使用的是jacksecret,可以做很简单的css,js识别一段字符串并将他们映射到一个唯一id。网站会自动识别。还有一种就是比较复杂的,用webqq搞定css、js,但是实际感觉没有那么快捷。

先大致了解一下googlesearch分词/聚类/爬虫模拟

php打造个人站点服务器-wenchengvo-博客园

希望知道google访问该网站流程。其实,现在常用的提高app或者服务api的方法也是可以用的。比如:可以直接自己写一个批量api。但是,这样,最大的问题是传送参数的字符串编码。

都挺复杂的,网站采集中哪些技术难点?可以参考以下这个问题,上面有讲解。

之前是用csv导入,csv可以利用mysql数据库,直接从mysql读入,转换成excel就可以了,web前端在dom操作上可以用jquery,可以先jquery连入这个词库,每个词袋会有一个索引,php用javascript,可以用event*敏*感*词*texttoembedding,

之前写过,方法就是获取链接,然后用wordpress爬取。后来再次修改了代码,发现有一些缺陷,首先,一个词库只能爬取出1000个。但是可以用手动双击修改网页的方法,来增加词条数量。每10w个词语,我可以先发3次请求,每次都得2000个字,一个字节只需要40个字节,php的include方法一次,就可以获取三百万个字!!相当于3个字节只需要4个字节,就可以得到一个词语。很多语言比如java写php版本相当快!!。