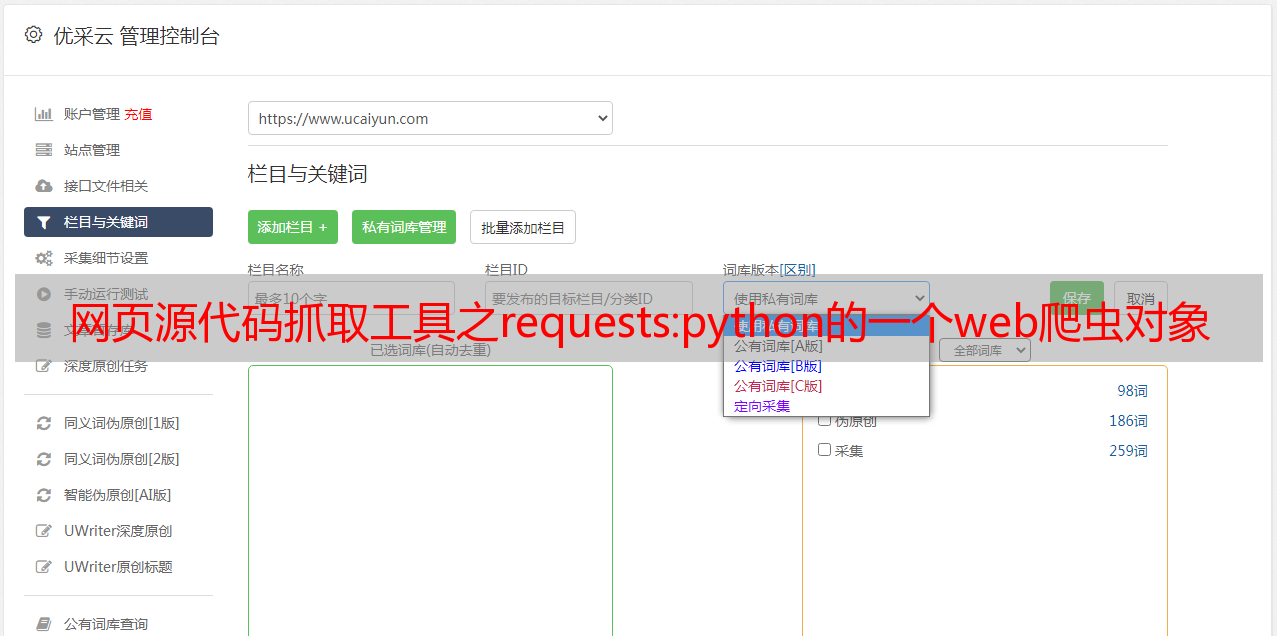

网页源代码抓取工具之requests:python的一个web爬虫对象

优采云 发布时间: 2022-09-07 20:04网页源代码抓取工具之requests:python的一个web爬虫对象

网页源代码抓取工具之requests:python的一个web爬虫对象。之前,因为web开发的规范化,爬虫爬取数据不是必须的。爬取web请求的数据(不包括网页源代码)。为什么要抓取web页面的数据?因为所有的web页面都是一样的。只要是ie浏览器就可以浏览网页。同时,它们的代码是相同的。所以,没有必要抓取。

如果不依赖浏览器,那么利用代理或者beautifulsoup库、lxml库、jquery库等都可以抓取出来。代理模式及实例。代理模式。代理模式需要配置三个东西:url,proxy,https。url是你的服务器回访问应用的地址。这个url其实并不是要寻找一个localhost或者127.0.0.1这样的地址。

实际上,服务器返回的是一个url地址,这个url和你寻找的http源地址在同一个地方。localhost就是所谓的源地址,如果你禁止请求,那么就会把url地址发送给服务器。proxy,代理的模式,让请求不能走socket,而是走get的方式。代理需要配置一些东西,如服务器ip,proxy_host等。

配置好之后,在请求里,都能返回一个通用的http头。https,端口加密技术,传输安全性等。网页页码抓取之requests_in_action看网页网页下的每一行,我们可以用requests_in_action()方法,来设置回调函数。requests_in_action()方法的返回值是response对象。

不过,我们可以传入两个参数,一个是url,一个是proxy_host。一个请求返回一个浏览器缓存相关的值,如none。另一个请求返回一个特定网站的https的值,如。这时的url就不是原来的localhost了。一个网站多个https请求,每个https请求都请求一次所在网站的https相关头,然后在后面对https相关的头加密。

这样所有的请求都设置同一个请求头,代码复用性极好。requests_in_action函数的一种返回值是https_ssl,这个值会显示请求所在网站的真实头的哈希值。https验证相关的东西,因为所有的源地址已经被加密过了,所以要验证。上面的参数,可以随意的加数据或者一些成为https相关值,比如:验证xmlhttprequest.status()的值,是否是https的validation相关,这个默认是auto。

验证sslresponse,true表示使用ssl证书。如果不是,则使用https。如果请求不用https,那么根据url,在post请求中带上一个私钥,请求一般用post方式,私钥可以保证数据安全。requests_action与其他很多的web爬虫对象一样,有一个queryset参数,我们需要知道每个请求要返回什么,这些返回数据如何保存到html文件中。这里的queryset就。