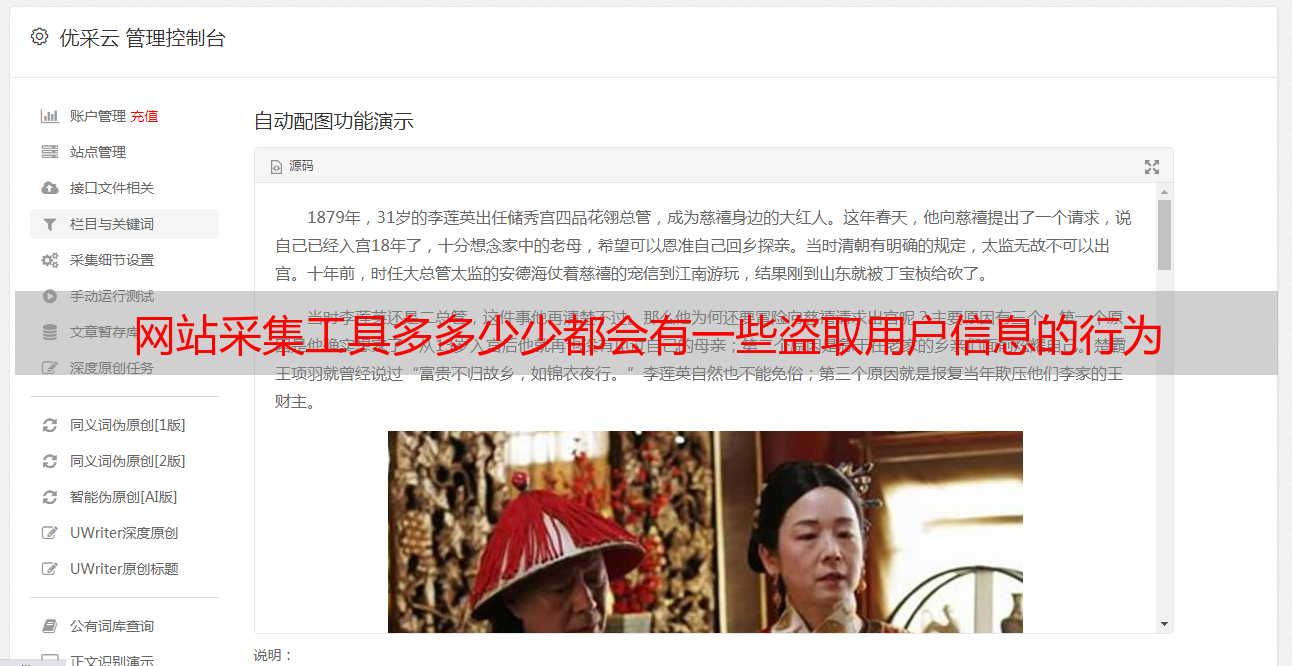

网站采集工具多多少少都会有一些盗取用户信息的行为

优采云 发布时间: 2022-08-30 17:02网站采集工具多多少少都会有一些盗取用户信息的行为

网站采集工具多多少少都会有一些盗取用户信息的行为,安全人员一直很警惕,特别是今年的3.31版本的更新,它们针对网站采集和爬虫系统作了一些专门的防御措施,比如开始禁止直接请求网站数据库或直接发送cookie等等。有些公司甚至对于网站爬虫的访问信息甚至关闭了人工访问网站的功能。所以说,现在很多的爬虫公司包括一些大型企业都重新启动了爬虫功能,到更多不透明的渠道抓取用户数据。

爬虫是采集信息的不二途径,所以对于网站来说,必然要面对四个实际的方向。其中一个方向是网络爬虫如何防御,必须有强大的防御意识。另外一个方向就是爬虫所产生的数据需要如何获取并使用。第三方开发平台主要承担爬虫服务和采集服务,互联网的各个方向的经营主体在采集爬虫服务之后,还要处理爬虫服务生成的数据,这是网络爬虫的生态环境。

至于第四个方向是怎么设计爬虫,很多人认为第四方开发平台只是交给程序员根据python/ruby写爬虫代码,这在服务上不够灵活。本文简单介绍的方法,可以让你写出更灵活的爬虫功能,让网站爬虫更加立体有效。网络爬虫系统网络爬虫主要的两个层次设计,一个是采集层,一个是爬虫层。那么怎么设计采集层,可以参考这篇文章深入浅出深入浅出揭秘网络爬虫开发(二)(三)之深入浅出现代网络爬虫首先说网络爬虫采集层。

根据最新的scrapy模块,我们可以开发基于requests的一个类库,这个类库非常的简单易用,它可以把爬虫的所有框架封装在一起,我们可以用scrapy.spider解析python文件,建立一个爬虫请求目标网站的例子:importrequestsurl=''page=requests.get(url)#这里我们已经拿到了一个python文件,而且是asp文件,即.html文件。

调用for循环,逐个爬取整个asp文件的内容。一个爬虫爬取一个asp文件的方法:importrequestsr=requests.get(url)r.status_code=5cur=r.textcur2=r.textprint('[',cur2,']')再看爬虫层,爬虫层设计一般和爬虫框架脱离,我们需要一个爬虫框架,一般来说requests会有定制的爬虫框架,如果requests爬虫框架不自定义,那么爬虫上层的设计如何开发呢?这个框架的选择很多,大部分可以参考haersresp/javascript2htmltemplates(2.0版本的web爬虫框架),在项目的初期,大多的项目都基于该爬虫框架做。

另外一种方式是直接开发爬虫框架,那么直接是让这个爬虫框架去编写爬虫的代码,基于该框架开发和爬虫相关的爬虫。项目初期,爬虫框架一般来说不会改动特别大,比如redis有r。