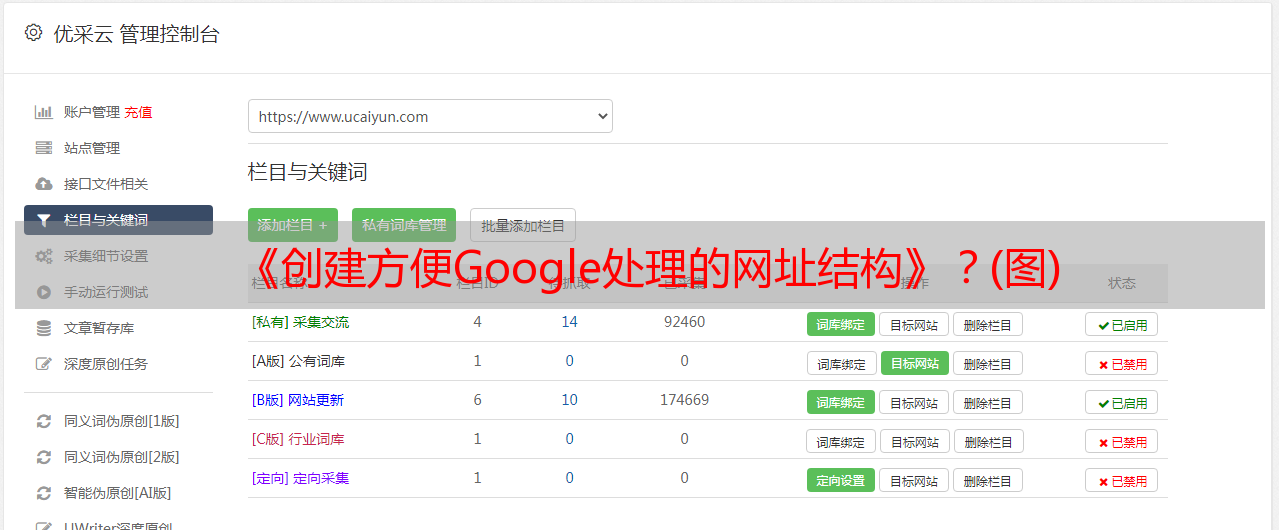

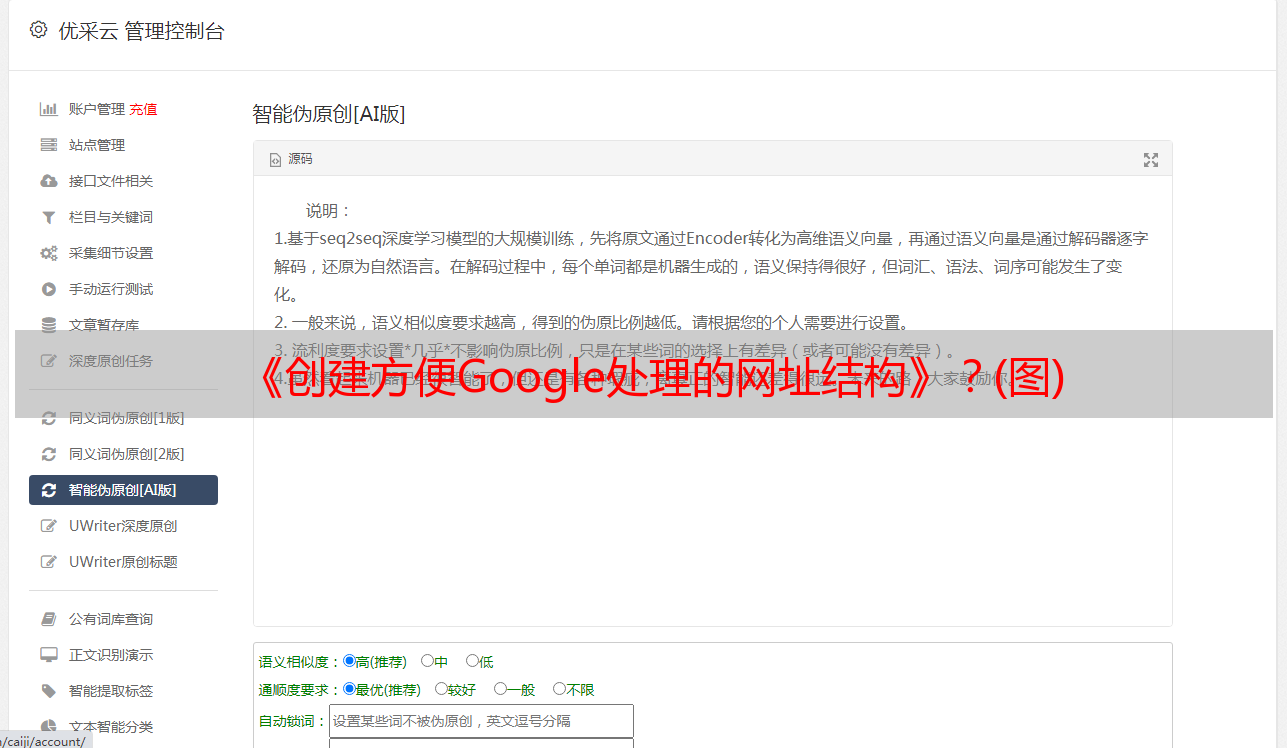

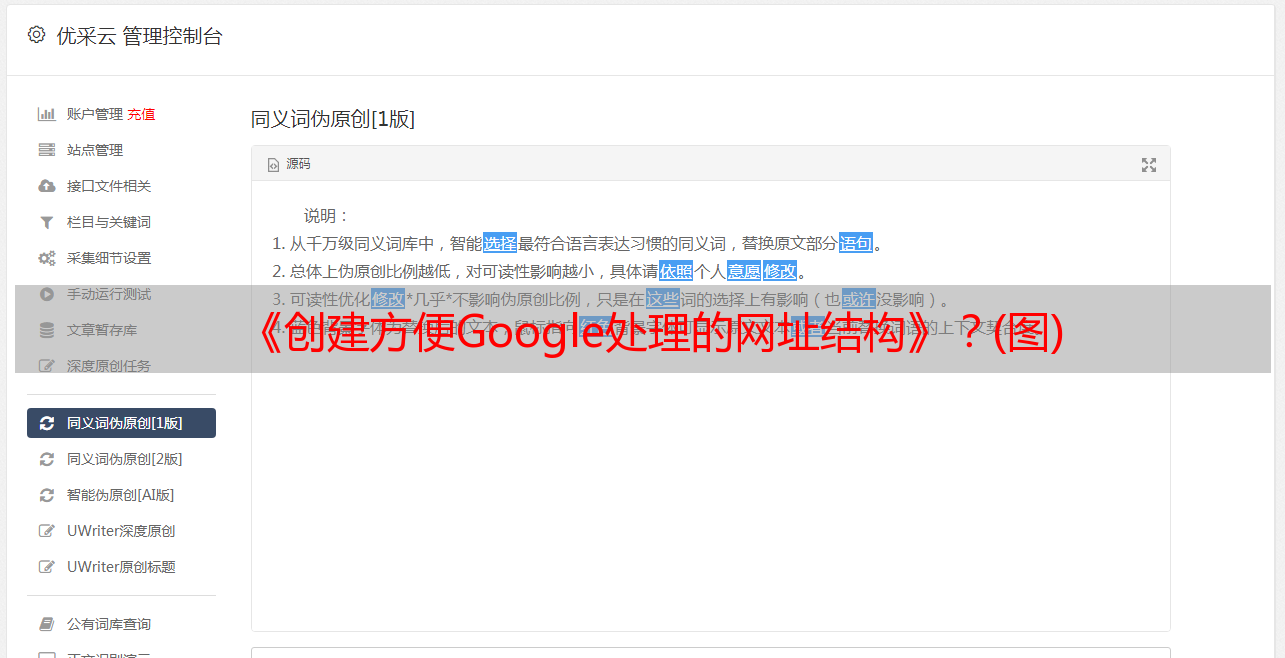

《创建方便Google处理的网址结构》?(图)

优采云 发布时间: 2021-05-23 04:06《创建方便Google处理的网址结构》?(图)

在开始讨论这些问题之前,您需要阅读以下文档:

“优化网站的抓取和收录”

“ Google搜索引擎入门指南”的第7至11页。点击这里下载

“创建一个易于Google处理的URL结构”? hl = cn&answer = 76329

这些是Google的正式文档,描述了各种规则。这些也适用于百度,因为它是针对爬虫的特性而提出的,而不仅是针对某个搜索引擎的。

阅读上述规则后,我发现我一直在谈论如何使采集器非常平滑地爬行整个对象网站。实际上,大多数网站都存在一种或另一种问题,包括我的博客,这在抓取过程中也存在一些问题。但是,如果每个博客帖子都可以是收录,则无需对其进行优化。但是对于许多仍然存在收录问题的网站(尤其是大中型网站),有必要进行良好的规划。您可以使用HTTrack来搜索semyj的博客,并且可以了解我为什么这么说。 (谁可以在一天之内抓取此博客,请告诉我。)

让我们从搜索引擎的情况开始。正如Google在文章中写道:

在线世界巨大;每时每刻都在产生新的内容。 Google自己的资源是有限的。当面对几乎无穷无尽的网络内容时,Googlebot只能找到并抓取一定比例的内容。然后,我们只能索引我们已抓取的部分内容。

URL就像网站和搜索引擎抓取工具之间的桥梁:为了能够抓取网站内容,抓取工具需要能够找到并跨越这些桥梁(即查找和抓取您的URL)

这段内容很好地概括了搜索引擎所面临的情况,那么抓取工具在处理URL时会遇到什么问题?

我们首先来看一下重复网址的问题。此处提到的重复URL指的是同一网站中的不同页面,并且有许多相同的URL。如:

还有这两页。

模板部分的URL相同

尽管页面不同,但其公共部分的URL地址相同。看来,如果不同的爬网程序对这些页面进行爬网,它们将重复进行爬网,从而浪费了很多不必要的时间。这确实是一个问题,但是基本上可以通过搜索引擎解决。实际上,抓取工具的抓取模式并不是我们所了解的那样,它在看到网页时就开始抓取。

采集器沿着URL逐个爬网Internet上的网页。它下载网页,同时提取网页中的链接。假设从搜索引擎的某个节点出来的采集器包括采集器A,采集器B和采集器C。当它们到达semyj的网站时,每个采集器将获取很多URL,然后它们将全部链接。都放置在公共的“待取清单”中。 (您可以使用lynx的在线版本来模拟采集器来提取链接。)

要获取的列表

通过这种方式,可以在“待爬网列表”中重复删除那些重复的URL。这是处于理想状态的节点的情况,但是实际上,由于搜索引擎将来会更新网页以及其他原因,因此网站每天仍然有很多重复的爬网。因此,在先前的文章中,我告诉您使用一些方法来减少重复爬网的机会。

这里有一个问题。许多人肯定想问一个网页上的所有链接是否都由搜索引擎提取。答案是肯定的。但是,“ Google 网站质量指南”中有一句话:“如果站点地图上的链接超过100个,则需要将站点地图拆分为多个网页。”有人将这句话解释为:“抓取者只能抓取前100个链接”,这是错误的。

由于“待爬网列表”中的URL,爬网程序将不会对每个链接进行爬网。可以将链接收录在此列表中,但是爬网程序没有太多时间,也不需要爬网每个链接。它需要具有一定的优先级。在“待访问列表”中,爬网程序将根据优先级来爬网一部分URL,同时记录尚未爬网的URL并等待下一次爬网,但是这些未爬网的URL是下一个爬网程序。每个网站的访问频率都不同,并且每种类型的URL的访问频率也都不同。

按优先级获取

那么,“要爬网列表”中的哪个URL可以首先被爬网,然后第二个URL可以被爬网?

如果我们稍加思考,便可以了解应如何设置此爬网优先级策略。首先,具有较高目录层次结构的那些URL是从属爬网的;模板部分中的内容或重复率非常高的网址是次要的;那些具有许多动态参数的URL会被次级检索。...。

其原因是搜索引擎的资源有限,网站的实际内容也有限,但是URL的数量不受限制。爬虫需要一些“线索”来确定哪些首先值得抓住,哪些不值得。

在“ Google搜索引擎入门指南”中,Google建议优化网站的URL结构。例如,建议不要使用“ ... / dir1 / dir2 / dir3 / dir4 / dir5 / dir6 / page.html”多层嵌套。这是因为在要爬网的列表中,如果其他条件相同,则爬网程序将优先爬网具有浅目录层次结构的URL。如果您使用Lynx在线版本查看此网站的页面,则:

获取优先级

如果我们说这17个链接中,抓取工具只能选择要抓取的几个链接,则在其他条件相同的情况下,红色箭头指向的链接将具有优先级。

但是这里还有另一个误解。有些人在SEO过程中将所有网页设置在根目录中,以为这样做将具有排名优势。这也无法理解原因。此外,采集器在此网站上搜寻的URL是其自己的URL与自己的URL的比率。如果所有网页都在同一目录中,则没有区别。

计划URL目录层次结构的最佳方法是根据业务方面的逻辑进行计划,并根据内容的隶属关系进行URL计划。就像“ Google搜索引擎入门指南”中的示例一样。

(顺便说一句。我经常在网站中看到很多非SEO的人,例如工程师和网页设计师或网站编辑器,都认为SEO与他们的工作相反。这是因为很长一段时间以来,一些SEO经常向他们提交许多SEO要求,这些要求明显违反了用户体验,导致他们认为SEO与他们所做的事情存在冲突,实际上,SEO与其他部门之间的冲突很少。可以使用科学的方法进行实践,您会发现过去存在太多误导性意见。此外,对于其他部门的专业人员,他们的专业领域意见也值得考虑。)

采集器的一个特征是它无法实时比较它所搜寻的内容是否为重复内容。因为如果要进行实时比较,它必须至少将要爬网的页面与索引库中已经存在的页面进行比较,而这在短时间内无法完成。以前的将所有URL放入要爬网的列表的方法只能避免完全相同的URL的重复爬网,但是它不能处理具有不同URL但内容相同的爬网。

正如所有搜索引擎所强调的那样,动态参数是URL不同但内容相同的常见原因。因此,搜索引擎建议您使用静态方法删除这些参数。静态化的本质是URL唯一性。在“ 网站爬网和收录的优化”的文章中,“一人一票”的描述用来恰当地表达这一点。静态仅仅是手段,而不是目的。为确保网址的唯一性,您可以将网址设为静态,使用robots.txt或nofollow阻止动态内容,使用rel = canonical属性,并阻止网站站长工具中的某些参数。还有更多

好的静态和坏的静态之间也有区别。在这里,我们将不讨论直接静态化多个参数的情况,而只是看一下以下两个URL:

然后? p = 1097

在这两个URL中,静态URL比动态URL好吗?实际上,两个URL之间的差异很小。首先,这两个URL搜索引擎可以收录。如果动态URL“?p = 1097”可能生成大量重复内容供爬网程序进行爬网,则不能保证此静态URL“ archives / 1097”。很多重复的内容。尤其是当爬网程序在爬网过程中遇到大量具有ID的静态URL时,爬网程序无法确定此网站是由静态化会话ID和其他参数引起的,还是该网站最初具有这么多的内容。 。所以更好的静态是这样的:

这种URL可以保证唯一性,并且不会与其他情况混淆,因此请尝试在URL中使用有意义的字符。这样做不是为了增加URL中的关键词密度,而是为了方便搜索引擎进行爬网。

以上是由爬行器的固有特性引起的爬行障碍,有时网站的结构也会引起爬行障碍。在“ 网站 Grabbing and 收录的优化”一文中,此结构被命名为“无限空间”。本文提供了一个日历示例:例如,许多博客上都有一个日历,您将始终单击该日历的日期。因为时间是无限的,所以总是会有链接供您单击。

实际上,“无限空间”的示例更多,但是术语“无限空间”的翻译不正确。将翻译理解为“无限循环”更为容易。举个例子:

JD Mall笔记本分类页面:

过滤条件

当您单击“ HP” +“ 11英寸”这两个条件时,可以显示一个页面,您可以单击“ Lenovo” +“ 14英寸” +“离散图形卡”显示一个页面。总共可以显示几页?

在此页面上,有18个品牌的类别,9个价格类别,7个尺寸类别,3个平台类别和2个图形卡类别。那么可以合并的URL数量是:

按1个条件过滤:18 + 9 + 7 + 3 + 2 = 39。

按2个条件过滤:18×9 + 18×7 + 18×3 + 18×2 + 9×7 + 9×3 + 9×2 + 7×3 + 7×2 + 3×2 = 527。

按3个条件过滤:18×9×7 + 18×9×3 + 18×9×2 + 18×7×3 + 18×7×2 + 18×3×2 + 9×7×3 + 9×7×2 + 9×3×2 + 7×3×2 = 3093。

按4个条件过滤:18×9×7×3 + 18×9×7×2 + 18×7×3×2 + 18×9×3×2 + 9×7×3×2 = 7776。

按5个条件过滤:18×9×7×3×2 = 6804。

可以合并的URL总数为:39 + 527 + 3093 + 7776 + 6804 = 18239。

笔记本类别中只有624个产品,需要放置在18,239页上,对于某些页面,一页可以放置32个产品。这将不可避免地导致大量页面没有商品。例如,单击以下过滤条件后,将不会出现匹配的产品:

没有结果

其结果是爬虫大量重复内容和大量不必要的时间,这些时间也可以视为“无限空间”。这种情况非常普遍。如

房地产网络的无限空间

上述京东商城的例子不是很严重。某些网站可以组合成千上万甚至无尽的URL。我在*敏*感*词*看到过很多类似的东西网站,而我发现到目前为止只有两个网站注意到了这个问题。原因是许多SEO人员对数据的关注度不高。从对爬虫的日志的一些分析中可以看出这种问题。直到现在,仍然有一些SEO者认为将这些以前动态的页面静态化是一件好事。不好的一面是,此类操作已创建了大量重复的页面。就SEO而言,这一直是一个问题。好变化。