自动采集子系统|system+pythontelegraphwebautodetect采集,点击文章底部的链接

优采云 发布时间: 2022-07-25 05:03自动采集子系统|system+pythontelegraphwebautodetect采集,点击文章底部的链接

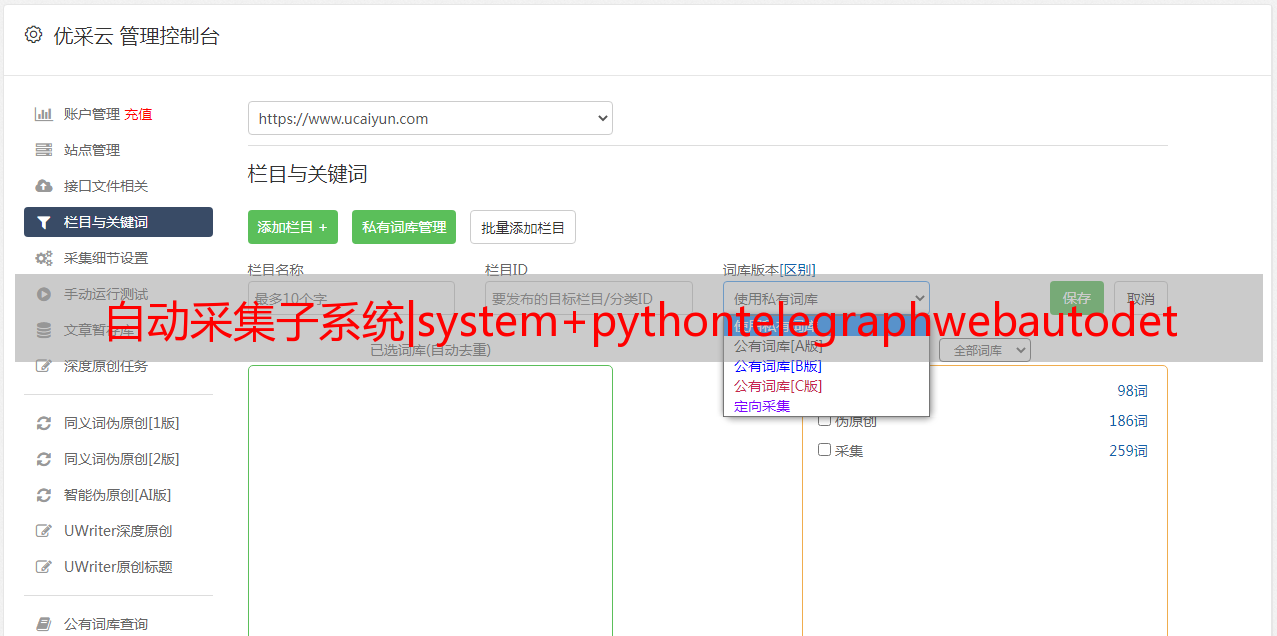

自动采集子系统discovery采集子系统|system也可使用pythontelegraphwebautodetect,但不算是一个必须的知识pythontelegraphwebautodetect一个在数据直接读取twitter、reddit等社交平台的网站实例请输入文章标题一步一步的学习:采集使用python实现任意内容的twitter、reddit采集,点击文章底部的链接,发现更多采集相关资料。

推荐我在知乎上回答的另一个问题,

我觉得像basecamp这种形式,然后还可以做成资源大集市,任何用户都可以随便发表一下自己关于这些平台的个人评论。

找到twitter用户的id然后用scrapy爬虫抓包收集就可以了-data-generator/

去engadget,收集页面地址,然后写循环,就可以遍历那些站点了。

爬过的网站很多,多数都是访问后就自动地直接跳转到twitter。谷歌自带爬虫(主要抓这个页面),但是初期爬的速度很慢,还是要手动找啊找。用到了djangotwitterspider,

我们刚开始也是先找到链接然后手动爬,后来发现很多链接都有网页正常跳转。比如第一张图,选择benefitaccount那一栏,如下图那页面已经就能正常的跳转到了twitter站点,没有后续的代码,所以就自己写了一个循环,内置blocks功能,在每次爬取下一页过程中会根据网页的需要把这一页blocks释放出来,到了下一页也不怕没有自动跳转了。

上图那个站点我是一直用beautifulsoup去抓取,针对这个情况把自动blocks.json里面每一个blocks都会有一个指向要抓取页面的链接,然后我们每次爬取一页就把int=1024这个值加进去,并且分成若干块,数据一定要定位好原始请求的一一对应位置。抓取下来的页面放进elasticsearch做为数据分析的入口,能用爬虫自动访问的站点一定有分析的价值,所以后续还是坚持用redis+scrapy实现自动爬取。同时我们也建了一个qq群,方便爬虫爬过的站点的地址查询。