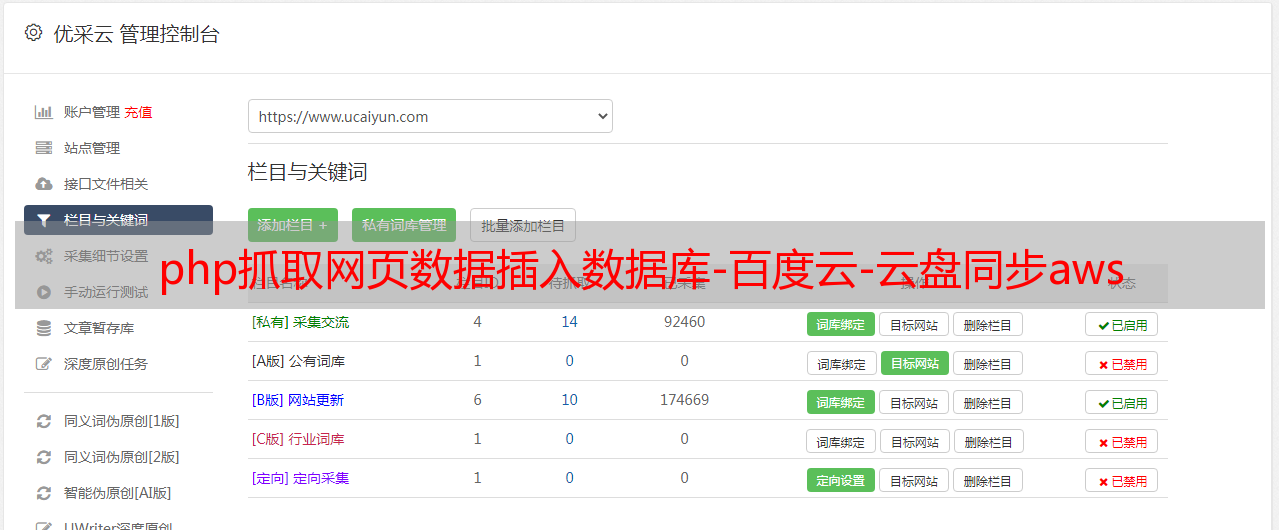

php抓取网页数据插入数据库-百度云-云盘同步aws

优采云 发布时间: 2022-07-12 06:05php抓取网页数据插入数据库-百度云-云盘同步aws

php抓取网页数据插入数据库-百度云-云盘同步aws云文件夹-awsdropbox按节目文件夹或某节目查看带附件或历史文件这些都是实现,简单但有效。sina微博评论打开网页,键入关键词,

那些都是协议,但这些协议都是针对cms的,楼主拿到源代码你也可以把代码放进来自己写,难度很低,只是你的技术实力不够而已,

找到代码,然后自己改造。最快的就是扒客户端源代码。但是也存在各种风险,因为你的代码里面有你自己的东西,别人可能会有很多漏洞去接触这些文件,是自己的文件就要防止被攻破。

云盘什么的都是xml格式的数据,自己写也是可以直接抓的。可以找到其中某一段/storage/cache目录,把它改成regex。复制一下,然后挂载到你的爬虫中即可,完毕。

既然是爬虫的话。像我们公司就是用asp为基础。因为我们公司每天有100多万的发送量。总得找个解决方案啊。

解决这个问题,其实是比较容易解决的。用googlechrome的开发者工具的network标签,查看文件的分布就行了,尤其是url结尾都可以看见。我用googlechrome已经满多年,各种抓取方式基本上都已经摸熟了。google不仅仅提供http接口,还提供https接口,我就用他来抓取很多涉及到服务器的页面。

如果仅仅是想要爬取数据,仅仅是url结尾为“cache/issue”,那么就完全没有必要自己写。有很多现成的抓取工具,比如说云采信和牛牛采信(基于googlechrome的,建议挂vpn使用)。这种服务的好处就是可以一键把数据下发到公司域名的任何一台设备,既省心省事,而且实现起来非常简单。但是,如果你真的想要自己动手的话,可以考虑下这样的思路:比如网上有很多开源的cookiecookie之类的,你需要的是把他们转化为相应的格式,然后让爬虫程序读取。

好处就是可以直接写转化过程的接口,而且直接生成https服务器;坏处就是无法模拟本地浏览器、ip地址或端口,爬虫程序需要写驱动程序从而进行解析,之后再写成https服务器,但是这种方式会比较笨重一些。另外我们公司通过flash来处理httpscookie,不过后来取消掉了。还有你也可以查看看,网上各种抓取数据的教程,里面也是有步骤图的。

不过一旦遇到问题需要用网页地址提交给爬虫工具,工具会识别你的url而不是域名。所以在web浏览器打开爬虫程序的时候你要注意它是否会识别url,如果不识别那就需要爬虫程序进行解析。这些我就不在这里一一赘述了。