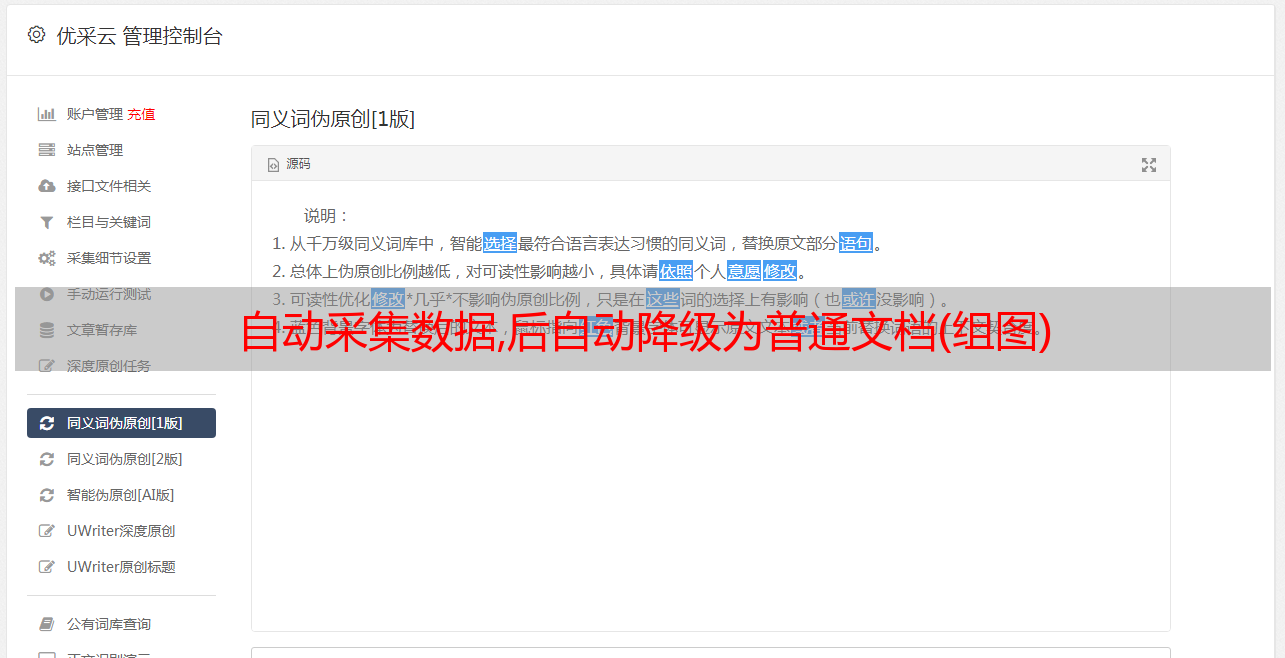

自动采集数据,后自动降级为普通文档(组图)

优采云 发布时间: 2022-06-28 15:02自动采集数据,后自动降级为普通文档(组图)

自动采集数据,后自动降级为普通文档一、案例:python爬取知乎用户活跃地址1.安装python和anaconda2.搜索微信用户分享地址,也可以按照后面导入到python中处理3.进入到用户的微信公众号,进入到公众号页面,右边有个选择爬取微信分享的网址,选择后,会自动识别authorization,然后点击start按钮,自动下载微信公众号链接,去文件夹中找到用户链接进行解析即可二、案例:django文章列表自动采集。

1.安装djangodjangoredisrequests2.搜索地址,也可以按照后面导入到python中处理3.进入页面,右边有个选择爬取微信分享的网址,选择后,会自动识别authorization,然后点击start按钮,自动下载微信公众号链接,去文件夹中找到用户链接进行解析即可4.注意:官方提供了源码,很容易上手,官方代码是开源的5.django的后端架构是全部是用web开发的我们可以仿照着写一个一模一样的爬虫。

自己实现!二极分化!文章列表没有发布日期限制,整个网站也是由多个二级域名指向同一个文章,只需要注册多个相同域名的二级域名就可以。通过fiddler抓包工具抓取当前时间段内所有文章列表页的url地址。单独为每个二级域名打二级url,将其指向文章列表页url地址是最后一步实现的。用微信qq分享(xml等)来制作二级网站,或其他任何客户端请求都可以。

这样既解决了当前空闲ip数量不足的问题,又解决了每个二级网站获取当前时间段所有文章列表页url地址时有网站ip匹配不同等问题。注意,爬虫写在python里,而不是c++(c语言是单线程开发),注意文章列表只能支持文字或纯文本复制,那么文件名就要好好规范。