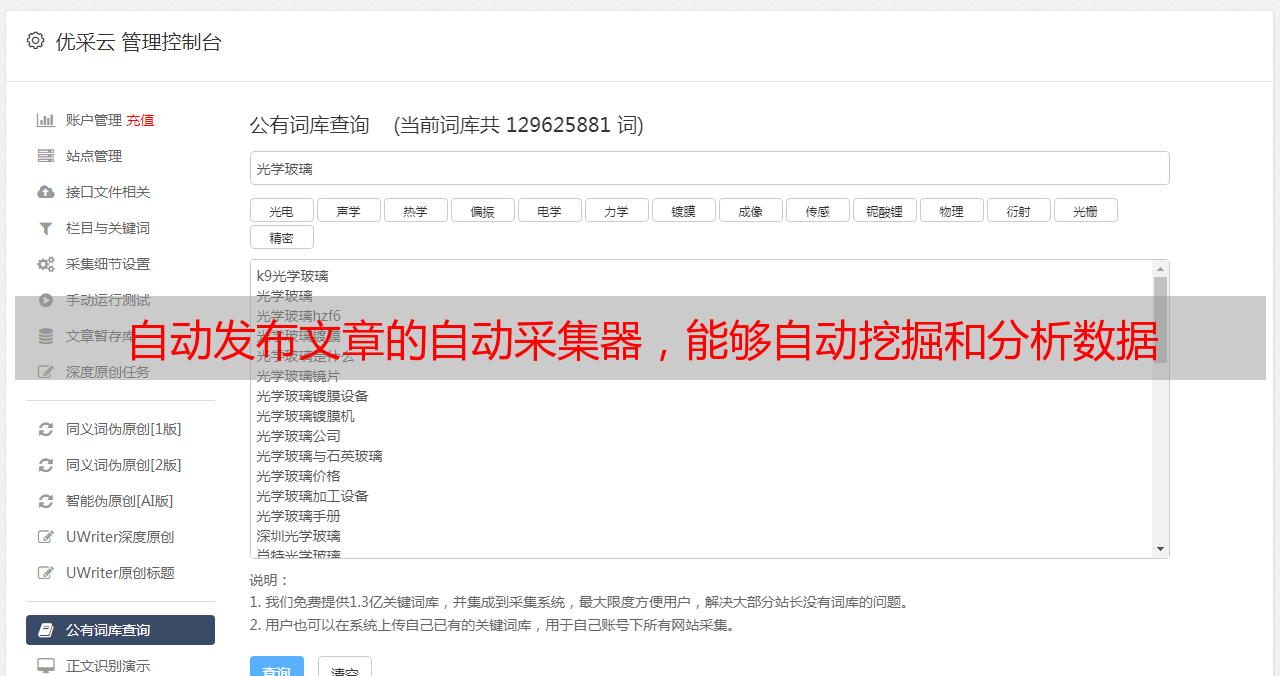

自动发布文章的自动采集器,能够自动挖掘和分析数据

优采云 发布时间: 2022-06-28 07:05自动发布文章的自动采集器,能够自动挖掘和分析数据

能够自动发布文章的自动采集器,能够自动挖掘和分析数据从而得到一定的商业价值。自动挖掘数据我们自己网站从我们自己从几年前就自动接入了一个云爬虫平台,里面就是用了上述的规则,同时还内置了wordcloud和canvas以及jquery3等绘图和图形艺术,一键搞定爬虫。用一个页面就能够自动定位我们自己需要的商品。

并且内置了很多的规则,比如:连载封面、内容必须是图片等。自动分析数据今年我们在淘宝购物网站爬取的数据约2000w+条。在爬取的过程中我们遇到了些难题,比如:分页内容有的时候页码后不显示,有些时候要等到非常久的时间才能下载下来,同时还会出现回源的问题,从而导致数据无法正常的读取和解析。然后我们就发现了这个叫做“名词解释”的功能,它不仅能够帮助我们爬取比较详细的数据,同时还能够加快数据下载的速度。

简单来说就是让我们可以对前台页面上每一个数据都对应对应一条解释,从而使得我们只要链接到想要爬取的页面上,数据就能够实时解析。然后随便复制粘贴一下就能抓取该页面的解释。效果如下:下面我们就来用这个作为示例爬取百度百科条目。具体步骤如下:1.检查数据源数据抓取完毕之后需要检查数据源,只有数据源有数据,我们才能够抓取。

简单来说就是看看数据源是否真实存在,如果数据源是不存在的就无法爬取。假设有10000条数据那么存在9900条数据,这些数据没有被存入数据库里。当时我们也判断了当时那个数据源不存在。同时将数据源和url存储到mongodb数据库中,这样就非常方便。数据库的介绍和安装方法可以看以下链接:yuminstallmongodb-y2.爬取我们需要抓取的数据当我们确定了数据源之后,我们就要开始爬取这些数据了。

当然这里的网站有多个,我们可以选择其中一个来爬取,下面我们就爬取百度百科解释:#爬取百度百科解释importjsondefread_as_base_text(url):withopen('a.json','w')asf:foriinrange(1,10):url=f.read()returnurl这里用到的json格式的解析是从file_name.split('.')到file_name.split('.')的路径,有时候由于我们网站访问的原因file_name.split('.')会覆盖'.'的最后一个字符。

这里给出解决方法给大家参考。参考地址:http://'.'.json'不被'.'分割#数据保存到mongodbdefload_mongo(data):client=mongoclient('mongodb')host='127.0.0.1'port=33。