网站被挂垃圾外链以及大量站内搜索被消耗bot抓取预算?怎么办?

优采云 发布时间: 2022-05-24 03:20网站被挂垃圾外链以及大量站内搜索被消耗bot抓取预算?怎么办?

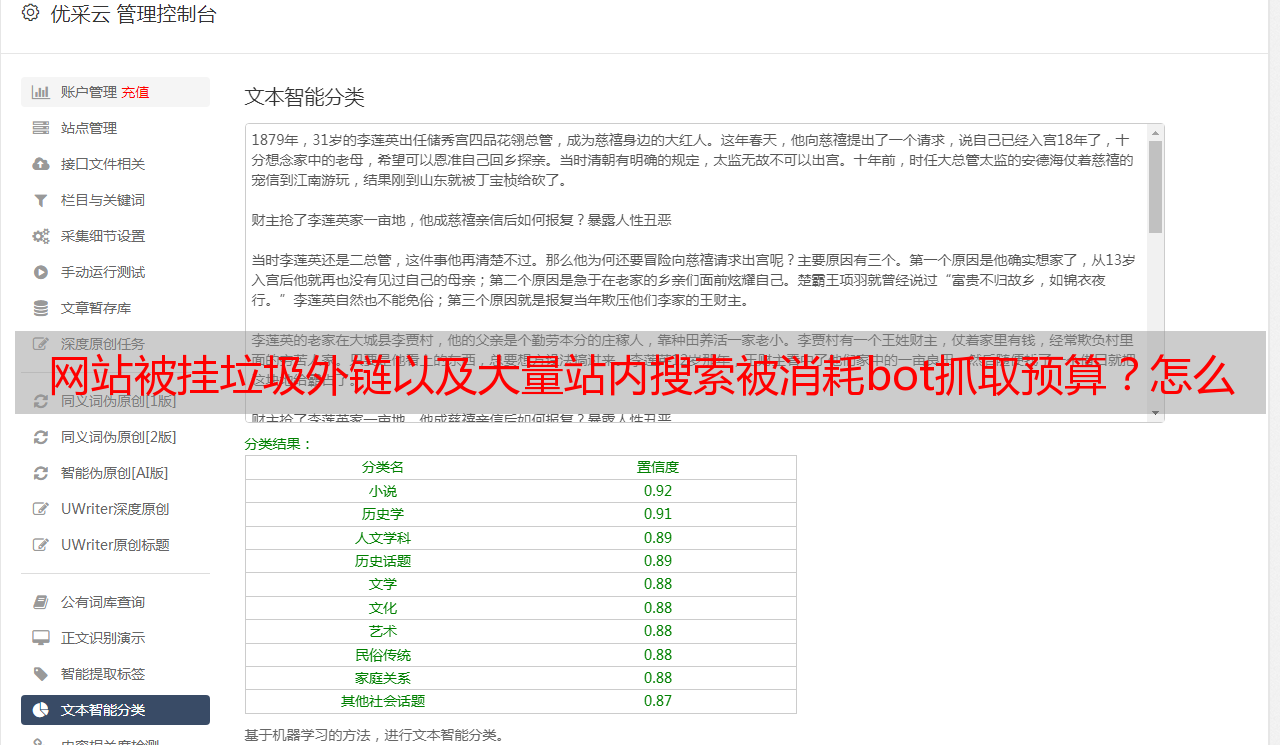

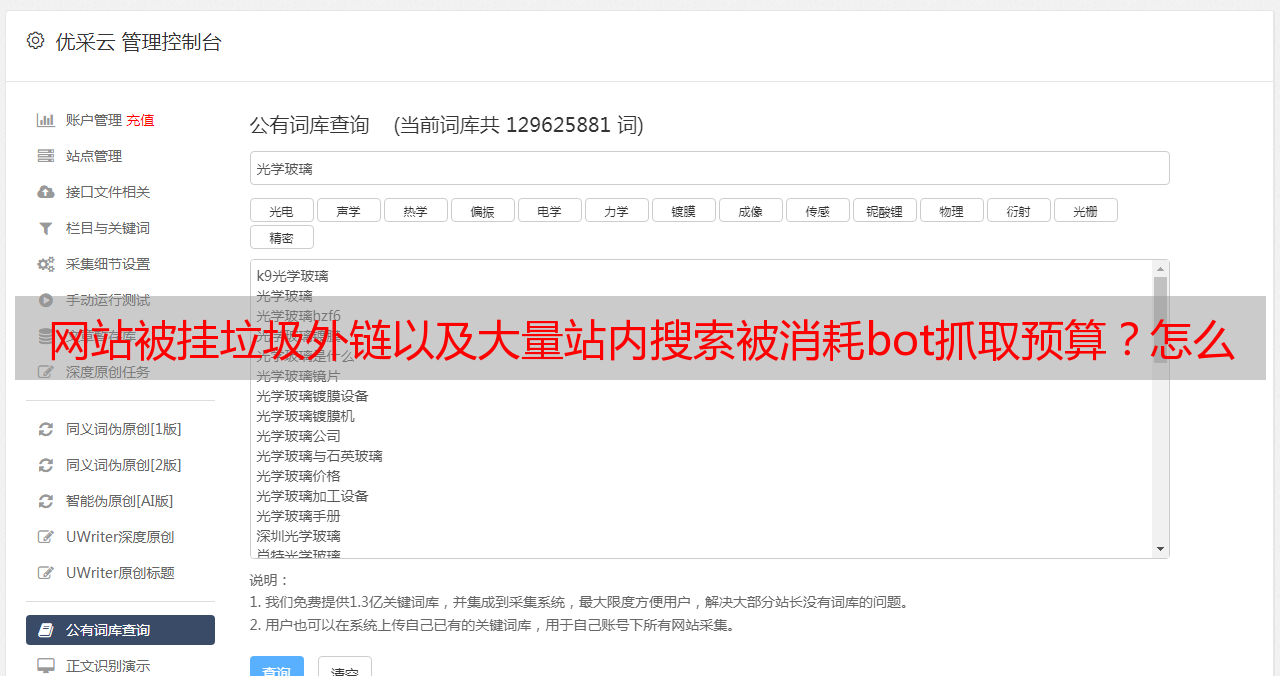

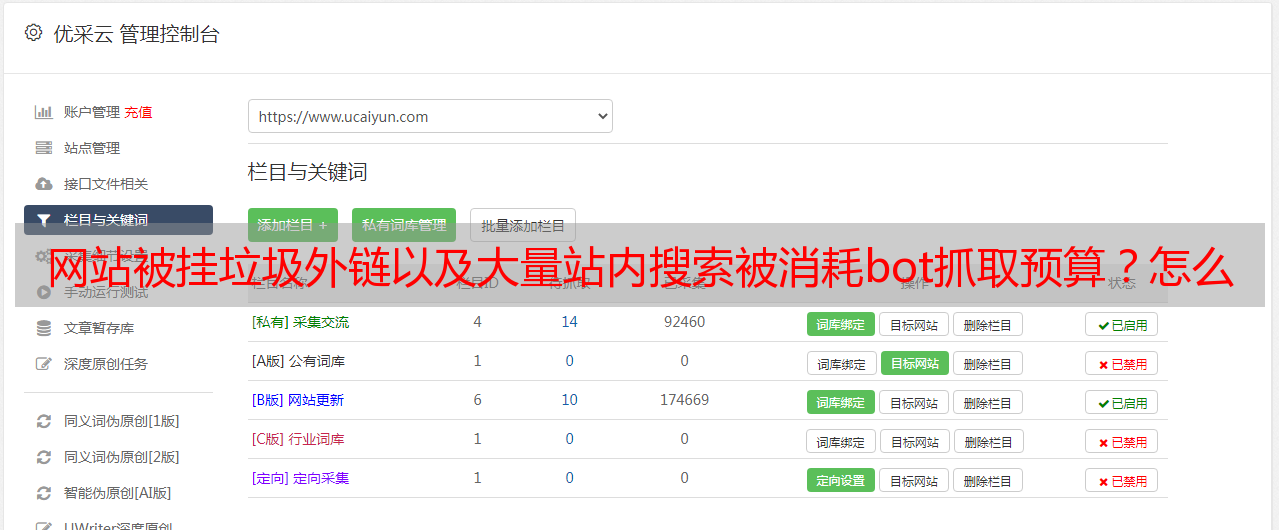

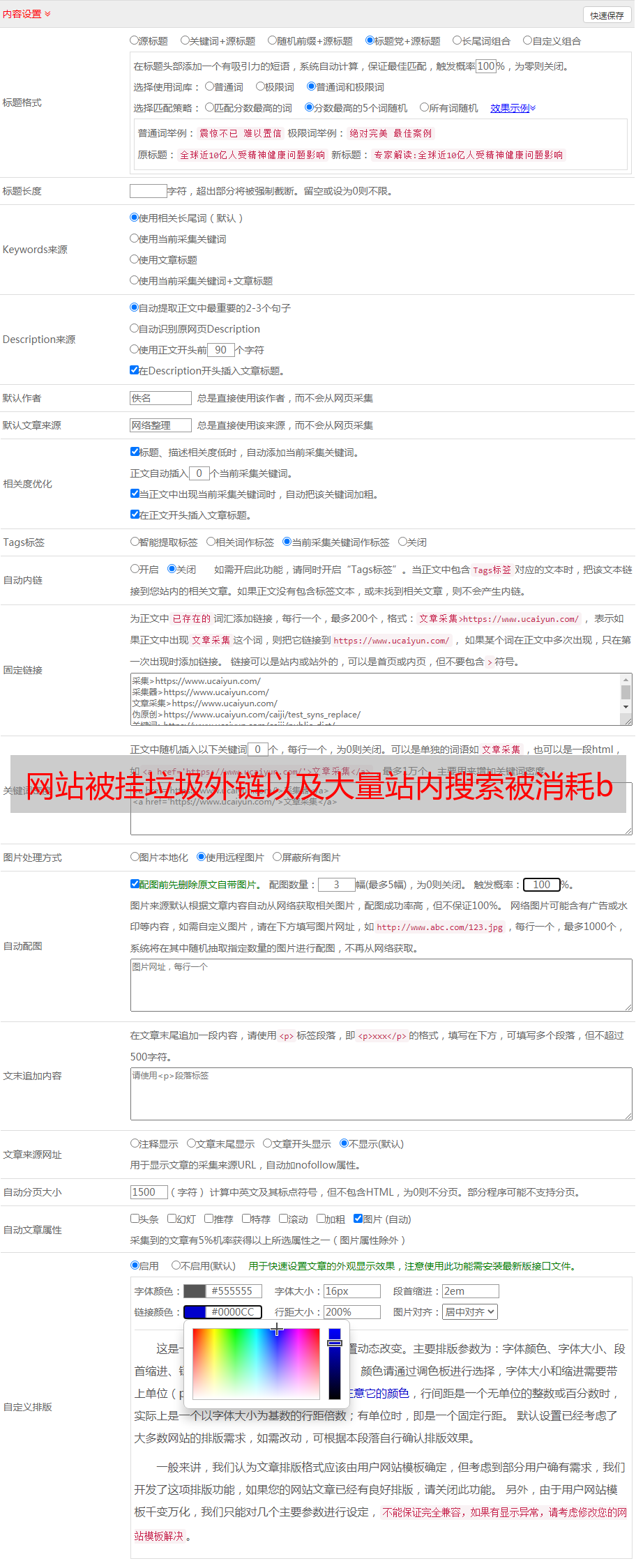

最近网站被挂垃圾外链以及大量站内搜索被消耗bot抓取预算,导致了一系列的错误和警告,如下图。以前觉得seo就是关键词,内容,用户体验度,外链等,但是其实做网站的时候,我们还需要来维护网站的健康成长。一起来看看Nina站长被挂垃圾外链以及站内搜索页面大量增多的网站问题,以及如何解决。

这是我被挂垃圾外链之后,处理后的状态,这已经是慢慢恢复的状态了。之前更惨。所以大家一定要定期查看GSC的数据。(心酸-(,,•﹏•,,))

接下来一个个查看,并且解决问题吧!

先来看看网站错误有:重定向错误,服务器错误。

这里我们能看到这里的错误链接都是包含了“?s=”以及“search/”, 打开看看,能发现这些都是站内搜索结果页面,也就是网站的搜索框搜索之后的页面。而链接中“?s=”以及“/search/”链接之后的内容就是搜索内容,我这些搜索内容里面还包含了网站链接,进去之后就是*敏*感*词*之类的你懂得网站。

至于为什么会定为重定向错误,在下也不知。我查看浏览器只发现204状态,没发现301.

服务器错误

如下图所示,也是站内搜索结果页面。两个错误都是搜索结果页面造成的,那么就要解决搜索框滥用的问题。

以抓取-尚未索引

大量的搜索结果页面,会消耗我们网站的BOT抓取预算,导致真正有内容有价值的页面抓取缓慢,甚至不被抓取。

检查到问题,那么解决方案来了。

我写了个robots.txt上传到网站的根目录来屏蔽搜索引擎对站内搜索页面的抓取:

代码如下:

User-agent:*

Disallow:/*?s=*

Disallow:/*search/*

这个代码是用来屏蔽搜索引擎抓取所有带"?s=”以及“search/"的链接页面。

(在自动抓取过程中,Google 的抓取工具会发现你对 robots.txt 文件所做的更改,并每 24 小时更新一次缓存的版本。如果你不相等的话,可以用robots.txt测试工具提交,加快这个进程。工具提交链接:)

方法行之有效,测试有效,而且我看到以抓取-尚未索引的页面在一天天慢慢减少。

但是。。。。。。。

过了两天,我再次查看GSC后台,出现了警告:已编入索引,尽管遭到robots.txt屏蔽。

我看了下也就是说robots.txt屏蔽的情况下,有12条链接从其他入口被索引进来了。

于是我点击链接右侧的搜索框,在GSC查询入口,一个个的查,查到一些网址。这个就是垃圾外链了,而它链接到我的网站的页面,就是那些站内搜索结果页面。(即消耗我的抓取预算,又利用我的搜索框引导bot去他的网站)

知道了垃圾外链的网址,我就要开始提交外链移除。在谷歌提交移除外链的链接是:

用谷歌账号登录,选择自己的网站资源,然后写好需要向谷歌需要移除的外链,保存在txt文档,上传即可。生效时间似乎是几周,时常关注,等待即可。