【研究池】通过自动OSINT打击人口贩运采集、验证和融合

优采云 发布时间: 2022-05-09 05:23【研究池】通过自动OSINT打击人口贩运采集、验证和融合

目录

摘要一. 简介二.背景介绍三. 相关工作四. 方法论 4.1 新闻爬虫 4.2 KeyBERT和搜索短语 4.3 使用谷歌新闻SRS进行新闻抓取 4.4 新闻相似性检查器 4.5 新闻关联性检查器 4.6 信息提取器 4.7 文本过滤器 4.8 问题和动态问题 4.9 挑战五. 实验设置

5.1 新闻爬虫的设置 5.2 信息提取模型设置 5.3 评估方法六.结果和讨论七. 结论

//摘要//

打击全球人口贩运,我们所面临的主要挑战之一是如何获得与贩运事件和行动相关的可执行情报?在监测和减少人口贩运方面,缺乏及时和结构化的数据仍然是我们遇到的最大瓶颈之一。

本文旨在通过开发一个基于自然语言处理和机器学习最新进展的自动管道来解决这个问题,以简化策划、分析和从多源新闻媒体中提取可执行情报的工作。在我们的解决方案中,我们使用且加强了BERT问答语言模型,从新闻的非结构化文本中提取信息。

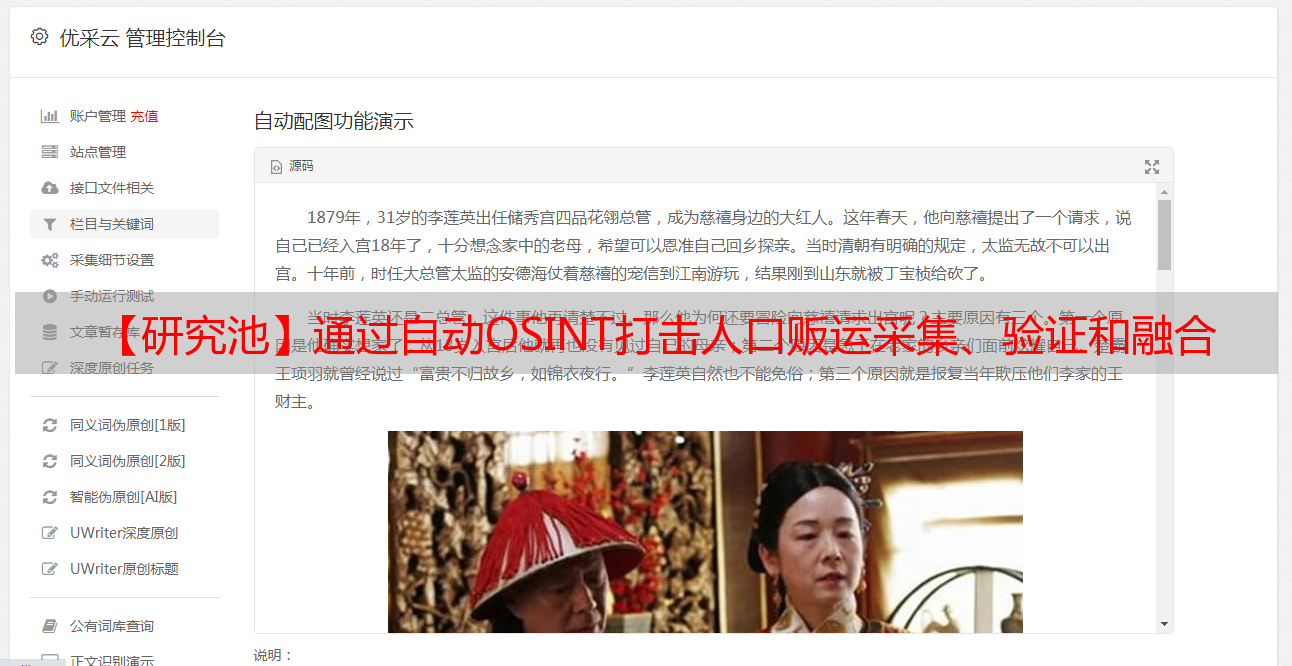

图源:摄图网可商用图片

此外,我们还开发了用以衡量策划的新闻文章的相关性和新颖性的算法,以减少计算成本和冗余处理。另外在包含人口贩运受害者和*敏*感*词*者的可执行情报的注释新闻文章数据集上评估了拟议的通道。

1. 简介

人口贩运一直都是一个普遍存在的问题,影响着全球成千上万的人。2017年,国际劳工组织(ILO)估计全球人口贩运受害者的数量为4030万人。

近年来,人口贩运活动的规模仍在飞速增长,2018-2019年可能还增长了20%(根据北极星项目数据)。人口贩运问题影响到世界各地的男性、女性及儿童。

人口贩运的受害者面临不同种类的剥削,如性剥削、强迫劳动、奴役,儿童被用作童工、童养媳或被迫乞讨。国际劳工组织报告指明每年由强迫劳动和性剥削等牟利的收入高达1,500亿美元,这意味着人口贩运是一个全球性的巨大问题,它将不断滋生,除非问题得到彻底解决。

国际政府组织(IGO)、非政府组织(NGO)和联合国已经联合起来,在国际、国家和地方层面分别打击人口贩运。政府和和政策制定者对人口贩运有严格的规则和政策,起诉贩运者并为幸存者提供保护和康复服务。但这也导致了人口贩运行业变得更加隐蔽、难以识别。

在识别和打击人口贩运方面,存在着不同的挑战。人口贩子为了避免被发现,不断变换作案手法与模式,包括改变公告网站、电话号码、运输方式等等;人贩子还通过威胁、暴力和药物滥用等不同手段限制受害者的社会交往。这种隐蔽性导致全面数据的缺乏,也变成了一种挑战。

全面的数据在打击人口贩运方面发挥着重要作用。数据及其分析将使参与打击人口贩运的实体可以深入了解人口贩运活动的趋势和规模,以及关于贩运者所使用的方法的信息,包括受害者是如何被引诱、捕获和剥削的,从而能够制定出打击人口贩运的新策略。

政府实体和非政府组织在社区层面开展工作,从多种来源收集数据,如电话、电子邮件、网络应用程序等多种来源的数据,这些数据具有非结构化和异质性的特点。

然而,这些利益相关者所收集的情报通常只限于某些地方,而且是零散的、互不关联的,因为这些组织为其内部目的收集数据,并且不愿意分享这些数据,可能是出于对数据隐私问题、数据信用问题以及数据使用目的等方面的考虑。

因此,缺乏全面的数据使得分析和研究变得困难。

为了在全球范围内获得洞察与情报,一个有望的解决方案是利用网络上的可用数据,如社交媒体、各地方报纸、论坛、博客和其他相关网站。特别是新闻媒体的文章和可提供贩运人口事件相关信息,包括在当地和国际层面的信息,也就是在互联网海量信息中挖掘有价值的情报信息,这也就体现了开源情报在打击人口贩卖中发挥着重要的作用。

相关信息可以查看福韵君之前发布的文章《人口贩卖2.0时代,开源情报如何打击罪恶?》,点击下方图片即可阅读。

这些新闻报道可能包含一些如受害者或*敏*感*词*嫌疑人的详细履历,以及与贩运行动相关的信息,包括受害者是如何被引诱的,是什么让受害者迁移的,迁移的方式,*敏*感*词*嫌疑人是否被捕,剥削手段等等。

然而,这一过程存在一个重要瓶颈,即人类调查员在整理和分析这些来源时,无法在全球范围内从这些来源中生成及时的可执行情报。

为了在全球范围内创建和共享这些数据,已经有人采取了一些措施。反人口贩运数据协作网(Counter-Trafficking Data Collaborative)是一个从世界各地的组织收集的全球数据集。然而,该数据集也并不及时,也没有提供关于受害者和嫌疑人的信息。

国家失踪与被剥削儿童中心(ICMEC)负责维护全球失踪儿童相关数据。ICMEC的数据只包含儿童的信息,而不包含*敏*感*词*的信息。这些数据也只是从有限的几个国家收集而来。目前缺乏现成的、及时的、更全面的最新数据。

因此,目前这一领域的工作还包括努力收集人口贩运相关数据。(Brewster, Ingle, and Rankin2014)提出了一个抓取开源数据的框架,以获取人口贩运的信息和指标,并促进对指标的检测和分析。

(Hundman et al.2017)提出了一个端到端的跟踪检测管道,通过抓取网络上的性服务广告用于多模式数据源。(Tong et al. 2017)策划了一个由10,000个注释广告组成的数据集。

总的来说,这一领域之前的工作大多集中在从特定环境中识别人口贩运的指标,因此,从非结构化和通用的新闻文章中提取情报的问题还没有解决。想要满足对该领域信息提取完全自动化过程的需求,也存在很大的现实差距。

在这项与“爱正义国际”(Love Justice International,简称LJI,非营利组织)的合作工作中,我们旨在通过利用自然语言处理和无监督的机器学习方法来解决上述问题,以创建一个完全自动化的管道,用于策划、分析和提取有关人口贩运事件的情报。

我们开发了一个自动化OSINT收集器,从新闻媒体中收集原始的多源情报,并利用BERT问答语言模型进行信息提取,以产生可执行情报。LJI使用可执行情报来监测和确定贩运人口活动的趋势和模式,用于缓解和政策的目的,并为人口贩运受害者提供支持。

我们还开发了测量文件相似性和相关性的算法,以进一步改善拟议管道的计算成本,提高准确性。本文的主要贡献如下:

2. 背景介绍

人口贩运中的OSINT收集情报是指从公开来源中提取的情报。这些来源可以是网站、新闻平台、博客、政府和非政府组织的报告、学术论文,也可以是其他来源。OSINT不仅在学术界,而且在许多执法机构中也很流行。

分析大量数字取证数据的优势在于,它可能包含不同数据源中的*敏*感*词*相关信息(Quick andChoo 2018)。*敏*感*词*的可执行情报将帮助决策者独立、公正地做出决策(Gibson 2004)。

OSINT收集一直是是利用机器学习打击人口贩运活动的关键步骤。在DARPA MEMEX计划中,研究人员收集了数以亿计的在线性服务广告,这成为许多研究人员在在线广告中寻找人口贩运指标的资源。同样,Trafficking-10K数据集(Tong et al. 2017)也是OSINT收集的例子。

DARPA MEMEX计划:今天的网络搜索使用一种集中的、一刀切的方法,该方法使用相同的工具集搜索 Internet 以进行所有查询。尽管该模型在商业上取得了巨大成功,但它不适用于许多政府用例。

例如,它仍然是一个很大程度上手动的过程,不保存会话,需要一次输入几乎精确的关键词,并且不组织或汇总链接列表之外的结果。此外,常见的搜索操作会遗漏深层网络中的信息即标准商业搜索引擎未索引的网络部分,并忽略跨页面的共享内容。为了帮助克服这些挑战,DARPA 启动了 Memex 计划。

Memex 寻求开发能够使在线搜索功能远远超出当前技术水平的软件。目标是发明更好的信息交互和共享方法,以便用户可以快速彻底地组织和搜索与其个人兴趣相关的信息子集。该计划中开发的技术将为改进的内容发现、信息提取、信息检索、用户协作和其他关键搜索功能提供机制。(译者注释,参考darpa.mil/program/memex)

BERT语言模型 来自转化器的双向编码器表示法(BERT)(Devlin et al,2018),是一个最先进的单词表示模型,它使用一个转化器来学习文本之间的上下文关系,给定的文本以双向的方式(即从左到右)。BERT的双向性使它在许多NLP任务中得到了应用,因为它改善了基于微调的方法来完成标记级别的任务。

BERT在训练中使用两种策略训练,第一种是遮蔽语言模型(MLM)。第二个是下句预测(NSP)。在MLM中,模型随机地掩盖了输入文本中的一些标记,然后模型就会试着把这些标记从输入文本中删除。

然后模型试图预测被掩盖的词的词汇ID,它是通过对上下文的双向考察来实现的。至于下一个句子的预测,则是将成对的句子输入,它试图预测给定的第二个句子是否是第一个句子的延续。该模型在训练过程中同时使用MLM和NSP来最小化损失。BERT可以被修改以执行许多下游的任务,如分类、问题回答、总结、句子预测等等。

问题回答的BERT变压器是BERT模,BERT可以通过输入特定任务的输入和输出而被修改以执行许多下游任务。对于问题回答任务如SQuAD(Rajpurkar等人,2016),它在隐性状态输出的基础上有一个跨度分类,以计算跨度开始对数和结束对数的变换器。

HuggingFace7的转化器在SQuAD(Rajpurkar et al. 2016)上进行了预训练。BERT QA模型需要两个输入,一个问题和一个包含答案的参考文本,问题和参考文本由[SEP]标记分开,BERT还利用 "片段嵌入 "来区分问题和参考文本。

而这些嵌入是通过转化器学习的,它在输入层之前将转化器添加到标记嵌入中。BERT问题回答模型的输出是简单地强调从开始标记到结束标记的参考文本的跨度。这是由模型找到开始标记和结束标记来实现的。

文本中所有令牌的最终嵌入被送入开始标记分类器。开始标记分类器对每一个词都使用一组权重,并在起始权重和输出权重之间取点积。在开始权重和输出嵌入之间取点积,然后用软键激活法应用。

软键激活的最终概率分布给出了具有以下特征的词最高的概率分布,然后被选为作为起始标记。同样的过程也被重复用于终点用一个单独的权重向量对结束标记重复同样的过程。用于问题回答的BERT是BERT-Large模型,它有24层,嵌入大小为1024,总共有4个。嵌入大小为1024,总共有340个参数。

3. 相关工作

机器学习、计算机视觉和自然处理方面的突破对开发打击人口贩运的工具产生了重大影响。自然处理的突破,对开发打击人口贩运的工具产生了重大影响。(Tong et al. 2017)设计了一个深度多模态模型,称为人口贩运深度网络(HTDN),用于检测Trafficking-10K数据集中的人口贩运广告。

Trafficking-10K数据集是作者的贡献,是第一个用于检测人口贩运的注释数据集。(Zhu, Li,and Jones 2019)开发并扩展了HTDN,该工具可以学习*敏*感*词*服务广告中的语言结构来检测人口贩运广告,该工具还可以自动识别疑似性贩运广告中的关键词,即使广告是用模糊语言写成的。

当广告是用混淆技术写的时候。作者取得了0.696的F1分数,并将他们的工具应用于检测人口贩运组织。旗帜(FlagIt)(Kejriwal等人,2017)是另一个用于指标挖掘的工具,被200多个执法机构广泛使用,寻找人口贩运的五个指标。

FlagIt代表了从文本中灵活和适应性地生成指标,它基于监督机器学习和无监督的文本嵌入,以及半监督的启发式的重新标记,用于发现网络中的指标,这些指标可用于线索生成和线索调查。

(Mensikovaand Mattmann 2017)训练了二元和多类情感模型,用于识别使用护送人员的人口贩运。从开放网络上抓取的评论数据来识别人口贩运。我们可以看到,大多数工作都与识别人口贩运或寻找人口贩运指标有关。

我们可以看到,大多数工作都与识别人口贩运或寻找人口贩运的指标有关。我们的工作主要集中在开发自动化管道,用于提取OSINT,以防止社区层面的人口贩运。

(Shi and Lin 2019)展示了使用BERT-base模型进行关系提取和语义角色标注。关系提取的任务是预测两个实体之间是否存在关系。作者表明预先训练好的BERT可以用于关系提取,而不需依赖于词法或句法特征。(Yang et al. 2019)。

将BERT与开源的Anserni检索工具箱一起使用以端到端方式从维基百科文章的大型语料库中识别答案。(Yang, Zhang, and Lin 2019)使用BERT来改进临时文档检索。

作者还解决了处理比BERT设计的输入长度更长的文件的问题。作者将每个句子单独送入模型然后汇总句子的分数以产生文档的分数。这些相关的工作与我们的研究项目的目标相似。所以为了从文件中提取信息,我们使用了BERT语言模型。

4.方法论

建议的解决方案由两个主要部分组成,即新闻爬行器和信息提取器。本节提供了这两个组件的技术细节,以及相应的流程。

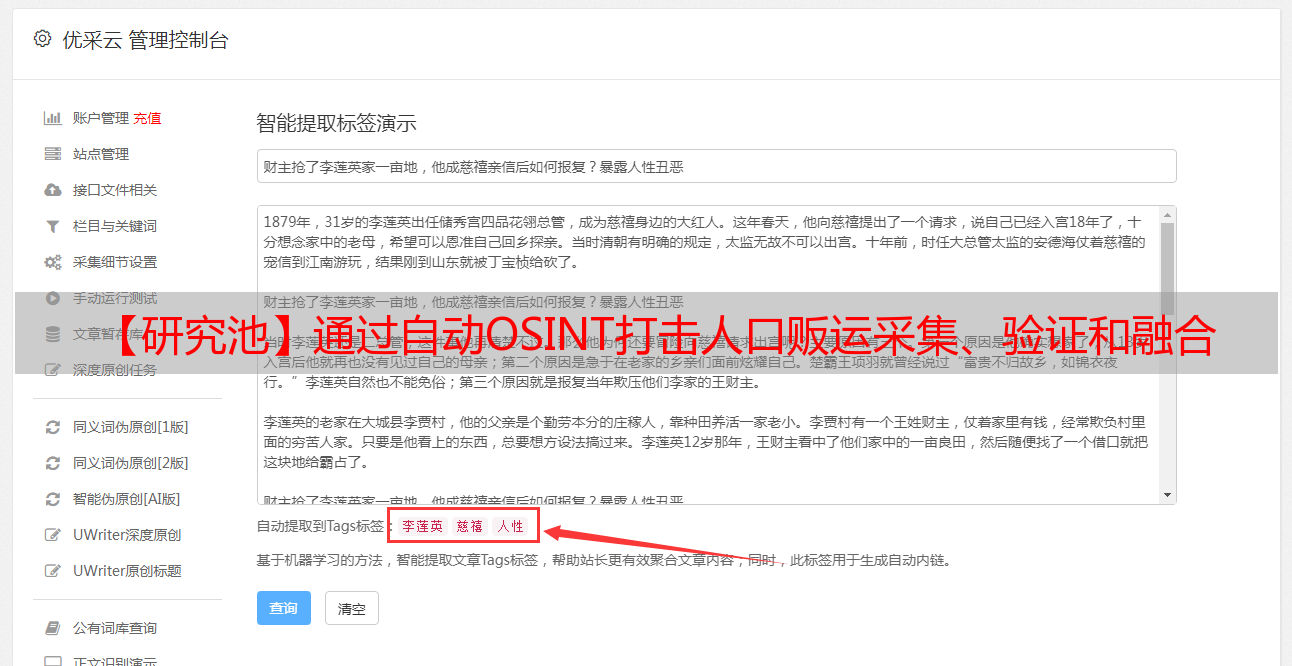

新闻爬虫

新闻爬虫是一个旨在从网上抓取新闻的应用程序。在我们的解决方案中,这个组件的目标是在网络上搜索与人口贩运有关的新闻文章,并包含有关受害者或嫌疑人的可操作情报的新闻文章。

新闻爬虫的程序流程如图1所示。新闻爬虫使用谷歌新闻API搜索新闻,并将新闻存储到MongoDB数据库中。然后,策划的文章被传递给新闻相似性检查器,在那里类似和重复的文章被删除。然后,剩余的文章被传递给新闻相关性检查器,该检查器过滤掉非相关的文章,并将剩余的文件更新到MongoDB数据库中。

爬虫使用与人口贩运有关的搜索短语,并提取由谷歌新闻API返回的新闻文章。新闻API返回的新闻文章。在我们的项目中,重要的是要收集与各种人口贩运相关的新闻。例如,童工、性贩运、人口贩运等。因此,挑战出现了,什么是搜索短语来产生和提取更多的相关新闻文章,以满足这一目标。

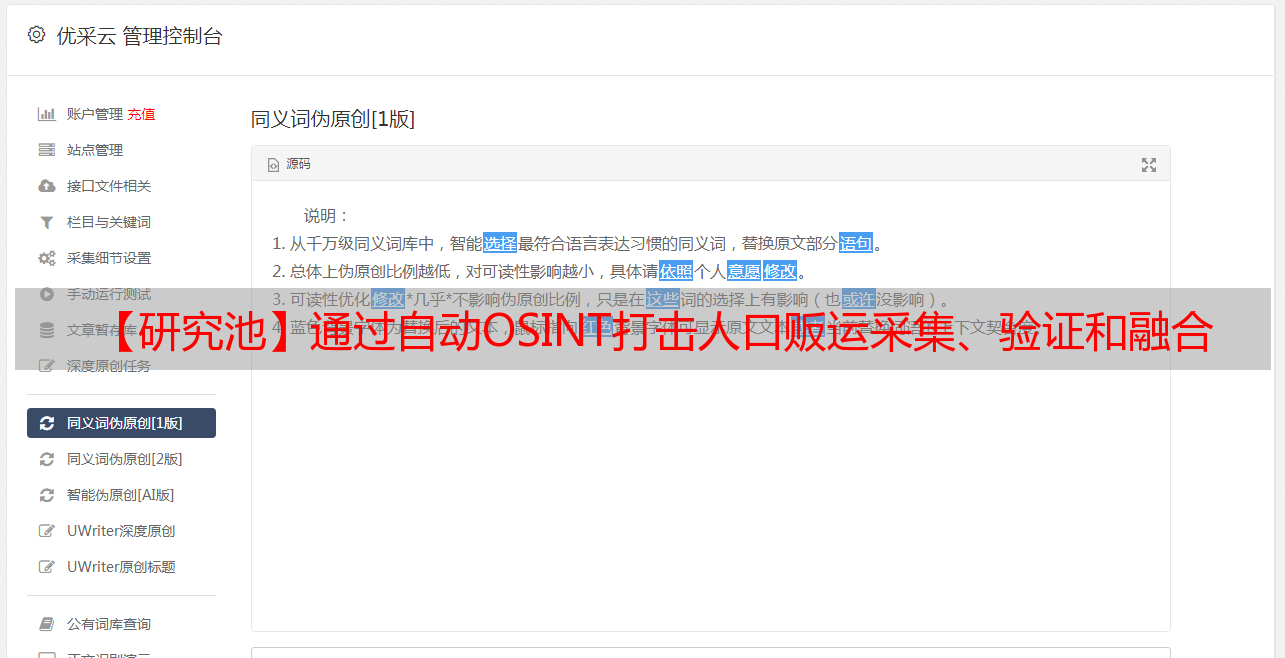

KeyBERT和搜索短语

我们使用了KeyBERT (Grootendorst 2020)模型,它是对BERT的修改,将关键词作为给定文本的输出。我们将预先注释过的366篇与人口贩运有关的文章的标题输入该模型,并检索到一组描述性的关键词作为输出。我们只选择高频率出现的关键词。我们还在关键词列表中加入了我们的赞助商(即爱与正义)感兴趣的国家名称。

因此,我们将高频率的搜索短语是将高频关键词和爱的正义在其中运作的国家名称。搜索关键词的例子包括人口贩运、贩运儿童、贩运劳工、*敏*感*词*的人口贩运、*敏*感*词*的儿童贩运、*敏*感*词*的劳工贩运、印度人口贩运、*敏*感*词*被捕的人贩子、印度被捕的人贩子等等。国家名单和搜索关键词都在GitHub中提供。

使用谷歌新闻RSS进行新闻抓取

我们使用了两种方法进行新的搜索。第一种方法是使用谷歌搜索引擎搜索新闻。在这种方法中从谷歌产生的结果是来自新闻网站以及其他网站。在人工评估抓取的新闻时,发现许多新闻是不相关的。

这促使我们探索第二种方法,即使用谷歌新闻RSS抓取新闻。谷歌新闻提供来自世界各地的新闻网站的汇总结果。对抓取的新闻进行人工评估是高度与人口贩运高度相关。因此,第二种方法被在爬虫程序中实施。

新闻相似性检查器

在对新闻进行抓取和提取后,新闻被保存在数据库中。策划的新闻是基于搜索短语的组合,有很高的几率抓取到具有相同链接的新闻。

因为搜索短语的组合与谷歌新闻引擎有类似的语义。也有这样的情况:同一个人口贩运*敏*感*词*被不同的新闻媒体分享或发布。也可能出现这样的情况:媒体的子公司以不同的标题报道同一新闻,但*敏*感*词*和背景相同。

所有这些情况导致了大量类似的新闻被抓取,即同一人口贩卖*敏*感*词*被覆盖在多篇新闻文章中。解决这个问题的方法是新闻相似性检查器,它可以在每天抓取的新闻中检查出类似的新闻并将它们标记为相似。

数据集有助于定义一个假设,即两篇新闻文章报道同一人口贩运*敏*感*词*的相似新闻将有类似的标题,并在新闻内容中共享同名的实体。基于这一假设的程序的制定过程中,每篇文章都要经过该程序,并与其他文章进行核对,以确定其是否相似。

这些文章通过两个步骤,在每个步骤中为文章提供一个分数。如果文章的总分通过了该阈值。那么它就被标记为相似。在第一步中,对新闻的标题进行余弦相似度比较。新闻的标题是用余弦相似度来比较的。余弦分数然后加到文章的总分上。在第二程序比较了两篇文章中命名实体的数量。两篇文章的命名实体都是用IBM Watson API提取的,然后进行比较。

命名实体计分机制是为每一种实体的匹配设置的。例如,如果有一个人的名字被匹配,那么总分将增加25分。如果有两个人的名字被匹配,则在总分中加入35分。类似的评分也是基于地点、组织和两个实体之间匹配的数量而提供的。最后,将总分与阈值进行比较。如果分数大于阈值,该文章就被标记为相似。

新闻关联性检查器

新闻爬虫的目的是收集包含人口贩运信息的新闻文章,并且很有可能包含受害者和嫌疑人的详细信息。有两个面临的额外挑战:

第一个挑战是文章与人口贩运有关,但缺乏嫌疑人和受害者的详细信息。

第二个挑战是,这些文章确实包含了关于人口贩运的搜索关键词组合或少数关键词。例如,一个名人是受害者,但文章的整体背景与人口贩运无关。后一个问题也导致了新闻的过度污染,因为新闻来源对名人的报道频率很高。

总之,问题是要找到相关的文章。寻找相关文章的过程可以被定义为寻找与人口贩运有关的、包含受害者或嫌疑人信息的新闻文章。

为了克服这一挑战,我们实施了一个新闻相关性检查器,它将标记非相关的新闻文章。新闻相关性检查器的算法分为两个步骤,以确定文章的相关性,以满足新闻抓取器的目标。

第一个步骤是检查相关的关键词在文章中的存在,以及第二步确定文章中出现的人名实体是否为名人。相关关键词的存在只是检查这组关键词是否出现在文章中。该关键字集是基于一组问题中使用的关键字而得出的。一组问题中使用的关键词,并将其输入到信息提取模型中。如果这组关键词没有出现在文章中,那么这篇文章就会被标记为不相关,并且不会被进一步处理。

另一方面,如果该文章被标记为则会进入第二步。这些文章含有知名人士名字的文章往往是不相关的文章。如何解决这个问题?

如何确定文章中提到的人是否是的问题是通过使用维基百科的API来解决的。这里使用的假设是,如果这个人是著名的,那么这个人的维基百科页面一定存在。

该算法将用IBM提取的每个人的名字发送到维基百科API,以确定维基百科的页面是否存在。如果维基百科页面已经存在,那么这篇文章将被标记为为不相关的,不作进一步处理。

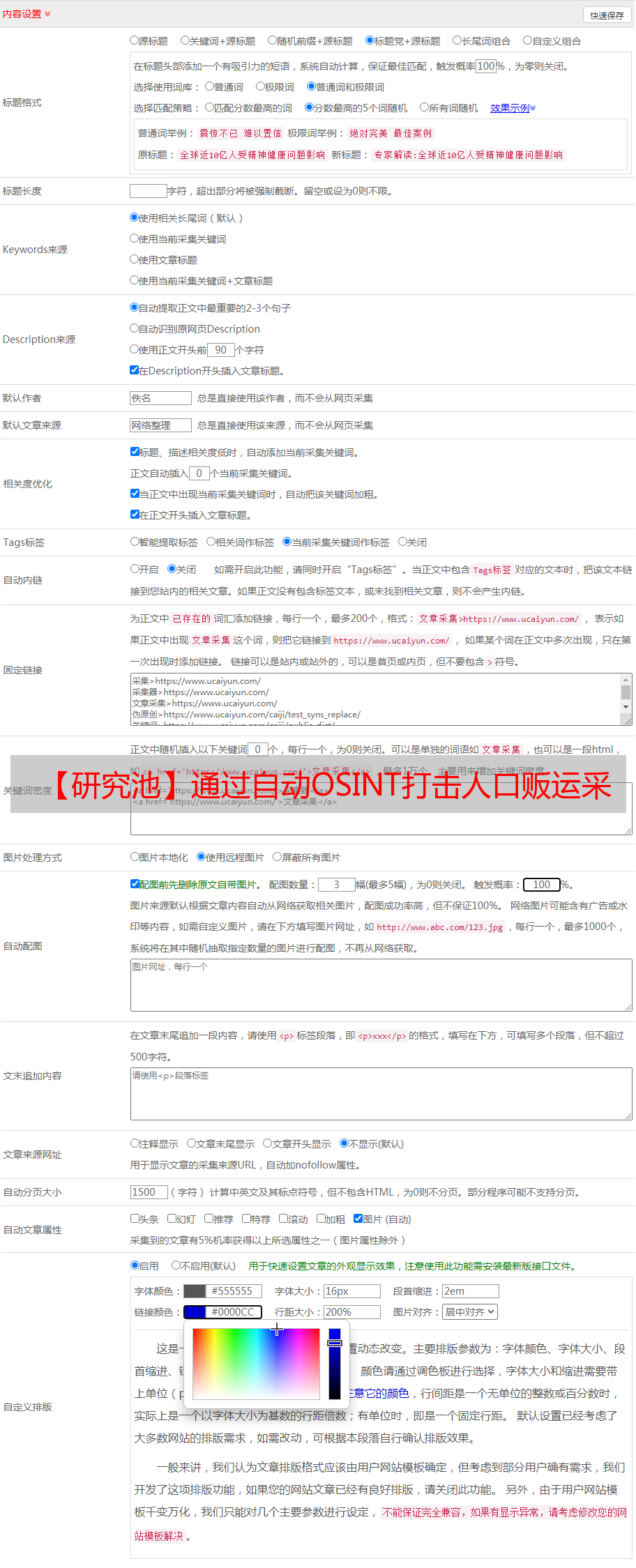

信息提取器

新闻报道通过信息提取器来检索有关受害者和嫌疑人的重要信息。这个组件的目的是为了检索以下信息:受害人的姓名、年龄、性别、国籍、地址、教育程度、职业和监护人,以及嫌疑人的姓名、性别、年龄、国籍和监护人。除了受害者和*敏*感*词*嫌疑人的详细信息,提取器还可以寻找以下信息:*敏*感*词*嫌疑人对受害者作出的承诺,受害者的旅行目的,以及受害者面临的剥削形式。(例如,劳动、性等)。

信息提取器是由一个文本过滤器和BERT QA语言模型。在通过了新闻相似性检查器和相关性检查器后,新闻文章被传递到文本过滤器,然后被传递到语言模型,以进行信息提取。信息提取器的框图如图2所示:

图2:信息提取器的流程

文本过滤器

文本过滤器对新闻文章进行预处理,然后再传递给模型。在把它们传递给模型之前,预处理阶段包括去除不需要的HTML标签、链接、非字母的ASCII字符和表情符号。

信息提取过程是使用BERT问题回答模型。问题和包含答案的参考文本被送入模型,然后该模型提供答案和分数。例如,为了在一篇文章中找到受害者,我们把问题 "谁是'和作为参考文本的新闻文章给模型。模型类的定义是这样的,它只在提供答案,如果该模型产生的置信度分数大于用户定义的阈值(例如90%),它才会提供答案。这个阈值可以由用户调整,作为我们解决方案的一个配置参数。

问题和动态问题

为了找到每个信息,该模型需要被问到一个特定的问题MongoDB保存的相关文章。

受害者的年龄和性别可以通过以下方式确定可以通过询问 "受害者的年龄是多少?"和 "受害者的性别是什么?。

但这并不总是文章中明确提到的关键词'受害者'。文章可能会谈论一个实际的受害者

使用类似的关键词,如幸存者、被绑架者或获救者。在这种情况下,通过询问以下问题得到的答案可能不正确,或者答案可能低于0.90分。如“谁是受害者?"或 "受害者的年龄是多少?解决这个问题的办法是提出不同的问题来获得相同的答案。观念在文章中代表受害者或嫌疑人的概念,从文章的作者到发表文章的媒体都有很大的不同。

利用KeyBERT和考虑文章中的顶级关键词,有助于制定一系列的问题,这些问题可以被传递给模型来提取每个信息。例如,为了找出受害者的名字,就会产生以下问题。谁是受害者?谁被绑架了?谁被解救?谁被贩卖了?谁是生还者?嫌疑人的名字

可以通过以下问题找到如:谁被逮捕了?谁是绑架者?谁是嫌疑人?绑架者是谁?

为了提取每个信息,其相应的问题集被传递给模型,模型对每个问题产生答案和分数。然后,我们的算法结合的答案,并选择对该信息得分最高的答案,以获得相应的信息。

类似的问题可以被组成,以确定受害者和嫌疑人感兴趣的其他信息。例如,为了提取受害者的年龄,一组问题可以是形成 "受害者的年龄是多少?","幸存者的年龄是多少?这种提取相关信息的方法导致了与寻找受害者和嫌疑人相比,从模型中提出的问题数量相同的问题。

虽然该模型在提取信息方面表现良好,但上述问题的通用结构引起了较高的计算量。每篇文章的计算时间和成本。此外,问题的通用性也可能导致信息提取的准确性降低。

为了解决这些问题,我们开发了一种技术用于生成动态问题的技术。动态问题是自动生成的,通过使用主体的名字而不是 "受害者 "或 "嫌疑人 "这样的一般性提法来找到受害者和嫌疑人的相关信息。诸如 "受害者 "或 "嫌疑人 "这样的一般参考资料。

因此,该模型只在找到受害人或嫌疑人的名字时才搜索相关信息。这有助于创建动态问题。例如,如果模型将受害者的名字确定为 "John Doe",那么算法所构成的动态问题是是'无名氏的年龄是多少?','无名氏的性别是什么?无名氏的地址是什么?"。类似的方法被用于生成动态问题来寻找嫌疑人的相关信息。使用动态问题的主要优势在于减少计算时间和提高信息提取的准确性。

挑战

前面提到的信息提取过程引起了两个主要的挑战。

第一个挑战是文章的长度较长。抓取的新闻文章的多样性。BERT QA语言模型只能处理512个标记,因此,具有更多标记的文章无法被处理。

第二个挑战是这些文章包括多个受害者的名字和多个嫌疑人的名字。该模型需要提取每个受害者或嫌疑人的信息以及他们各自的信息。

挑战一:处理较长的文章

处理含有超过512个标记的长篇文章,模型的处理过程类似于CNN模型中的池化过程。文章被分解成不同的块,然后分别处理。该算法确保文章中的句子不会失去其语义。同时将文章分解成许多片断。对于每个信息的提取,例如找到受害者的名字,模型向所有的人提出相应的问题。

文章的第一块被送入模型中的问题集。该算法将为第一块文章选择具有最佳得分的最佳答案。同样的过程也会在其他碎片上重复。每一块文章都会产生答案和分数。然后,该算法将所有小块文章产生的答案和分数结合起来的答案和分数,然后选择具有最高分数的答案。

对于每个信息提取过程,各自的问题集被问到模型上,并以破损的文章作为参考。

然后挑选出最佳答案。

挑战二:多个受害者/嫌疑人的检索方法

语言模型在寻找单一的受害者或嫌疑人的名字方面效果很好。然而,总是有一些*敏*感*词*

有多个受害者和多个嫌疑人。这就需要提取这些所有受害者和嫌疑人的名字。在这些*敏*感*词*中的观察结果是,语言模型多数情况下,即使给出了多个名字,也只给出了一个受害者/嫌疑人的答案。

原因可能是,提到受害者的文章的语义密切只参考了多个名字列表中的第一个名字作为受害者。找到多个受害者/嫌疑人名字的解决方案是递归算法。该算法从文章中的多个名字中找到第一个名字,然后将该名字从文章中删除。

然后将该文章送入模型。该模型产生了第二个名,该算法再次将第二个名字从文章中删除,并将该文章送回模型,以找到第三个名字。这个过程一直持续到模型找到名字为止。

这种方法成功地找到了在文章中找到多个受害者/嫌疑人的名字。当要在一篇较长的文章中找到多个受害者/嫌疑人的名字时,就会出现额外的挑战。这个问题是通过结合两种方法来解决的。

首先,文章被分割成小块。对于每一块文章,该算法使用递归算法找到多个受害者/嫌疑人使用一个递归算法。然后结合结果,在最后选择得分最高的答案。

5. 实验设置

新闻爬虫的设置

新闻爬虫被设置在亚马逊T2 Micro EC2实例中,用于抓取新闻的持续时间为4天。搜索时间可由用户改变。相似性检查器的算法参数可以由用户进行调整。目前的阈值分数被设定为50。对于余弦分数超过0.40的,总分加40,余弦分数超过0.50的。50分被添加到总分中,默认情况下,只有超过0.30分的文章被用来进行比较。

对于人名和地点名称,如果两篇文章之间存在单一的名称匹配,则25分被用于比较匹配,则加25分;如果有两个名字匹配,则加35分;如果有三个名字匹配,则加50分。对于组织和数量实体,如果有匹配,则得20分;如果有两个匹配,则得30分;如果有三个或更多的匹配,则得50分。

例如,两篇文章的标题余弦值相似度为0.30并且有一个共同的名字的两篇文章将有总分是55分,大于阈值。因此,两篇文章是相似的。新闻关联性检查器由20个关键词组成,它们是绑架、受害者、幸存者、被绑架、获救、被贩卖、失踪、被卖、被骗、嫌疑人、被逮捕、被定罪、绑架者、诱拐者、贩运者、代理人、被指控、被抓住、被拘留和经纪人。最后得出的新闻文章被保存在MongoDB数据库中。

信息提取模型设置

信息提取模型是由一个文本过滤器和BERTQA语言模型。正在使用的BERT QA模型一个预先训练好的BERT大型无套管模型,在SQuAD数据集上进行了微调。该模型类被设置为只给分数超过0.90的答案,否则就返回'不可用'。该模型建立在亚马逊ML T2上大,有8GB内存和2个vCPUs。在提取信息后,MongoDB数据库被更新,同时,CSV文件也被更新到亚马逊S2桶上的CSV文件也被更新。

评估方法

新闻抓取器和信息提取器模型的评估是手动完成的。新闻爬虫输出的新闻文章的相关度是手动测量的。对于每一组相关和不相关的文章,注释者都要手动查看每条新闻以验证结果。注释者手动浏览每条新闻以验证结果。

信息提取的输出不仅仅是一个词,有时还包括短语,因此用字符串进行自动评估比较是不可行的。在这种情况下,注释者也会仔细检查每篇文章,确定受害者和*敏*感*词*嫌疑人,以及各自的元数据和附加信息,然后与模型生成的结果进行比较

6. 结果和讨论

新闻抓取结果 在四天的新闻期中,抓取的新闻总数为1479条。爬行器随后处理这些文章,然后删除重复的和类似的文章。剩余的463篇文章随后被传递到到新闻相关性检查器,该算法把122篇文章是相关的,341篇文章是不相关的。

经过人工评估,相关文章的总数为184篇,非相关文章为279篇。该算法给出了45个假阳性结果和107个假阴性结果。新闻相关性检查器给出了0.6311的精确分数和0.6717的准确分数。

我们在这里需要关注的一个重要问题是假阴性数字。因为这107篇文章可能含有受害者/嫌疑人的信息。我们的评估发现,在341篇非相关标记的文章中有27篇文章含有与目标相关的受害者/嫌疑人的信息。

根据我们的观察,有3个原因导致这些文章被标记为为不相关。第一个原因是文章中缺乏相关的关键词。在这些文章中。这些文章没有包含20个相关关键词中的任何一个,而这些关键词会将它们标记为相关。然而,我们可以在这些遗漏的文章中找到关键词,然后添加到到相关的关键词集中,但这也会开始将其他的文章也会被标记为相关的。

第二个原因是语义上的,这些文章在上下文中没有提到嫌疑人或受害者,但在文章的后面提供了受害者/嫌疑人的名字。这些语义和写作风格不佳的文章不仅被新闻相关性检查器所遗漏,而且在反馈到语言模型时也表现不佳。

最后一个原因是人口贩运新闻是一个备受关注的*敏*感*词*,并且有其受害者/嫌疑人的维基百科页面。例如,这条新闻包含了Jeffery Epstein作为嫌疑人,但由于它包含了维基百科的页面,所以算法将其标记为不相关。假阴性文章的影响也应被注意。

如果文章中包含任何关于受害者的信息和任何与人口贩运有关的搜索关键词。那么该模型可能会产生嫌疑人/受害者提供错误的信息。含有*敏*感*词*嫌疑人/受害者信息的文章的总数为122篇中有77篇,122篇中有20篇含有受害人/嫌疑人的名字。抓取器的目的是要找到含有受害人/嫌疑人姓名和元数据的人口贩运文章。

但根据观察,大多数时候,受害者/嫌疑人的名字在新闻文章中是保密的。因此,新闻文章的叙述包含相关的关键词,但缺乏受害者/嫌疑人的名字。我们还需要注意的是,这条新闻的抓取时间为在4天的时间里,媒体报道的*敏*感*词*数量有限。而且出现受害者/嫌疑人姓名的*敏*感*词*也可能是有限的。

信息提取器的结果

为了评估信息提取器,我们使用了一个由366篇相关新闻文章组成的注释数据集。信息提取的平均计算时间为每篇文章7.5秒。对于受害者信息,该模型得到了提供了142篇包含受害者姓名的文章。该模型匹配了103篇文章中的受害者姓名,在39篇文章中出现了错误。因此预测受害者姓名的准确率为72.53%。在142篇文章中出现的受害者总数为347人。其中模型提取了205个受害者名字。对于元数据的评估,我们只选择了年龄和性别,因为其他信息在文章中并不常见。

受害者的性别在93篇文章中与受害者的性别相匹配,在48篇文章中与受害者的性别相误。在性别预测方面的准确率为65%。总的性别其中197篇被模型预测正确,25篇被错误地预测。对于受害者的年龄,有84篇文章的年龄预测是匹配的,有58篇文章的年龄预测是错误的。年龄预测的准确率为59.15%。总共有99个年龄被提及,其中模型正确预测了其中的66个,错误的是33个。

在识别嫌疑人姓名和元数据的情况下230篇含有嫌疑人姓名的文章被送入模型。该模型在135篇文章中预测了嫌疑人的名字,在95篇文章中犯了错误,在识别嫌疑人名字方面的准确率为为58.69%。

在230篇文章中出现的嫌疑人总数为600人。该模型提取了222个名字。对于*敏*感*词*嫌疑人的性别,该模型在114篇文章中正确预测了性别,在116篇文章中犯了错误。其准确率为49.35%.。给出的性别总数为235个,其中模型预测了165个。该模型预测了其中的165个,而在识别性别方面犯了70个错误。对于*敏*感*词*嫌疑人的性别,该模型在115篇文章中正确预测了性别,而在另外115篇文章中犯了错误,其准确率为50%。给出的年龄总数为91,模型预测了91条中的60条,在预测其他30条时犯了错误。

我们需要分别评估和讨论受害者和*敏*感*词*嫌疑人的情况,因为这两者在其重要性、出现在文章中的时间和地点方面有很大的不同。用来识别受害人和嫌疑人的名字是不同的,文章中的受害人名字的数量的次数少于嫌疑人的次数。准确性的衡量标准是以文章中的匹配结果的数量来衡量。此外,还提供了成功提取姓名和元数据的数量,以分析该模型如何在识别和提取文章信息方面的工作。

该模型在识别含有单一姓名的文章中的受害者时表现良好。有多个名字的文章中,整个模型使用了递归算法来搜索名字,当模型给出第一个名字时,模型就会删除这个名字,并将其发送至模型,以便找到下一个名字并重复这个过程。这个过程在删除名字后会扭曲文章的语义。

如果受害者/嫌疑人的名字是在列表中给出的,而年龄在其一侧,那么删除名字将只在句子中留下年龄。句子,这将扭曲整个句子的语义包括文章的语义。例如,如果多个受害者的的名字以这种模式表示,在文章中 "受害者是是John Doe 28,Mary Lith 30,William James 29',在第二次递归后删除第二个名字将使句子成为'受害者是28,30,威廉-詹姆斯29'. 在这样的情况下,模型会遗漏识别最后出现在列表中的几个名字。

该模型在识别受害者和嫌疑人的名字方面也有错误。曾有在一些案例中,模型预测的是受害者的名字而不是嫌疑人的名字,反之亦然。造成这种情况的原因是文章的写作风格。这些文章并没有提及受害者或嫌疑人的名字,并明确使用了相关的关键词。

在某些情况下,文章在前几句谈到受害者被绑架,而在文章的最后才出现受害者的名字。因此,该模型漏掉了这个名字或混入了其他名字。然而,这个问题已经在模型中得到了解决。每次提取受害人的名字时,模型都会与嫌疑人名单进行交叉检查,如果该名字出现在嫌疑人名单中,受害人的名字就会被转移到嫌疑人名单中。

同样的过程也被用于提取嫌疑人,嫌疑人的名字也采用同样的过程。受害者和嫌疑人的性别识别取决于文章中提到名字的背景。在有多个受害者/嫌疑人的情况下,性别在很大程度上会被遗漏。

因此,该模型利用了性别-API 8,如果性别没有被模型识别,那么它就把名字发送给Gender-API来检测性别。这里的挑战是,很少有名字是该特定国家的,而且是非常独特的。

在这种情况下,即使是Gender-API也无法确定性别。文章中的年龄是以小数字表示的。年龄也以一种模糊的方式表示,如受害者二十多岁的受害者或四十多岁的嫌疑人。该模型不能提取这些模棱两可的术语。年龄有时被提到词,算法将其转换为数字。在少数情况下,模型将其他数字误认为是嫌疑人/受害人的年龄。

7. 结论

我们的工作展示了利用自然语言处理和机器学习的最新进展来创建一个自动管道来简化策划、分析。从多来源的新闻媒体中提取可操作的情报。作为开放的情报来源(OSINT)。我们还证明了使用BERT问题回答模型可用于从非结构化数据中提取重要信息,并可利用该模型和其他算法来减少计算成本和冗余处理,只需策划相关的新闻文章。整个模型和新闻爬虫的性能证明了所开发的系统可以用于人口贩运*敏*感*词*的信息提取。

这是更全面的数据收集管道和人口贩运OSINT框架的第一阶段。未来的工作包括加强我们的系统,以检测模式和技术,以实时发现人口贩运的存在。此外,未来的工作还包括解决以下问题使用自动翻译工具,解决系统搜索和处理英语文章的局限性。

封面来源:摄图网可商用图片论文作者:Bibek Upadhayay, Zeeshan Ahmed M Lodhia, Vahid Behzadan1SAIL Lab参考文献:本文所有参考文献说明见原文

ps:可在公众号后台回复“人口贩运”获取论文原文报告

END