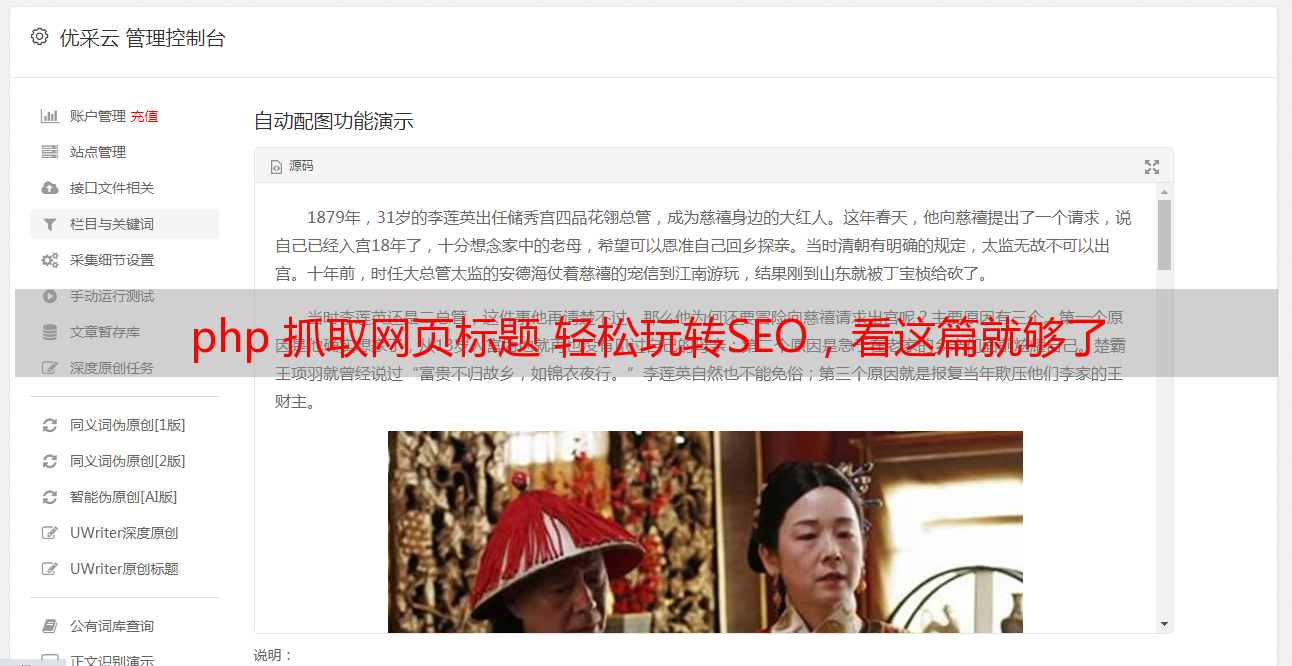

php 抓取网页标题 轻松玩转SEO,看这篇就够了

优采云 发布时间: 2022-05-09 03:39php 抓取网页标题 轻松玩转SEO,看这篇就够了

欢迎投稿到早读课,投稿邮箱:

最近在看SEO方面的知识,很是有趣,能学些新东西的感觉总是好的,随着经历增多心境较之前也少了些浮躁,当下的年纪也正是钻研些好玩事物的大好时光,在这里给大家推荐两本SEO的基础入门书籍,《百度SEO一本通》 《7天精通SEO》希望借此文和志同道合者共同进步!

虽然现在最火的SEO书籍是Zac出的那本《SEO实战密码》,豆瓣评分也不错,但实际读来逻辑比较散乱,信息量太大,有点像历史博客文章的堆积,对于刚接触SEO的人来说其实并不适合,个人建议可以先从入门的书籍开始看,形成自己的理解体系,然后再用自己建立起来的这套体系去做加深阅读,这也是我常用的方法,实际说来我看书的量并不多,更偏向看适合自己这个阶段的,去到书中参悟。

首先,让我们先来看看这两本书的逻辑体系,带着方向去阅读

《7天精通SEO》.png

这书本重点看站内篇、站外篇、策略篇部分,这三个部分主要讲做优化的实际方法论,基础篇就是了解大致常识,可以快速浏览,可以和案例篇专题篇组合来看。

《百度SEO一本通》.png

这本书主要看关键词、链接优化技巧,理解和了解网络技术和百度的竞价推广、网盟推广。

接下来,梳理下SEO的基本常识(不完全的部分会在后续补充)

1. SEO定义:

Search Engine Optimization(全称)也即搜索引擎优化,就是从搜索引擎上获得流量的技术。搜索引擎的主要工作包括:通过了解搜索引擎的工作原理掌握如何在网页流中爬取网页、如何进行索引以及如何确定某一关键词排名位置从而对网页内容进行科学的优化,使其符合用户浏览习惯的同时提高排名与网站访问量,最终获得商业化能力的技术。

2. 搜索引擎工作原理:

主要有三段工作流程:爬行抓取、预处理、服务输出

2.1 爬行抓取

主要功能是对网页进行抓取,目前有三种爬行抓取方法

2.1.1 常见蜘蛛

搜索引擎蜘蛛是搜索引擎的一个自动程序,作用是访问互联网上的网页、图片、视频等内容,建立索引库,一般用法为spider+URL这里的URL是搜索引擎的痕迹,可以通过查看服务器里的日志里是否有该URL,同时还能查看一些列属性。

2.1.2 爬行策略

2.1.3 预处理

也即对抓取回来的数据进行一个索引工作,其中包括多个流程,在后台提前完成。

2.1.3.1 关键词提取

将HTML、JS、CSS等标签&程序去除,提取用于排名的有效文字。

2.1.3.2去除停用词

即反复出现的无用词,如:“得、的、地、啊、阿、再”等

2.1.3.3分词技术

是中文搜索引擎特有的技术支持,中文不同于英文单词与单词之间用空格分隔,因此搜索引擎必须把整个句子切割成小单元词,分词的方法有两种

2.1.3.4消除噪声

消除网页上各种广告文字、图片、登录框、版权信息等对搜索引擎无用的东西。

2.1.3.5分析网页建立倒排文件

![Upload 索引.jpg failed. Please try again.]

2.1.3.6 链接关系计算

计算出页面上有哪些链接指向哪些其他页面,每个页面有哪些导入链接,链接使用了什么锚文本等,Google推出的PR是代表之一。

2.1.3.7 特殊文件处理

对flash、视频、PPT、XLS、图片等非文字内容不能执行脚本和程序。图片一般使用标签

2.2 服务输出

输出结果的展现方式,如:与搜索关键词匹配的部分用红色字体标出

输出

3. 网站分类目录

是人为编辑的搜索结果,将互联网上优秀的网站收集整理在一起,按照不同的分类或者主题放在相应的目录中,多靠人为提交,如:hao123网址导航

4. 关键词

一般指用户在搜索框中自定义输入的信息,按照概念可以分为:目标关键词、长尾关键词、相关关键词;按页面上分,可以为首页、栏目页、内容页关键词;按目的来分可以分为直接性、营销性关键词

5. 权重和PR值(PageRank)

PR值是谷歌搜索引擎用来衡量网页重要性的一种方法,也是其判断一个网站好坏的重要标准之一,最大的影响因素为是否拥有大量的高质量外链。

网站权重是指网站与网站在搜索引擎眼中的分级制“待遇”表现,是搜索引擎中的一个综合表现指标,决定因素有:外部链接的导入、稳定的高质量内容和结构清晰的网站结构等。

要注意区分这是两个不同的概念

6. 白帽SEO和黑帽SEO

7. 锚文本、外链、内链、单向链接、双向链接、导出链接、导入链接

8. 有机列表

是SERP中的免费列表,即搜索结果页面的免费列表,可以通过制定SEO策略进行优化。

9. robots.txt文件

Robots Exclusion Protocol,网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。多用来避免出现大量404页面、死链接如何查看?格式:在浏览器中输入URL/robots.txt即可,下面是

![Uploading d62a6059252dd42a8d159f41013b5bb5c9eab838_722675.jpg . . .]文件

User-agent: Baiduspider

Disallow: /

User-agent: baiduspider

Disallow: /

User agent 指浏览器

robots文件常通过组合的方式来运用,主要有如下四种情况

10. nofollow

决定是否对网站进行投票,传递权重,可以用来防止垃圾链接

11. 黑链

只存在于源代码中的超链接

12.动态网址和静态网址

13.搜索跳出率

用户查到一个网站并点击进入,且只浏览了一个页面就离开所占的比例

14. 网页快照

搜索引擎在收录网页时,对网页进行备份,存在自己的服务器缓存里,当用户在搜索引擎中点击“网页快照”链接时,搜索引擎将Spider系统当时所抓取并保存的网页内容展现出来,称为“网页快照”。