seo优化搜索引擎工作原理(搜索引擎工作的大体最重要的是什么?(一) )

优采云 发布时间: 2022-04-20 08:08seo优化搜索引擎工作原理(搜索引擎工作的大体最重要的是什么?(一)

)

搜索引擎最重要的是什么?有人会说是查询结果的准确性,有人会说是查询结果的丰富度,但其实这些都不是搜索引擎最致命的地方。对于搜索引擎来说,最致命的就是查询时间。试想一下,如果你在百度界面查询一个关键词,结果反馈给你需要5分钟,结果一定是你迅速放弃百度。

为了满足对速度的苛刻要求(商业搜索引擎的查询时间单位是微秒级),搜索引擎使用缓存来支持查询需求,这意味着我们在查询和搜索时得到的结果并不及时,但结果已缓存在其服务器上。那么搜索引擎工作的一般流程是怎样的呢?我们可以理解为三个段落。

本文的文章只是对三阶段工作流程的一般解释和概述,一些详细的技术细节将与其他文章分开解释。

一.网页合集

网页抓取其实就是我们常说的蜘蛛抓取网页。所以对于蜘蛛(谷歌称之为机器人)来说,他们感兴趣的页面分为三类:

1.蜘蛛从未爬过的新页面。

2.被蜘蛛爬过但内容发生变化的页面。

3.被蜘蛛抓取但现在被删除的页面。

那么如何有效的发现和爬取这三类页面是蜘蛛编程的初衷和目的。那么这里就有一个问题,蜘蛛爬行的起点。

只要你的网站建设没有被严重降级,每一个站长都可以通过网站后台的服务器找到辛勤的蜘蛛光顾你的网站,但是你有没有想过从从编程的角度来看,蜘蛛是怎么来的?对此,各方意见不一。有一种说法,蜘蛛的爬行是从*敏*感*词*站(或称高权重站)开始,根据权重从高到低开始的。另一种说法是蜘蛛在 URL 集合中爬行没有明显的顺序。搜索引擎会根据你的网站内容更新的规律,自动计算出何时是爬取你的网站的最佳时间。,然后爬行。

其实对于不同的搜索引擎,它们的爬取起点肯定是不一样的。对于百度,笔者更倾向于后者。在百度官博发表的文章《》中,明确表示“蜘蛛会尝试检测网页的发布周期,并以合理的频率检查网页”。由此我们可以推断,在百度的索引库中,对于每一个URL 采集,都会计算一个合适的爬取时间和一系列参数,然后爬取对应的站点。

在这里,我要说明的是,对于百度来说,site 的价值并不是爬过你页面的蜘蛛的价值。比如site:****.com,得到的值并不是大家常说的百度收录值。如果要查询具体的百度收录卷,应在百度提供的站长工具中查询索引。数量。那么什么是网站?这个我以后会向你解释文章。

那么蜘蛛是如何发现新链接的呢?它依赖于超链接。我们可以把所有的互联网想象成一个有向集的集合,蜘蛛开始沿着网页中的超链接从初始 URL 集 A 中发现新的页面。在这个过程中,每找到一个新的 URL 都会与集合 A 中已有的 URL 进行比较。如果是新的 URL,则将其添加到集合 A,如果已经存在于集合 A,则将其丢弃。蜘蛛对一个站点的遍历和爬取策略分为两种,一种是深度优先,一种是广度优先。但是,如果是百度这样的商业搜索引擎,它的遍历策略可能会是一些更复杂的规则,比如域名本身的权重系数,百度自身服务器的矩阵分布。

二.预处理

预处理是搜索引擎中最复杂的部分,基本上大部分排名算法都在这个环节生效。那么,在预处理的过程中,搜索引擎主要对数据进行如下处理:

1.提取关键词

蜘蛛爬取的页面与我们在浏览器中查看的源码相同,通常代码杂乱无章,很多与页面的主要内容无关。由此看来,搜索引擎需要做三件事: 1. 代码去噪。从网页中删除所有代码,只留下文本。②去掉非文本关键词。示例包括页面上的导航栏和不同页面共享的其他公共区域的关键词。③ 去除停用词。停用词是没有特定含义的词,如“of”、“in”等。

当搜索引擎得到这个网页的关键词时,会使用自己的分词系统将文章分成一个分词列表,然后存入数据库,并进行*敏*感*词*的处理与本文网址对应。我将在下面举一个例子。

如果蜘蛛抓取到的页面的URL是****.com/2.html,并且搜索引擎对这个页面进行上述操作后提取的关键词的集合是p,并且p由关键词p1,p2,...,pn组成,在百度数据库中,它们之间的关系是一一对应的,如下图。

2.删除重复并重新打印网页

每个搜索引擎对重复页面的识别算法不同,但笔者认为,如果将去重算法理解为由100个元素组成,那么所有搜索引擎可能有80个元素完全相同。其他20个元素根据不同搜索引擎对seo的不同态度,专门设置了相应的策略。本文仅对搜索引擎的一般流程进行初步解释,不解释具体的数学模型。

3.重要信息分析

在代码去噪的过程中,搜索引擎并不是简单地去除它,而是充分利用网页代码(如H标签、强标签)、关键词密度、内链锚文本等。此页面上最重要的短语。

4.网页重要性分析

通过指向该网页的外部链接的锚文本传递的权重值,为该网页确定一个权重值,同时结合上述“重要信息分析”,每个关键词set p 这个网页成立。@关键词 拥有的排名因素。

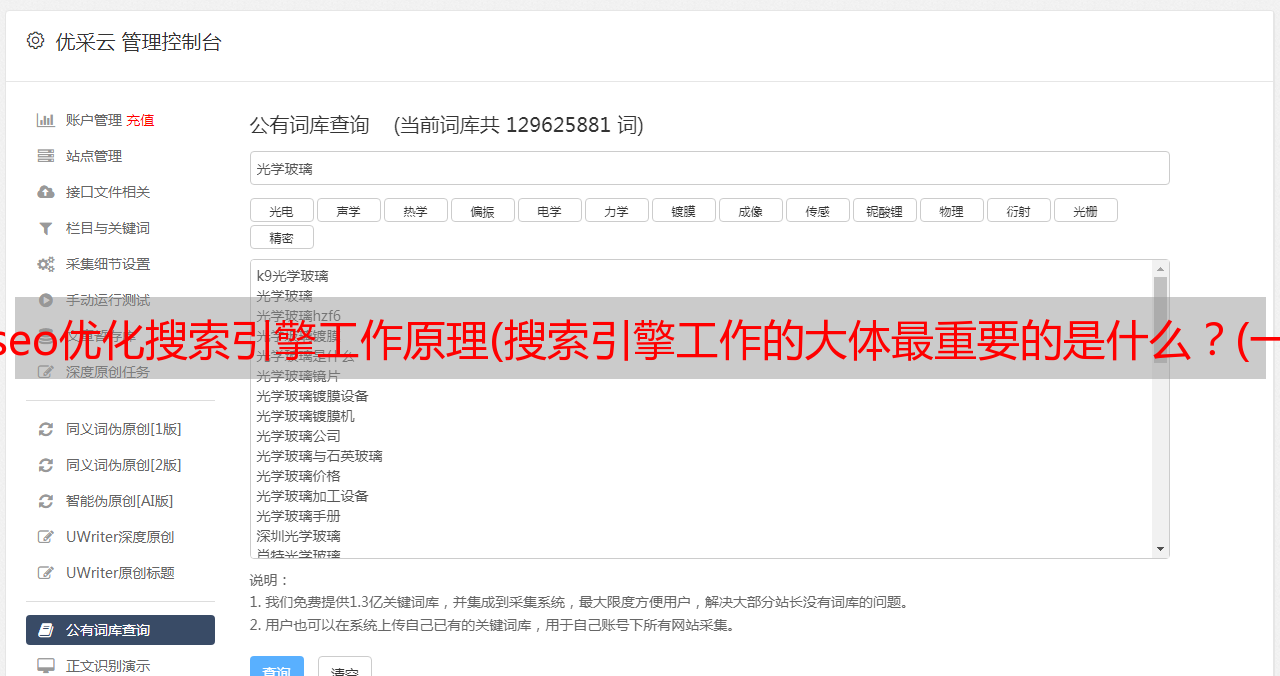

5.反转文件

如上所述,用户在查询时得到的查询结果并不及时,而是已经大致排列在搜索引擎的缓存区中。当然,搜索引擎不会是不可预知的,他不会知道哪些用户会查询关键词,但是他可以建立一个关键词词库,在处理用户查询请求时,将根据词库请求。这样,搜索引擎就可以在用户产生查询行为之前,计算出词库中每个关键词对应的URL排名,大大节省了处理查询的时间。

简单来说就是搜索引擎通过控制器控制蜘蛛爬取,然后用原创数据库保存设置的URL,保存后再使用索引器控制每个关键词与URL的对应关系,并将其存储在索引数据库中。

下面举个例子:

如果将 ****.com/2.html 页面分割成 p={p1, p2, p3, ..., pn},在索引数据库中会用下图表示。

上图是为了方便大家理解而制作的。索引数据库其实是搜索引擎中对性能要求最高的数据库,因为里面的所有因素都会受到算法的影响,所以我觉得实际的索引数据库应该是由多维数组组成的。它是一个比较复杂的索引表,但它的主要功能与上图相同。

三、查询服务

查询服务,顾名思义,就是在搜索界面处理用户的查询请求。搜索引擎构建爬虫,然后分三个步骤处理请求。

1.根据查询方法用关键词进行分词

首先将用户搜索到的关键词分成一个序列关键词,我们暂时用q来表示,那么用户搜索到的关键词q被分成q={q1 , q2, q3, ..., qn}。

然后根据用户的查询方式,比如所有的词是连在一起的,还是中间有空格等等,根据q中关键词的不同词性,将每个词中的所需的查询词在查询结果的显示上确定。占有的重要性。

2.搜索结果排序

我们有搜索词集q,q中每个关键词对应的URL排序——索引库,也根据用户的查询方式和部分计算出每个关键词在查询结果中的展示的语音如果重要,那么只需要一点综合排序算法,搜索结果就出来了。

3.显示搜索结果和文档摘要

当搜索结果可用时,搜索引擎会将搜索结果显示在用户的查看界面上供用户使用。

在这里,你可以思考两个问题。

1 在搜索界面,你经常会发现百度显示的摘要是围绕着用户的搜索词。如果我不只看第一页,还翻了一些页面,我会看到一些结果,因为目标页面本身并没有完全收录搜索词,百度提取的摘要中的红色词只是搜索的一部分词,那么我们可以理解,如果百度没有完全收录在搜索词中,是否应该首先显示在分词结果中,百度词认为哪个更重要?那么从这些搜索结果中,我们能看出百度分词算法的一些蛛丝马迹吗?

②有时搜索词在页面出现多次,但是在百度搜索结果页面的网站摘要部分,只会显示一部分,通常这部分是连续的,那么我们可以理解为在摘要部分,百度会优先考虑它认为对这个搜索词最重要的页面部分吗?那么由此可以推断出百度去噪后对不同部分进行权重分配的算法吗?

仁者见仁,智者见智。做SEO的朋友应该自己摸索摸索。作者在这里不敢没有孩子。

四、目前百度的流程漏洞

请原谅我将此模块描述为进程错误,但我不得不说,在当今的点击器世界中,我认为将其称为错误并没有错。

即除了以上三大环节,百度还构建了用户行为模块,影响原数据库和索引库。影响原数据库的是百度的快照投诉,主要是处理一些互联网的暴利行为,可以理解。影响索引库的是用户的点击行为。这种设计本身是可以理解的,但是百度算法的不成熟导致了点击者作弊的猖獗。

百度的用户行为分析模块很简单。除了自己投诉的提交条目外,就是采集用户在搜索界面的点击行为。如果这个页面的结果被大多数用户查看,但没有产生点击,则大多数用户选择点击第二个。页面甚至更多页面,这种现象会被百度工程师知道,算法会根据这方面进行微调。今天,百度的算法对于不同的行业是不同的。

如果前两页中的一个搜索界面被大量用户选中并点击,通常在24小时内,搜索结果就会有很大的提升,甚至提升到首位。

五、搜索引擎总流程图(加用户行为分析器)