自动采集编写(如何利用Python打造搜狗壁纸自动下载爬虫库的反爬措施)

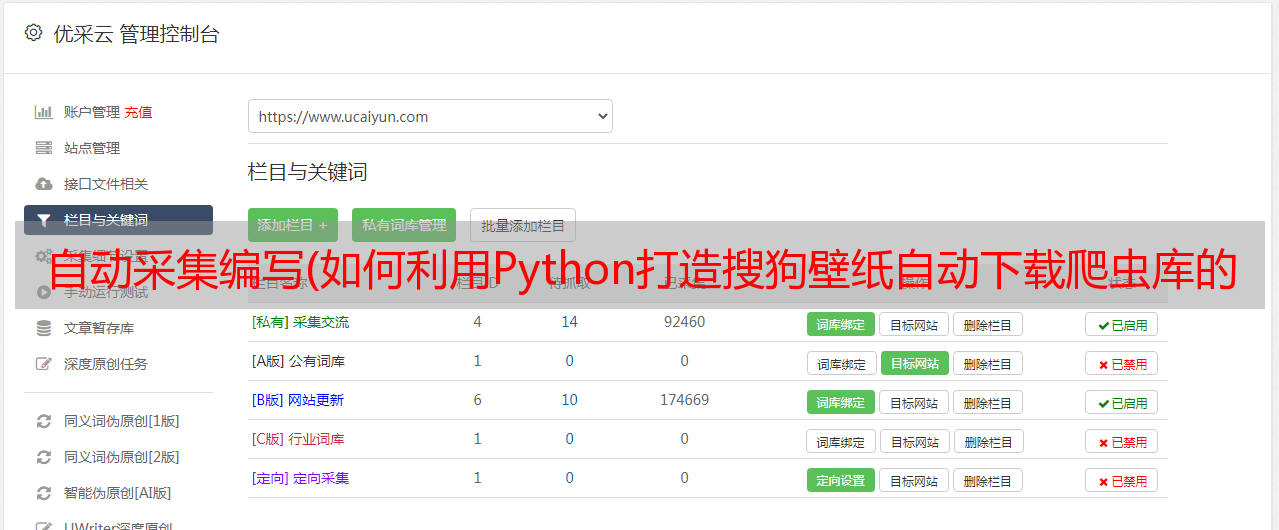

优采云 发布时间: 2022-04-16 15:16自动采集编写(如何利用Python打造搜狗壁纸自动下载爬虫库的反爬措施)

这些案例是为一些想进入Python行业的朋友写的。看到大家都很满意,我又拿出来了。如果你已经开始学习python,对爬虫一窍不通,不妨看看这几个案例!

二、环境准备

Python 3

requests 库、lxml 库、beautifulsoup4 库

pip install XX XX XX 一起安装。

三、Python爬虫小案例

1、获取机器的公网IP地址

使用python的requests库+公网查IP接口自动获取IP地址

2、使用百度的搜索界面,Python编写url采集工具

你需要使用requests库和BeautifulSoup库来观察百度搜索结构的URL链接规则,通过在程序中设置User-Agent请求头来绕过百度搜索引擎的反爬虫机制。

Python 源代码:

用Python语言编写程序后,使用关键词inurl:/dede/login.php批量提取某个网络的后台地址cms:

3、使用Python制作搜狗壁纸自动下载爬虫

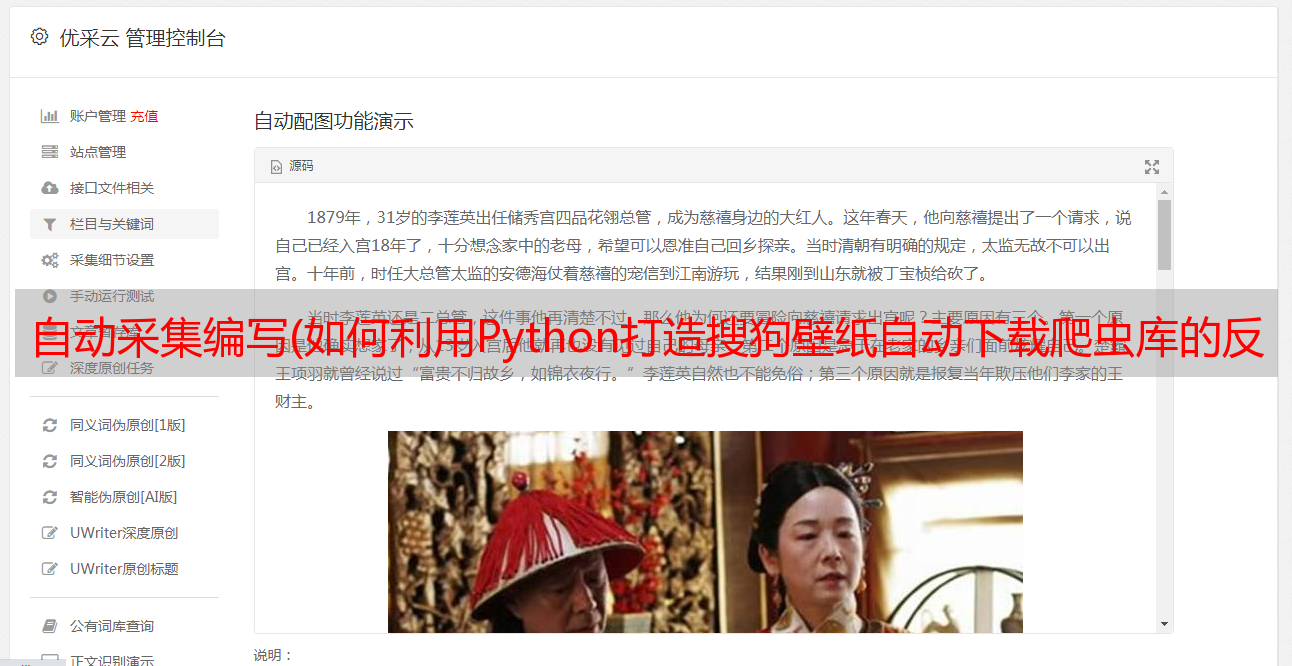

搜狗壁纸的地址是json格式的,所以使用json库解析这组数据,将爬虫程序存放图片的磁盘路径改成要存放图片的路径。

渲染:

4、Python 自动填充调查

和一般网页一样,多次提交数据都需要一个验证码,这就是反爬机制。

如图:

那么如何绕过验证码的反爬措施呢?使用X-Forwarded-For伪造IP地址访问,Python代码如下:

效果:

5、获取 West Thorn 代理上的 IP,以验证这些代理被禁止的可能性和延迟时间

可以将Python爬取的代理IP添加到代理链中,然后就可以进行一般的渗透任务了。这里,linux系统命令ping -c 1 " + ip.string + " | awk 'NR==2{print}' - 被直接调用。要在Windows下运行这个程序,需要修改os.popen倒数第二行的命令,可以修改为Windows可执行。

爬取的数据如图:

演示:

结论