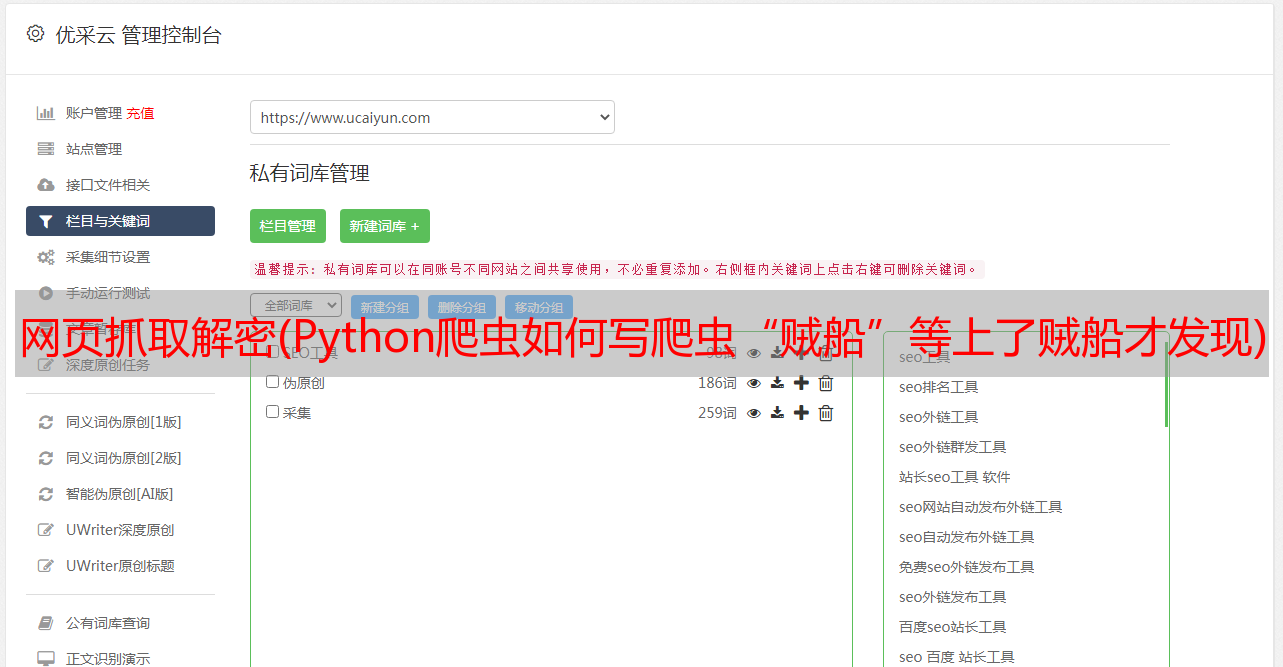

网页抓取解密(Python爬虫如何写爬虫“贼船”等上了贼船才发现)

优采云 发布时间: 2022-04-15 08:17网页抓取解密(Python爬虫如何写爬虫“贼船”等上了贼船才发现)

写爬虫是一项考验综合实力的工作。有时,您可以轻松获取所需的数据;有时候,你努力了,却一无所获。

很多Python爬虫入门教程都是一行代码骗你上“贼船”,上贼船才发现,水好深~

例如,爬取一个网页可以是非常简单的一行代码:

r = requests.get(')

很简单,但它的作用只是爬取一个网页,而一个有用的爬虫远不止是爬取一个网页。

一个有用的爬虫,只用两个词衡量:

但是要实现这两个字,还需要下一番功夫。自己努力是一方面,但同样很重要的一点是你想要达到的网站的目标是它给你带来了多少问题。综合来看,写爬虫有多难。

网络爬虫难点一:只爬 HTML 页面但可扩展

这里我们以新闻爬虫为例。大家都用过百度的新闻搜索,我就用它的爬虫说说实现的难点。

新闻网站基本不设防,新闻内容全部在网页的html代码中,抓取整个网页基本上就是一行。听起来很简单,但对于一个搜索引擎级别的爬虫来说,就不是那么简单了,要及时爬取上万条新闻网站的新闻也不是一件容易的事。

我们先来看一下新闻爬虫的简单流程图:

从一些*敏*感*词*页开始,*敏*感*词*页往往是一些新闻网站的首页,爬虫抓取该页面,从中提取出网站的URL,放入URL池中进行爬取。这从几页开始,然后继续扩展到其他页面。爬虫爬取的网页越来越多,提取的新网址也会成倍增加。

如何在最短的时间内抓取更多的网址?

这是难点之一,不是目的URL带来的,而是对我们自身意愿的考验:

如何及时掌握最新消息?

这是效率之外的另一个难点。如何保证时效?上千条新闻网站时刻都在发布最新消息。爬虫如何在织网抓取“旧”新闻的同时兼顾“新”新闻的获取?

如何存储大量捕获的新闻?

爬虫的抓取会翻出几年前和几十年前的每一个新闻页面网站,从而获取大量需要存储的页面。就是存储的难点。

如何清理提取的网页内容?

快速准确地从新闻网页的html中提取想要的信息数据,如标题、发布时间、正文内容等,给内容提取带来困难。

网络爬虫难点二:需要登录才能抓取想要的数据

人们很贪婪,想要无穷无尽的数据,但是很多数据并不容易提供给你。有一大类数据,只有账号登录才能看到。也就是说,爬虫在请求的时候必须登录才能抓取数据。

如何获取登录状态?