网页抓取解密(学完课程后可以干什么?-处理请求参数的加密和解密 )

优采云 发布时间: 2022-04-12 20:34网页抓取解密(学完课程后可以干什么?-处理请求参数的加密和解密

)

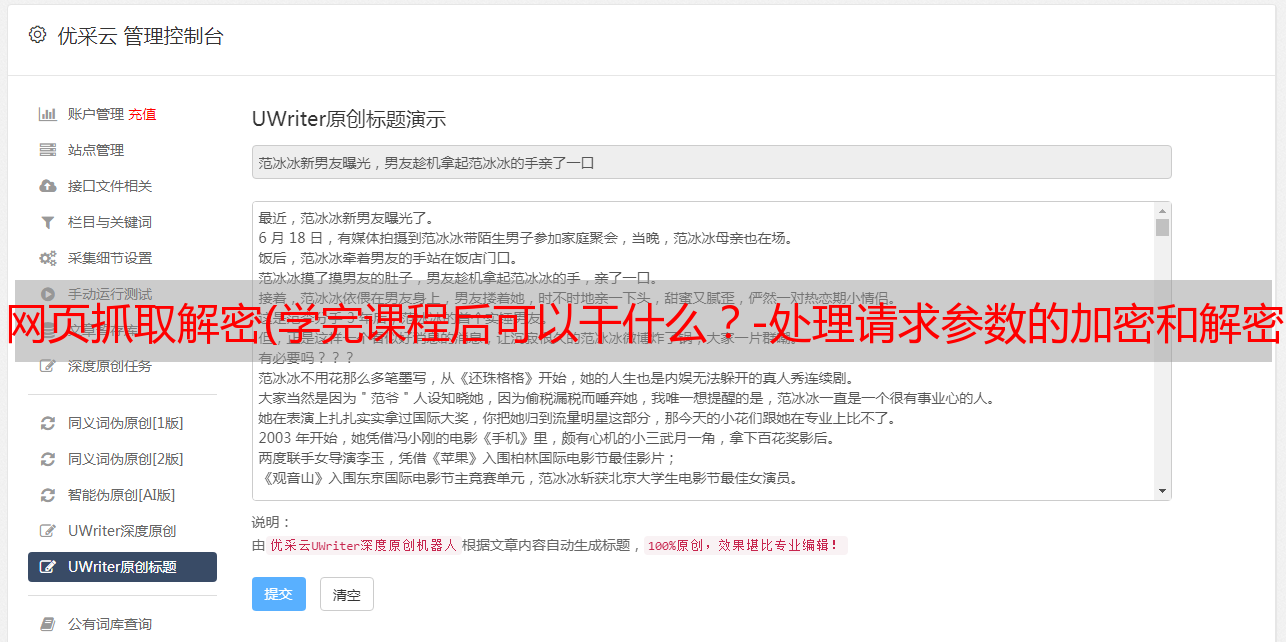

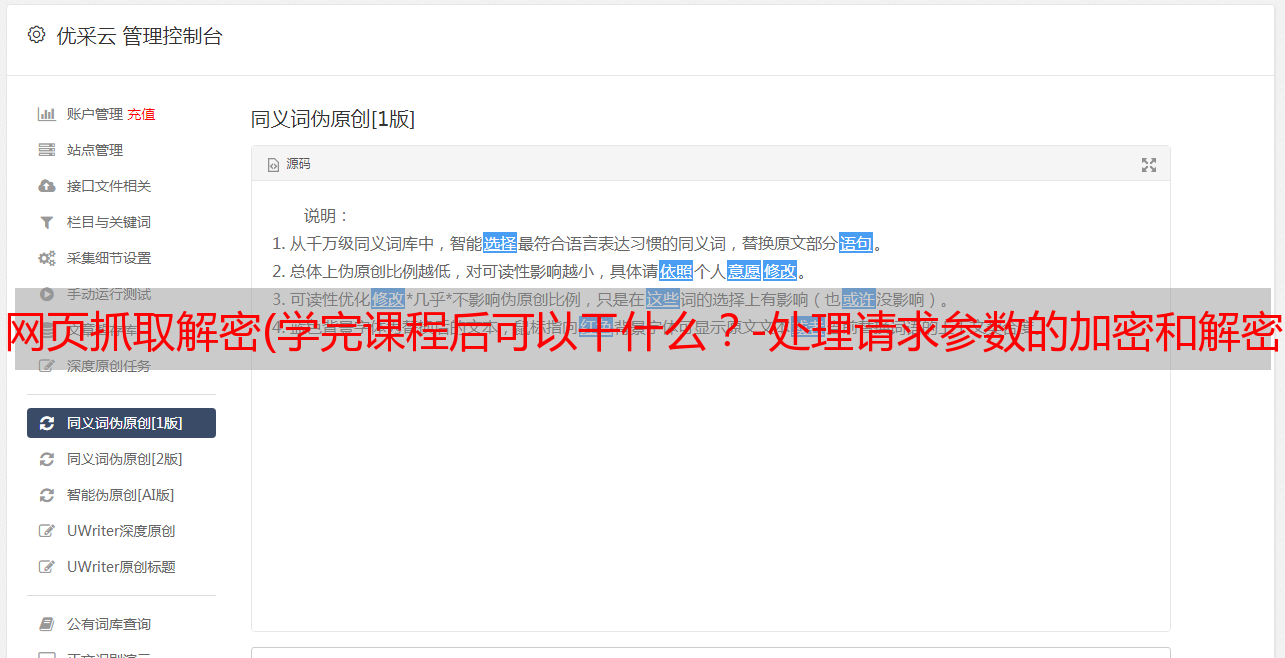

完成课程后我可以做什么?

- 处理请求中动态变化的请求参数

- 实现请求参数的加解密操作

- 轻松跳过所有形式的登录验证(刷卡验证等)

- 破解加密响应数据

- ......

爬虫是个奇妙的东西,这也是python的魅力所在——用非常简单的代码,你就可以创建一个强大的爬虫来爬取你想要采集的信息,将人类的双手从重复的工作中解放出来。但是,很多初学者往往在理解爬虫的基本原理上下了不少功夫。一段时间以来,在学习python爬虫的过程中积累了很多经验。我将在这里稍微总结一下,希望能够给你所有的开始。给学者一点启示。

爬虫(又称网络蜘蛛、网络机器人,在 FOAF 社区中,更常称为网络追逐者);它是按照一定的规则自动抓取网页信息的程序或脚本。

如果我们把互联网比作一个大蜘蛛网,电脑上的数据是蜘蛛网上的猎物,而爬虫是小蜘蛛,它们沿着蜘蛛网抓取他们想要的猎物/数据。

概念

Requests 是 Python 爬虫非常常用的库。它基于urllib编写,采用Apache2 Licensed开源协议的HTTP库。Requests 相比 urllib 和 urllib3 更方便,可以为我们省去很多工作,所以建议新爬虫从 Requests 库入手。

Requests 库主要使用 post() 方法和 get() 方法来获取网页数据。

post() 一般用于将特定参数传递给网站,以获得特定的结果。该参数是指网站必须接受的参数,根据这些参数返回不同的结果。比如百度翻译,传入不同的内容,返回不同的翻译。

get()方法一般不需要网站设置的具体参数,可以传入url、headers、roxies等通用参数(主要用于伪装浏览器、反爬虫等,注意以上具体参数)。url 是 网站 链接;headers为网站请求头,也可以通过浏览器检测功能获取;proxies 就是代理,后面的教程会讲解。