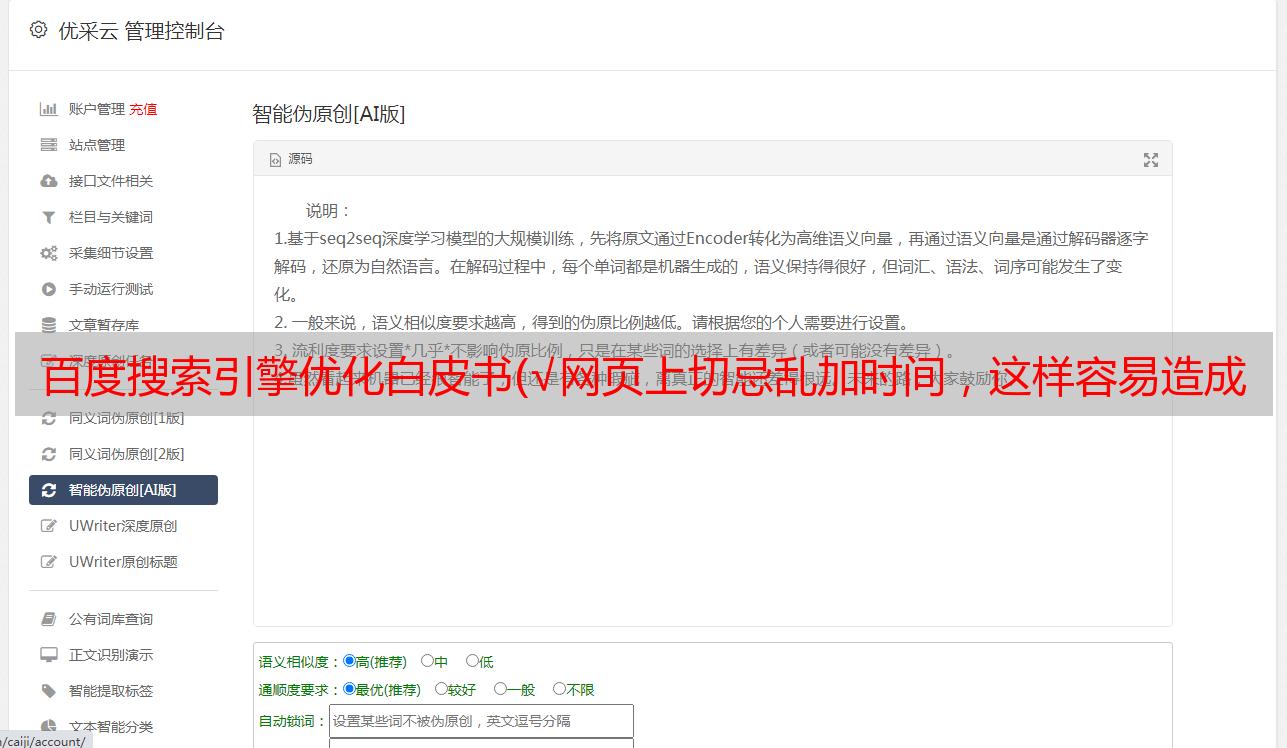

百度搜索引擎优化白皮书(√网页上切忌乱加时间,这样容易造成页面时间提取问题)

优采云 发布时间: 2022-04-08 06:17百度搜索引擎优化白皮书(√网页上切忌乱加时间,这样容易造成页面时间提取问题)

√ 不要在网页上随意添加时间,容易造成页面时间提取问题,或者搜索引擎判断提取时间不可靠,从而降低网页的展示效果

3.2.1.4 个规范标签

规范标签的目的

在PC互联网时代,规范标签主要用于解决相同内容在不同URL形式下造成的内容重复问题。在移动时代,规范标签被百度搜索赋予了更多的意义。在原有功能的基础上,还起到了移动端页面与PC端相同内容页面关联的作用;让移动资源更容易继承PC资源。使网络数据快速生效的各种功能。

如何设置规范标签

将 rel="canonical" 添加到 HTML 代码的头部,不能添加多个,否则搜索引擎会将其视为无效的规范标签。另外需要注意的是,href中的地址不能是死链接、错误页面或者被robots屏蔽的页面。

具体示例如下:

3.2.2登陆页面体验

为提升移动搜索整体用户体验,提升搜索满意度,百度搜索于2017年推出《百度移动搜索落地页体验白皮书——广告2.0》(以下简称广告白皮书) . 广告白皮书对网站移动落地页广告的内容、位置、大小等方面做出明确要求,充分保障搜索用户的浏览体验。

白皮书详情请参考《百度移动搜索登陆页面体验白皮书-广告2.0》

3.3 页值

3.3.1内容值

原创文章,创作要求独立完成,不得歪曲、篡改、抄袭或抄袭。需要足够的评论、补充和其他增益信息。

建议原创文章在标题下明确注明“来源:xxxx(本站站点名称)”或“本站原创”,转载文章用明确说明 不建议使用“admin”、“webmaster”、“anonymous”等模糊术语。

3.3.2外链搭建

一般认为,外部链接是从本站到第三方网站页面的链接,是本站对第三方网站页面内容的认可和推荐。

网站在搭建外链时,建议有真实的推荐意图,指向那些熟悉的、认可的、与内容相关的外链;不建议推荐与本站页面内容无关的外部链接。也不建议随意推荐外链、交换外链、指向作弊网站(这些很可能被超链策略反向识别为垃圾作弊网站进行压制)。

最后,站长应该及时发现和处理被黑页面。页面被黑后,会在页面上人为放置大量不相关甚至作弊的外部链接。目的是为了瓜分网站自身的权重,从而增加外链目标网站的影响力。建议站长在发现后及时将死链接提交到搜索资源平台(原站长平台)进行删除和屏蔽。不及时处理会在一定程度上影响网站本身的权重。最好在技术上进行优化,提高站点安全屏障,未雨绸缪。

3.3.3 内部链构造

内部链接描述网站的结构,一般起到页面内容组织和站内引导的作用;内部链接的重要意义是指向并告诉搜索引擎哪个页面最重要。

组织内链时,建议结构清晰,不要太复杂。另外,内链组织的布局建议保持一致,对搜索引擎超链接分析更友好。

与外链类似,建议站长善用nofollow标签,不仅对搜索引擎友好,还可以避免网站本身的权重受到垃圾链接的影响。

3.3.4anchor

锚点描述:尽可能使用典型的、有意义的锚点。锚点描述要与超链接页面的内容大致一致,避免使用高频无意义的锚点。此外,同一个 URL 的锚点描述类型不应该太多。锚点分布越稀疏,搜索排名越低。

上一篇:百度发布《移动搜索网站优化白皮书》:网站建设

下一篇:百度发布《移动搜索网站优化白皮书》:域名替换、HTTPS改造等

站长之家() 注:上篇文章主要阐述了移动网站建设的一般流程,包括:域名选择、服务器选择、网站安全等方面。本文主要涉及《百度移动搜索网站优化白皮书》中的“网站优化”方面。

以下是内容详情:

3网站优化

3.1 抓取友好度

关于爬取的优先级,这里强调一下:

√网站更新频率:频繁更新高价值网站,优先爬取

√人气:用户体验好的网站会被抢先

√ 优质入口:优质站内链接,优先抓取

√历史捕获效果越好,优先捕获越高

√ 稳定服务器,优先爬取

√网站有优质安全记录,优先抢夺

平滑稳定的爬取是网站获取搜索用户和搜索流量的重要前提,影响爬取的关键因素,站长可以通过本章了解。

3.1.1URL 规范

网站的URL如何设置,请参考2.3.1中的URL设置规范

3.1.1.1 个参数

URL中的参数放置需要遵循两点:

√ 参数不能太复杂

√ 不要使用无效参数。参数无效会导致页面识别问题,搜索时不会显示页面内容。

此外,很多站长使用参数(参数对搜索引擎和页面内容无效)来统计网站访问行为。这里要强调的是,这种形式的资源尽量不要出现,比如:

要么:

;NTESnmtpSI=-8010#/app/others/details?editId=&articleId=578543&articleType=0&from=sight

3.1.2找到链接

3.1.2.1 百度蜘蛛

很多站长会问怎么判断百度手机蜘蛛。这里推荐一个方法:只需两步就能正确识别百度蜘蛛

查看 UA

如果UA错了,可以直接判断不是百度搜索的蜘蛛。到目前为止已宣布的 UA 是:

移动 UA 1:

Mozilla/5.0 (Linux;u;Android 4.2.2;zh-cn;) AppleWebKit/534.46 (KHTML,likeGecko) 版本/5.1 Mobile Safari/10600.6.3(兼容;Baiduspider/2.0;+search/spider.html)

移动 UA 2:

Mozilla/5.0 (iPhone; CPU iPhone OS 9_1 像 Mac OS X) AppleWebKit/601.1.46 (KHTML, 像 Gecko) 版本/9.0 移动/ 13B143Safari /601.1

(兼容;百度蜘蛛渲染/2.0;+)

个人计算机 UA 1:

Mozilla/5.0 (兼容;百度蜘蛛/2.0;+)

个人计算机 UA 2:

Mozilla/5.0(兼容;Baiduspider-render/2.0;+spider.html)

检查IP

站长可以通过DNS反查IP判断蜘蛛是否来自百度搜索引擎。不同平台的验证方式不同。例如Linux/Windows/OS三种平台下的验证方式如下:

Linux平台下,可以使用hostip命令反向IP判断是否是从百度蜘蛛爬取的。百度蜘蛛的主机名以 *. 格式,如果不是 *. 是模仿。

这里有必要说明一点。建议使用DNS替换成8.8.8. 8,然后进行反向nslookup解析。否则很可能会出现不退货或退货错误的问题。

在Windows平台上,可以使用nslookup ip命令反向IP判断是否是从百度蜘蛛爬取的。打开命令处理器,输入nslookupxxx.xxx.xxx.xxx(IP地址)解析IP,判断是否是从百度蜘蛛爬取的。百度蜘蛛的主机名以*.的格式命名,如果不是*. 是模仿。

在MacOS平台下,网站可以使用dig命令破译IP,判断是否是从百度蜘蛛爬取的。打开命令处理器,输入digxxx.xxx.xxx.xxx(IP地址)解析IP,判断是否是从百度蜘蛛爬取的。百度蜘蛛的主机名以*.的格式命名,如果不是*. 是模仿。

3.1.2.2链接提交

链接提交工具是网站主动向百度搜索推送数据的工具。网站使用链接提交可以缩短爬虫发现网站链接的时间。目前,链接提交工具支持四种提交方式:

√ 主动推送:最快的提交方式。建议通过这种方式立即将站点新的输出链接推送到百度,保证新的链接能被百度及时抓取。

√Sitemap:网站可以定时将网站链接放入Sitemap,然后将Sitemap提交给百度。百度会定期对提交的Sitemap进行爬取检查,并对其中的链接进行处理,但爬取速度比主动推送慢。

√ 手动提交:如果不想通过程序提交,可以通过这种方式手动提交链接到百度。

√自动推送:轻量级的链接提交组件。自动推送的 JS 代码放置在网站各个页面的源码中。当页面被访问时,页面链接会自动推送给百度,有利于新页面快速被百度接受。找。

简单来说:建议有新闻属性的网站使用主动推送进行数据提交;新的验证平台站点,或者对内容没有时效要求的站点,可以使用Sitemap提交网站所有使用Sitemap的内容;技术能力弱,或者网站对于内容较少的网站,可以手动提交数据;最后,还可以使用插件模式自动推送数据到百度

3.1.3 网页抓取

3.1.3.1访问速度

在手机页面的访问速度方面,百度搜索资源平台于2017年10月推出闪电算法,为页面首页的打开速度提供战略支持。闪电算法中指出,移动搜索页面首屏的加载时间会影响搜索排名。如果移动端页面首屏加载时间在2秒以内,则在移动端搜索下获得提升页面评价的优惠,流量会出现倾斜。压制。

以下是加快页面访问速度的一些建议:

资源加载:

√ 在服务器端压缩合并同类型资源,减少网络请求数和资源量。

√ 参考常用资源,充分利用浏览器缓存。

√使用CDN加速将用户请求引导到最合适的缓存服务器。

√ 折叠图像类加载下方,为折叠请求留出网络带宽。

页面渲染:

√ 在头部样式表中写入 CSS 样式,减少网络请求 CSS 文件造成的渲染阻塞。

√ 将 JavaScript 放在文档末尾或异步加载,避免 JS 执行阻塞渲染。

√ 为非文本元素(如图片、视频)指定宽度和高度,避免浏览器重排和重绘。

希望站长继续关注页面加载速度体验,根据网站自身情况,参考建议自行优化页面,或者使用通用加速方案(如MIP) ) 不断优化页面首屏的加载时间。

了解MIP-Mobile Web Accelerator,请参考:《如何使用MIP快速搭建用户友好的移动页面》

3.1.3.2返回码

HTTP 状态码是一个 3 位数的代码,用于指示 Web 服务器的 HTTP 响应状态。在日常维护网站的过程中,站长可能会在站长工具后台抓取异常或者服务器日志中看到各种响应状态码,其中有的甚至会影响网站的SEO效果,比如强调网页404设置,百度搜索资源平台(原百度站长平台)中的一些工具,比如死链接提交,需要网站提交死链接后的内容,这里的设置必须是404。

以下是一些常见的 HTTP 状态代码:

301:(永久移动)请求的网页已永久移动到新位置。当服务器返回此响应(作为对 GET 或 HEAD 请求的响应)时,它会自动将请求者重定向到新位置。

302:(临时移动)服务器当前正在响应来自不同位置的网页的请求,但请求者应继续使用原创位置进行将来的请求。此代码类似于响应 GET 和 HEAD 请求的 301 代码,并自动将请求者重定向到不同的位置。

这里强调301和302的区别:

301/302 之间的主要区别是:此资源是否存在/有效

301表示资源还在,但是位置变了,返回新位置的内容。

302表示资源暂时失效,返回一个临时替换页面(如镜像资源、首页、404页面)。请注意,在永久失败的情况下应使用 404。

有时站长认为百度对302不友好,这可能是对302处理仍然有效的资源的滥用。

400: (Bad Request) 服务器不理解请求的语法。

403:(禁止)服务器理解请求,但拒绝执行。

404:(未找到)服务器找不到请求的网页。

这里不得不提一下,很多站长想要自定义404页面,需要保证蜘蛛访问时返回状态码是404。认为网站上出现了大量重复页面,从而影响了对网站的评价。

500:(内部服务器错误)服务器遇到错误,无法完成请求。

502: (Bad Gateway) 服务器作为网关或代理,收到上游服务器的无效响应。

503:(服务不可用)服务器当前不可用(由于过载或停机维护)。通常,这只是一个暂时的状态。

504: (Gateway Timeout) 服务器作为网关或代理,没有及时收到上游服务器的请求。

3.1.3.3 个机器人

robots工具的详细工具使用说明请参考4.3.4robots工具章节。关于机器人的使用,只强调以下两点:

√ 百度蜘蛛目前在robots中不支持中文,所以不建议在写网站robots文件时使用中文

√robots文件支持UrlEncode编码,如%E7%89%B9%E6%AE%8A:%E6%B5%8F%E8%A7%88/%E7%94%9F%E6%AD%BB% E7% 8B%99%E5%87%BB:%E7%99%BD%E9%93%B6%E5%8A%A0%E7%89%B9%E6%9E%97

3.1.3.4 个死链接

当网站死链接数据积累过多,显示在搜索结果页面时,对网站自身的访问体验和用户转化都有负面影响。另一方面,百度查死链接的过程也会给网站带来额外的负担,影响网站其他正常页面的爬取和索引。

百度搜索资源平台推出了死链提交工具,帮助网站提交死链数据。

搜索资源平台收到多位站长反馈,称网站从百度搜索中消失,网站发现网站的数据为0。

经查,这些网站都使用了某国外品牌的DNS服务器*.DOMAINCONTROL.COM。这一系列的DNS服务器存在稳定性问题。百度蜘蛛经常无法解析IP。在百度蜘蛛看来,网站 是一个死站。小型DNS服务商屏蔽百度蜘蛛解析请求或国外DNS服务器不稳定的案例已经屡见不鲜。所以这里建议网站,慎重选择DNS服务。

蜘蛛禁令

禁止爬虫会导致爬虫认为网站无法正常访问,然后采取相应措施。爬虫禁令其实有两种,一种是传统的机器人禁令,一种是需要技术人员配合的IP禁令和UA禁令;并且在大多数情况下,禁令是由于操作不当造成的。搜索引擎上的响应是爬虫无法正常访问。因此,爬虫禁令的操作必须谨慎。即使因为访问压力暂时被封禁,也必须尽快恢复。

服务器负载

除了服务器硬件问题(不可避免)之外,导致服务器负载过大的大多数情况都是由软件程序引起的。比如程序有内存泄漏、程序有核、服务混用不合理(其中一个服务消耗服务器资源过多。服务器负载增加,影响服务器对爬虫访问请求的响应)。提供服务时,一定要注意服务器负载,并留出足够的缓冲区,保证服务器有一定的抗压能力。

其他人为因素

人为操作不当导致访问异常的现象屡见不鲜。这种情况需要严格的制度约束,不同地点的情况不同。必须确保每次升级或操作都是准确的。

3.1.5可访问链接总数

3.1.5.1资源可以耗尽

一般来说,网站的内容页是可以穷尽的,10000、1000000甚至100000000的级别,但必须是可穷尽的。现实中确实有一些网站,爬虫在为这些网站抓拉链条的时候会掉进一个“链接黑洞”;;典型的是网站的一些搜索结果页面。不同的查询在不同的anchor下有不同的a标签链接,从而导致“链接黑洞”的产生,因此严禁生成带有用户访问行为的URL或搜索词等绑定因素。

3.2页分析

页面解析,主要是指网站页面被蜘蛛爬取,会对页面进行分析识别,称为页面解析。页面解析对网站 非常重要。网站内容的爬取是网站被发现的第一步,而页面解析则是网站内容的识别。一个重要的部分,页面分析的效果直接影响搜索引擎对网站的评价。

3.2.1 个页面元素

3.2.1.1 页面标题

网页标题方面,百度搜索于2017年9月推出清风算法,重点打击网站标题作弊、引导用户点击、损害用户体验;清风算法重点打击的标题作弊情况如下:

√文字不正确,网站标题明显与文字不符,误导搜索用户点击,对搜索用户造成伤害

√ 大量堆叠,网站大量堆叠标题中的关键词也很劝阻

网站标题作弊详细解读,请参考搜索学院发布的官方文档《百度搜索内容质量白皮书-网页标题作弊详解》

关于网站TDK,需要注意以下几种情况:(“T”代表页眉中的title元素,“D”代表页眉中的description元素,“K”代表页眉中的keywords元素页眉,只需参考网站的标题、描述和摘要)

√ 百度不承诺严格按照标题和描述的内容显示标题和摘要,尤其是摘要。根据用户检索到的关键词,会自动匹配并显示相应的摘要内容,让用户了解网页的主要内容,影响用户的表现。行为决策。

√ 站长会发现同一个链接的摘要在不同的关键词下会发生变化,这可能并不完全符合站长的期望,尤其是当站长在搜索框中进行站点语法操作时,他可能会觉得摘要是相对不同的区别。不过不用担心,毕竟绝大多数普通网友是不会这样做的。在这种情况下,出现意外摘要并不意味着对网站的惩罚。

√ 还有一种情况,网页中的HTML代码错误,导致百度无法解析出摘要,所以有时候会看到一些结果的摘要是乱码(当然这种情况很少见),所以也请请教站长注意代码规范。

3.2.1.2主要内容

主要内容要注意两点。一是主要内容太长(一般网页源代码长度不能超过128k),文章太长,可能导致抓取被截断。它被判断为无价值的内容。

下面分析两个例子:

正文内容过长示例分析:

某网站的主要内容是JS生成的,并没有针对用户访问进行优化;而网站针对爬虫爬取做了优化,图片直接base64编码推送到百度。内容不被百度展示

页面质量非常好,专门针对爬虫进行了优化。为什么百度搜索不到内容?

分析的主要原因如下:

√网站爬虫爬取的优化是直接将图片base64编码放入HTML,导致页面长度过长,网站页面长度可达164k;

√ 网站优化后,主要内容放在最后,但图片放在最前面;

√ 爬虫爬取内容后,页面内容过长被截断,被爬取部分无法识别主要内容,最终导致页面被识别为空短不被索引。

在这种情况下,给出以下建议:

√ 如果网站做了爬虫爬取优化,建议网站的源码长度在128k以内,不要太长

√ 针对爬虫抓取进行了优化,请将主要内容放在前面,避免抓取截断导致内容抓取不完整

空短内容示例分析:

某网站报告网站的内容没有被索引。分析发现网站的爬取没有问题,但是被爬取的页面提示输入验证码查看所有页面。此类页面被判定为空短页,爬取后这些页面将被判定为垃圾页面。