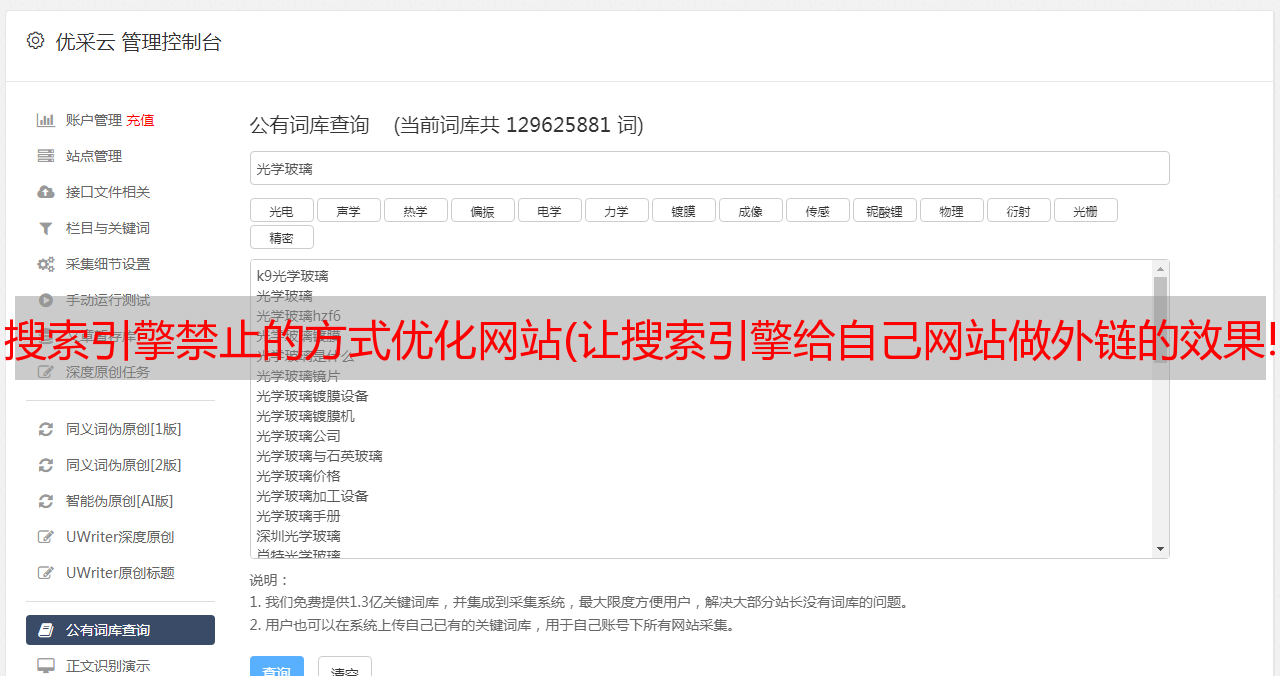

搜索引擎禁止的方式优化网站(让搜索引擎给自己网站做外链的效果!(图))

优采云 发布时间: 2022-04-05 08:03搜索引擎禁止的方式优化网站(让搜索引擎给自己网站做外链的效果!(图))

我们知道,搜索引擎的产品线很长,多个产品不可能完美配合。因此,robots.txt的limit收录存在一个漏洞可以利用。

原理分析(以搜狗为例)

搜狗已经屏蔽了各个搜索引擎的搜索结果页面。其中,“/sogou?”、“/web?” 其他路径是结果页面的路径。那么,会不会出现这种情况呢?搜狗还有其他搜索结果页面路径,但是没有在robots.txt中声明 屏蔽?为了验证这个猜想,我们在百度搜索了搜狗。

我们可以看到“/sie?” 和“/sgo?” 是搜狗搜索结果页面的路径,但在robots.txt文件中并没有声明屏蔽!也就是说,允许搜索引擎搜索具有这种路径的页面。收录,如果这样一个页面的搜索结果都是你自己的网站呢?这样就达到了让搜索引擎网站为自己做外链的效果!

那么问题来了?如果所有搜索结果都是您自己的网站怎么办?很自然地想到现场搜索!具体如何查找站内搜索参数请自行搜索相关资料,这里直接说明结果:搜狗站内搜索参数为insite,然后组装成这样的URL:

当这个 URL 可以是 收录 时,这个页面的所有搜索结果都指定为 网站,类似的 URL 在互联网上传播。蜘蛛爬取之后,最终会被存入数据库并被索引。达到了我们的目的:让搜索引擎给出自己的网站链接。

写在最后

这种方法时效性不是很高,很多人用了之后就会固定下来。之所以说清楚原理,是为了描述黑帽法的发现过程。黑帽不是单纯的做站群、群发外链什么的,更多的是利用搜索引擎本身的漏洞进行优化。本文只是一个非常简单的黑帽方法发现过程的示例。更多的大神都非常低调,他们发现的方法并没有在网上流传开来。这篇文章只是为了让大家多了解一下黑帽,并不是鼓励大家使用黑帽优化网站,不仅伤害了用户,也给互联网带来了更多的污染。