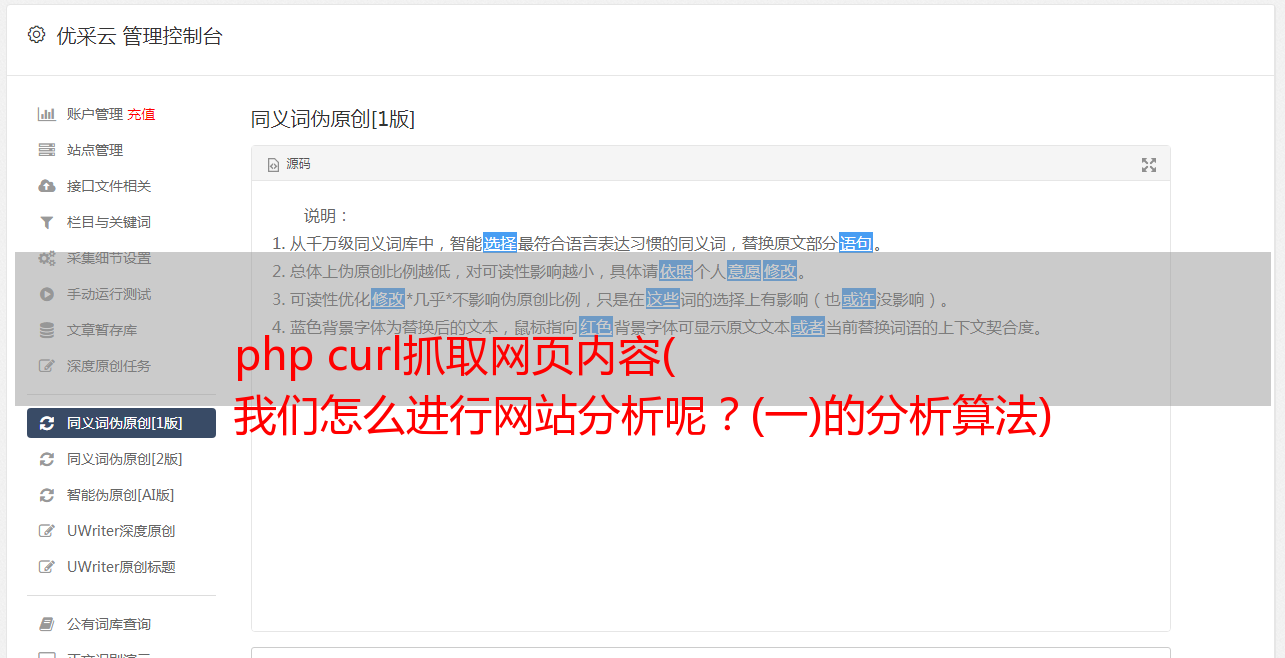

php curl抓取网页内容( 我们怎么进行网站分析呢?(一)的分析算法)

优采云 发布时间: 2022-04-04 06:13php curl抓取网页内容(

我们怎么进行网站分析呢?(一)的分析算法)

我们如何网站分析?

首先,如果你想编程抓取网页并保存在本地,你需要使用socket编程,或者学习使用libcurl库。这些比学习html语言有用得多。在不做网页爬虫的时候,这个知识还是很有用的。. 而且,不同的网页有不同的内容,可能有不同的规则。比如你给的例子网址,我右键查看源码,里面没有所谓的“标签”,也就是它的形式不是通过这些标签来实现的。所以,让你看这些标签是完全不同的。

网页分析,归根结底就是字符串的处理和分析。因此,如果你真的想学习,最好学习一下正则表达式和字符串处理相关的函数,还有函数库,比如tidy库。正则表达式用于匹配一种类型的字符串,易于查找模式,易于处理。当您学习一点时,您就会知道它们是多么强大和有用。而且,正则表达式与语言无关,任何语言都可以用,学这个也不亏。

标准 C 库中没有与正则表达式相关的函数。一般来说,C中使用了两个正则表达式库,一个是POSIX C正则库,一个是perl正则库PCRE。相比之下,PCRE 更强大,POSIX C 正则库就足够了。

其次,在进行网页分析时,还必须对算法有一定的了解:

(1)基于网络拓扑的分析算法:基于网页之间的链接,通过已知的网页或数据,到与其有直接或间接链接关系的对象(可以是网页或网站等)来评估算法。进一步分为三种类型:网页粒度、网站粒度和网页块粒度。

(2)基于网页内容的网页分析算法:基于网页内容的分析算法是指利用网页内容的特征(文本、数据等资源)对网页进行评价。,发展到主动态页面(或称为隐藏网络)数据,后者的数据量约为直接可见页面数据(PIW,public Indexable Web)的400到500倍。

以上就是《我们如何进行网页分析?》的大致介绍,希望对大家有所帮助!