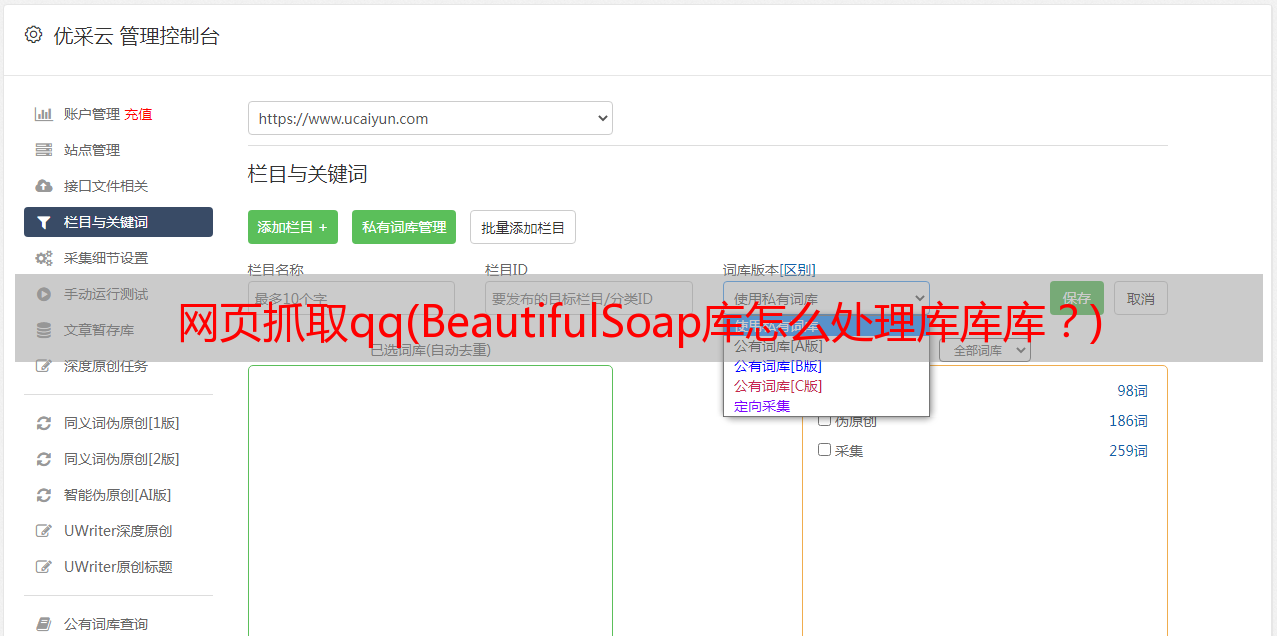

网页抓取qq(BeautifulSoap库怎么处理库库库?)

优采云 发布时间: 2022-04-01 10:02网页抓取qq(BeautifulSoap库怎么处理库库库?)

标签下

之后,我们将处理我们刚刚请求的 html 代码。这时候,我们就需要用到 BeautifulSoap 库了。

soup = BeautifulSoup(wbdata,'lxml')

这一行的意思是解析获取到的信息,或者把lxml库换成html.parser库,效果是一样的

news_titles = soup.select("div.text > em.f14 > a.linkto")

这一行使用刚刚解析的soup对象来选择我们需要的标签,返回值是一个列表。该列表收录我们需要的所有标签内容。也可以使用 BeautifulSoup 中的 find() 方法或 findall() 方法来选择标签。

最后使用for in遍历列表,取出标签中的内容(新闻标题)和标签中href的值(新闻URL),存入数据字典

for n in news_titles:

title = n.get_text()

link = n.get("href")

data = {

'标题':title,

'链接':link

}

数据存储所有新闻标题和链接。下图是部分结果。

这样一个爬虫就完成了,当然这只是最简单的爬虫。如果深入爬虫,有很多模拟浏览器行为、安全问题、效率优化、多线程等需要考虑。不得不说,爬虫是个深坑。

python中的爬虫可以通过各种库或框架来完成,请求只是比较常用的一种。还有很多其他语言的爬取库,比如php可以使用curl库。爬虫的原理是一样的,只是不同语言和库使用的方法不同。