搜索引擎主题模型优化(如何克服传统信息检索中文档相似度计算方法的缺点)

优采云 发布时间: 2022-03-22 00:15搜索引擎主题模型优化(如何克服传统信息检索中文档相似度计算方法的缺点)

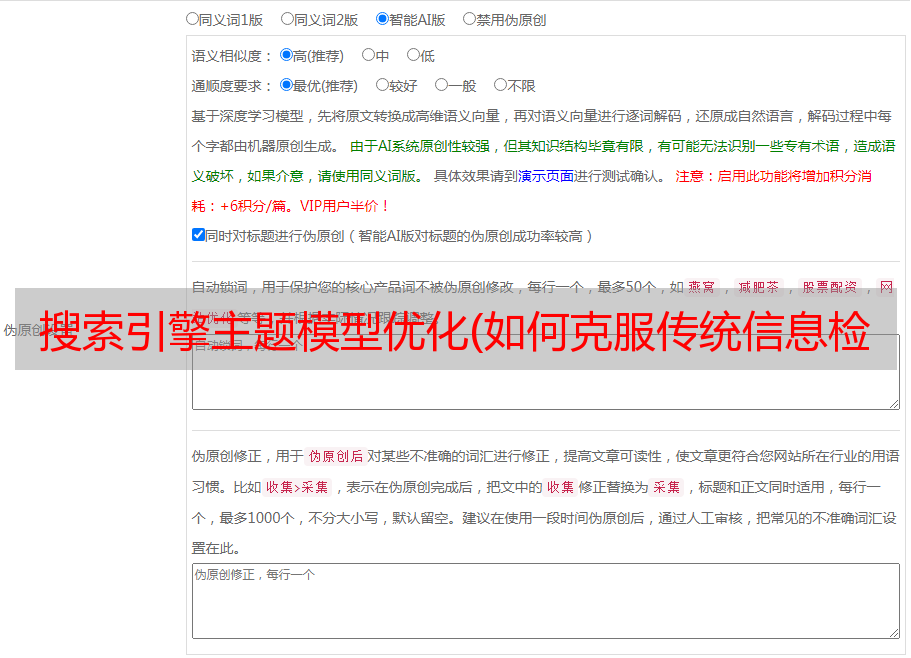

有时候我们在做SEO写作的时候,经常会强调原创文章的重要性,同时我们在网站优化中也需要避免重复的内容,但是有时候,我们看到的是表面上的问题不是而且实际上是一种情况,如果你想尝试研究页面的相关性,我想你可能需要仔细阅读以下内容:

两个文档是否相关往往不仅取决于单词的字面重复,还取决于单词背后的语义关联。挖掘语义关联可以使我们的搜索更加智能。本文重点介绍一个强大的语义挖掘工具:主题模型。主题模型是对文本隐含主题进行建模的方法。它克服了传统信息检索中文档相似度计算方法的不足,能够在海量互联网数据中自动发现词间语义主题。近年来,各大互联网公司都开始在这方面进行探索和尝试。让我们来看看。

关键词:主题模型

技术领域:搜索技术、自然语言处理

假设有两个句子,我们想知道它们是否相关:

第一个是:“乔布斯离开了我们。”

第二个是:“苹果的价格会下降吗?”

以人类来看,我们一眼就能看出,这两个句子虽然没有任何共同词,但还是很有关联的。这是因为,虽然第二句中的“苹果”可能指的是被吃掉的苹果,但既然第一句中有“乔布斯”,我们自然会将“苹果”理解为苹果的产品。事实上,搜索引擎算法中经常会遇到文本句子之间的相关性和相似性问题。例如,用户输入查询,我们想从海量网络库中找到最相关的结果。这是如何衡量查询和网页之间的相似度的问题。对于这样的问题,人们可以根据上下文来判断。但是机器能做到吗?

在传统的信息检索领域,实际上有很多衡量文档相似度的方法,比如经典的VSM模型。然而,这些方法通常基于一个基本假设:文档之间重复的单词越多,它们就越有可能相似。在实践中并非总是如此。在许多情况下,相关程度取决于其背后的语义联系,而不是单词的明显重复。

那么,应该如何衡量这种语义关系呢?事实上,在自然语言处理领域,已经有很多方法可以从单词、短语、句子、章节的角度来衡量。本文将介绍语义挖掘的强大工具之一:主题模型。

什么是主题模型?

主题模型,顾名思义,是一种对文本中隐含主题的建模方法。在上面的示例中,单词“apple”既收录 Apple 主题,也收录水果主题。对比第一句话,苹果的话题与“乔布斯”所代表的话题相匹配,所以我们认为它们是相关的。

在这里,让我们首先定义什么是主题。主题是一个概念,一个方面。它以一系列相关词的形式出现。比如一个文章涉及到“百度”这个话题,那么“中文搜索”、“李彦宏”等词出现的频率就会更高,而如果涉及到“IBM”这个话题,那么“笔记本”出现的频率就会更高。 “它会经常发生。用数学来描述它,主题是词汇表中单词的条件概率分布。与主题越密切相关,其条件概率越高,反之亦然。

例如:

通俗地说,一个话题就像一个“桶”,里面收录了很多出现概率很高的词。这些词与主题之间有很强的相关性,或者更确切地说,正是这些词共同定义了主题。对于一篇文章,有些词可以来自这个“桶”,有些可能来自那个“桶”,而一段文字往往是几个主题的混合。我们举个简单的例子,见下图。

以上摘自网络新闻。我们分为 4 个桶(主题),百度(红色)、微软(紫色)、谷歌(蓝色)和 Marketplace(绿色)。段落中收录的每个主题的单词都用颜色编码。从颜色分布可以看出,文中的主要思想是谈百度和市场发展。里面也出现了谷歌和微软这两个话题,但不是主要语义。值得注意的是,百度、微软、谷歌这三个话题上很可能会出现“搜索引擎”这样的字眼。可以认为一个词被放入多个“桶”中。当它出现在文本中时,这三个主题都在一定程度上得到了体现。

有了主题的概念,我们不禁要问,这些主题究竟是如何得到的?如何分析文章中的话题?这正是主题模型要解决的问题。下面我简要描述主题模型的工作原理。

主题模型如何工作

首先,我们从生成模型的角度来看两件事,文档和主题。所谓生成模型,就是我们认为一个文章的每一个词都是通过“以一定的概率选择一个主题,并以一定的概率从这个主题中选择一个词”的过程得到的。的。那么,如果我们要生成一个文档,其中每个单词出现的概率为:

上式可以用矩阵乘法来表示,如下图所示:

左边的矩阵表示每个文章中每个单词出现的概率;中间的Φ矩阵表示每个主题中每个词出现的概率,也就是每个“桶”。

它表示每个文档中每个主题出现的概率,可以理解为每个主题在段落中所占的比例。

如果我们有很多文档,比如大量的网页,我们首先对所有文档进行分词,得到一个词汇表。这样,每个文档都可以表示为单词的集合。对于每个单词,我们可以用它在文档中出现的次数除以文档中的单词数作为它在文档中出现的概率。这样,对于任何文档,左边的矩阵是已知的,右边的两个矩阵是未知的。主题模型使用大量已知的“word-document”矩阵,通过一系列训练来推断正确的“word-topic”矩阵Φ和“topic-document”矩阵Θ。

主题模型训练和推理的方法主要有两种,一种是pLSA(Probabilistic LatentSemanticAnalysis),另一种是LDA(LatentDirichletAllocation)。pLSA主要使用EM(期望最大化)算法;LDA 使用 Gibbssampling 方法。由于都比较复杂,篇幅有限,这里只简单介绍一下pLSA的思想,其他具体的方法和公式,读者可以参考相关资料。

pLSA使用的方法称为EM(期望最大化)算法,它由两个迭代过程组成:E(期望)过程和M(最大化)过程。举个直观的例子:比如食堂的大厨炒了一道菜,分成两份给两个人吃。显然,没有必要使用秤来准确称重。最简单的方法是先。将菜肴随意分成两个碗,然后观察数量是否相同,取出较大的部分放入另一个碗中。重复这个过程,直到没人能看到两个碗里的菜。直到有任何不同。

对于主题模型训练来说,“计算每个主题的词分布”和“计算训练文档中的主题分布”就像是两个人分餐一样。在E过程中,我们可以通过贝叶斯公式从“word-topic”矩阵中计算出“topic-document”矩阵。在M过程中,我们使用“topic-document”矩阵重新计算“word-topic”矩阵。这个过程一直是这样迭代的。EM算法的神奇之处在于它可以保证这个迭代过程是收敛的。也就是说,经过反复迭代,我们肯定可以得到趋于真实值的Φ和Θ。

如何使用主题模型?

有了主题模型,我们如何使用它?它有什么优点?我总结了以下几点:

1)衡量文档之间的语义相似度。对于文档,我们发现的主题分布可以看作是它的抽象表示。对于概率分布,我们可以通过一些距离公式(如KL距离)计算两篇文档的语义距离,得到它们之间的相似度。

2)可以解决多义问题。回想第一个例子,“apple”可以是一种水果,也可以指苹果公司。通过我们得到的“词-主题”概率分布,我们可以知道“苹果”属于哪些主题,我们可以通过主题匹配来计算它与其他词的相似度。

3)它消除了文档中噪音的影响。一般来说,文档中的噪音往往是次要主题,我们可以忽略它们,只保留文档中的主要主题。

4)它是无人监督且完全自动化的。我们只需要提供训练文件,它就可以自动训练各种概率,无需任何人工标注过程。

5)它与语言无关。任何语言都可以被训练来获得它的主题分布,只要它可以分割它。

综上所述,主题模型是一个强大的工具,可以挖掘语言背后的隐藏信息。近年来,各大搜索引擎公司都开始重视这方面的研发。语义分析技术逐渐渗透到搜索领域的各种产品中。让我们看看在不久的将来我们的搜索将如何变得更智能。

蝙蝠侠IT转载需授权!