搜索引擎禁止的方式优化网站(海之睿:robots文件用于指令搜索引擎禁止抓取网站)

优采云 发布时间: 2022-03-21 15:23搜索引擎禁止的方式优化网站(海之睿:robots文件用于指令搜索引擎禁止抓取网站)

robots文件用于指示搜索引擎禁止爬取网站某些内容或指定爬取网站某些内容。因为robots文件是给搜索引擎的,用好可以增加搜索引擎抓取网站的体验,增加网站收录的数量。下面小编海之睿就为大家讲解正确设置robots文件对网站优化的意义。

1. 阻止 网站 的空链接、死链接

由于网站内容的修改和删除,很容易导致网站中的一些内部链接失效,变成空链接或死链接。通常,我们会定期检查网站上的空链接和死链接,将这些链接提取出来,写入robots文件,防止搜索引擎抓取链接,间接提升搜索引擎的体验。这种方法是有效的,因为在修改已经收录的内容时,搜索引擎会再次爬取修改后的网页,重新判断是否执行收录,如果不继续收录 ,那你一定要试试。

2.防止蜘蛛爬行网站重复内容

因为网站很多动态页面是收录搜索不到的,所以很多时候我们需要为这些动态页面开发一个静态页面来帮助搜索引擎收录。这个时候,让搜索引擎不要抓取一些重复的内容,这样可以减少网站中页面的权重竞争。

3. 防止蜘蛛抓取无意义的内容,浪费服务器资源

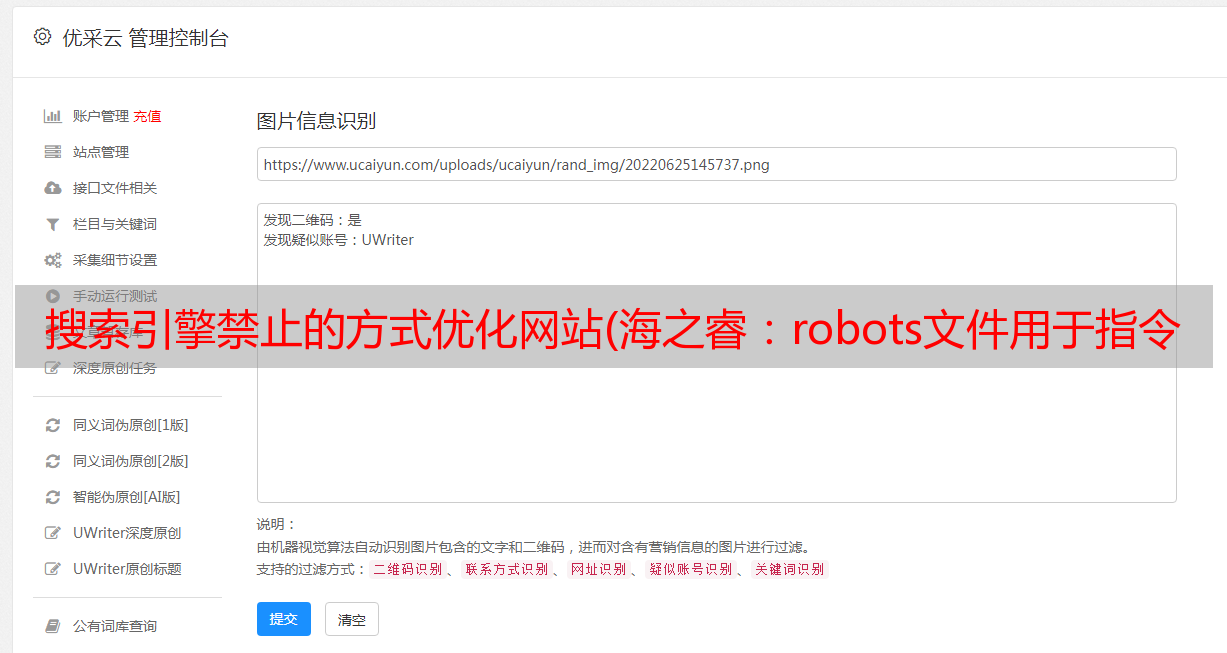

网站上有很多无意义的内容,比如网站的各种脚本代码、css文件和php文件,这些文件对于网站的优化都是很重要的,没有意义,爬取这些< @网站 不仅不会收录,还会浪费服务器资源。上图中很多禁止的内容就是这样无意义的文件目录。

4.保护网站隐私内容

网站有很多页面都有一定程度的隐私,比如用户接受的推送或者购物车等。虽然这些链接在一个页面中,但他们显然不希望搜索引擎抓取内容。

5. 便于 网站 调试

在 网站 初次启动之前,会出现一定的错误。需要一段时间调试,然后打开爬取到搜索引擎。在调试过程中,您可以将robots文件设置为拒绝所有搜索引擎抓取的状态。等到所有错误都解决后再修改 robots 文件。

总结:robots文件对于网站来说是很重要的东西,而这种文件往往对网站的排名起到致命的作用。相信通过上面的介绍,大家都明白正确设置robots文件的意义了。