2017搜索引擎优化规则(《搜索引擎是呈现网页的过程》之互联网之爬虫)

优采云 发布时间: 2022-03-21 05:022017搜索引擎优化规则(《搜索引擎是呈现网页的过程》之互联网之爬虫)

上次和大家分享“搜索引擎是呈现网页的过程”。不知道大家有没有有所收获或者有什么疑问。如果有,你们可以互相交流。您可以通过搜索万物网络工作室与我联系。

今天主要给大家分享一下搜索引擎工作第一环节的知识:互联网爬虫。我们先来看看它的定义:网络爬虫(也称为网络蜘蛛、网络机器人,在FOAF社区中,更常被称为追网者),是一种自动爬取万维网的爬虫。按照一定的规则上网。信息程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

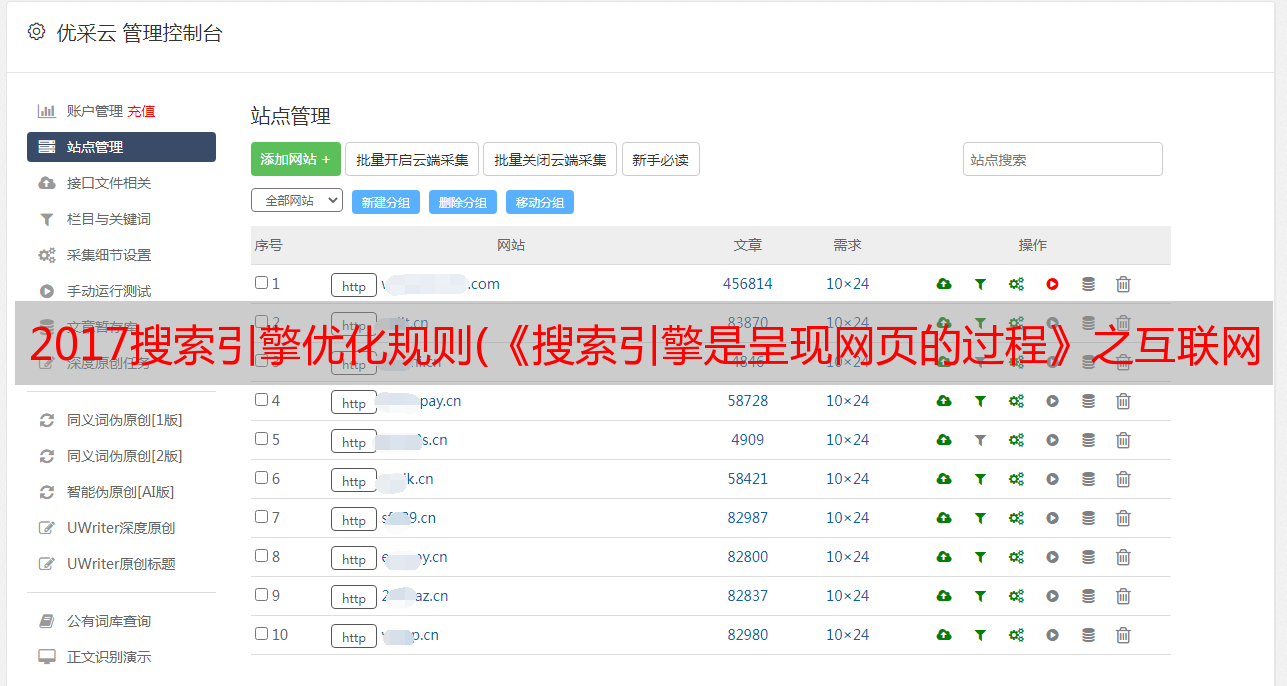

从上面的定义来看,百度蜘蛛和谷歌机器人都是爬虫的一种,而爬虫主要是按照一定的规则自动抓取信息的脚本或程序。这个不难理解,有经验的程序员可以独立编写一套比较完整的蜘蛛程序,用来采集网络信息,丰富自己的网站。其实很多资料采集软件也用到了这个技术。那么让我们来看看蜘蛛是做什么的:

每种资源都有对应的爬虫去采集,当然解析的方式也不同。我们经常可以在网站的日志中看到百度的spider和image-spider。不同的爬虫使用自己的规则来解析他们的页面。即便如此,我们可以看到爬虫在抓取页面的时候还是有一定的规律性的,而这种规律性来自于最大化搜索引擎效率的权衡。

广度优先遍历原则:这个原则从网站本身开始,按照网站的层级进行抓取。因为我们在做网站的时候都有一个优先级,比如我希望搜索引擎首先看到的是首页,然后是每个目录页,然后是内容页。蜘蛛也使用这个。抓住。不完整的pagerank排序:这个原理是用谷歌的pr值计算的。因为每个网页在谷歌中都会有一个分数,所以会根据这些分数的高低进行抓取。如果是全计算的话,会消耗更多的计算资源,所以pr值高的网页传输的链接一定是可靠的。OPIC(在线页面重要性计算):这个原理与pr值计算几乎相同。在采集网页中计算每个网页的重要性,然后优先抓取。大网站优先策略:这是毋庸置疑的。因为战争更符合信任的原则。

其实我们可以看到,这个原则其实是网页的有限爬取和无限爬取之间的一种折衷,也就是在有限的时间内爬取网络中更重要的页面和资源。当然,我们还需要了解网络爬虫的工作原理,这样更有利于我们的SEO优化。本文由凡世网络工作室原创整理,转载注明出处。