seo搜索引擎优化论文( 网络运营J先生2020-07-23本文内容偏技术细节)

优采云 发布时间: 2022-03-07 01:25seo搜索引擎优化论文(

网络运营J先生2020-07-23本文内容偏技术细节)

[seo优化] seo网站优化详解

网络运营J先生2020-07-23

这篇文章内容太多,内容技术性太强。适合阅读人群:seo从业者、网络运营商、企业相关负责人;

这是本文的大纲思维导图。以中小企业网站为例,家长可以根据自身情况选择性阅读相关内容:

一、网站三个元素

网站三要素主要包括:title、description、关键词,也有人称之为TDK(取三个词的首字母)。

1.标题标题

分析:页面的标题主要告诉用户这个网站是关于什么的,就像我们读一本书的标题或者一个文章,你大概可以知道这本书/这是什么< @文章 关于?页面标题首先显示在搜索结果页面上。个人认为,一个好的标题不仅包括品牌名称和关键词,最重要的是用短句把它们整合起来,可读性强,有特色,让用户一眼就能记住。

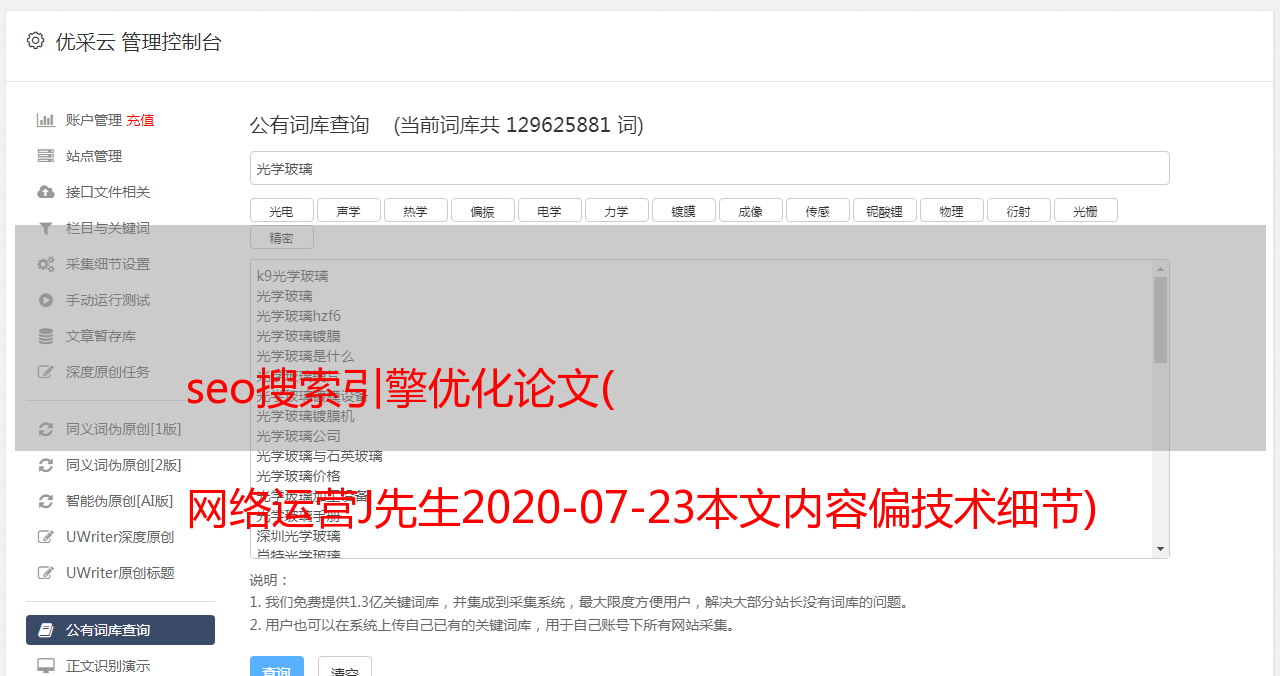

2.关键词 关键字

分析:页面关键词,没有显示搜索结果,放置在页面代码中供搜索引擎爬取,主要是告诉搜索引擎这个页面要解释哪个核心关键词内容,以及方便用户搜索,所以很重要,也很有技巧性和可操作性,体现了优化者的思想和营销策略。设置关键词的时候,记住关键词一定要和页面的主题相关,不要盲目追求流行的关键词,最好根据行业情况和关键词,公司的营销推广策略要制定,不要叠加关键词,不要为优化而优化。

3.说明

分析:页面内容摘要,会显示搜索结果,主要是告诉搜索引擎这个页面内容的摘要,原因与文章论文的摘要相同。设置页面描述时,可以结合标题和关键词的设置思路。另外,不要堆叠 关键词。可以适当添加长尾关键词,或者添加公司电话号码和公司特征。等,在注重整体优化的同时,可读性强,给客户留下深刻印象。

三元标签代码使用参考:

网站三要素是网站优化中非常重要的一步,但在做之前,必须做好以下三件事:

①竞品分析(至少5个以上同行/同品类网站);

②清楚了解公司网站定位及公司网络营销策略;

③明确网站页面结构,制定网站所有页面、长尾词、流量词引流策略;

完成竞争分析后,想想我们的客户正在寻找什么关键词 来解决他们想知道的问题。这样至少可以采集到8个候选关键词,然后根据关键词的搜索量、关键词的索引、竞争程度和公司营销策略,确定网站的优化关键词,不要拿到网站,根据自己的想法写出三个要素,否则影响很大;

二、网站结构合理化

网站结构的合理化涉及到网站的权重分布。在设计网站的结构时,应该尽可能的扁平。主页、栏目页、专题页、内容页要有简洁明了的规划,通过站点内的链接关系合理分配网站的权重,让重要的页面获得更大的权重,有利于对其 关键词 排名的竞争力。目前,最适合优化的网站结构是树形结构。为 网站 分配权重有助于蜘蛛爬行。建议链接层数不要超过3层,这样用户体验好,有利于蜘蛛爬取。如果层数太深,

三、静态页面设置

静态URL有利于搜索引擎的爬虫爬取内容,从而增加网站的收录,增加搜索引擎的友好度。

标准化的 URL 形式:在将 网站以 .htm、.shtml、.xhtml 或 .html 结尾的 URL 设为静态时,可以提供以下几点供您参考:

1、URL 中不要收录特殊字符

2、网址最好以关键词(英文)或中文拼音开头

3、网页文件和文件夹最好命名为网站关键词。

四、网站首选域和 301 重定向

首先我们要明白,我们首选域和301重定向的目的是为了更好的集中网站的权重,例如:当你访问网站和/或可以访问网站首页,那么网站的权重会很容易分散,都会被搜索引擎收录搜索到,如果你设置网站首选域和301重定向,让网站无论输入以上任何一种形式,都会直接跳转,让网站的权重集中在一点,也有利于搜索引擎的爬取和以后的SEO工作.

五、网站地图(站点地图,rssmap)和404页面设置

网站 地图,也称为站点地图,实际上是一个收录指向所有 网站 页面的链接的页面。当用户在网站上找不到需要的信息时,可以点击这个页面,非常清楚地看到网站上的所有页面。还有,像网站这样的搜索引擎非常喜欢地图,对搜索引擎收录和爬虫也很有好处。

其实你可以把网站地图理解为公园的游览地图或者书籍目录。试想一下,一进园区,园区工作人员就会给你发一张游览地图,这样你就知道整个园区的情况了,去哪都比较方便。

404页面设置

其实设置404页面就是怕部分用户进入网站的错误页面,或者输入错误的URL。设置404页面后,用户可以清楚的知道自己访问的页面有错误,可以返回或者返回首页重新浏览,不仅对用户体验有好处,对搜索引擎优化也很有好处,降低网站的跳出率。

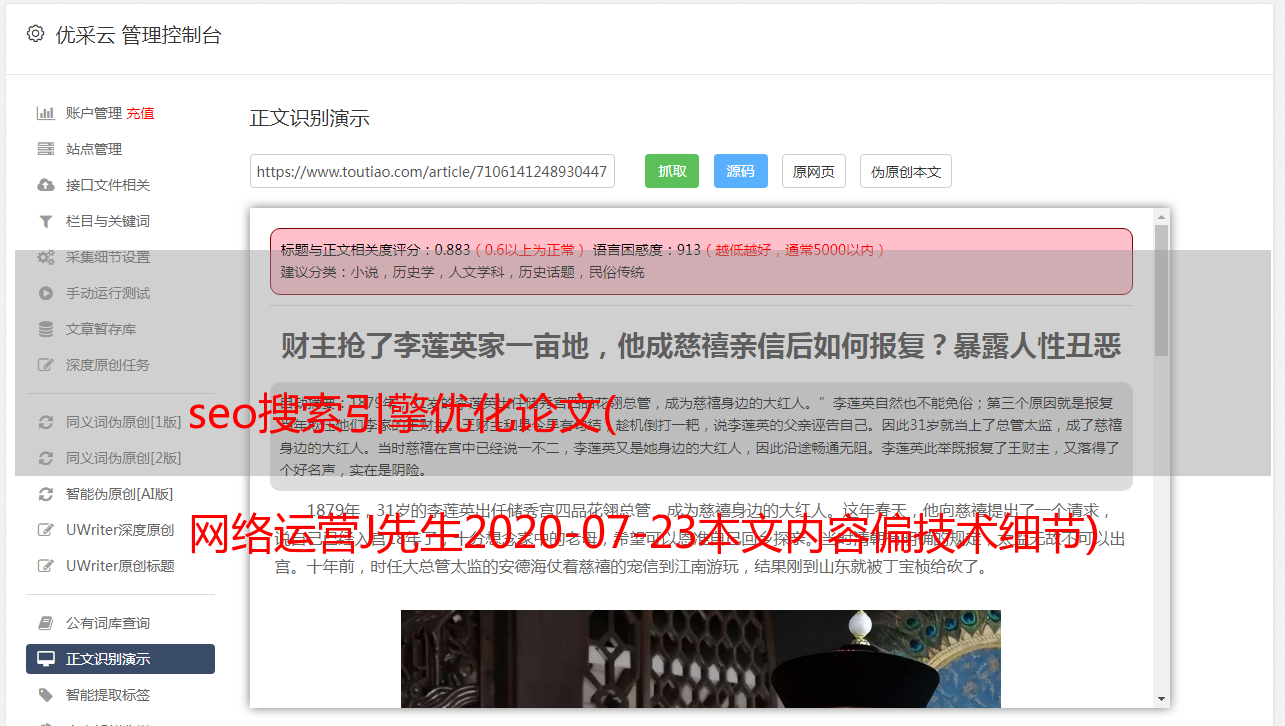

六、图片 Alt 属性设置

首先,我们需要了解搜索引擎非常喜欢文字内容。但是,它对于图片的可读性不是很好。我不知道图片是什么意思。所以看到这里有人会问,那摄影、图片素材类型网站怎么优化呢?搜索引擎虽然无法读取图片,但可以读取图片的alt属性。alt属性相当于告诉搜索引擎这是什么图片,这张图片是什么意思。图片的alt属性还有第二个作用,就是帮助用户浏览。当图片没有加载或者出现错误时,可以清晰的看到图片的alt属性的内容,从而判断会是什么样的图片。如果给文本链接加上title属性,效果会更好。从优化的角度,尽量少用图片代替文字。最好在上传图片前压缩下一个尺寸,这样打开速度会更快。如果将解压后的图片直接上传到网站,会影响网站的打开速度,从而影响用户和搜索。发动机经验。

图片加alt描述属性代码具体参考:

七、H1-H6标签设置合理

H1-H6标签主要告诉搜索引擎哪些是最重要的,哪些是次要的。为页面的主题使用标签。充分利用标签来指示内容的层次和描述内容的相似区域。注意不要在一个页面上使用多个标签。

其中,H1标签非常重要。可以说H1是除了title标签之外最重要的标签。只允许在页面上出现一次,搜索引擎首先抓取的是H1标签,一般给页面核心关键词,如果在文章@的标题上加H1 > 页面和产品页面会让搜索引擎立即知道该页面主题的重要性。H1标签对搜索引擎优化非常有利。但是,滥用标签可能会导致降级。

八、Nofollow 属性合理设置

nofollow 是 HTML 页面中 a 标签的属性值。它是由谷歌首创并得到百度、雅虎等主要搜索引擎广泛支持的“反垃圾链接”标签。nofollow 标签的作用有两个方面。简单来说,一是不给链接投票,降低链接权重,二是让添加nofollow的部分内容不参与网站的排名,方便集中<的权重@网站 ,以减少权重的分散。

我们在交换友链时,注意对方是否添加了nofollow标签。如果是,请立即取消兑换链接,因为他们这样添加的好友链对我们没有任何影响。

代码参考:

文字内容

九、面包屑、锚文本设置

面包屑导航一般出现在栏目页和内容页,主要是为了方便用户返回之前的分层页面,有利于用户体验,也便于内链搭建和关键词优化。

锚文本:简单来说就是一个带有链接的关键词。单击以跳转到目标页面。这里我们主要谈谈站点中的锚文本。它的主要作用是方便网站内链接的建设,引导搜索引擎抓取。,方便用户点击,提升用户体验,同时有利于网站的优化,提高关键词的排名。

关于锚文本设置,请注意以下几点:

1) 结合 SEO关键词 为信息页面添加锚文本超链接;

2)每页锚文本控制在1-3个以内,锚文本长度控制在30个汉字以内;

3) 链接页面应该与 关键词 高度相关;

4) 不要一直使用相同的 关键词 链接到 URL,尽可能多地使用不同的锚文本。使链接看起来更自然;

5) 对关键页面链接(首页、特殊页面等)应给予特殊处理;

十、代码优化

1、网站navigation网站的导航设计很重要(头部导航、底部导航、栏目页面级导航、面包屑导航等),尽量改用文字导航图片和flash等,如果一定要用图片,请加alt属性。尽可能避免闪光。虽然 Flash 看起来很酷,但它的加载速度非常慢,而且搜索引擎无法读取 Flash 文件。

2、代码简单,布局合理。遵守web2.0标准,使用div+css设计网页,合理布局标签,尽量减少div层。div+css布局的好处是可以让搜索引擎爬虫爬取你的页面更流畅、更快、更友好;div+css布局还可以大大减小网页大小,提高浏览速度,让代码更简洁、流畅,更容易放置更多内容。

3、使用更少的脚本,外部调用。网站的js和css文件都是外部调用的,不要在网页中写代码,尽量减少脚本文件的数量,这样不仅有利于网页的加载速度,也有利于搜索引擎蜘蛛的爬行!提到虽然ajax效果很炫,但是尽量少用!

4、尽量不要使用表格布局,因为搜索引擎懒得抓取嵌套在表格布局3层内的内容。

5、清理垃圾代码并最小化页面大小。

十个一、链接

同行业网站最好换个链接,注意质量,有利于收录和搜索引擎排名。

交换友链需要注意以下几点:

1.不要与作弊交换链接网站,尤其是那些被百度和谷歌惩罚的网站(这些网站页数收录与页数大)。

当我们交换附属链接时,我们应该考虑搜索引擎和反向链接中附属链接的收录 数量。如果一个网站的PR可以达到4以上,但是他的收录个数或者反向链接很少,那么就要考虑网站是否有PR劫持 作弊手段来获得高PR .

2.如果您的链接被百度降级,那么您的网站可能会受到牵连。所以我们在交换友情链接的时候,一般是看一些网站的实际页数,百度一下网站的收录的页数,如果< @收录 很小,如果是这样,很可能不会被百度点赞。

我们需要检查 网站 已经存在的反向链接的数量。如果这个网站的PR是4甚至更高,但是如果这个网站的链接已经达到了几百个,那么这种友谊链就没有必要进行实质性的交换了。

3.做友情链接的时候,如果是新站,那么起点低,可以找和自己类似的交流,如果是老站,应该找和自己类似的交流你自己。交换时,要看对方是否做了隐藏链接。这种链接是无用的,不传递权重。

要检查链接是否具有欺骗性,只需将对方的 网站 放在 JS 代码或链接 iframe 中,或者在链接中添加 nofollow,这样的链接蜘蛛无法抓取,对我们来说,没有任何意义。

4.友情链接尽量显示为文字链接,尽量避免图片链接。图片往往不被搜索引擎识别,图片是通过img标签中alt的属性值来识别的。制作图片链接的时候一定要打上网站的alt标签,否则对网站关键词的排名影响不大。

从以上几点可以看出,在交换友情链接的时候,要做的工作很多。在很多搜索引擎中需要查询对方收录的数量和反向链接,需要查询对方网站的PR,特别是要定期查看和注册报告.

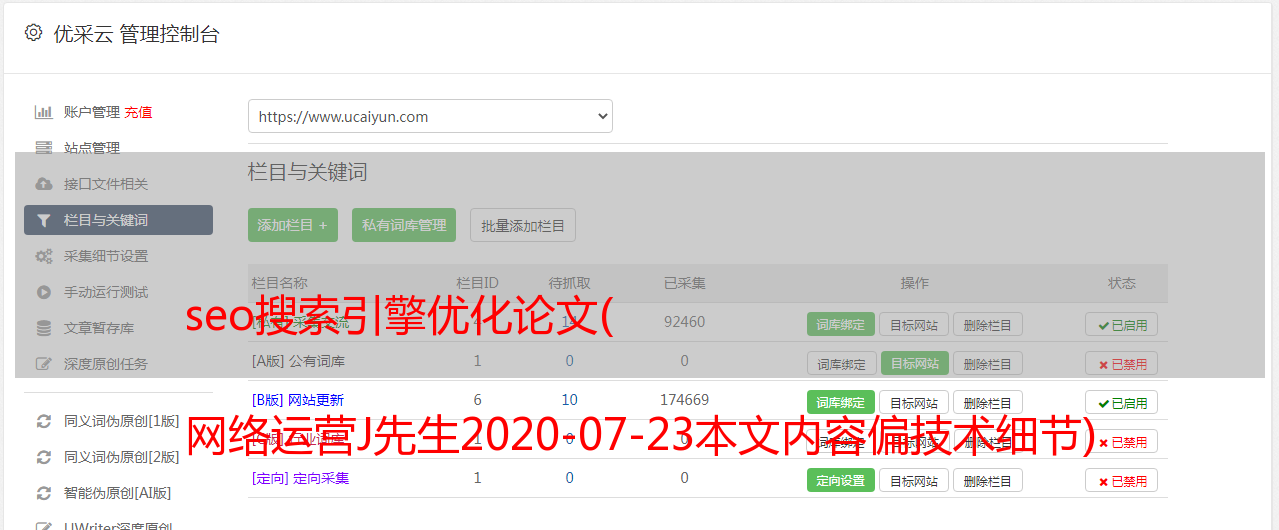

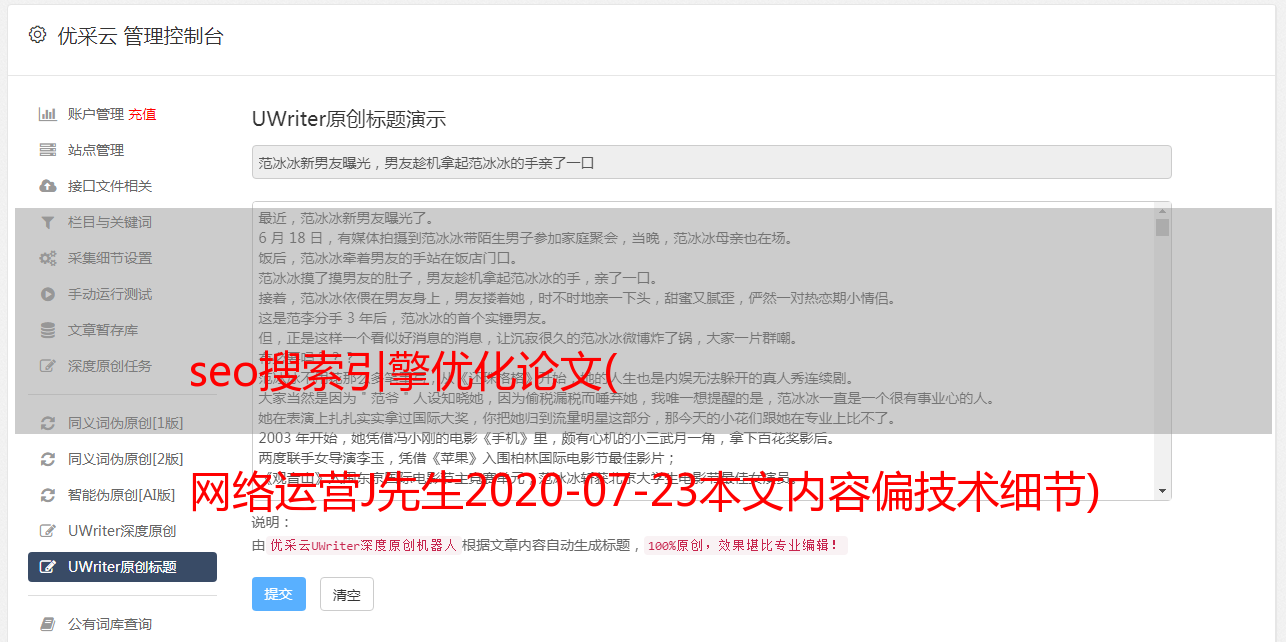

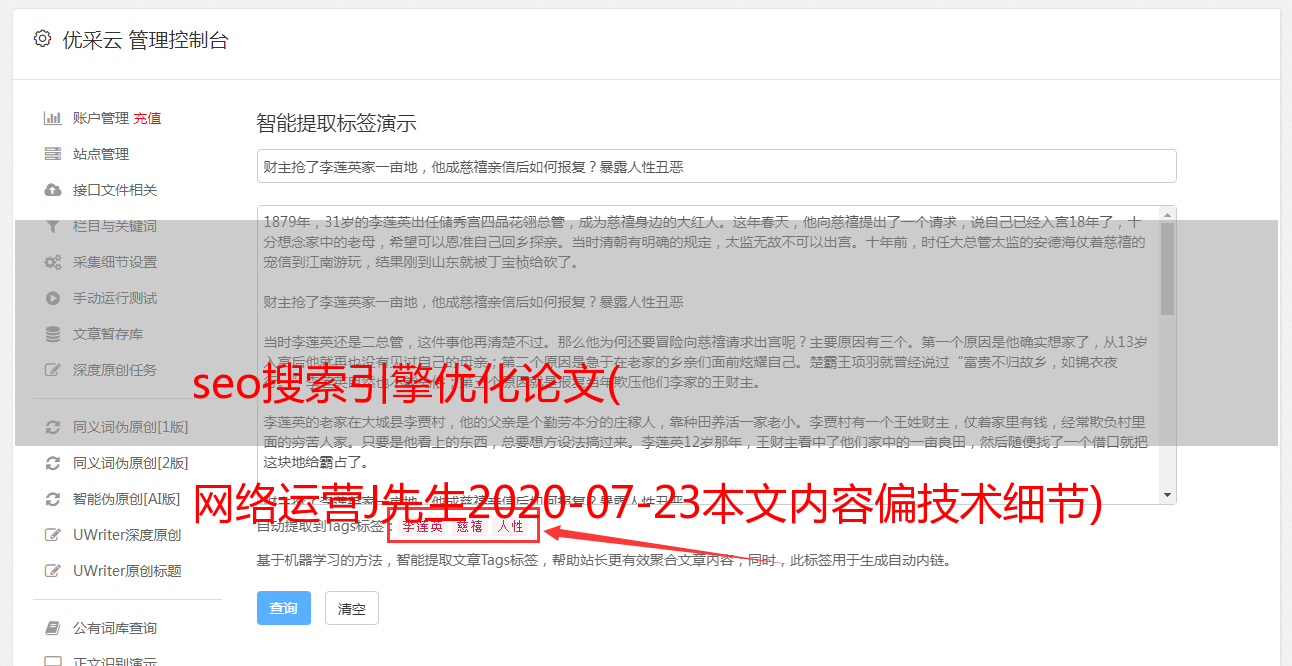

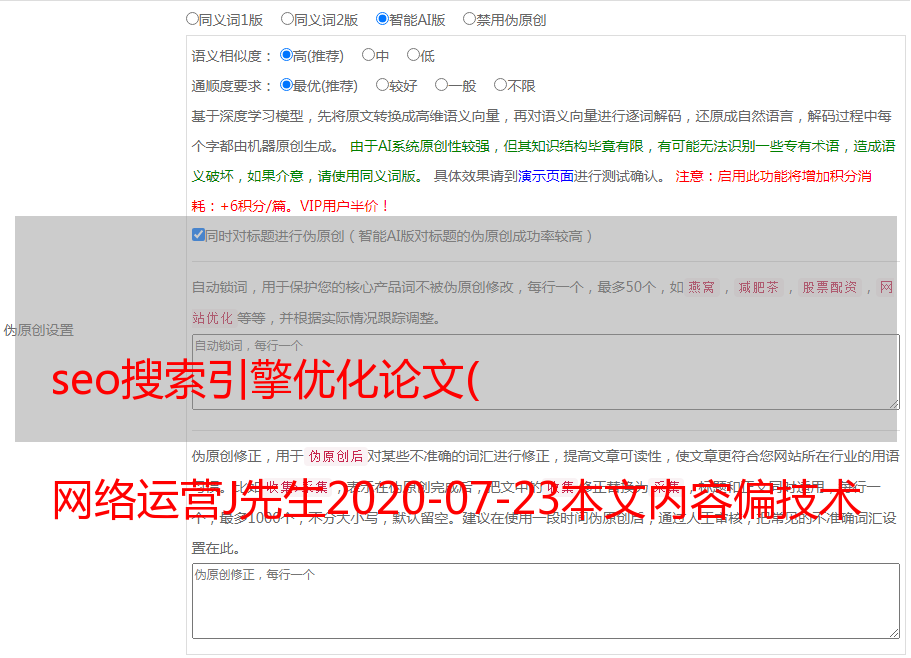

十个二、持续高质量原创或伪原创内容更新

内容为王,这是永恒的真理。无论是seo还是新媒体,短视频运营都非常注重内容,一个好的文章,加上合理化的标题、关键词和描述,可以给网站@带来很多意想不到的流量>;

十个三、机器人文件设置

1、robots.txt对于每个从事SEO工作的人来说都是非常重要的,因为通过robots.txt我们可以告诉搜索引擎哪些内容可以爬取,哪些内容不能爬取。阻止不重要的页面可以减少 网站 服务器的负载。

2、一些常见问题和知识点

①。当蜘蛛找到一个网站时,第一步是去抓取网站的robots.txt文件(当然这是官方说的,有时候也会有不合规的情况);

②。建议所有网站都设置robots.txt文件。如果您认为 网站 上的所有内容都很重要,可以创建一个空的 robots.txt 文件;

3、在 robots.txt 文件中设置 网站maps 您可以在 robots.txt 中添加 网站maps 来告诉蜘蛛 网站maps 的位置。

4、robots.txt的顺序在spider协议中,Disallow和Allow是按顺序排列的。这是一个非常重要的问题。如果设置错误,可能会导致爬取错误。搜索引擎蜘蛛将根据第一个匹配的 Allow 或 Disallow 行来确定是否访问 URL

例如,您可能会更好地理解:

1.用户代理:*

2.允许:/seo/a

3.禁止:/seo/

这种情况下,爬虫/seo/a目录可以正常爬取,但是/seo/目录下的文件无法爬取。通过这种方式,您可以允许蜘蛛访问特定目录中的部分 url。让我们来看看向下的位置。

1.用户代理:*

2.禁止:/根目录下的文件夹/

3.允许:/seo/a

第一行出现/seo/目录,并且禁止爬取该目录下的所有文件,那么第二行的Allow无效,因为第一行已经禁止爬取seo目录下的所有文件爬取了,a目录位于seo目录下。在内容下。所以抓取失败。

5、robots.txt路径问题在spider协议中,Allow和Disallow后面可以有两种路径形式,即绝对链接和相对链接。绝对链接是完整的 URL 形式,而相对链接仅适用于根目录。记住这一点很重要。

文章4@>斜线问题

Disallow:/seo表示禁止爬取seo目录下的所有文件,如:seo1.html、seo/1.php不允许爬取;

Disallow:/seo/表示禁止爬取seo目录下的文件,允许爬取seo1.html,但不允许爬取seo/1.php。

因此,在设置 robots 文件时需要非常小心。设置后最好使用对应的网站管理工具检查是否正常。

本公众号将以通俗易懂、由浅入深的方式与大家分享我这十年的网络运营经验总结和心得,也将记录我的一些工作生活经历和感悟,如果你喜欢,如果对你有帮助,可以点击关注,谢谢!